APS:大型多模态室内摄像机定位系统

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

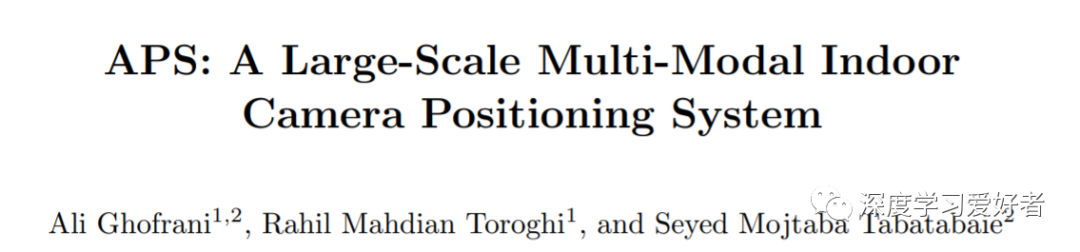

在没有gps信号的封闭区域内进行导航是一项极具挑战性的任务。为了解决这一问题,近年来基于图像的方法引起了许多研究者的关注。这些方法要么提取特征(如使用SIFT,或SOSNet),并将描述性的特征映射到相机的位置和旋转信息,要么部署一个端到端系统,直接从RGB图像中估计这些信息,类似于PoseNet。前一种方法在测试过程中计算量大,后一种方法对环境变化和物体运动缺乏准确性和鲁棒性。然而,端到端系统在测试和推断过程中非常快,并且非常适合实际应用程序,尽管它们的训练阶段可能比以前的要长。摘要小说多end-toend提出了大规模的室内定位系统,即APS(α定位系统),集Pix2Pix GAN网络重建输入的点云对查询图像,与深CNN网络以强劲估计相机的位置和旋转信息。在这种集成中,现有的数据集存在室内环境下成对RGB/点云图像的缺点。因此,作者创建了一个新的数据集来处理这种情况。通过实施提出的APS系统,作者可以实现高精度的相机定位,精度水平低于一厘米。

本文在[6,7]的基础上,提出了一种端到端深度神经网络系统,该系统一方面包含特定场景的RGB数据,另一方面包含与之对应的点云数据;然后集成他们,并提供相机位置和四元数估计与高精度。此外,与icp -net相比,该系统对图像部分遮挡、光照变化等环境变化具有鲁棒性。

整个提出的APS工艺流程图

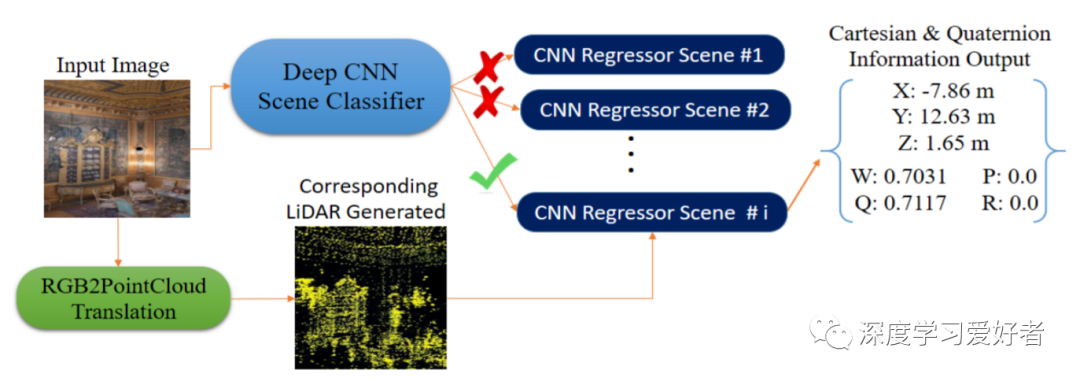

基于EfficientNet-B0 CNN的场景分类器。输入:RGB数据;输出:场景数量有关。

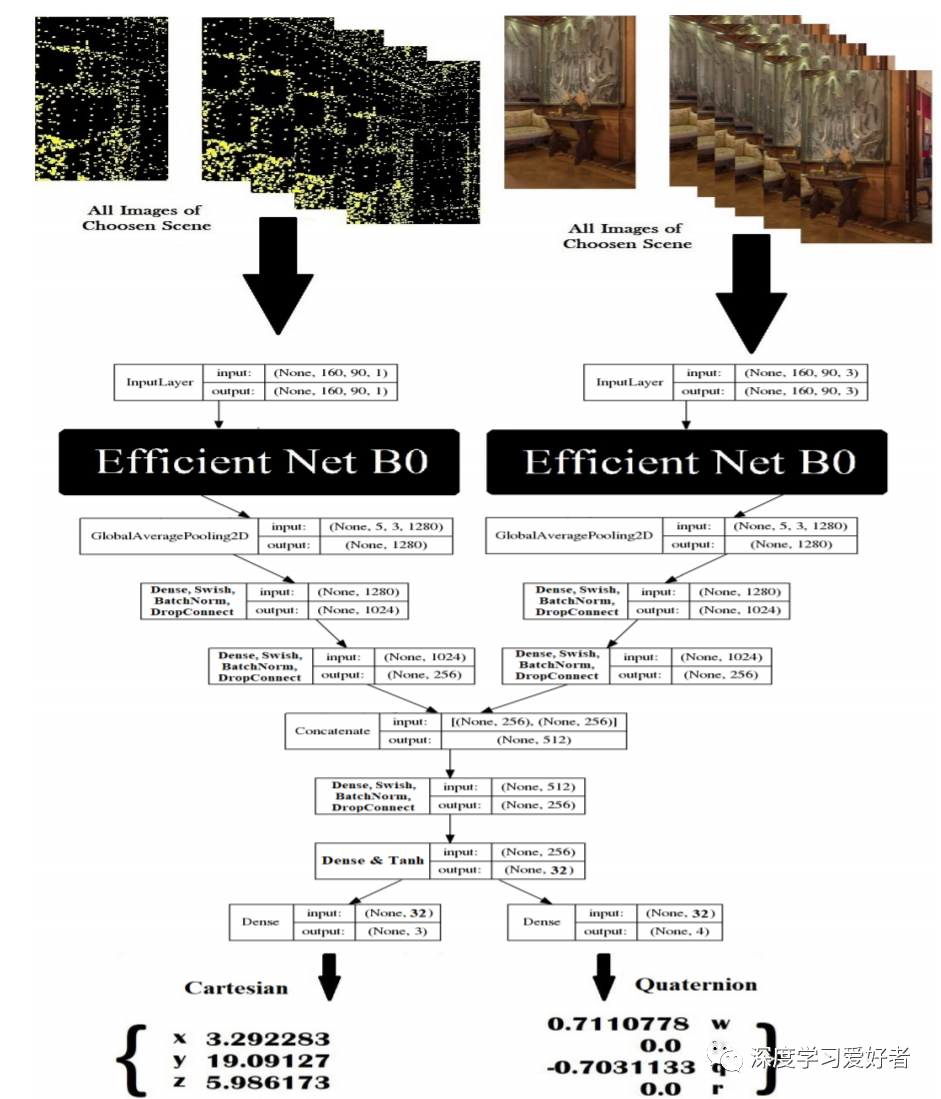

一种新的多模态回归因子CNNs。左侧路径仅在GAN输出获得的pointcloud数据上进行训练;只对RGB数据正确路径。

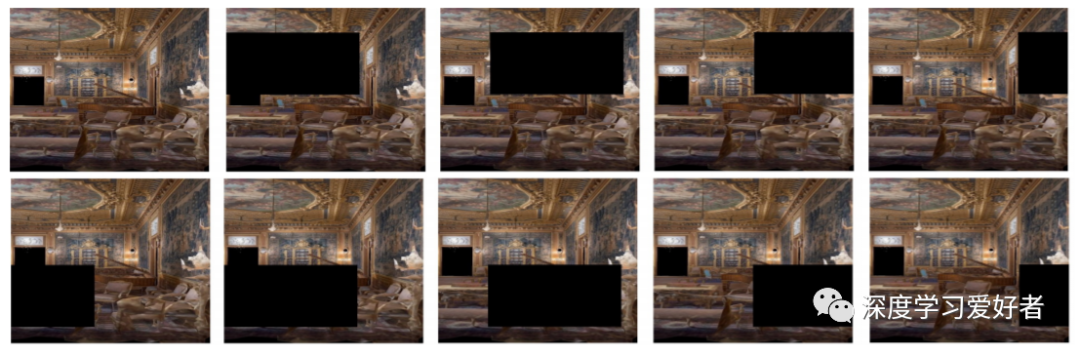

通过插入掩模和在左上角的参考图像上完全滑动来增加数据。

使用对象插入来创建测试样本,以遮挡和屏蔽视图模式,以测试模型对屏蔽效果的鲁棒性。(上)场景的大视图,(下)从左到右:由于物体遮挡不同的相机视图和掩蔽模式。

本文提出了一种端到端系统来解决室内定位问题。这项工作改进了之前提出的系统,即icp -net和激光雷达icp -net。由于背景中存在动态对象,ICPS-net具有较强的抗环境变化能力。激光雷达icp -net具有数据生成简单、抗输入变化能力强等优点。然而,它缺乏精确性。另一个创新是使用Pix2Pix GAN生成点云数据,这可以通过生成分布接近数据集的图像来帮助数据增强。虽然新的数据可以防止模型过拟合,但当输入的RGB图像被遮挡和遮挡时,它有助于提供鲁棒的点云数据。第三种新颖的是多模态CNN,它融合了两个独立的CNN模型,在回归精度和收敛能力方面都优于它们。笛卡尔坐标和四元数估计,相对于SOTA有了显著的改进。该模型的新颖之处简化了系统在各种应用中的利用,如大型建筑、商场、隧道和AR/VR应用。

论文链接:https://arxiv.org/pdf/2102.04139.pdf

每日坚持论文分享不易,如果喜欢我们的内容,希望可以推荐或者转发给周围的同学。

- END -

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~