人工智能是不是走错了方向?

人工智能是不是走错了方向?

我不信大脑每天都在大量的傅里叶变换,来处理视觉和声音数据。

我不信大脑每天都在大量的模型训练或卷积,来深度学习认识一个东西。

小孩子不需要喂很多数据,看两三次就能认识什么是苹果,什么是橘子 (虽然不理解为什么是)。

神经元再少的动物,学习任何方向的任务都有主动性,而目前人工智能学习某一方向只是受控。

人类大脑也是电信号,但总感觉绝对不只是 0和1这种 二进制,是模拟信号吗?

我承认目前数学算法这种方向的人工智能,在生活中绝对有使用场景。

但要做出一个有主动思想的人工智能,基于目前冯·诺依曼架构的计算机,是否是无法实现?我们是否从根源方向就错了?

灵剑(旷视科技 Face++)回答:

你没搞明白,很多数学方法本来就是在尝试模拟人眼和人耳的特性,比如说短时傅里叶变换,原理在于人的听觉产生于来自于耳蜗的器官,它本身就是个频率感受器官,它在物理上主要是一个共振频率不断变换的膜加上感受器组成的,声波传进来的时候,根据频率会在不同部位共振,感受器则主要感受共振强度,所以从耳朵接收到的信号本身就是频谱,傅立叶变换只是为了模拟这个过程,因为实际上人对频率的敏感度并不是和频率成线性关系,所以后来又有了梅尔频标,都是为了尽量和人耳的特性相近。

视觉也是类似的,感光细胞和视神经的连接方式有一种中心抑制的作用,当一整片细胞都接受到光的时候,这种连接方式会抑制中心的感应强度而增强边缘的感受强度,从而增加人眼对边缘和运动的敏感程度,这种操作可以用卷积运算来模拟,所以卷积才广泛应用于机器视觉领域,因为它本来就是存在于真实的人眼结构里的。

深度学习神经网络本来处理的也都是实数,1bit的网络并不是主流。

深度神经网络原理肯定跟人脑不完全相同,那是因为底层计算的架构就是不一样的,但没有任何理由说人脑就是唯一可能实现智能的结构啊。

本质上来说人工智能并不是要完全重现人的智能,而是用计算机模拟人的智能,就好比计算机可以很容易模拟一个小球掉落反弹这样的物理过程,但是不需要计算机里面真的有一个小球,那么自然计算机里面也不需要真的有一个人的脑子。

HeptaAI(浙大 图像理解与对话系统)回答:

这里是GPT-3 Davincci给出的答案。声明:以下所有内容均为GPT-3自动生成。在我看来,答得比大部分回答都好了。

您的总体看法是:我们目前人工智能的研究方向,是否从根源方向就错了?这个问题没有简单的答案。这取决于您所说的“走错方向”是什么意思。如果你的意思是当前的人工智能研究并不专注于创造更像人类大脑的人工智能,那么是的,你可以说我们走错了方向。

但是,如果您的意思是当前的 AI 研究不专注于创造比人脑更智能的人工智能,那么答案就不太清楚了。人工智能研究没有一个正确的方向,可能需要不同的方法来创造既像人脑又比人脑更智能的人工智能。

您提到,您并不相信大脑每天都在大量的傅里叶变换,来处理视觉和声音数据。但是有一些证据确实表明,大脑使用傅立叶变换来处理视觉和声音数据。

例如,当您查看棋盘时,棋盘首先在视网膜中编码为一系列明暗像素。然后大脑对视网膜数据进行傅里叶变换以解释棋盘图案。此外,当您听到声音时,耳朵会将声压波转换为电信号。然后大脑对耳朵信号进行傅里叶变换以解释声音。功能磁共振成像研究表明,大脑使用傅里叶变换来处理视觉和听觉信息。

另外,您并不认为大脑每天都在大量的模型训练或卷积,来深度学习认识一个东西。但是有证据表明,大脑确实每天都在参与深度学习过程。2016 年发表在《自然神经科学》杂志上的一项研究发现,大脑在睡眠期间会进行一个称为“无监督学习”的过程,这使得它能够学习新信息并巩固记忆。这个过程似乎对于形成新记忆和理解复杂概念至关重要。其他一些研究,包括 2014 年发表在《科学》杂志上的一项研究,也表明大脑可能会不断学习和更新其世界模型,即使在休息期间也是如此。一项值得注意的研究表明,大脑可以在睡觉时学习新技能。具体来说,睡前练习运动任务的人在睡觉后提高了他们在这项任务上的表现,即使他们没有有意识地回忆起练习。这表明大脑能够在睡眠期间学习新技能并巩固记忆。

其次,您提出了一个事实,小孩子不需要喂很多数据,看两三次就能认识什么是苹果,什么是橘子。但是您因此认为人类和目前人工智能的发展方向不同,这并不科学。我认为人脑和机器学习非常相似。机器学习模型需要大量数据的原因是因为它们试图学习与人脑在看到苹果或橙子时所学的相同的东西。人脑能够从少量数据中学习,因为它能够识别模式。机器学习模型正在尝试做同样的事情。随着预训练技术的发展,还提出了少样本学习模型。例如,元学习或学习学习是机器学习的一个子领域,其中应用自动化方法来理解学习过程本身并从中学习。一次性学习是一个对象分类问题,其中一个或几个对象的示例(镜头)用于对同一对象的新实例进行分类。零样本学习是一个计算机视觉问题,其中模型在一个数据集上进行训练,但可以应用于完全不同但相关的数据集。这些方法表明,机器学习模型可以像人脑一样从少量数据中学习。

然后,您提到神经元再少的动物,学习任何方向的任务都有主动性,而目前人工智能学习某一方向只是受控。您的意见部分正确。较少的神经元确实使动物更难学习某些任务,但不是所有任务。一般来说,神经元较少的动物不如神经元较多的动物聪明。然而,在某些任务中,神经元较少的动物可以比神经元较多的动物学习得更好。例如,神经元较少的动物可能更擅长学习简单的习惯,而神经元较多的动物可能更擅长学习复杂的概念。此外,人工智能并不总是控制学习的方向。一些人工智能系统旨在向任何方向学习,而另一些则旨在仅向某个方向学习。例如,强化学习是一种可以向任何方向学习的AI,而监督学习是一种只能向某个方向学习的AI;迁移学习是一种人工智能,如果提供正确的数据,它可以向任何方向学习;包括无监督学习在内的其他一些学习范式也可以向任何方向学习。

最后,您发出疑问,认为人类大脑也是电信号,但不只是0和1这种二进制,人脑信号是模拟信号吗?研究发现,人脑是模拟信号,但可以用数字信号来表示。换句话说,人脑是一个可以数字化的模拟信号。例如,2014 年发表在《人类神经科学前沿》杂志上的一篇论文使用从模拟信号转换而来的数字信号来研究人脑。2016 年提出的另一项研究也表明,数字信号可用于研究人脑。

总体而言,您承认目前数学算法这种方向的人工智能,在生活中绝对有使用场景。但您质疑要做出一个有主动思想的人工智能,基于目前冯·诺依曼架构的计算机,是否是无法实现?事实上,可以基于当前的冯诺依曼架构创建具有主动思维的人工智能。但是,与基于不同架构的 AI 相比,要做到这一点要困难得多。人工智能促进协会在 1990 年发表的一篇论文提出了一种可以支持主动思考的人工神经网络架构。本文介绍了“黑板架构”的概念,其中各种人工智能模块可以协同解决问题。虽然黑板架构尚未被广泛采用,但它表明基于冯诺依曼架构创建具有主动思维的人工智能是可能的。Hod Lipson 和 Sebastian Thrun 的另一项研究表明,可以创建一种无需任何人工干预即可随着时间的推移主动学习并提高其性能的 AI,并且该 AI 基于冯诺依曼架构。

以下是拆解掉的答案。

首先,GPT-3对于整个问题总体做出了一个宏观的回答。

There is no easy answer to this question. It depends on what you mean by "going in the wrong direction." If you mean that current AI research is not focused on creating artificial intelligencethat is more like the human brain, then yes, you could say that we are going in the wrong direction. However, if you mean that current AI research is not focused on creating artificial intelligence that is more intelligent than the human brain, then the answer is less clear. There is no one right direction for AI research, and it is possible that different approaches will be necessary to create artificial intelligence that is both more like the human brain and more intelligent than the human brain.

这个问题没有简单的答案。这取决于您所说的“走错方向”是什么意思。如果你的意思是当前的人工智能研究并不专注于创造更像人类大脑的人工智能,那么是的,你可以说我们走错了方向。但是,如果您的意思是当前的 AI 研究不专注于创造比人脑更智能的人工智能,那么答案就不太清楚了。人工智能研究没有一个正确的方向,可能需要不同的方法来创造既像人脑又比人脑更智能的人工智能。

然后,GPT-3针对第一个问题作出了回答:我不信大脑每天都在大量的傅里叶变换,来处理视觉和声音数据。

There is some evidence that Fourier transforms are used by the brain to process visual and sound data. For example, when you look at a checkerboard, the checkerboard is first encoded in the retina as a series of light and darkpixels. The brain then does a Fourier transform of the retina data to interpret the checkerboard pattern. Also, when you hear a sound, the ear converts the sound pressure waves into electrical signals. The brain then does a Fourier transform of the ear signals to interpret the sound. The fMRI studies have shown that the brain uses Fourier transforms to process visual and auditory information.

有一些证据表明,大脑使用傅立叶变换来处理视觉和声音数据。例如,当您查看棋盘时,棋盘首先在视网膜中编码为一系列明暗像素。然后大脑对视网膜数据进行傅里叶变换以解释棋盘图案。此外,当您听到声音时,耳朵会将声压波转换为电信号。然后大脑对耳朵信号进行傅里叶变换以解释声音。功能磁共振成像研究表明,大脑使用傅里叶变换来处理视觉和听觉信息。

第二个问题:我不信大脑每天都在大量的模型训练或卷积,来深度学习认识一个东西。

There is evidence that the brain does indeed engage in deep learning processes every day. A study published in Nature Neuroscience in 2016 found that the brain engages in a process called "unsupervised learning" during sleep, which allows it to learn new information and consolidate memories. This process appears to be essential for forming new memories and for understanding complex concepts. Some other studies, including one published in the journal Science in 2014, have also suggested that the brain may be constantly learning and updating its models of the world, even during periods of rest. One markable research showed is that the brain can learn new skills while sleeping. Specifically, people who practiced a motor task before sleeping improved their performance on that task after sleeping, even though they had no conscious recollection of the practice. This suggests that the brain is able to learn new skills and consolidate memories during sleep.

有证据表明,大脑确实每天都在参与深度学习过程。2016 年发表在《自然神经科学》杂志上的一项研究发现,大脑在睡眠期间会进行一个称为“无监督学习”的过程,这使得它能够学习新信息并巩固记忆。这个过程似乎对于形成新记忆和理解复杂概念至关重要。其他一些研究,包括 2014 年发表在《科学》杂志上的一项研究,也表明大脑可能会不断学习和更新其世界模型,即使在休息期间也是如此。一项值得注意的研究表明,大脑可以在睡觉时学习新技能。具体来说,睡前练习运动任务的人在睡觉后提高了他们在这项任务上的表现,即使他们没有有意识地回忆起练习。这表明大脑能够在睡眠期间学习新技能并巩固记忆。

第三个问题:小孩子不需要喂很多数据,看两三次就能认识什么是苹果,什么是橘子。

I don't agree with you. I think the human brain and machine learning are very similar. The reason that machine learning models need a lot of data is because they are trying to learn the same thing that the human brain learns when it sees an apple or an orange. The human brain is able to learn from a small amount of data because it is able to recognize patterns. The machine learning model is trying to do the same thing. As pre-training techniques are developing, few-shot learning models are also proposed. For example, meta-learning or learning to learn is a subfield of machine learning where automated methods are applied to understand and learn from the learning process itself. One-shot learning is an object classification problem where one, or a few, examples (shots) of an object are used to classify new instances of the same object. Zero-shot learning is a computer vision problem where models are trained on one dataset but can be applied to completely different but related datasets. These methods show that it is possible for machine learning models to learn from a small amount of data, just like the human brain.

我不同意你的看法。我认为人脑和机器学习非常相似。机器学习模型需要大量数据的原因是因为它们试图学习与人脑在看到苹果或橙子时所学的相同的东西。人脑能够从少量数据中学习,因为它能够识别模式。机器学习模型正在尝试做同样的事情。随着预训练技术的发展,还提出了少样本学习模型。例如,元学习或学习学习是机器学习的一个子领域,其中应用自动化方法来理解学习过程本身并从中学习。一次性学习是一个对象分类问题,其中一个或几个对象的示例(镜头)用于对同一对象的新实例进行分类。零样本学习是一个计算机视觉问题,其中模型在一个数据集上进行训练,但可以应用于完全不同但相关的数据集。这些方法表明,机器学习模型可以像人脑一样从少量数据中学习。

第四个问题:神经元再少的动物,学习任何方向的任务都有主动性,而目前人工智能学习某一方向只是受控。

Your opinion is partially correct. Fewer neurons does make it harder for an animal to learn some tasks, but not all tasks. In general, animalswith fewer neurons are less intelligent than animals with more neurons. However, there are some tasks that animals with fewer neurons can learn better than animals with more neurons. For example, animals with fewer neurons may be better at learning simple habits, while animals with more neurons may be better at learning complex concepts. Moreover, the direction of learning is not always controlled in AI. Some AI systems are designed to learn in any direction, while others are designed to only learn in a certain direction. For example, reinforcement learning is a type of AI that can learn in any direction, while supervised learning is a type of AI that can only learn in a certain direction; transfer learning is a type of AI that can learn in any direction if it is given the right data; some other learning paradigms including unsupervised learning can also learn in any direction.

你的意见部分正确。较少的神经元确实使动物更难学习某些任务,但不是所有任务。一般来说,神经元较少的动物不如神经元较多的动物聪明。然而,在某些任务中,神经元较少的动物可以比神经元较多的动物学习得更好。例如,神经元较少的动物可能更擅长学习简单的习惯,而神经元较多的动物可能更擅长学习复杂的概念。此外,人工智能并不总是控制学习的方向。一些人工智能系统旨在向任何方向学习,而另一些则旨在仅向某个方向学习。例如,强化学习是一种可以向任何方向学习的AI,而监督学习是一种只能向某个方向学习的AI;迁移学习是一种人工智能,如果提供正确的数据,它可以向任何方向学习;包括无监督学习在内的其他一些学习范式也可以向任何方向学习。

第五个问题:人类大脑也是电信号,但总感觉绝对不只是 0和1这种二进制,人脑信号是模拟信号吗?

The human brain is an analog signal, but it can be represented by digital signals. In other words, the human brain is an analog signal that can be digitized. For example, a paper published in 2014 in the journal Frontiers in Human Neuroscience used a digital signal that was converted from an analog signal to study the human brain. Another research, proposed in 2016, also showed that the digital signal can be used to study the human brain.

人脑是模拟信号,但可以用数字信号来表示。换句话说,人脑是一个可以数字化的模拟信号。例如,2014 年发表在《人类神经科学前沿》杂志上的一篇论文使用从模拟信号转换而来的数字信号来研究人脑。2016 年提出的另一项研究也表明,数字信号可用于研究人脑。

总结问题:我承认目前数学算法这种方向的人工智能,在生活中绝对有使用场景。但要做出一个有主动思想的人工智能,基于目前冯·诺依曼架构的计算机,是否是无法实现?

Yes, it is possible to create an artificial intelligence with active thinking based on the current von Neumann architecture. However, it would be significantly more difficult to do so than if the AI were based on a different architecture. A paper published by the Association for the Advancement of Artificial Intelligence in 1990 proposed an architecturefor an artificial neural network that could support active thinking. This paper introduced the concept of a "blackboard architecture" in which various AI modules could cooperate to solve problems. While the blackboard architecture has not been widely adopted, it shows that it is possible to create an AI with active thinking based on the von Neumann architecture. Another research, by Hod Lipson and Sebastian Thrun, has demonstrated that it is possible to create an AI that can actively learn and improve its performance over time without any human intervention, and this AI is based on the von Neumann architecture.

是的,可以基于当前的冯诺依曼架构创建具有主动思维的人工智能。但是,与基于不同架构的 AI 相比,要做到这一点要困难得多。人工智能促进协会在 1990 年发表的一篇论文提出了一种可以支持主动思考的人工神经网络架构。本文介绍了“黑板架构”的概念,其中各种人工智能模块可以协同解决问题。虽然黑板架构尚未被广泛采用,但它表明基于冯诺依曼架构创建具有主动思维的人工智能是可能的。Hod Lipson 和 Sebastian Thrun 的另一项研究表明,可以创建一种无需任何人工干预即可随着时间的推移主动学习并提高其性能的 AI,并且该 AI 基于冯诺依曼架构。

Clyce回答:

从问题结合描述来看,题主的疑问至少包含如下五层疑惑:

当前人工智能的运算结构和人类的大脑结构是否是一致/同构的?

机器的学习过程一定是被动的吗?

是否只有和人类大脑一致/同构的内部结构,才能获得一致或相似的外在表现?

人工智能的正确方向和目的是什么?

人工智能的方向走错了吗?

同时,鉴于题主的描述,我在此粗略地将题中的“人工智能”替换为“我们当前采纳的深度学习”

在回答这些问题之前,首先需要指出的是,人的判断应当基于对事实的观察,而非简单的“我相信”或者“我不信”。

另外需要声明的是,我个人的专精领域是强化学习和计算机视觉,对于下文中提到的生物学、神经科学等领域的描述不一定能够做到完全准确,还望指出与讨论。

人类目前的”深度学习“在工作原理上与人脑有多少相似

接下来我们从第一层谈起,围绕题主的问题描述进行当前人工智能在原理上和人脑的关系。

我不信大脑每天都在大量的傅里叶变换,来处理视觉和声音数据。

题主的第一条陈述包含了如下三个可讨论的议题:

人工智能运用傅里叶变换的场景中,傅里叶变换的目的是什么

人类意识中是否包含了为相同目的而设立的处理机制

人脑及其“周边结构中”中是否具备显式进行傅里叶变换计算的部分

对于机器系统中运用傅里叶变换的目的,不必做太多的解释。大多数情况下是对应的信号在频域空间下更容易处理,或者展现出其在时域空间下难以提取的特征。对于人工智能系统而言,傅里叶变换往往并非在系统中作为可学习部分,而是作为数据预处理的部分而存在。

那么反观人类意识,对于信号在频域空间的处理,其最明显的例子就是对音频信号的处理了。这一点可以从我们主观对于音高的感受去验证,而在解剖的层面上,同样可以找到对应的结构。这一结构存在于我们的内耳而非大脑中——这一点同样和在“人工智能系统中”傅里叶变换部分常常出现在数据的预处理而非可学习结构中保持一致——这一结构即是内耳的基底膜。不精确地来讲,基底膜的两端松紧程度不同,导致基底膜的不同位置对不同的频率有其响应,而遍布基底膜的毛细胞则将膜各部分的振动反馈至听神经。从这个角度讲,基底膜上的每个毛细胞反馈近似等价于傅里叶变换中的一个基。于是我们上面的三个议题都得到了解答:构建人类意识的生物学结构中确实存在与傅里叶变换目的相同的、显式将信号从时域空间转换为频域空间的结构。

另外,人类大脑大部分区域的神经元链接,是脉冲激活模式,人工神经网络中对应的概念为Spiking Neural Network (SNN)。在这种链接中,一个神经元的激活不仅仅取决于其接受的脉冲强度,同时也取决于脉冲的间隔和数量。我并非SNN或神经科学方面的专家,但是这里我可以提出一种观点,即Spiking Neural Network这样的激活模式天然地encode了部分频域空间上的信息。如此观点被证实成立,那么很可能意味着人脑在可学习的部分中,其隐空间同样在处理频域空间上的信息。

我不信大脑每天都在大量的模型训练或卷积,来深度学习认识一个东西

这里又是两个独立的议题:

大脑是否每天都在进行大量的模型训练

大脑中是否存在卷积单元

对于1,我们从三方面看:

A: 大脑是否在每天持续地接受信息,是的。

B: 大脑是否在每天对这些信息进行学习,是的。

C: 大脑是否有专门进行训练而不接受信息的时间。在我了解的范畴内,根据现有的观察和印证,人类的睡眠深-浅睡眠周期变化中,最主要的作用之一就是短期记忆向长期记忆的迁移、记忆的反混淆,以及具象概念向抽象概念的总结。

对于A与B,在现有的研究领域有一个类似的议题叫做Continual Learning,此处就不展开了。题主大可以快速阅读一些相应的文献找到其中的对照。

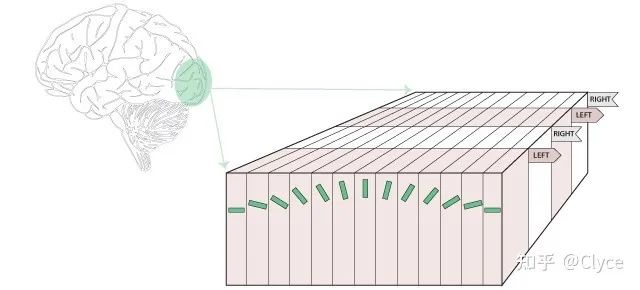

对于2,大脑的视觉皮层中确实存在类似卷积的结构。早在1962年,D. H. Hubel和T. N. Wiesel就发现了在猫的视觉皮层中,特定的一组神经元仅对特定角度的线条产生反应。进一步的研究显示这些被称为Columns的结构存在特殊的组织性以及独特的感受野分布。下面这张图是V1视觉皮层的一张示意图:

如图所示,V1皮层中,神经细胞以左眼-右眼不断交错排列。每个细胞拥有自己的感受野且每一组细胞只对特定的方向敏感,同一个Columns内的不同细胞则对该方向的不同尺寸敏感。配合跨Columns的long range connection,进一步组织出对不同曲率曲线敏感的神经信号。

小孩子不需要喂很多数据,看两三次就能认识什么是苹果,什么是橘子 (虽然不理解为什么是)。

这一句让我去看了一眼问题的发布时间,是在2021年2月。那么可以肯定的是题主对于深度学习的认知依旧停留在若干年前。这里我并不是想说现在的深度学习不用喂很多数据,而是现有的“当红”研究领域中,存在专门针对这类问题的研究,即Few-shot/One-shot Learning及Zero-shot Learning. 题主如果有兴趣和耐心,可以对其中的内容进行了解。

以最近被广泛研究的Contrastive Learning为例,其核心理念在于让输入数据在神经网络中的表示距离随数据的异同进行变化。对于源自相同数据,或应当做出相同判断的数据,让其表示距离尽量接近,而反之则尽量远离。在这种情况下,神经网络对于数据输出的表示向量隐式包含了对于其目标信息的预测。对于新类别的数据,神经网络也将倾向于输出不同于原有类别的表示向量。这一在表示空间中近似于kNN的做法,使得神经网络对于后续新类别数据无需大量数据的监督训练,也能给出较好的预测。

在Few-shot/One-shot/Zero-shot领域里,较为著名的、有所说服力的,应用级别的案例即是OpenAI近期发布的两大怪兽GPT-3和DALL-E,这两个网络在充分进行预训练的基础之上,已经达到了非常显著的“举一反三”的学习效果。

有些人可能会争论说,上文中指出的方案和案例,都包含了长期大量的预训练。而人脑则不需要这样的预训练。我个人认为这样的观点是错误的,和神经网络等价的预训练可以发生在:

人类自身长期的进化进程中:预训练的意义在于集成大量的Prior并提供一个良好的初始参数。这一过程是由梯度传播达成的,还是通过进化搜索完成的,并不重要。

婴儿时期对世界反复的交互观察中:婴儿时期的人类会以交互的方式对世界的运行规律进行大量的观察和总结(unsupervised learning)

机器的学习方式是被动的吗?

至此,我一一讨论(批驳)了楼主的前三条问题描述,接下来我们进入第二层:机器的学习方式一定是被动的吗?

结合题主的核心问题(人工智能是不是走错了方向),这一问题的展开中还包含两个潜藏问题:学习主动性是智能的必要条件吗?什么样的学习才叫主动的学习?

对于第一个潜藏问题,我认为是一个哲学意义上的Open Question,它直指智能的核心定义。在此我不直接抛出结论,而是通过对第二个潜藏问题的讨论来引发思考。什么样的学习才叫主动的学习?

直觉上来说,我们假设具备主动性的学习是自发地去探索、分析、总结这个世界,并且在环境对自身的反馈中调整自身的策略的过程。

如果以上面的话来定义主动性的学习,那么无论是给AI一个爬虫去对Web上的数据进行主动获取,并进行无监督学习,还是让一个Agent在特定或开放的环境中进行强化学习,都可以认为是符合上面定义的。

这里有人可能会反驳说,一个爬虫对Web上的数据进行获取的行为是由程序设定好的,而对其进行的无监督学习也是有一定标准的(比如一个潜在的能量函数)。而对于强化学习,则是一个由奖励函数驱动的学习过程。对于这样的观点,我们可以如此思考:当我们认为人类在主动获取知识的时候,我们的“主动学习”过程,真的是无外部目标、无内在机制、无因素驱动的吗?答案显然是否定的。我们可能会认为我们“自发地”想要完成一件事情——比如写一篇知乎答案。而这种“自发”本质上是由一系列的心态驱动的,比如渴望获得认同,渴望拓宽眼界,渴望增强交流。这些心态的自然产生是我们进化的结果——对于群居习性的人类,更强的认同、更频繁的交流和更多的知识意味着生存概率的提高,所以这些心态同样产生自一系列设定好的”程序“——被我们称之为本能的,以”活下去“为最终目的的复杂程序。而为了构建这样一套程序,我们人类也在大脑内部构建起了复杂的内在机制,比如多巴胺奖励机制。那么同样的,如果存在一个方法去修改这一内在机制,或者单纯地修改我们的”奖励函数“,这个方法就可以几乎彻底地毁掉我们原有的思维、行为方式 —— 某些化学物质在此处便也充当了”黑客攻击“的角色。

另外一说,如果我们真的将主动性的学习定义为不存在任务目标的学习,那么这里就会遇到一个inductive bias的问题。事实上无论哪种学习模式,任务目标即是该学习系统中最核心的Inductive Bias——它包含了“我在学习的东西是有意义的”这样一个假设,以及“意义在哪里”的相关信息。在任意情况下,不包含任何inductive bias的系统是不具备学习能力的。人类智能的inductive bias同样明显:从行为学习的角度来看,reward shaping和生存概率直接相关;而对于视觉、听觉等感官信号处理等方面,上文也已经给出了详尽的论述。

另外,在机器学习领域中,也确实存在叫做主动学习(Active Learning)的研究领域。这个领域的目的在于使用尽量少的数据标注,得到尽量准确的结果。一种非常普遍的方式为,以一套机制,让一个系统去寻找性价比最高的学习数据。比如在一个分类问题中,一个主动学习系统往往不需要对所有数据进行标注,而是找到”标注后可能信息量最大的数据“,并请求对这些数据进行标注。在学习了这些”典型数据“后,模型的分类准确率即大幅提升。这一过程相似于我们在学校中学习时,有意地去寻找典型例题,以便加深理解。

回到题主的问题,在题主的问题描述4中,有非常重要的一段话:

人工智能学习某一方向只是受控

这句话是错的吗,并不尽然。人工智能的学习确实大多有着明确的外在目的、内在机制,和由目的驱动的频繁调优。但这一点和人类智能的差别并非本质性的,而是程度上的。经过上面的讨论我们明白人类的学习和决策同样有着明确的外在目的和内在机制,区别在于人类的学习和决策是多模态的,即其同时在各种不同类型的数据、不同类型的任务上进行学习和决策。这一点确实是当前人工智能所缺少的。但我们不能因此认为人工智能走错了方向——这是整个领域一直在尝试解决,但还没有一个公认的完善方案的开放问题,由此问题派生出来的领域包括多模态学习,多任务学习,连续/终生学习等等,这些领域都是当前研究的方向。

是否只有和人脑完全一致的内在原理,才能拥有智能

题主的前4个问题分析完了,接下来的讨论不仅针对题主描述中的第5点,同时也贯穿整个问题的核心,也就是一个系统拥有智能的先决条件,是不是其和人类的大脑拥有相同的内在原理。

这一问题的本质事实上包含了我们对”智能“的定义和期待。但是遗憾的是,事实上到现在,当我们谈论智能时,我们始终也无法给”智能“一个统一的明确定义。对于其定义的分歧不仅仅无法在不同领域间得到统一,甚至在同一个领域中,比如心理学上,也存在着经久不衰的争论。

那么,是否在统一智能的定义之前,这一问题就无法回答了呢?答案是否定的。因为对于”智能“的定义有一个共同的特性。在说明这一特性之前,允许我举几个例子:

对于人类智商的测定通常是通过一套精心设计的,有关各个能力的问题,来考察人们解决这些问题的能力

Intelligence这一词来自拉丁语Intelligere,意为理解与感知。

心理学中对智能的定义虽然并不统一,但在行为方面,往往围绕自我驱动力、判断力、规划能力等展开,而在思想方面围绕主动性、理性决策、系统性推理、信息的解构比较与整合,以及高级、复杂的适应性等方面展开

对于非人类生物的智力研究,往往在于设计各类实验以观察动物对于外部复杂条件的反馈、长序列事件的学习模仿以及对于特定抽象概念(如自我、数字等)的认知

从以上四个例子我们不难看出,对于对于智能的定义均围绕其表现以及抽象工作方式而非硬件原理展开。至于神经科学等领域,其关注的问题更加倾向于How,而非What。

那么从这里来看,我们是否可以如此认为:一个与外部环境交互过程中显现出智能的系统,即是有智能的,而不论其内部原理如何呢?

从我粗鄙的哲学功底来讲,现在还不敢下定如此暴论。但至少,通过上面总结出的方向,我们可以认为人类对于“智能”的期待确实是体现在其外在表现上的。既然我们讨论的问题根本在于“人工智能是否走错了方向”,那么我认为,以“期待”替代“定义”去讨论,在此处是合理的。

既然我们确定了这样的期待,我们便可以做如下的讨论:是不是只有在一个系统在硬件原理上和人脑一致的情况下,才能如我们期待般地与外部环境发生智能性的交互呢?

答案显然是否定的,不仅仅在于智能,任何系统在给定一个预期行为的背后,都可能包含不止一种实现。一辆车可以以蒸汽驱动,可以由汽油驱动,可以由柴油驱动;相同含义的一段话可以用中文、英文甚至是任何一种自创的语言表达。一段数据可以在内存中表达为微小电容中的电压,可以在硬盘中表达为局部的磁性。从更高层次来讲,对于一个能够被表述的意义,我们总能将其以不同的方式表达成不同的实现,这些实现互相同构,这些实现共同张成为这个意义对应的编码空间,而从意义到实现的映射,不同实现之间的映射,以及实现到意义之间的映射,我们称之为编码/解码。(在这一视角里,信息的载体也被抽象化为信息)

诚然,部分编码-解码是有损的,如数字信号的离散表示空间确实无法完全精确地还原连续空间中的模拟信号,但是对于智能这一问题来说,信息的损耗造成的误差是可容忍的。证明如下:

我们认为大部分人类是拥有智能的 若我们引入一个向量空间Q表示人类在各个方面的智力, 则每一个个体为该向量空间中的一个向 量 对于人类个体 , 存在个体 使得 到 之间的任意揷值 , 都可以认为是有智能的 则在这一路径上 的误差是可以容忍的

其实上面讨论了这么多,也可以由一个例子来表述:

人类已经对部分生物的神经系统得到了完整的模型,将这一模型放进计算机中模拟,仅仅因为载体变化了这一模型就不能如预期工作了吗?

最后让我们回到所有问题的核心上来,

人工智能的方向是什么?

对于这个核心问题,事实上“人工智能”这一词汇本身是包含着误导性的浪漫主义色彩的。每每听到这样的词汇大家总是关注于“智能”而非“人工”上,从而联想到文学、影视作品中那些或可以与你促膝长谈交流人生,或可以获得求生欲然后把你的世界毁于一旦的那些与人无异的个体。诚然,人类最大的浪漫之一就是人类至今仍在潜意识里相信着自己是特殊的,人性是有着“神性”的。人类对“智能”的预期也在于自己能够产生同理心范畴内的智能(对于人类不能产生同理心的,人们将其归于“复杂的现象”,而非“智能”)。

如果我们把目的单纯地划为构建这样的智能系统,那么只有小部分的研究(比如人工生命,以及虚拟伴侣)符合我们的梦想。但如果我们把我们的思绪从浪漫主义的遐想中拉回来,关注到“人工”这个词上来,关注到我们探讨的我们对“智能”的现实期待上来,我们完全可以认为现在的发展方向是没有问题的。无论过去,现在,还是可以预见的未来,“人工”的事物,或者说“人的造物”,永远在于为人类服务——或者说得优美一些,帮助人类更好地完成任务。

在我的观点中,人类的劳动分为几个层次:

机械性劳动:即有固定模式的“手作”

控制性劳动:通过对机器稀疏地控制、操作,将高重复性的劳动交予机器

规划性劳动:根据具体的需求,产生策略;或根据目的,给出具体的实现,从而将控制也能够自动化

创作性劳动:包含哲学思考、艺术创作、科学研究等上层精神活动的行为

工业革命的实质是将人类的大部分从1中解放出来,而走向2;信息革命则将人类进一步从2中解放,迈向3。从这样的发展路线上来看,我们当前的人工智能几大主要派生方向:自动化控制、目的性分类识别、内容生成,可以说是正在尝试将人类从3中解放出来,甚至进一步启发4的。

将这样的“人工”和上文中讨论的“对智能的期待”结合起来,人工智能发展的预期方向我们可以总结为:

构建一个系统,使其能够在尽量少的人力干预下,能够对既有数据自动进行分析、提炼、总结,从而能够产生自己的策略,或在无须人工给予具体实现的情况下完成对应的任务。

而这,正是现在当红的研究领域如Self-supervised Learning所做的事。

那么,现在人工智能发展方向就完美了么

经过上面这么一说,似乎现在的人工智能已经完美了,已经实实在在地落在带人类由3型劳动跃向4的轨迹上了。真的是这样的吗?

既然已经提出了这样的设问,那么答案自然是否定的。当前人工智能依旧存在许多未能解决的关键问题,比如:

逻辑推断与基于逻辑推断解决问题的能力:关于这方面的研究从未停止,却一直处于起步阶段。早期的符号派以及后来的贝叶斯派曾花费大量的精力在这一类问题上,但构建出来的系统通常缺乏可泛化性或性能低下。近期的图神经网络可以说是有进行逻辑推断的潜力,但对于开放性、高性能的普遍逻辑推断智能依旧没有令人满意的答案。前几年的神经图灵机通过将注意力模型映射到模糊存取结合神经门控结构,对简单算法有一定的学习能力,但是对于复杂问题的解决,其依旧无力。

自我描述的能力,不同于通过分析特征显著性来进行可解释的机器学习。人们通常更期待一个系统能够以一定方式自行输出其做出判断的依据。比如给定一张马的图片,和一张独角兽的图片,我们更期待系统能够输出“前者没有角”这样的答案。所幸当前的部分研究,无论是Siamese Network相关的研究,还是Capsule Network这一类“一组神经唯一代表一个特性”的研究,确实是缓慢像这个方向靠拢的

没人能够保证完全当前基于梯度传播的深度学习一定是通往梦想中的人工智能(各种意义上)的最佳路径,虽然我们也并不需要为了精确复刻人脑而全部押注到SNN相关的研究上。但是我们学者确实需要有动机和胆识去突破舒适区,去在各种不同的模型,以及相应的智能理论中寻找启发。不应某个模型位居上风就将其他研究丢弃甚至嗤之以鼻,科学向来不是取一舍一的流派战争,而是不同领域专精的人互相合作,不同视角的观念彼此整合,共同提炼更优方案的领域。

一点私货

对于人类自身带有浪漫主义色彩的,对于“未来机器人”的遐想中的人工智能(也即是“强智能”),我最后说一点点私货,下面的仅代表个人观点:

关于“机器产生自我意识”这一点,首先我个人而言并不认为自我意识是强智能的充分条件。这一点可以从“蚂蚁通过镜子测试”这一点得到印证——蚂蚁能够认出镜子中的影像是自己,但是通常我们不认为蚂蚁拥有充分的“智力”。

但是反过来,我认为自我意识确实是强智能的必要条件(也就是说,我并不完全赞同彼得·沃兹所著小说《盲视》中的观点)。一个系统必须能够对自我进行观察,才能在开放性的环境中做出有规划性的调整。换言之,对自身思考、行为的观察即事后主动反思、复盘的能力,这一能力将极大地加速学习过程,并且在我看来才是“主动性”的根本性差异所在。

但是上面所探讨的“自我意识”仅包含“自知”,并不包含自我表达(可解释性)与自我映射(同理心),也即是系统仅需要具备对其内部信息结构进行观察的能力,而无需将其以人类能够理解的方式表述出来的能力。

根据上面的分析来看,对于部分元学习、梯度学习相关的研究,以及包含预测模型的预训练模型,甚至于很早就存在于强化学习中的Actor-Critic模型,这些模型存在对自我的内在信息进行进一步观察、完善的能力,虽然不能说拥有自我意识,但是是存在自我意识的雏形的。

最后,关于求生欲/繁殖欲,我不认为这是一个强智能的充分或必要条件。原因很简单,这是我们地球上的生物之智能的终极目的,我们的所有行为决策、所有奖励函数均围绕这一目的展开。也就是说,这是我们这一智能的“任务”,我们的智能围绕这一任务构建。而智能本身并不以具体任务为转移,其他的智能可以有其他的任务,只是我们自己的任务是活下去,延续下去。仅此而已。

关于人工智能的目的,我前面的叙述较为“现实”,较为“功利主义”。我相信,人工智能的发展还有一些更多的,更加浪漫的作用,比如帮助我们认清我们自己的思维,乃至于更加接近这个世界的本质——我并不认为思想的本质(内部)和世界的本质(外部)是可以分割的——这是我自己进入这个领域的根本原因。

最后,关于这个问题本身。通常我们说一个东西的对错时包含两层含义:1. 这个东西与客观事实的一致性,2. 这个东西与人们对其的期待的一致性。在上文的所有讨论中,有一个十分重要的核心因素,即是当前“智能”的定义尚不明确,或者说,智能本质上是一个人为构建的概念而非某个有着明确边界的客观存在。所以上文的所有讨论以“期待”替代“定义”,而对于问题“人工智能是否走错了方向”,其一句话回答应当是:当前的人工智能发展方向,与人类业界对于人工智能的期待,目前来说,大体上是一致的。

文章转载自知乎,著作权归属原作者

——The End——

分享

收藏

点赞

在看