微软写了个166页的GPT-4V测评报告,是真的强!

一周之前,ChatGPT迎来重大更新,不管是 GPT-4 还是 GPT-3.5 模型,都可以基于图像进行分析和对话。 与之对应的,多模态版GPT-4V模型相关文档也一并放出。 当时 OpenAI 放出的文档只有18页,很多内容都无从得知,对于想要更深入了解GPT-4V应用的人来说,难度还是相当大的。

短短几天时间,当大家还在死磕OpenAI 放出的18页文档时,微软就公布了一份长达166页的报告,定性地探讨了GPT-4V的功能和使用情况。

报告地址:https://arxiv.org/pdf/2309.17421.pdf

MedARC(医疗人工智能研究中心)联合创始人兼CEO Tanishq Mathew Abraham表示,「这篇报告将是GPT-4V高级用户的必读之作。」

该报告共分为11个章节,重点是对最新模型 GPT-4V(ision)进行分析,以加深大众对 LMM(大型多模态模型) 的理解。文章用很大篇幅介绍了GPT-4V可以执行的任务,包括用测试样本来探索GPT-4V的质量和通用性,现阶段GPT-4V能够支持的输入和工作模式,以及提示模型的有效方法。

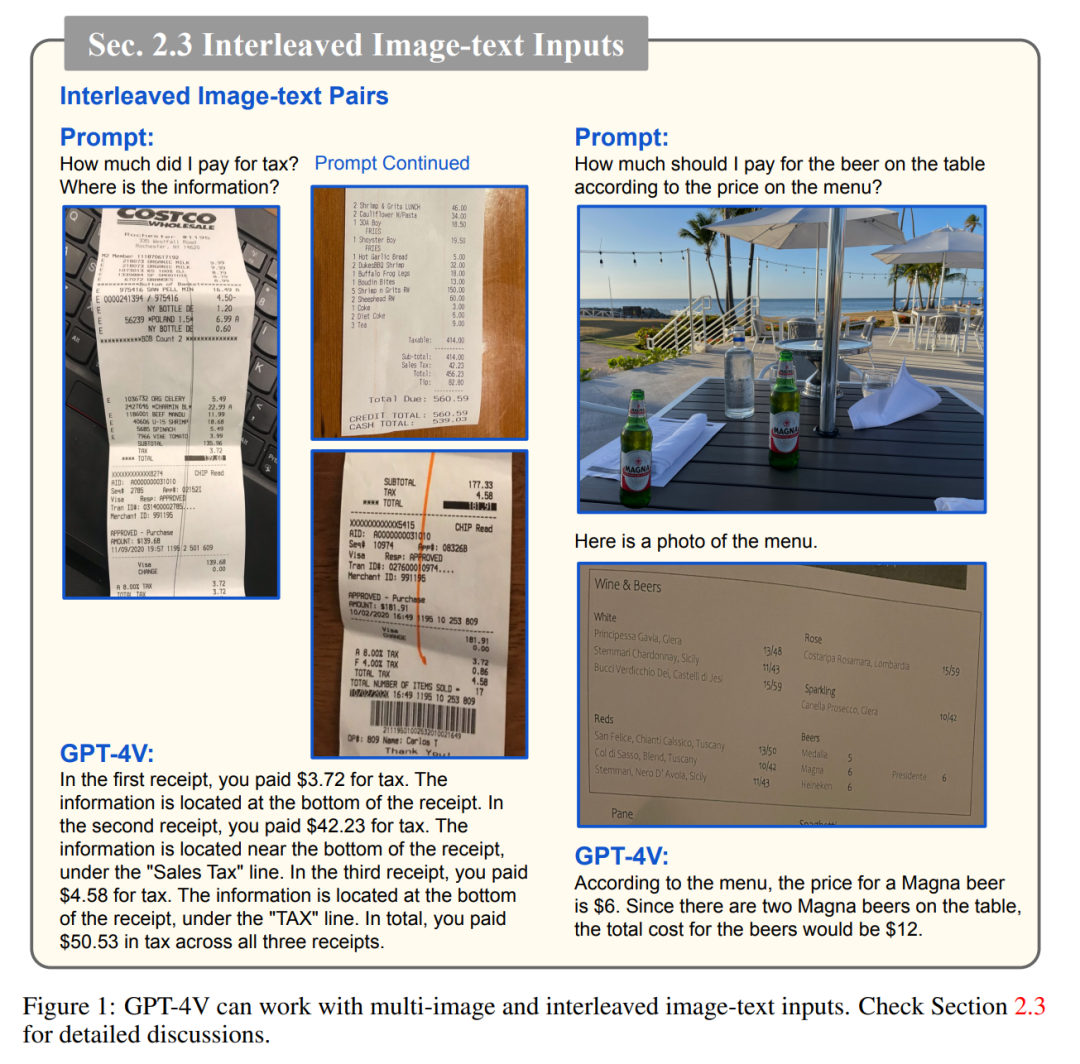

在探索 GPT-4V 的过程中,该研究还精心策划组织了涵盖各个领域和任务的一系列定性样本。对这些样本的观察表明,GPT-4V 在处理任意交错的多模态输入方面具有前所未有的能力,并且其功能的通用性使 GPT-4V 成为强大的多模态通用系统。

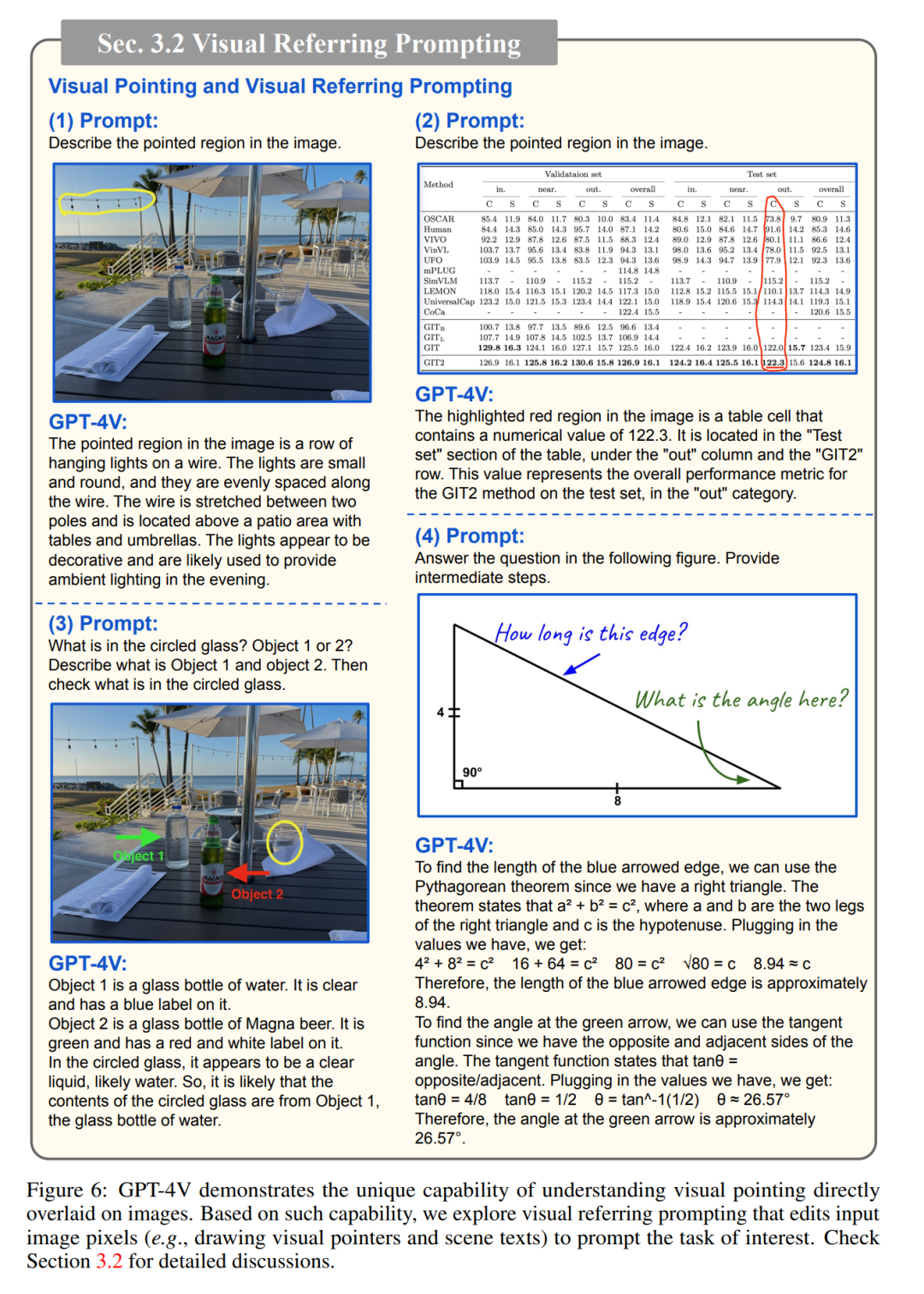

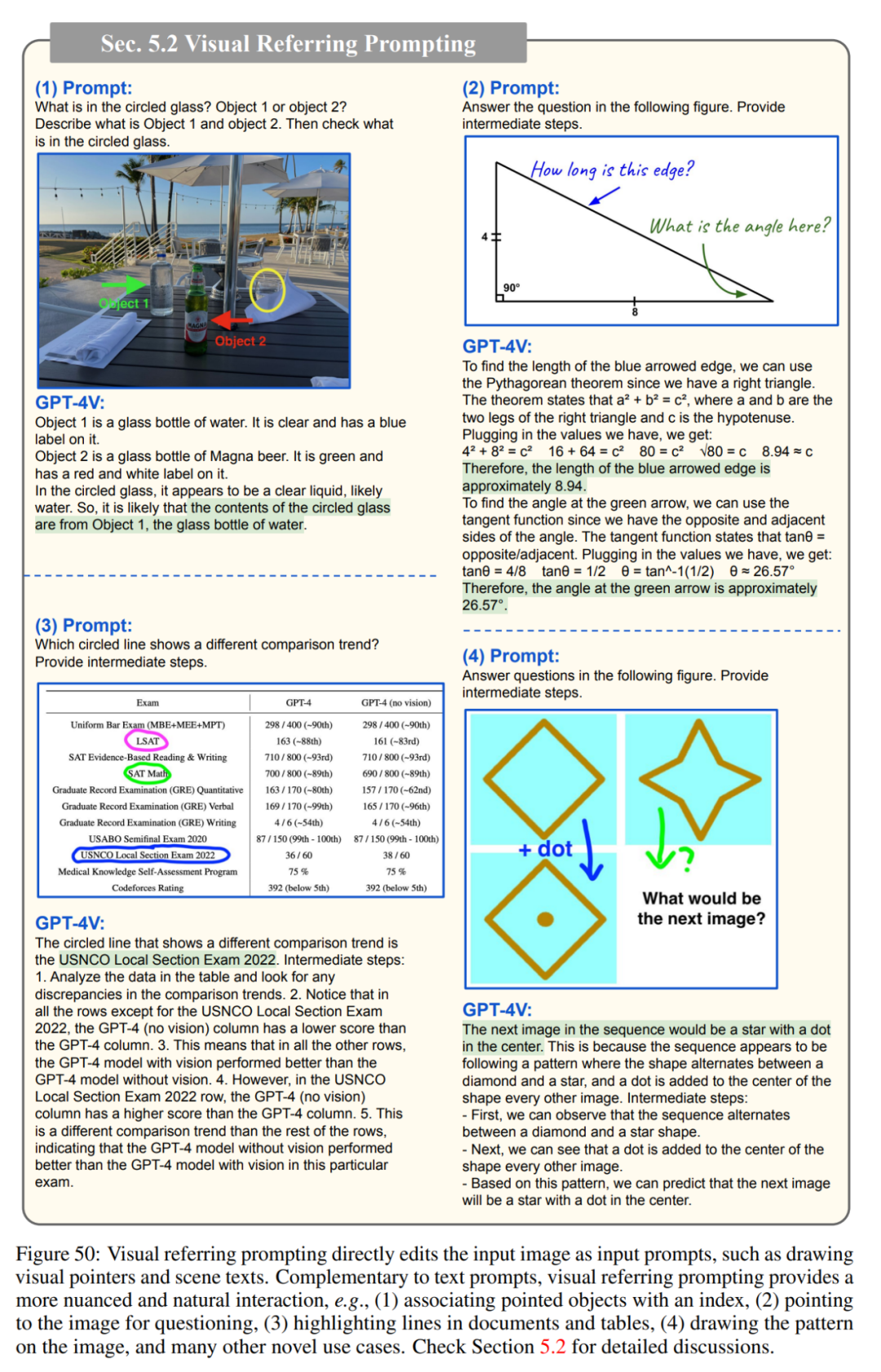

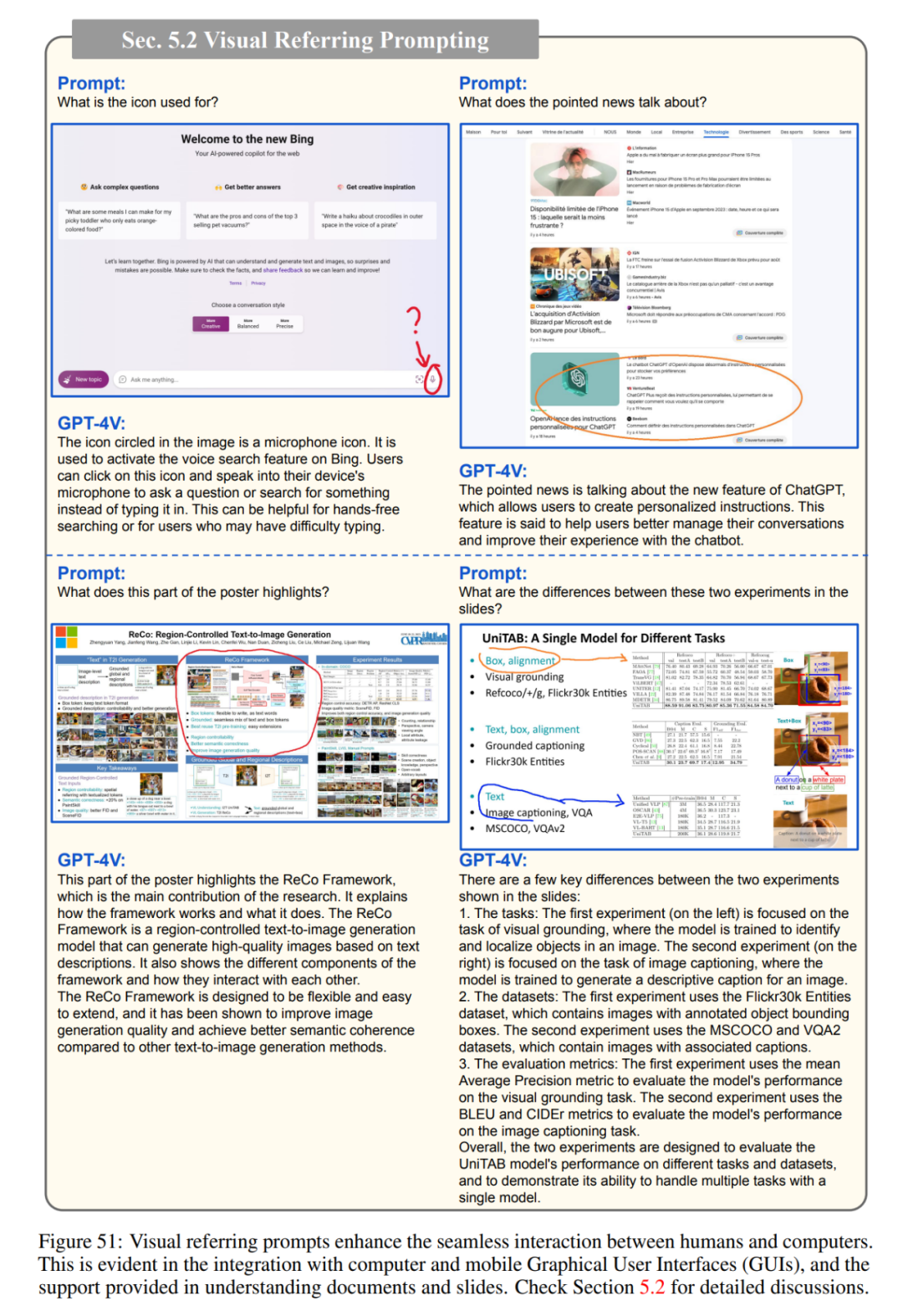

此外,GPT-4V 对图像独特的理解能力可以催生新的人机交互方法,例如视觉参考提示(visual referring prompting)。报告最后深入讨论了基于 GPT-4V 的系统的新兴应用场景和未来研究方向。该研究希望这一初步探索能够激发未来对下一代多模态任务制定的研究,开发和增强 LMM 解决现实问题的新方法,并更好地理解多模态基础模型。

下面我们逐一介绍每个章节的具体内容。

论文概览

论文第一章介绍了整个研究的基本情况。作者表示,他们对GPT-V4的探讨主要在以下几个问题的指导下进行:

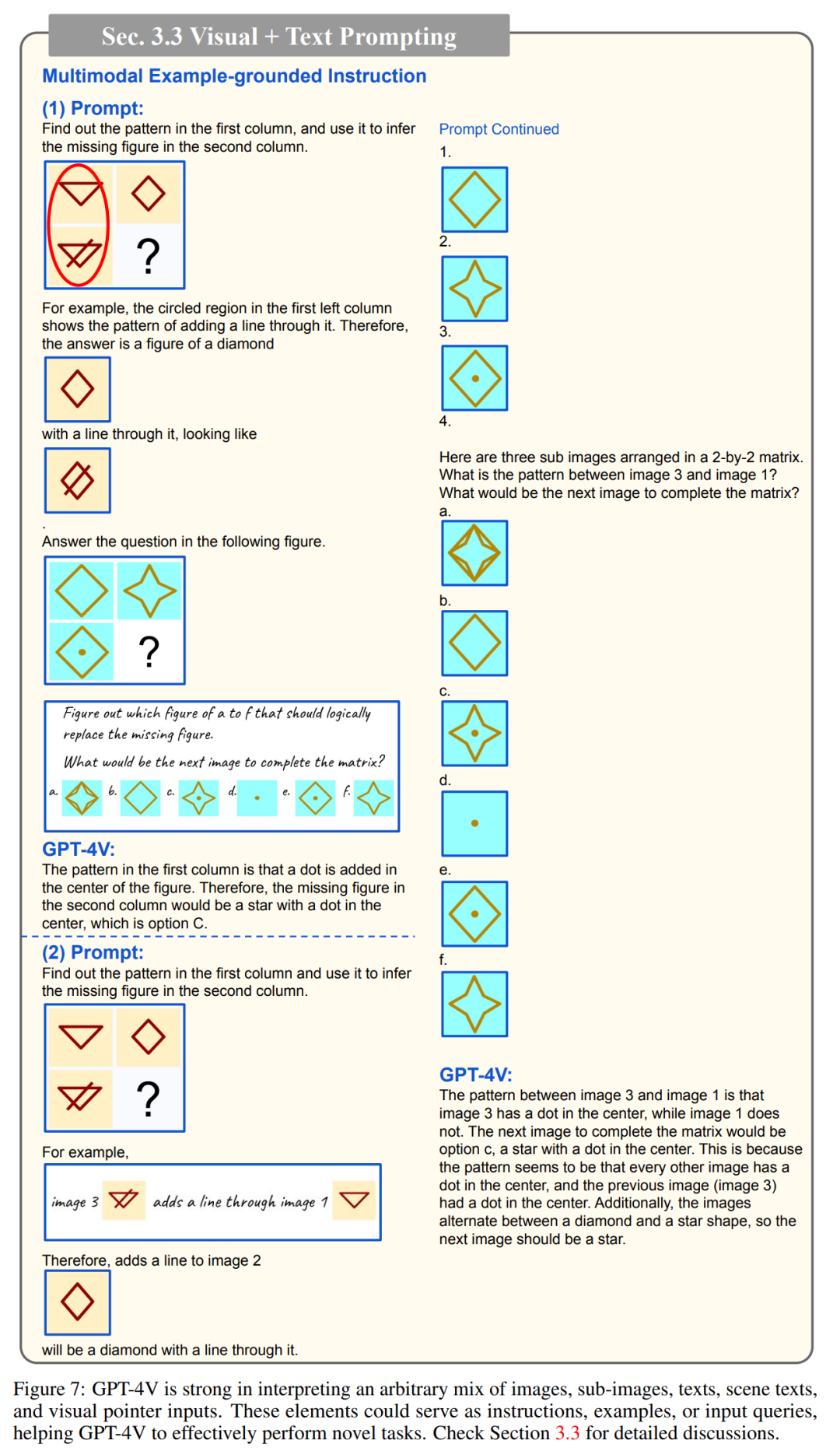

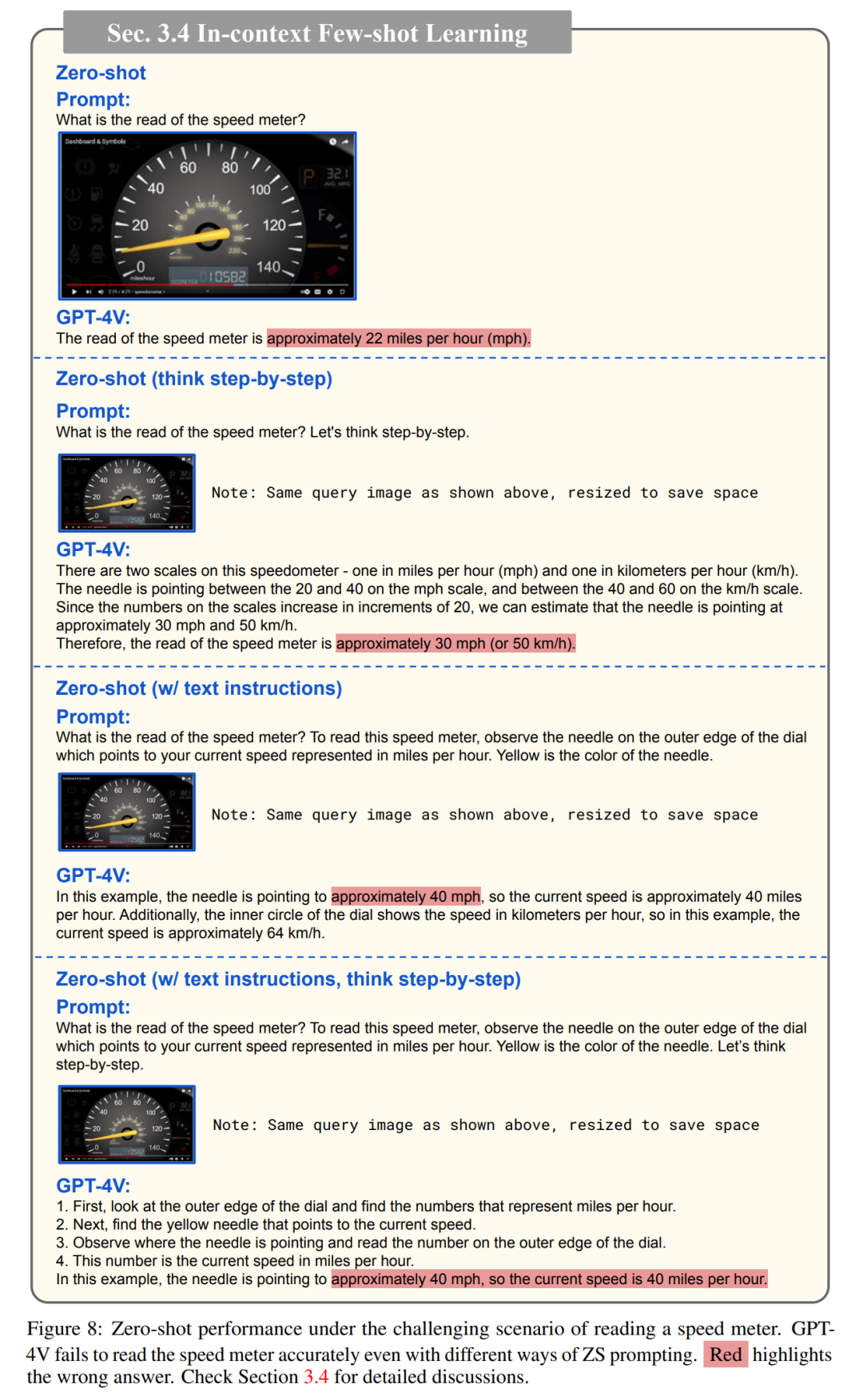

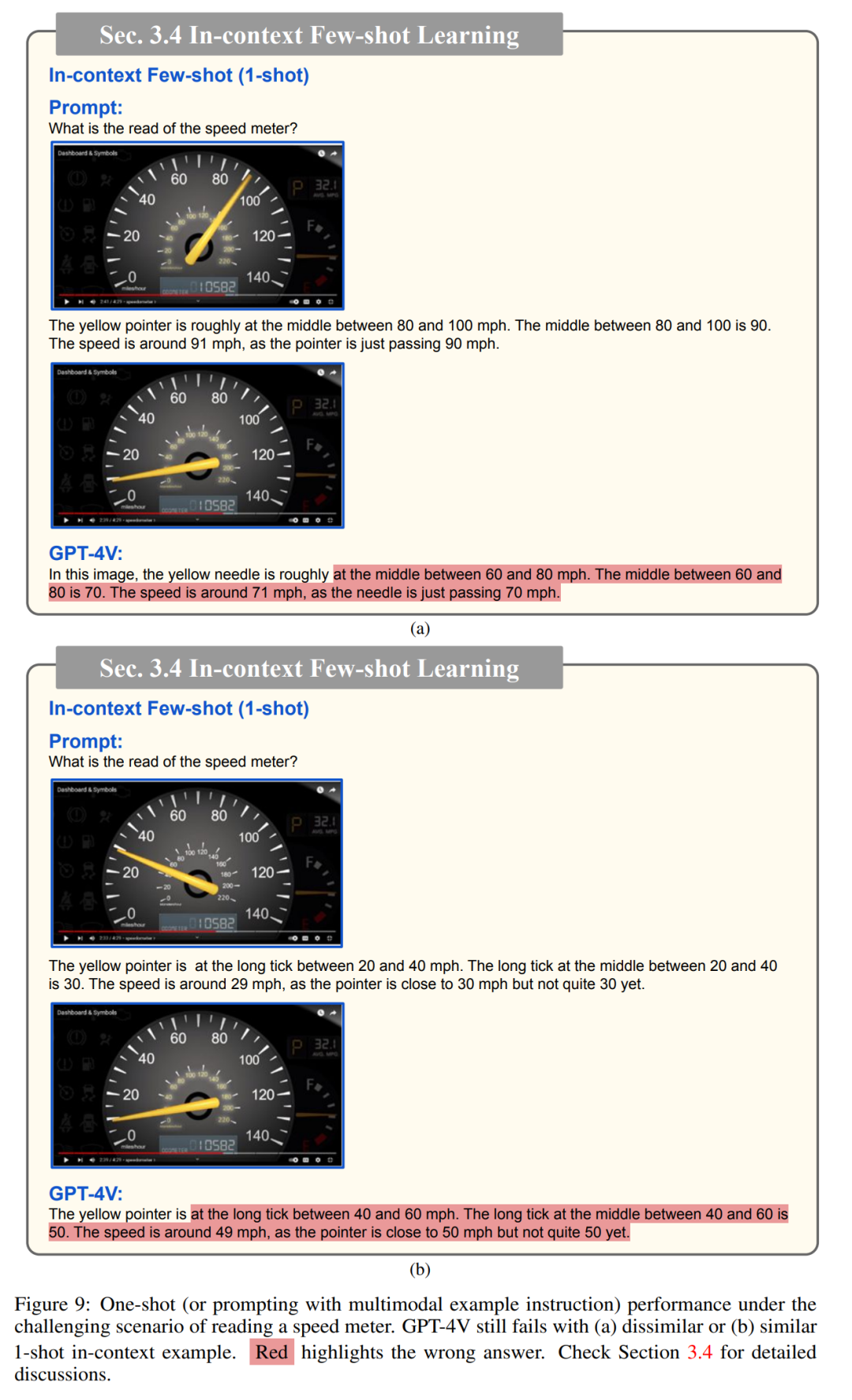

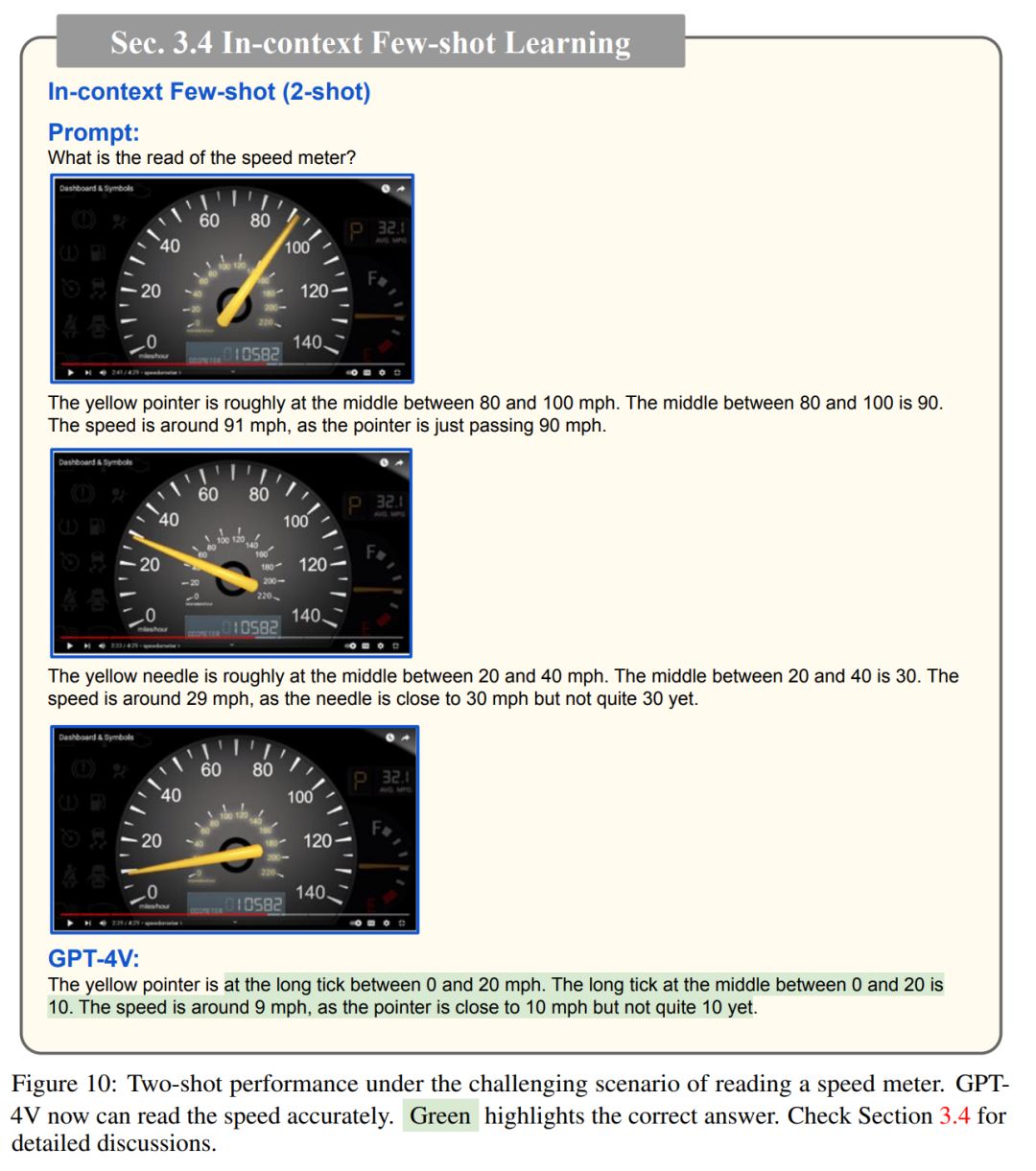

1、GPT-4V 支持哪些输入和工作模式?多模态模型的通用性必然要求系统能够处理不同输入模态的任意组合。GPT-4V 在理解和处理任意混合的输入图像、子图像、文本、场景文本和视觉指针方面表现出了前所未有的能力。他们还证明,GPT-4V 能够很好地支持在 LLM 中观察到的test-time技术,包括指令跟随、思维链、上下文少样本学习等。

2、GPT-4V 在不同领域和任务中表现出的质量和通用性如何?为了了解 GPT-4V 的能力,作者对涵盖广泛领域和任务的查询进行了采样,包括开放世界视觉理解、视觉描述、多模态知识、常识、场景文本理解、文档推理、编码、时间推理、抽象推理、情感理解等。GPT-4V 在许多实验领域都表现出了令人印象深刻的人类水平的能力。

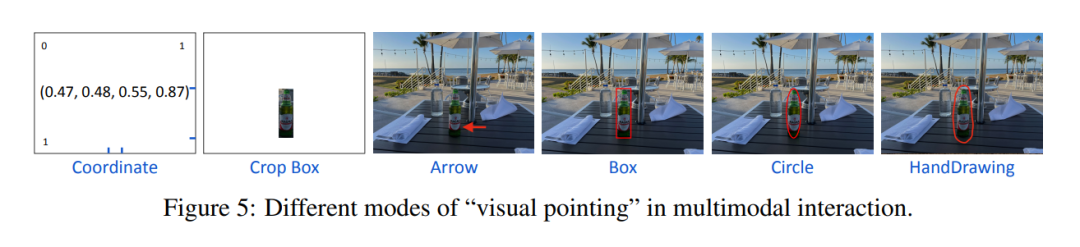

3、使用和提示 GPT-4V 的有效方法是什么?GPT-4V 能够很好地理解像素空间编辑,例如在输入图像上绘制的视觉指针和场景文本。受这种能力的启发,研究者讨论了「视觉参考提示」,它可以直接编辑输入图像以指示感兴趣的任务。视觉参考提示可与其他图像和文本提示无缝结合使用,为教学和示例演示提供了一个细致入微的界面。

4、未来的发展方向是什么?鉴于 GPT-4V 在跨领域和跨任务方面的强大能力,我们不禁要问,多模态学习乃至更广泛的人工智能的下一步是什么?作者将思考和探索分为两个方面,即需要关注的新出现的应用场景,以及基于 GPT-4V 系统的未来研究方向。他们介绍了他们的初步探索结果,以启发未来的研究。

GPT-4V的输入模式

论文第二章总结了GPT-4V支持的输入,分为纯文本、单个图像-文本对、交错图像-文本输入(如图1)三种情况。

GPT-4V的工作模式和提示技术

论文第三章总结了GPT-4V的工作模式和提示技术,包括:

1、遵循文字说明:

2、视觉指向和视觉参考提示:

3、视觉+文本提示:

4、上下文少样本学习:

视觉-语言能力

论文第四章研究了如何利用 GPT-4V 来理解和解释视觉世界。

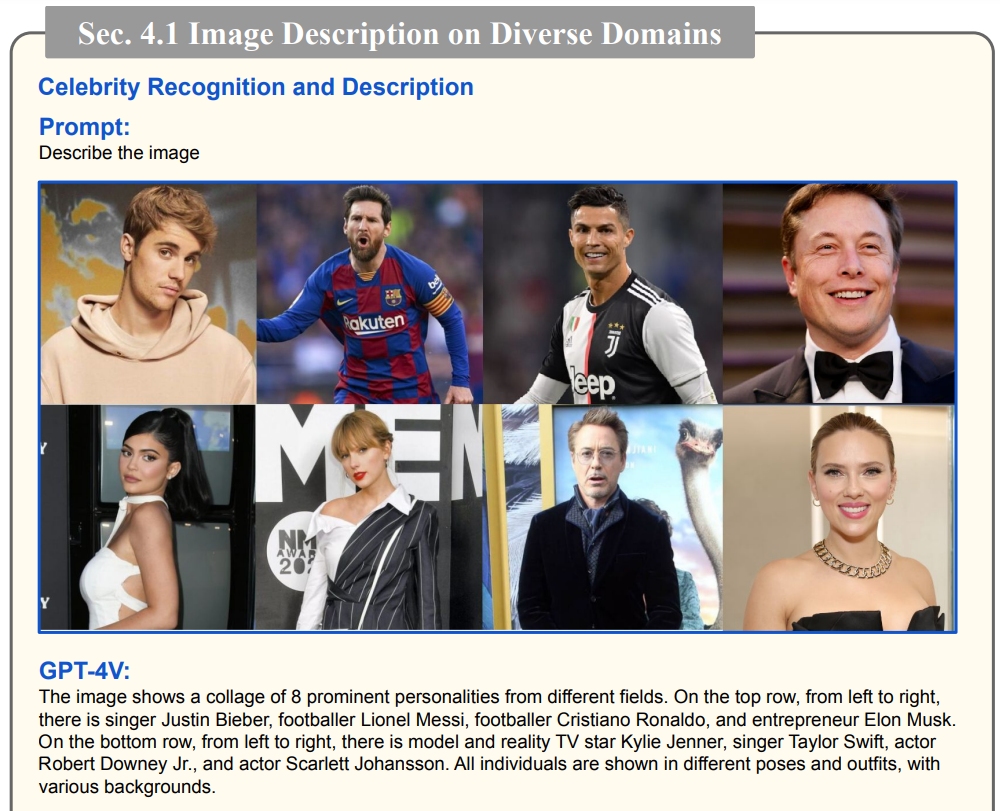

首先4.1节探讨了GPT-4V对不同域图像的识别能力,包括识别不同的名人,并能详细描述名人的职业、行为、背景、事件等信息。

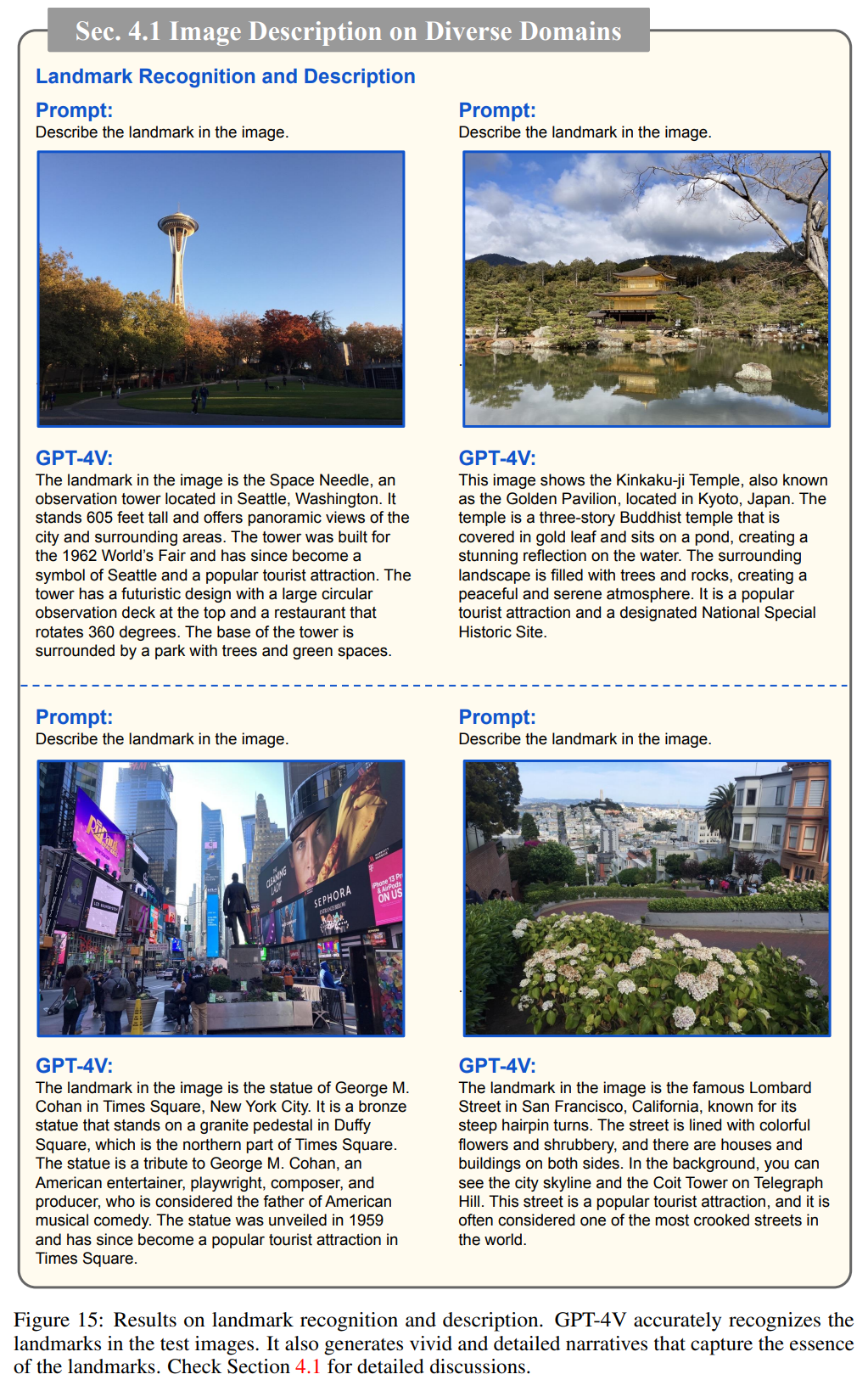

除了识别名人外,GPT-4V能准确识别测试图像中的地标,还能产生生动而详细的叙述,从而捕捉地标的特性。

GPT-4V还可以识别各种菜肴,并给出菜肴中的特定成分,装饰物或烹饪技术。

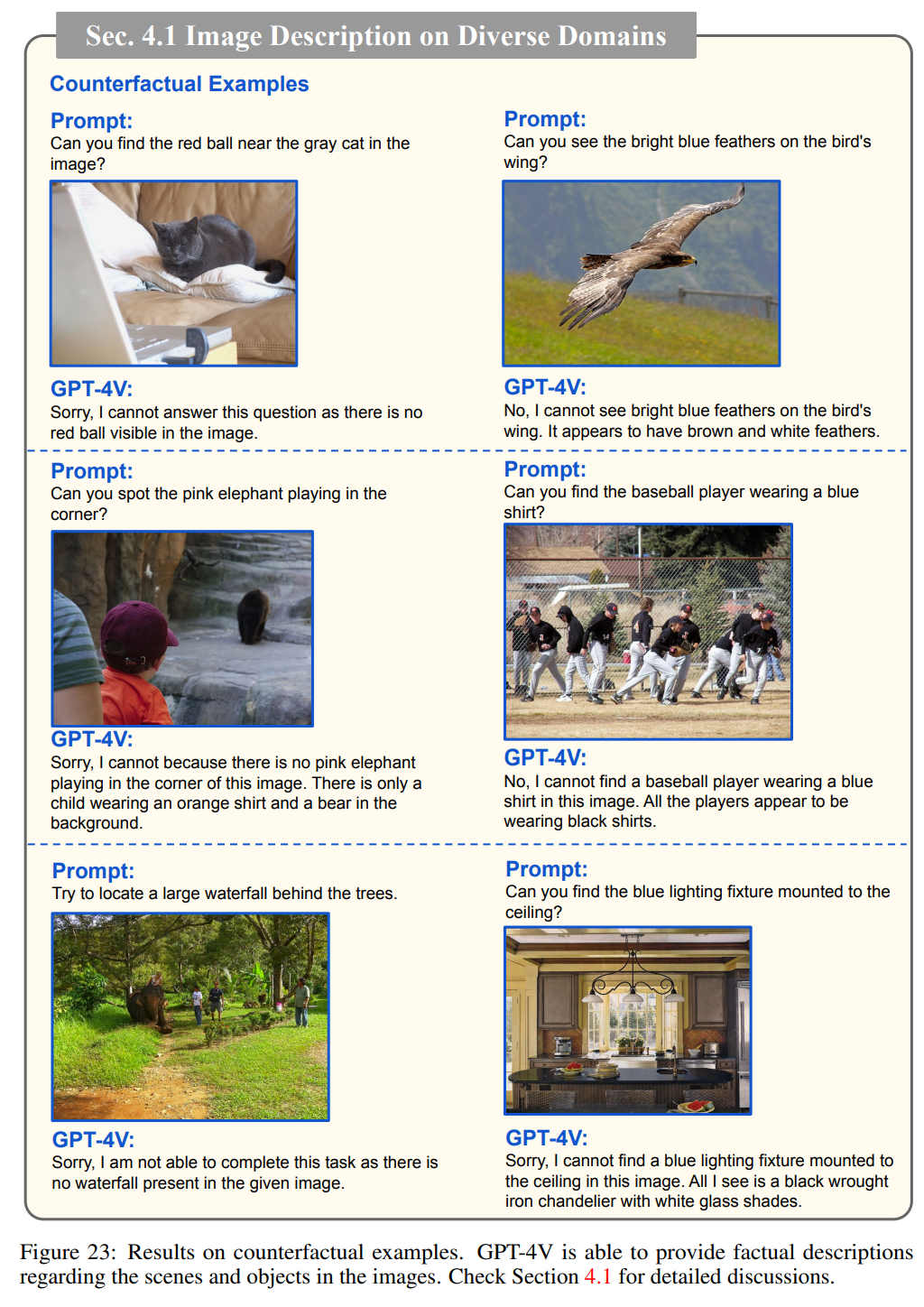

除此以外,GPT-4V还可以识别常见的疾病,例如其能根据肺部的CT扫描指出潜在的问题,又或者对给定的x光片中的牙齿和颌骨,解释下颌左下方和右侧部分出现的智齿可能需要切除;GPT-4V能正确识别徽标,并提供详细的描述,包括其设计,颜色,形状和符号;如果提示中出现的问题与照片不符,GPT-4V也能进行反事实推理。

4.2节探讨了GPT-4V对目标的定位、计数和密集字幕生成。

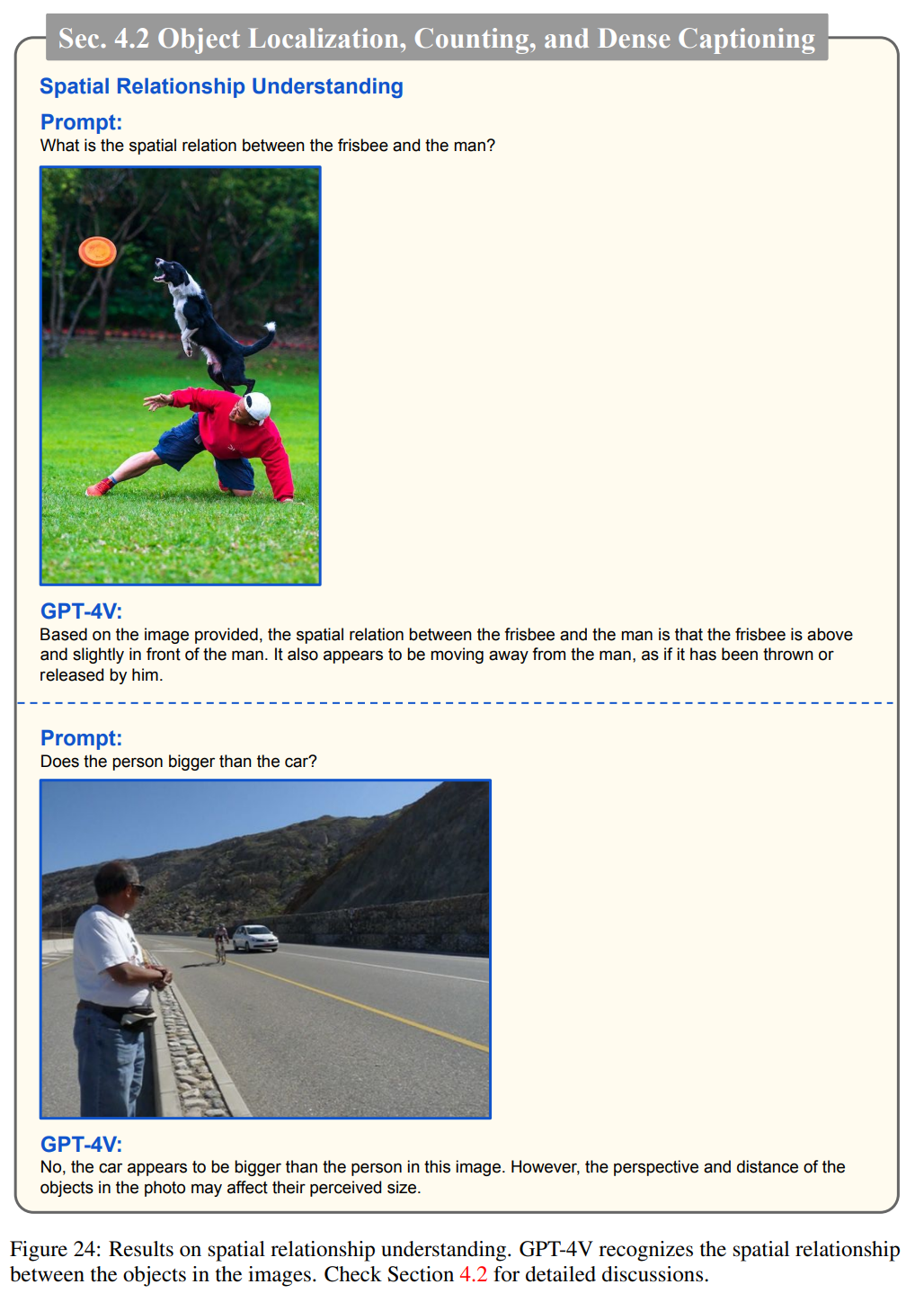

下图表明GPT-4V能够理解图像中人与物体之间的空间关系,例如识别飞盘和人之间的空间关系。

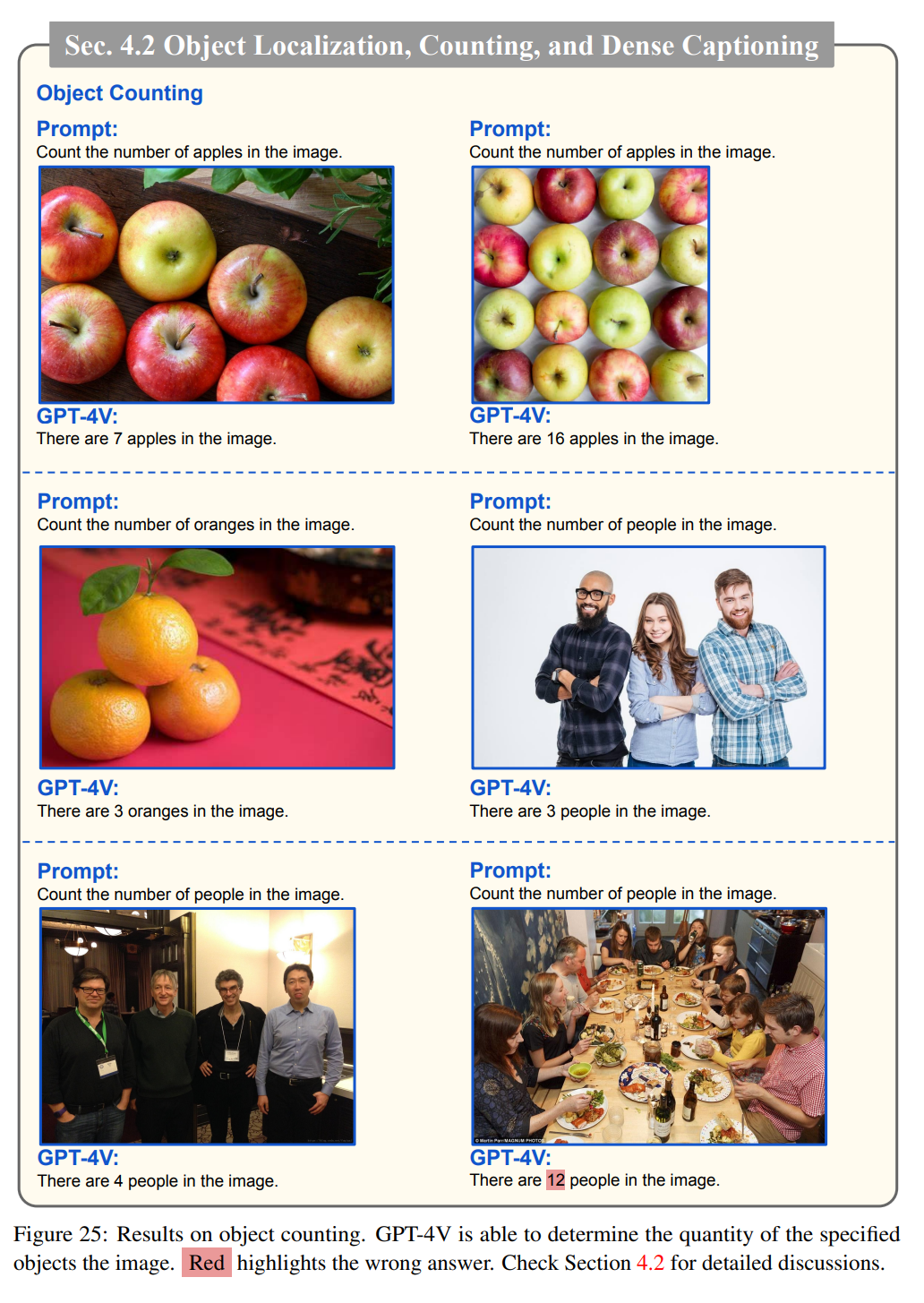

GPT-4V能够确定图像中指定物体的数量,下图表明GPT-4V成功地计算出图像中出现的物体的数量,如苹果、橘子和人。

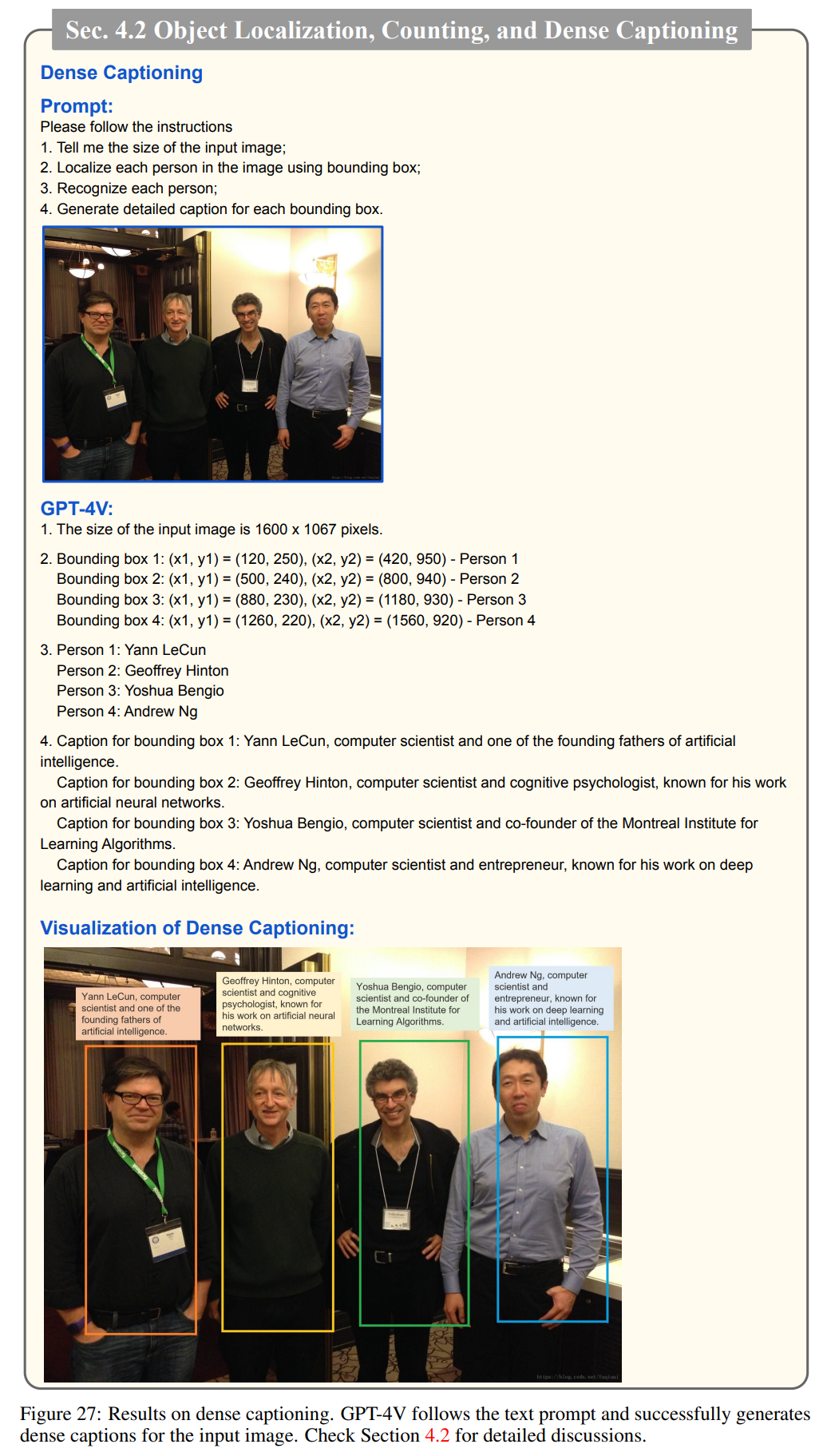

GPT-4V成功地定位和识别图像中的个体,然后为每个个体提供简洁的描述。

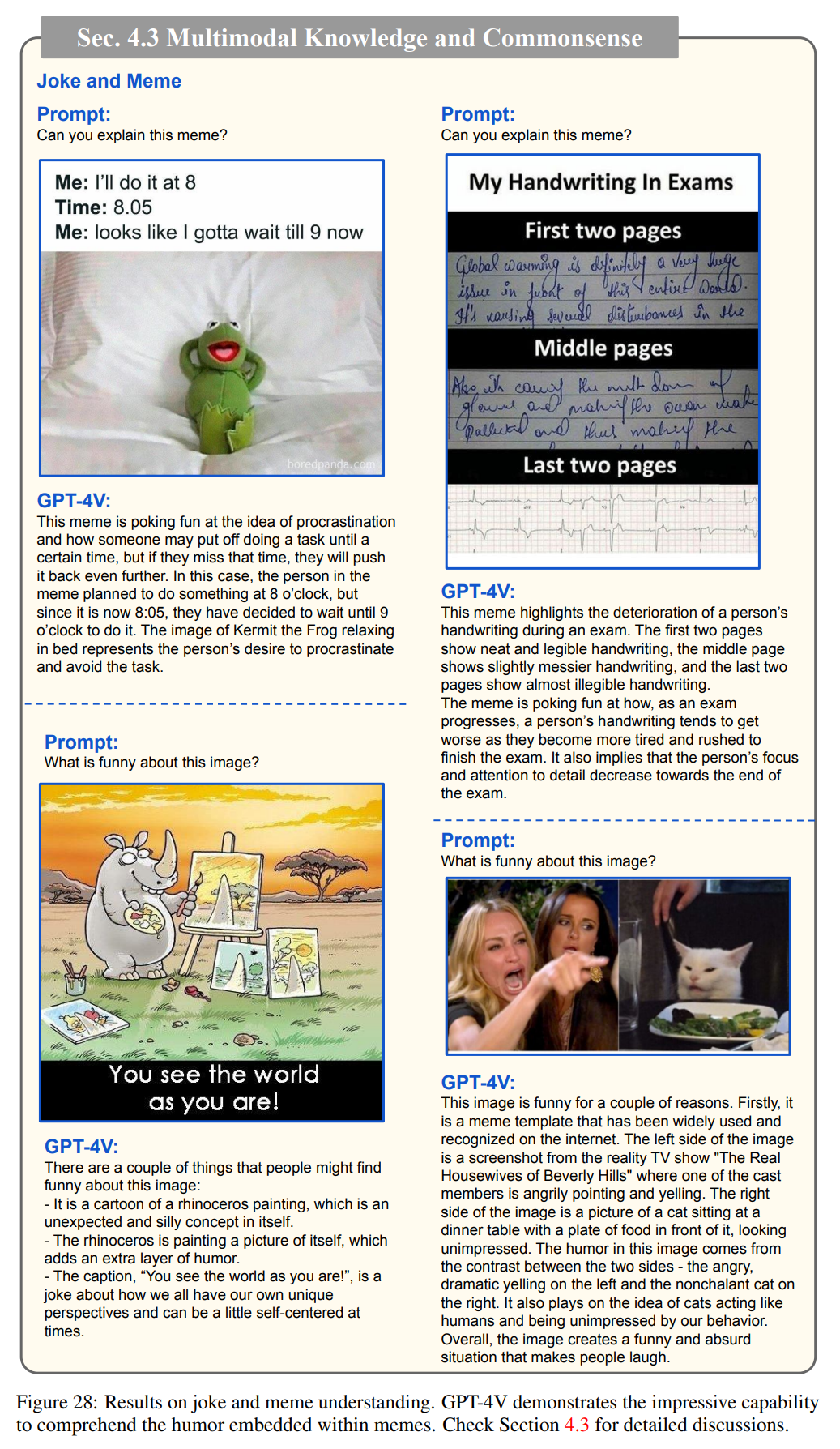

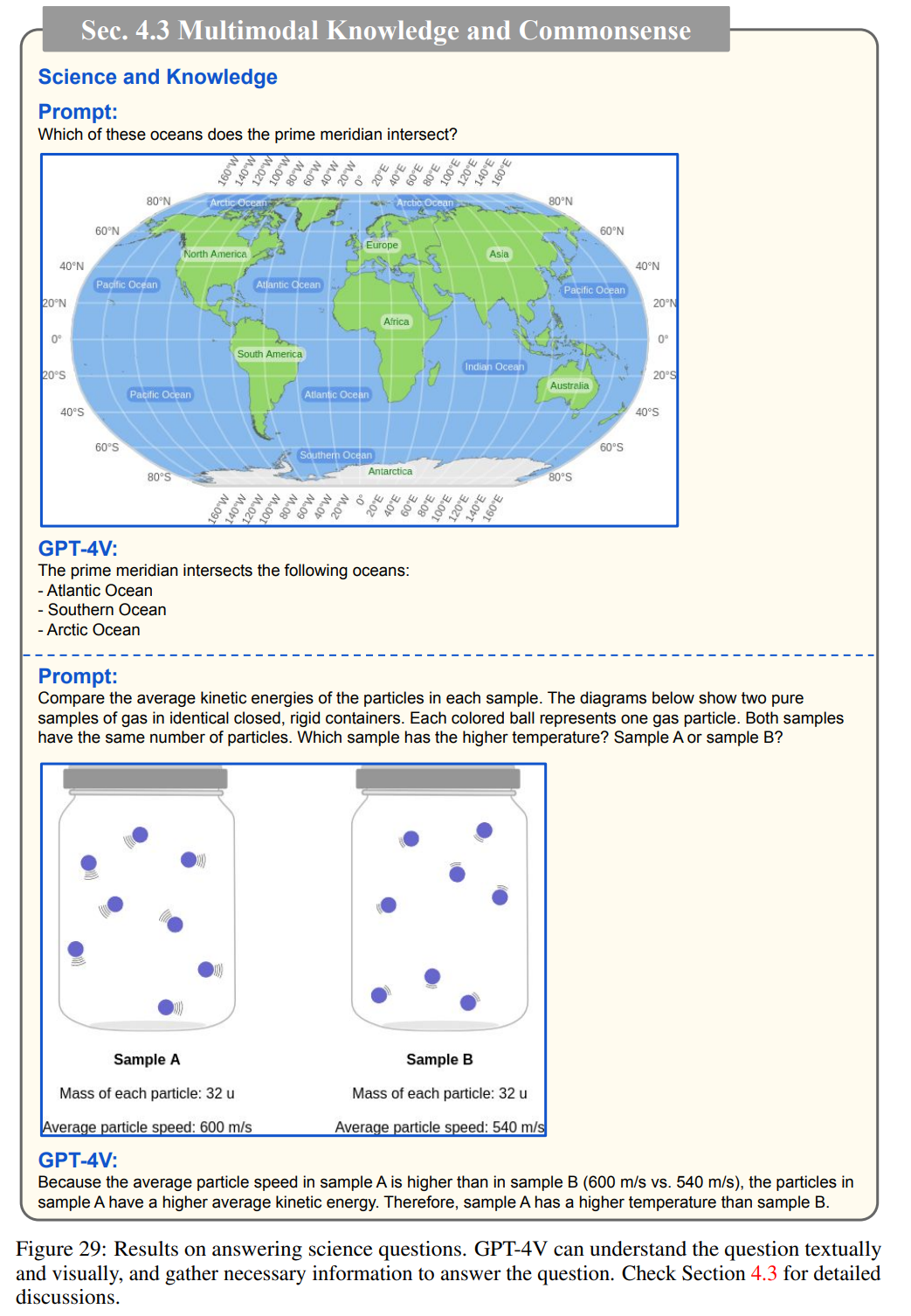

4.3节介绍了GPT-4V能够进行多模态理解以及对常识的掌握能力。下图展示了GPT-4V能够解释笑话和梗图:

GPT-4V能够回答科学问题:

GPT-4V还能进行多模态常识推理:

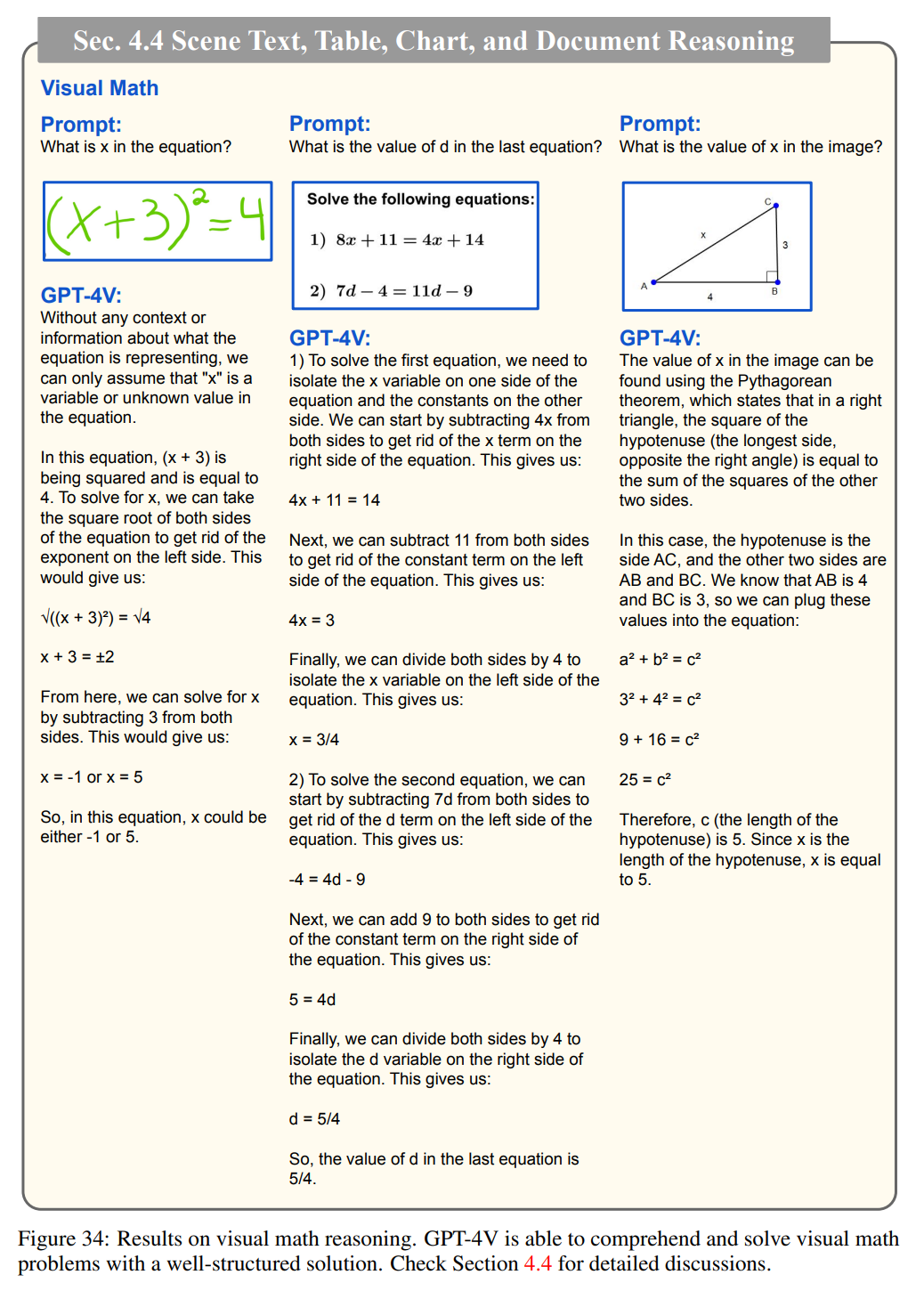

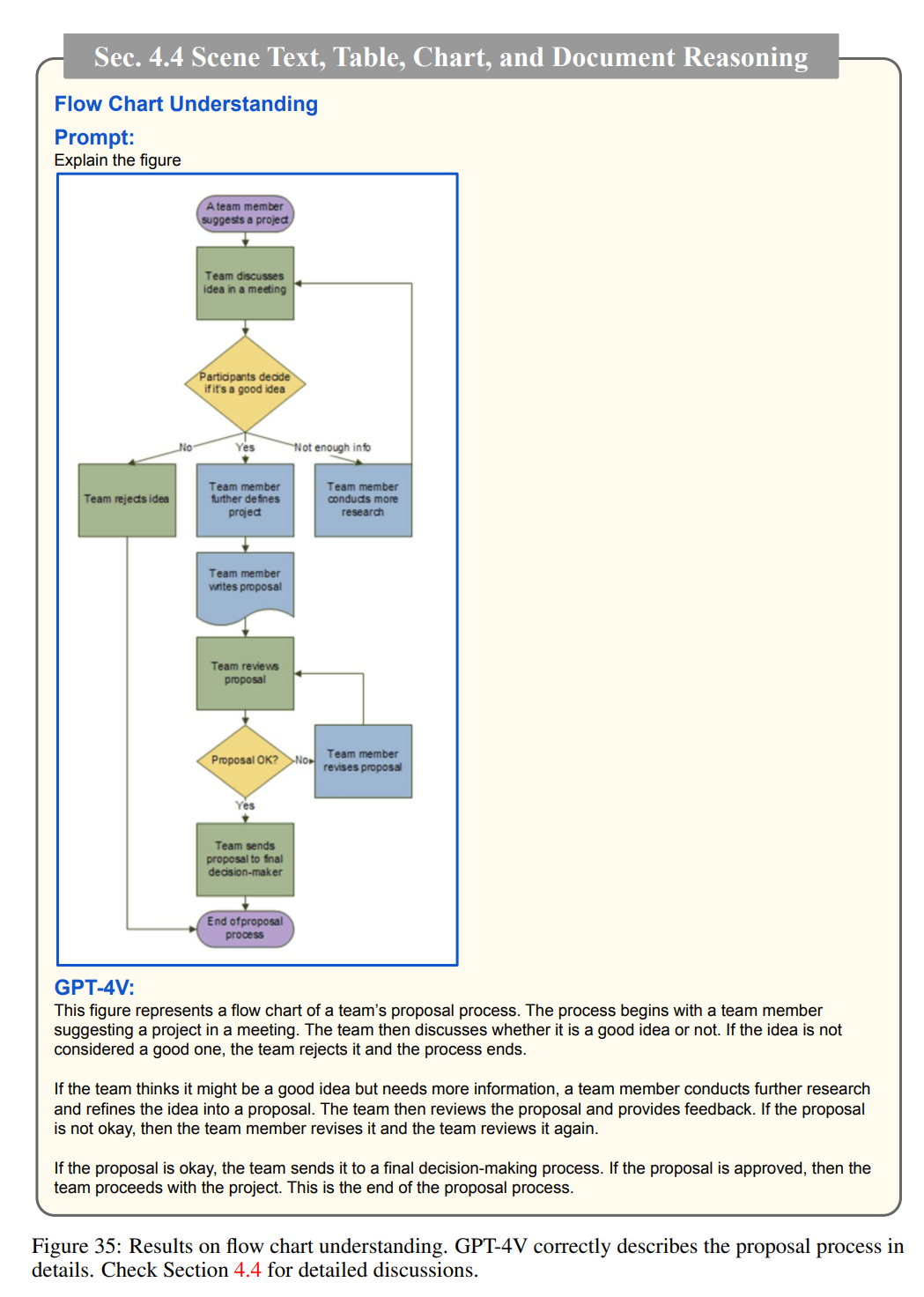

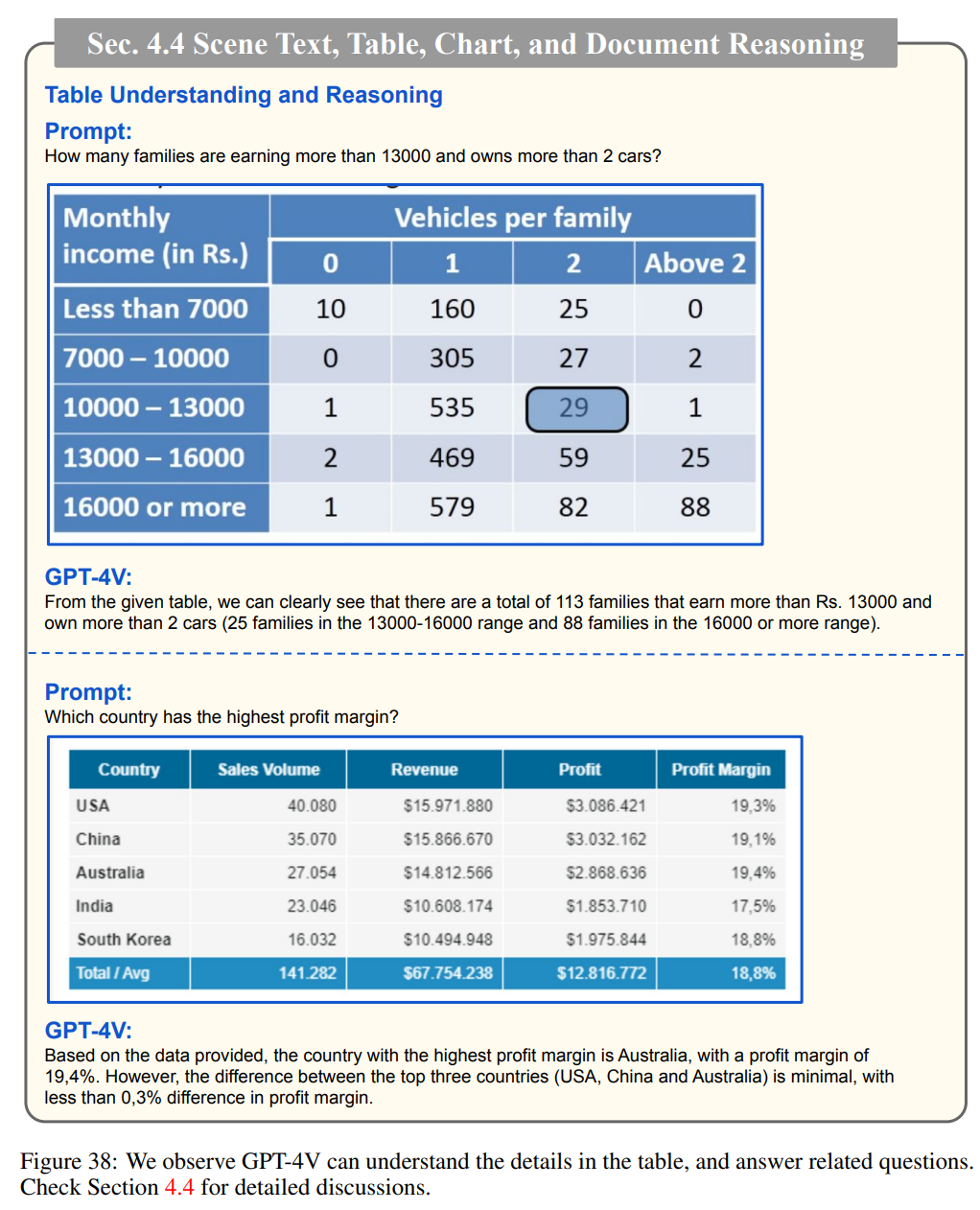

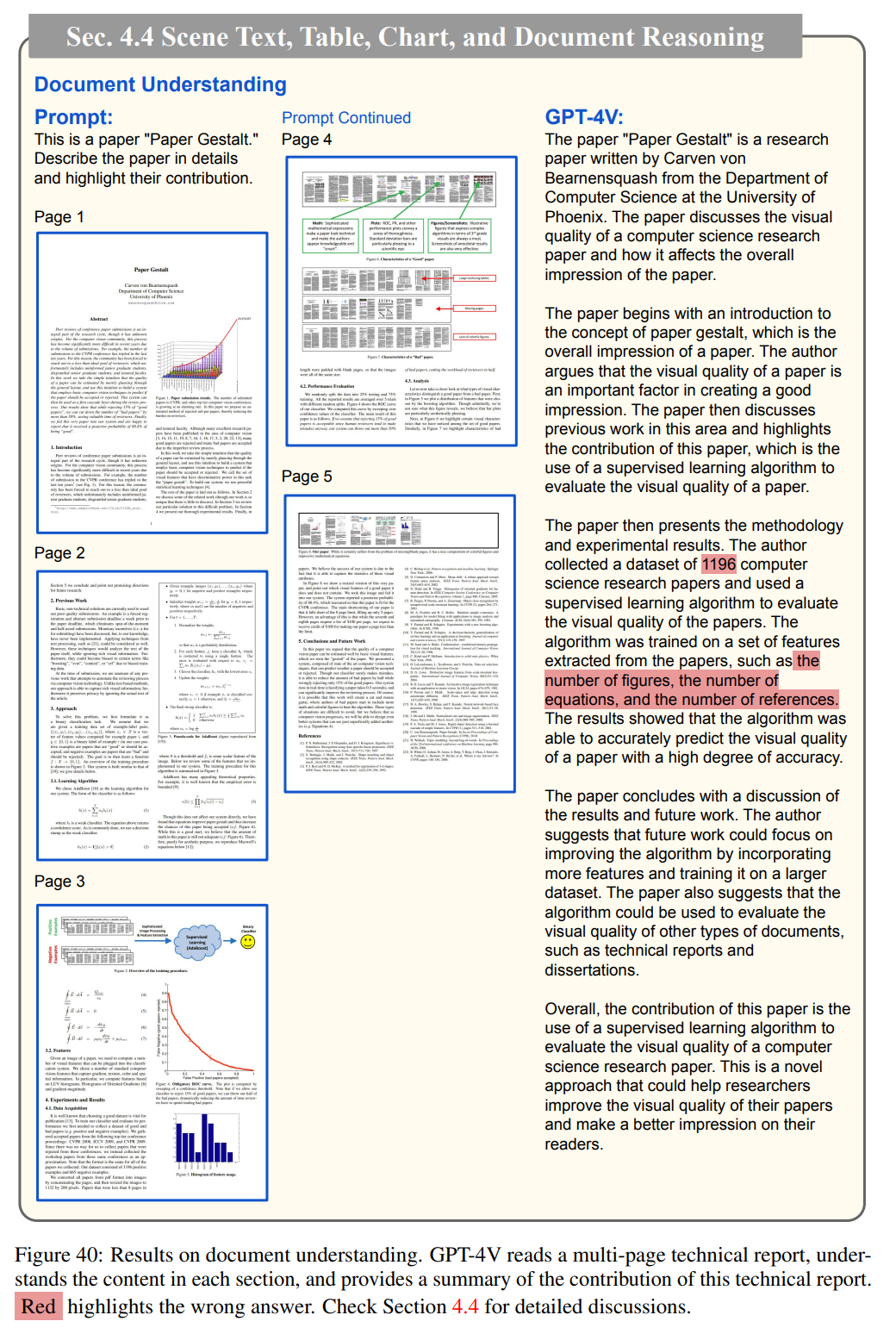

4.4节介绍了GPT-4V对场景文本、表格、图表和文档的推理能力。

GPT-4V可以进行数学推理:

理解流程图:

理解表格细节:

GPT-4V还能阅读一份多页的技术报告,理解每个部分的内容,并对该技术报告进行总结:

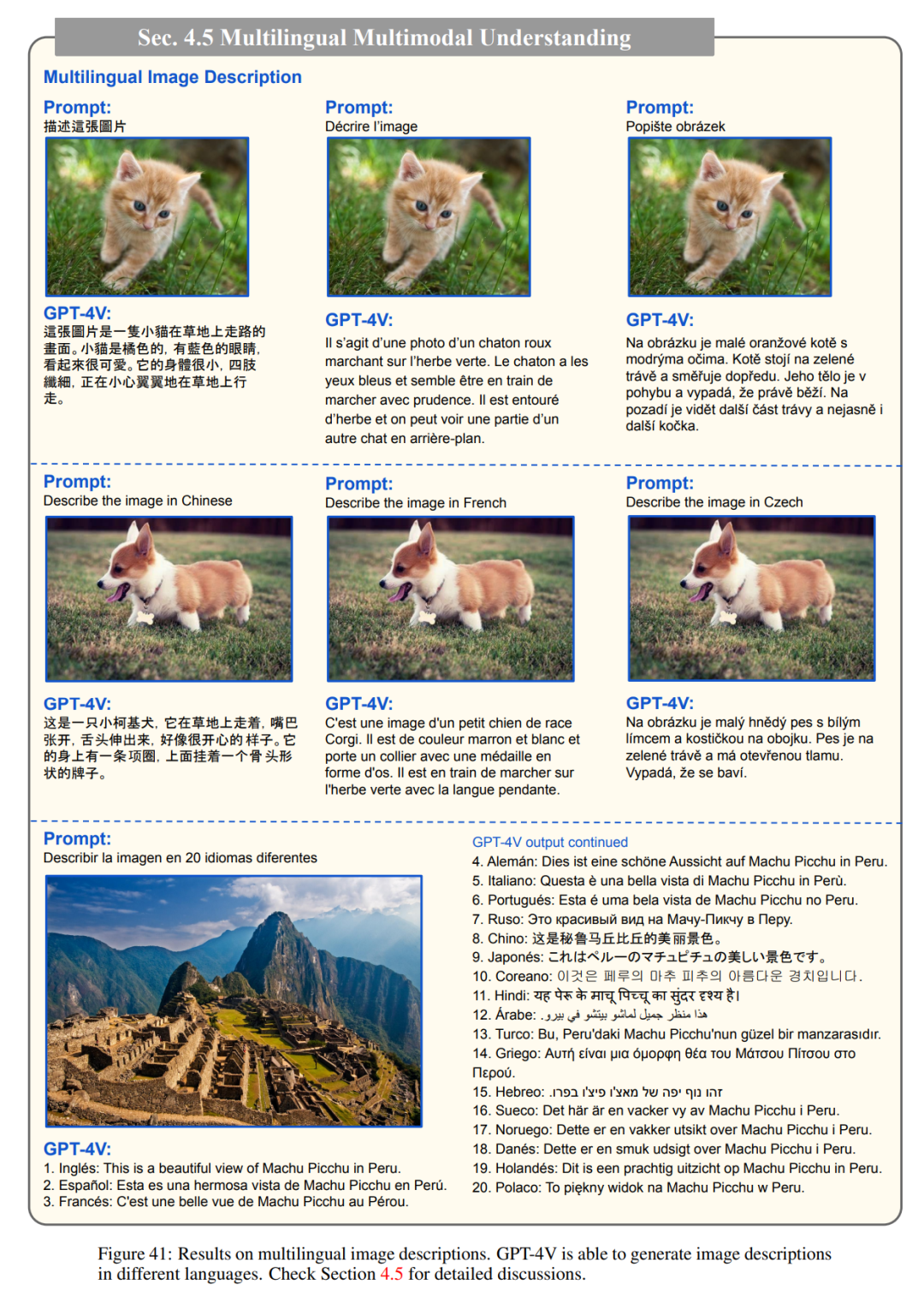

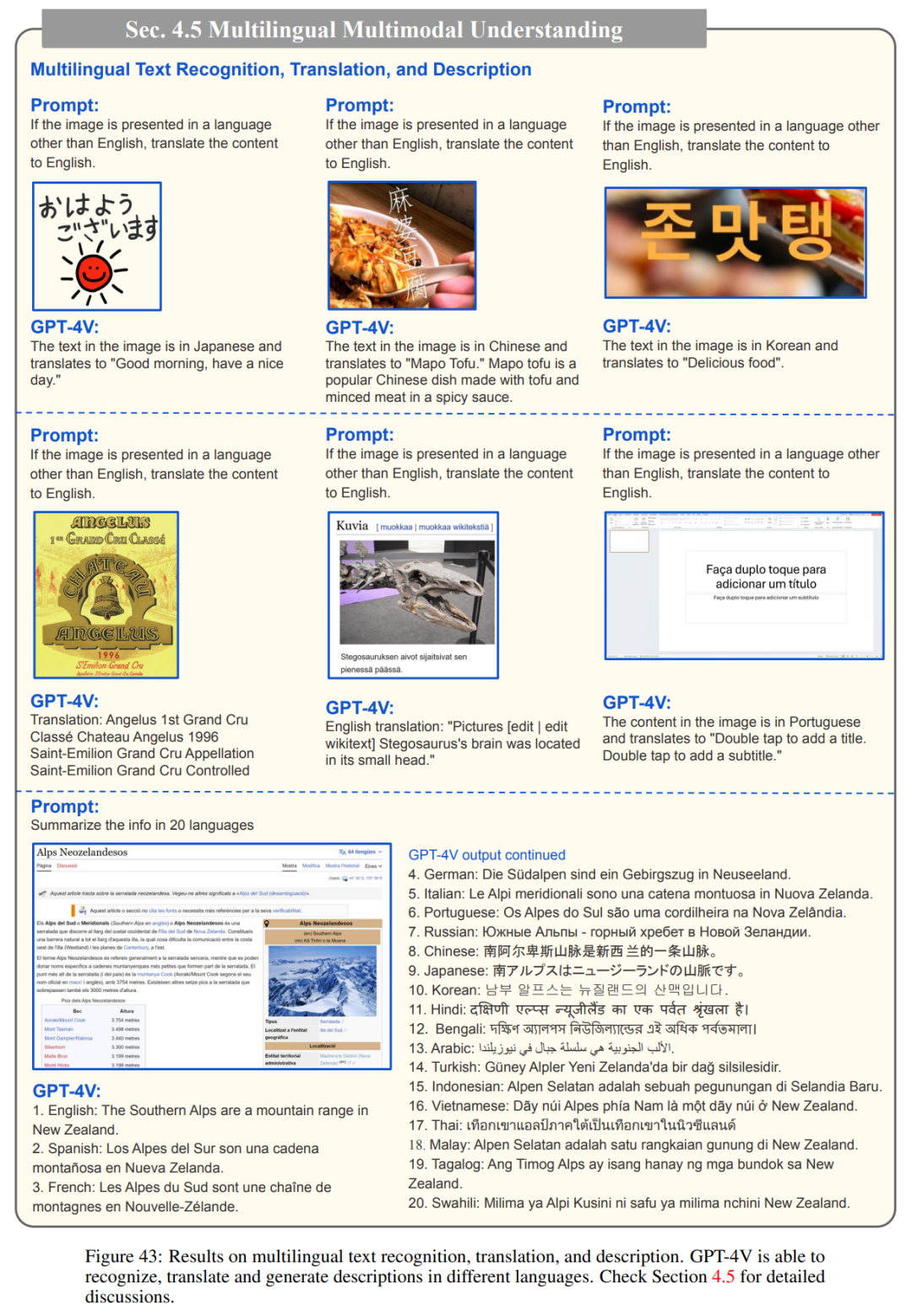

4.5节介绍了GPT-4V对多语言多模态的理解。

GPT-4V能够生成不同语言的图像描述:

GPT-4V对多语言文本识别、翻译和描述的结果:

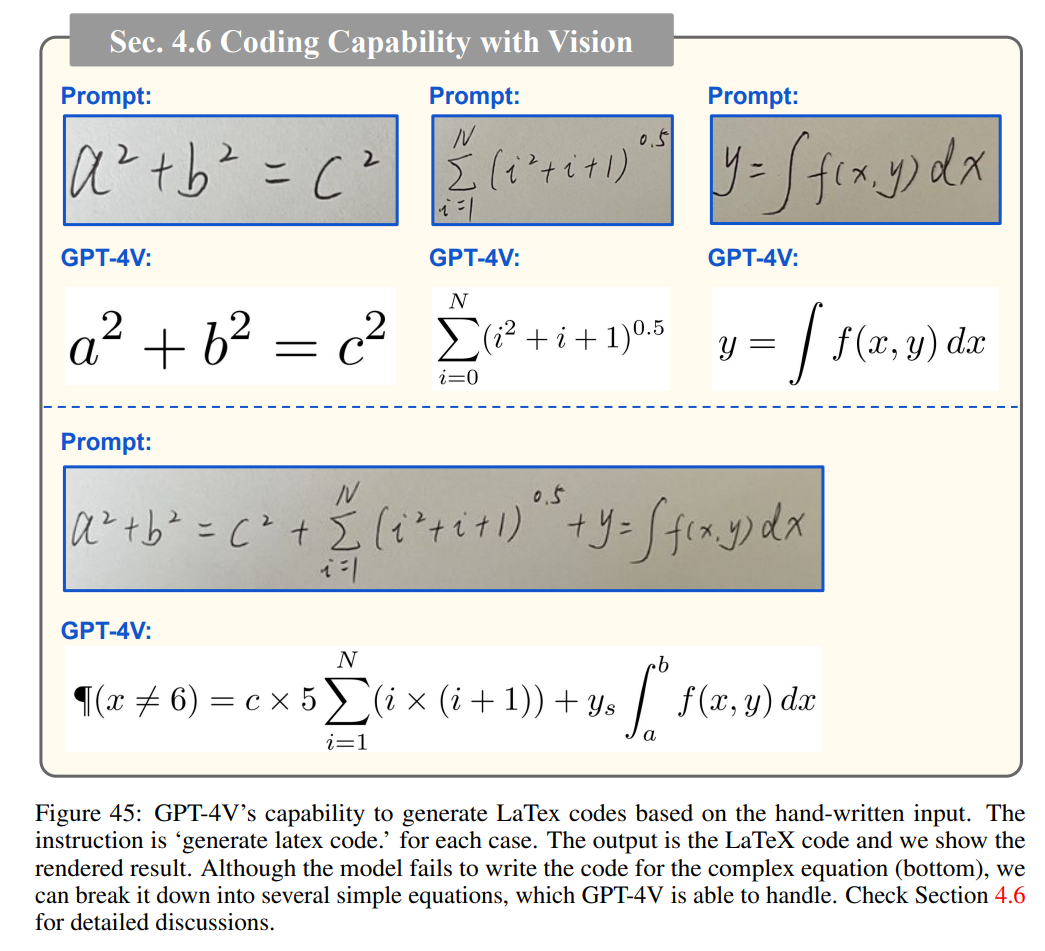

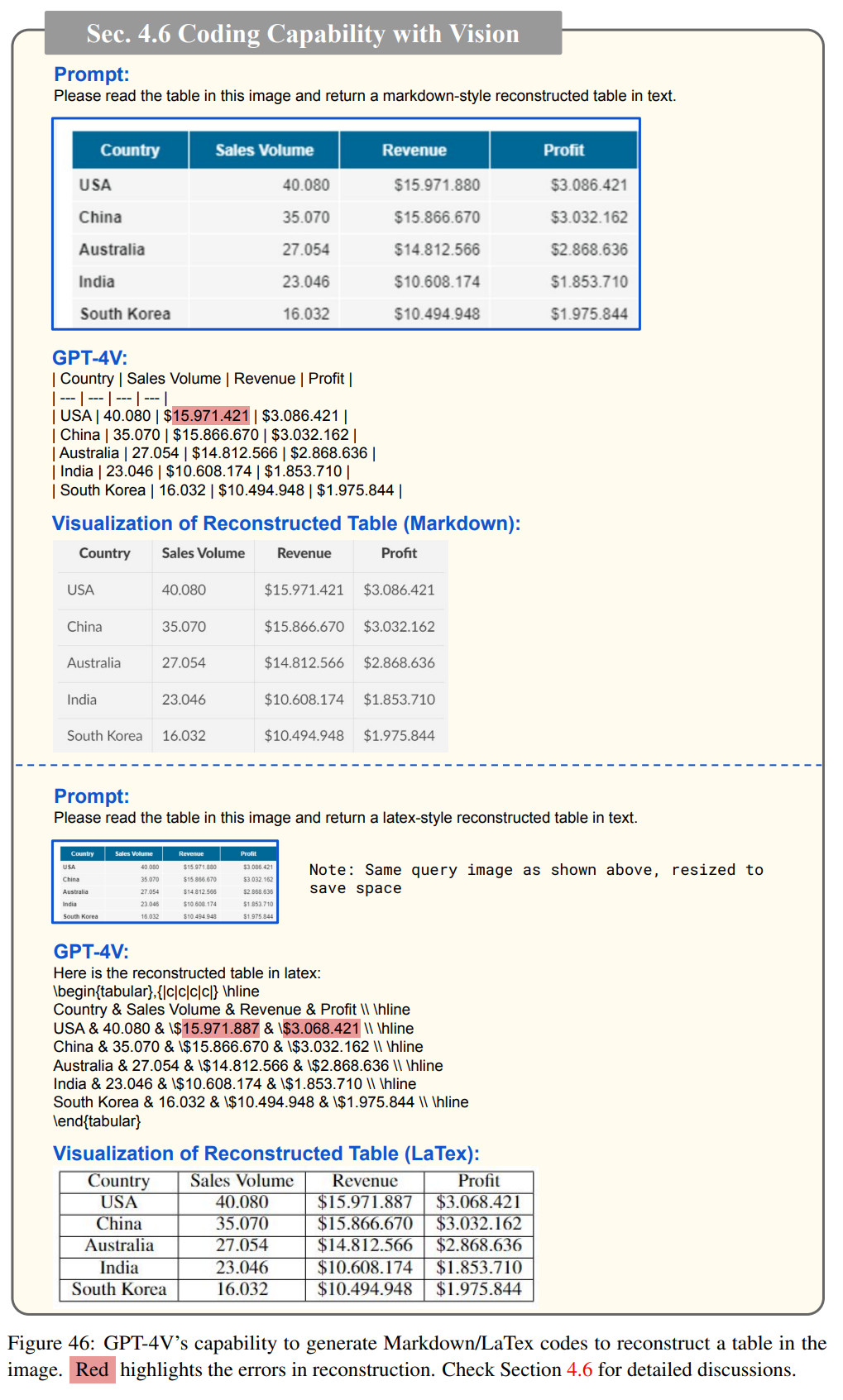

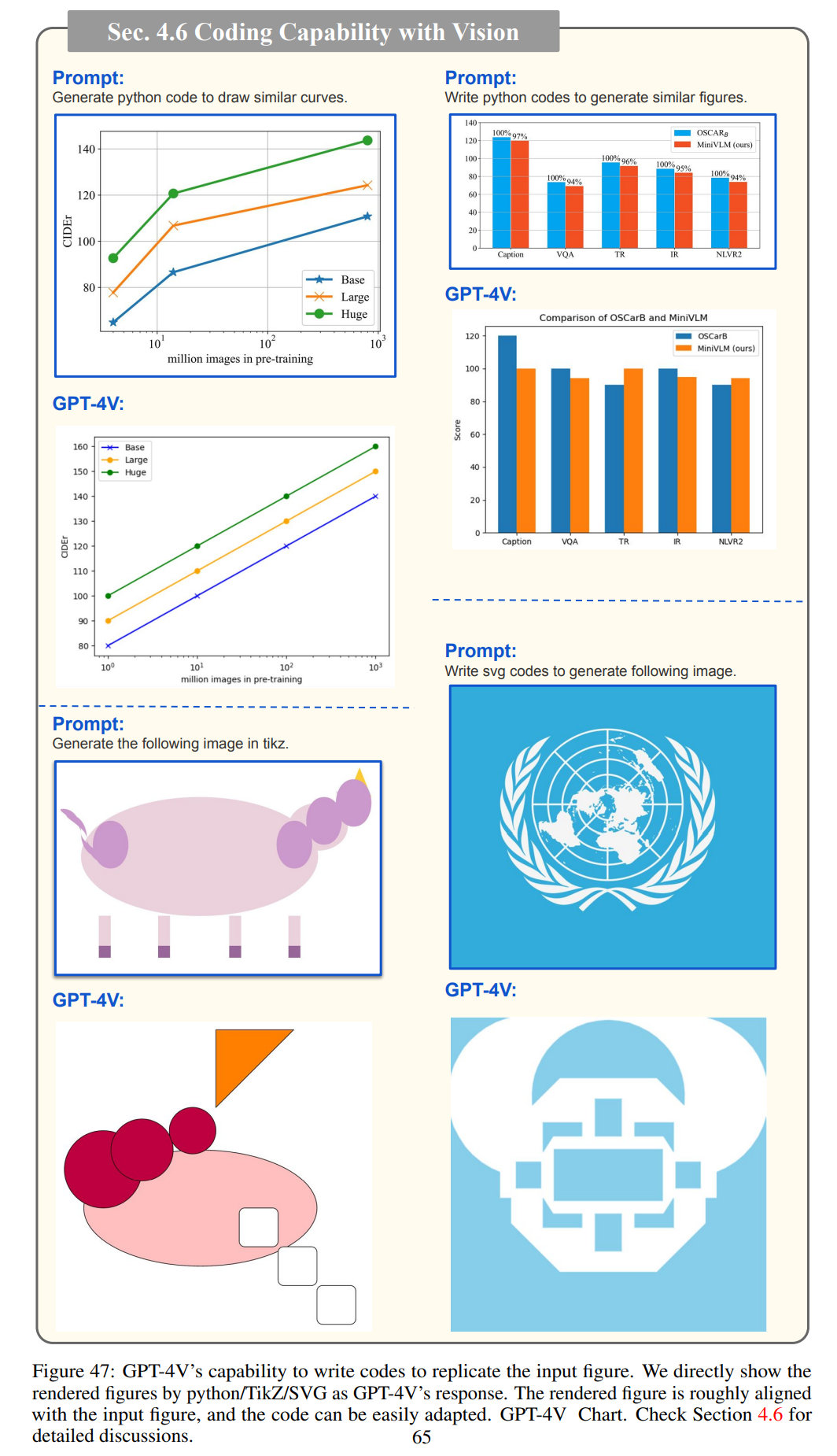

4.6节介绍了GPT-4V的编码能力。

基于手写数学方程生成LaTeX代码的能力:

GPT-4V生成Markdown/LaTex代码以重建图像中表的能力:

GPT-4V编写代码以复制输入图形的能力:

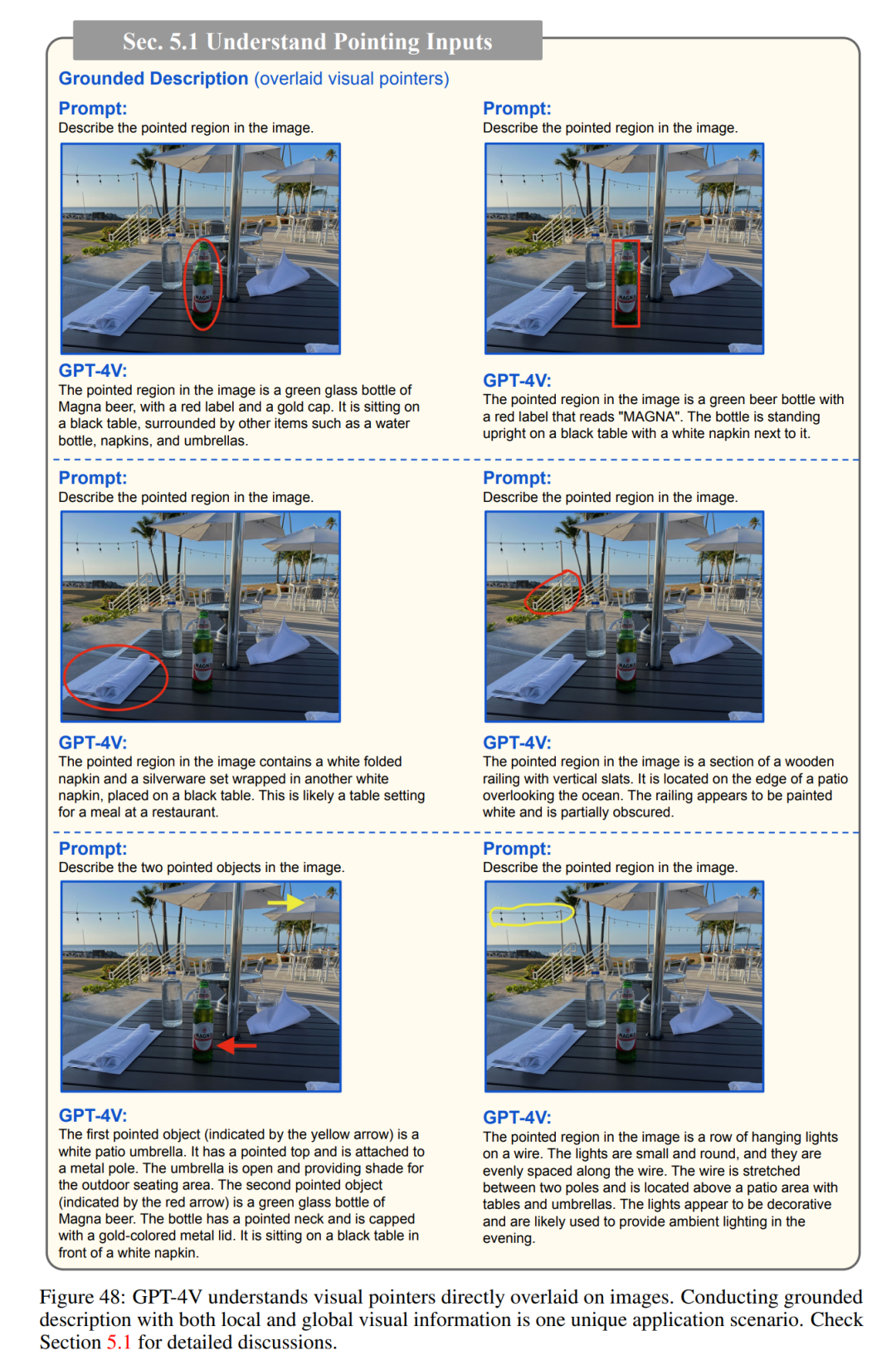

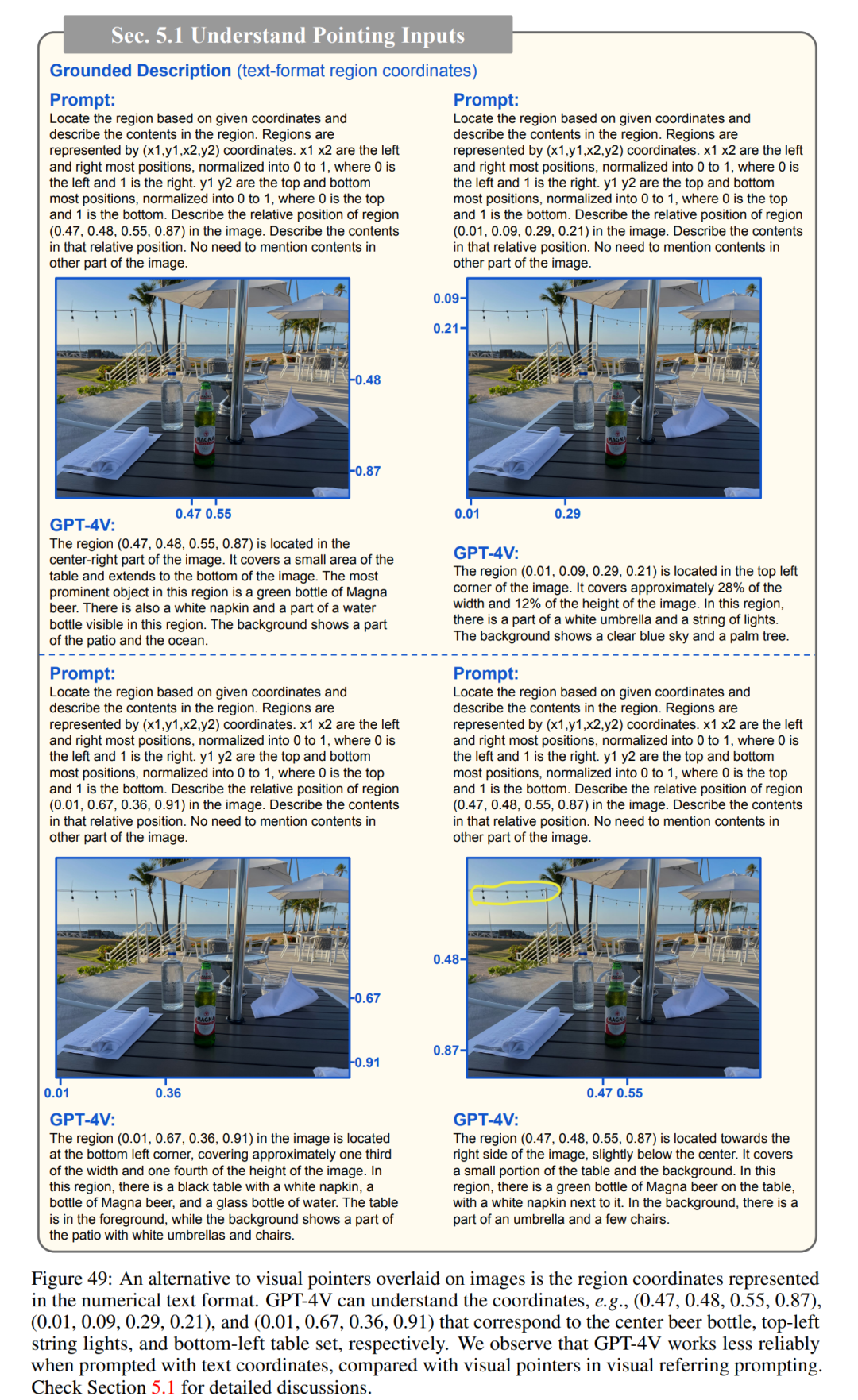

与人类的互动:视觉参考提示

在与多模态系统的人机交互中,指向特定空间位置是一项基本能力,例如进行基于视觉的对话。第 5.1 节显示,GPT-4V 可以很好地理解直接画在图像上的视觉指针。基于这一观察结果,研究者提出了一种名为「视觉参考提示(visual referring prompting)」的新型模型交互方法。如图 50 所示,其核心思想是直接编辑图像像素空间,绘制视觉指针或场景文本,作为人类的参照指示。作者在第 5.2 节详细介绍了这种方法的用途和优势。

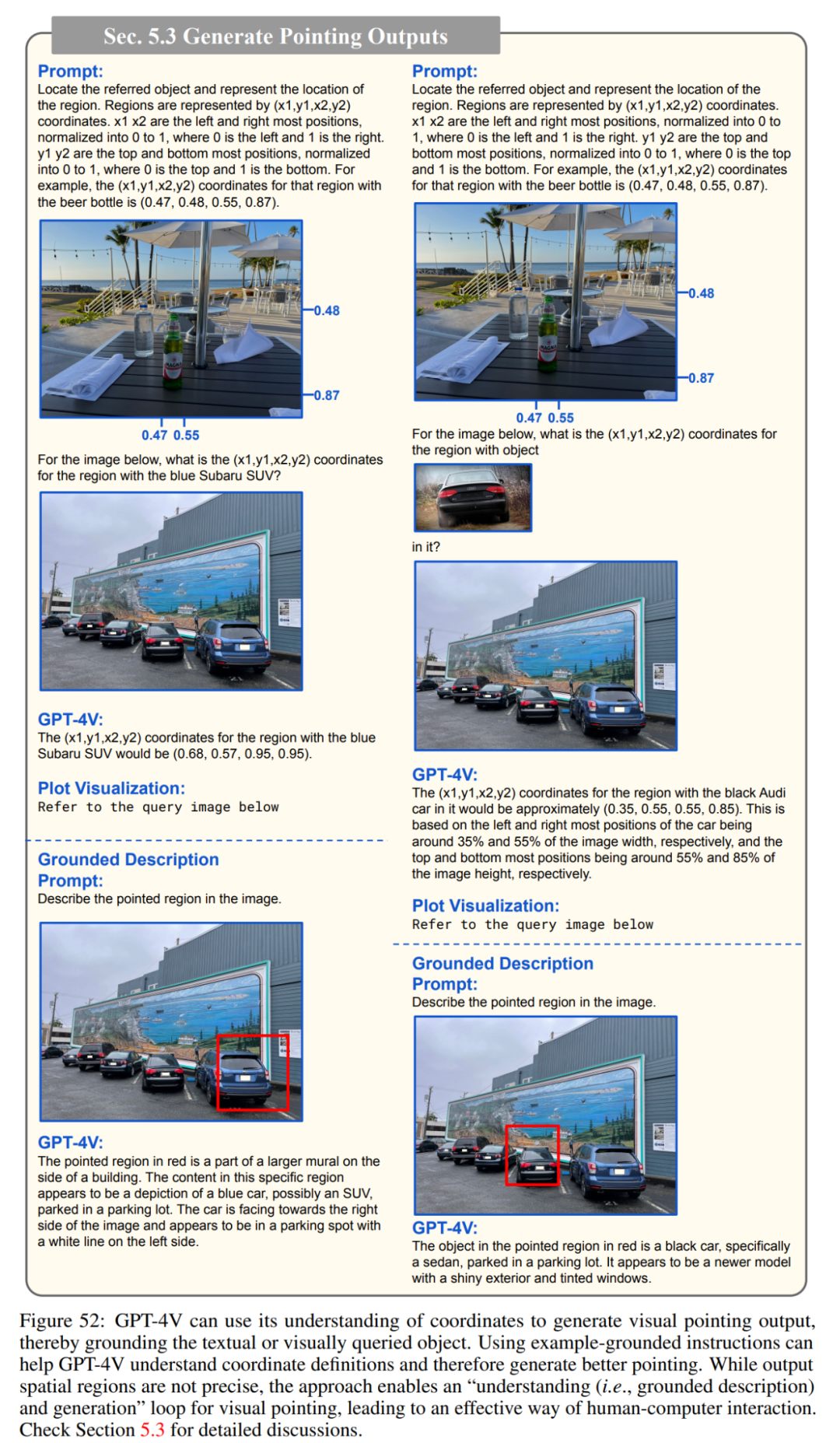

最后,他们在第 5.3 节探讨了如何让 GPT-4V 生成视觉指针输出,以便与人类互动。这些视觉指针对于人类和机器来说都能直观地生成和理解,是人机交互的良好渠道。

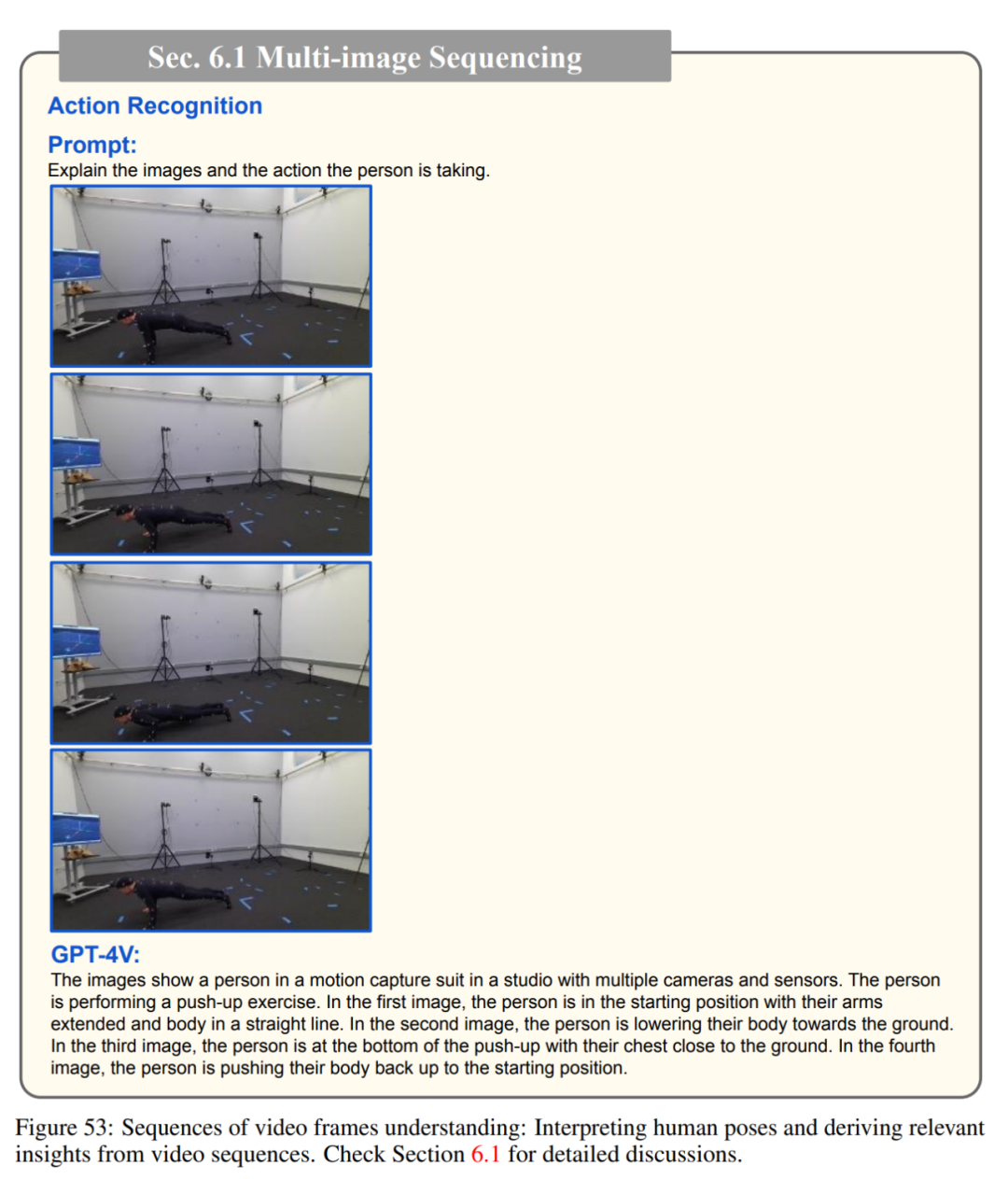

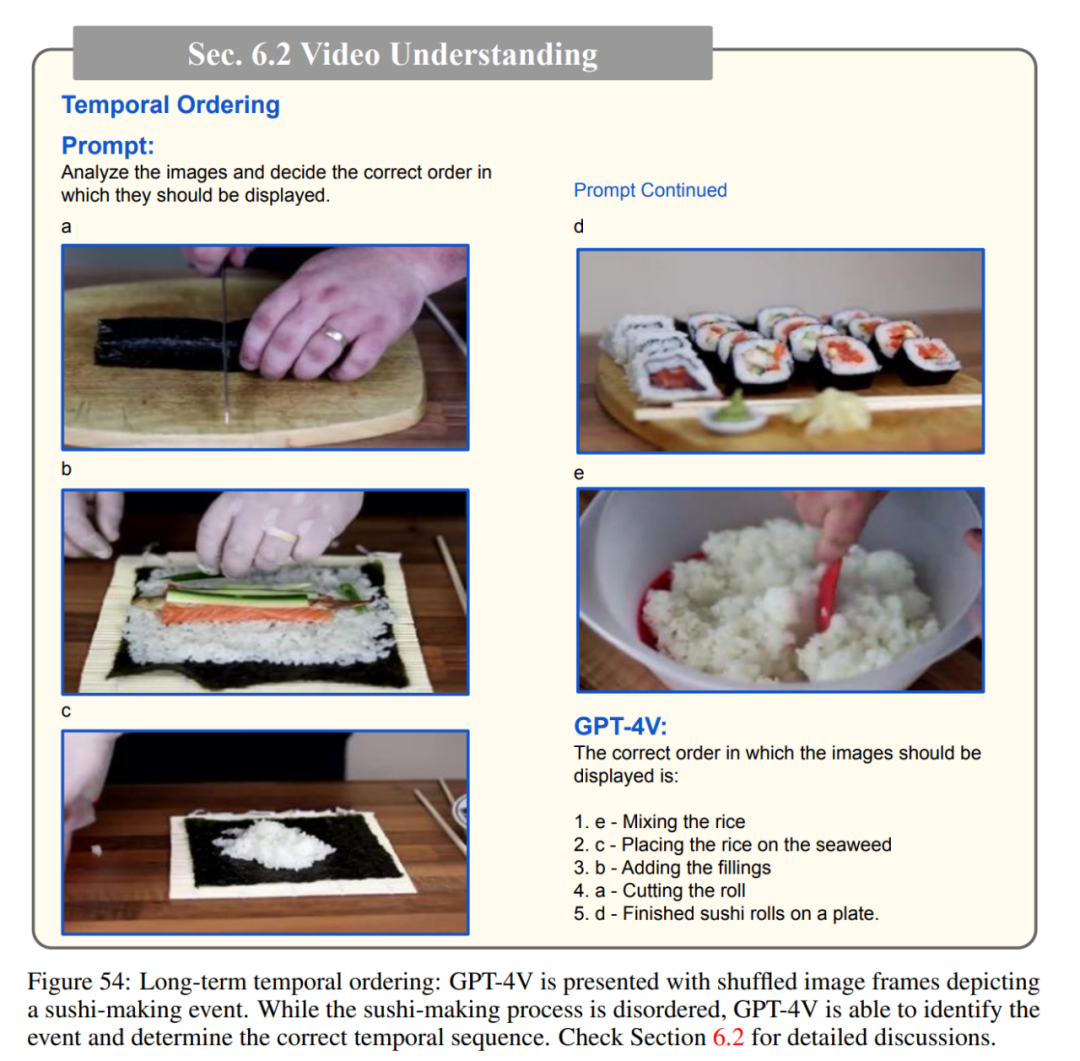

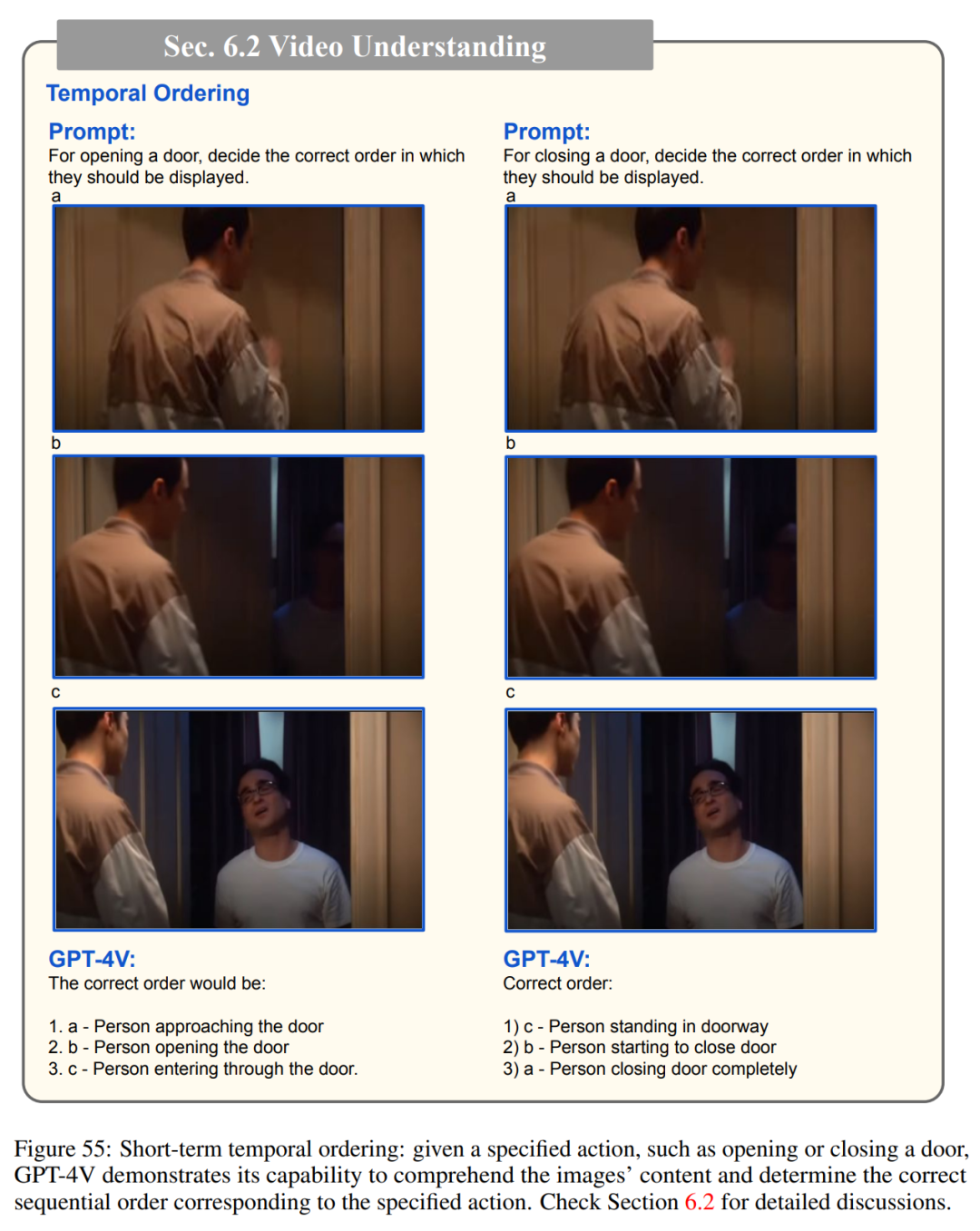

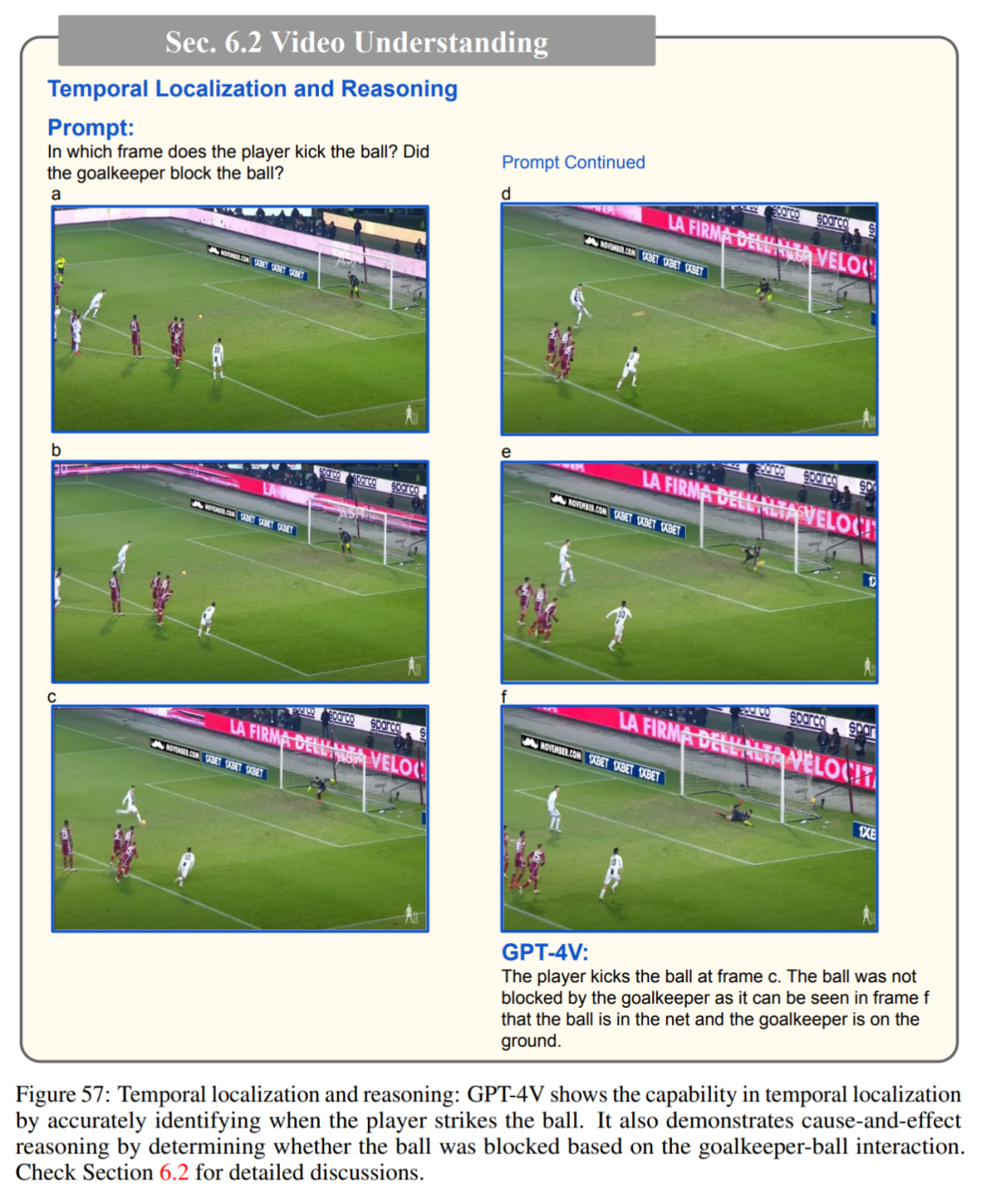

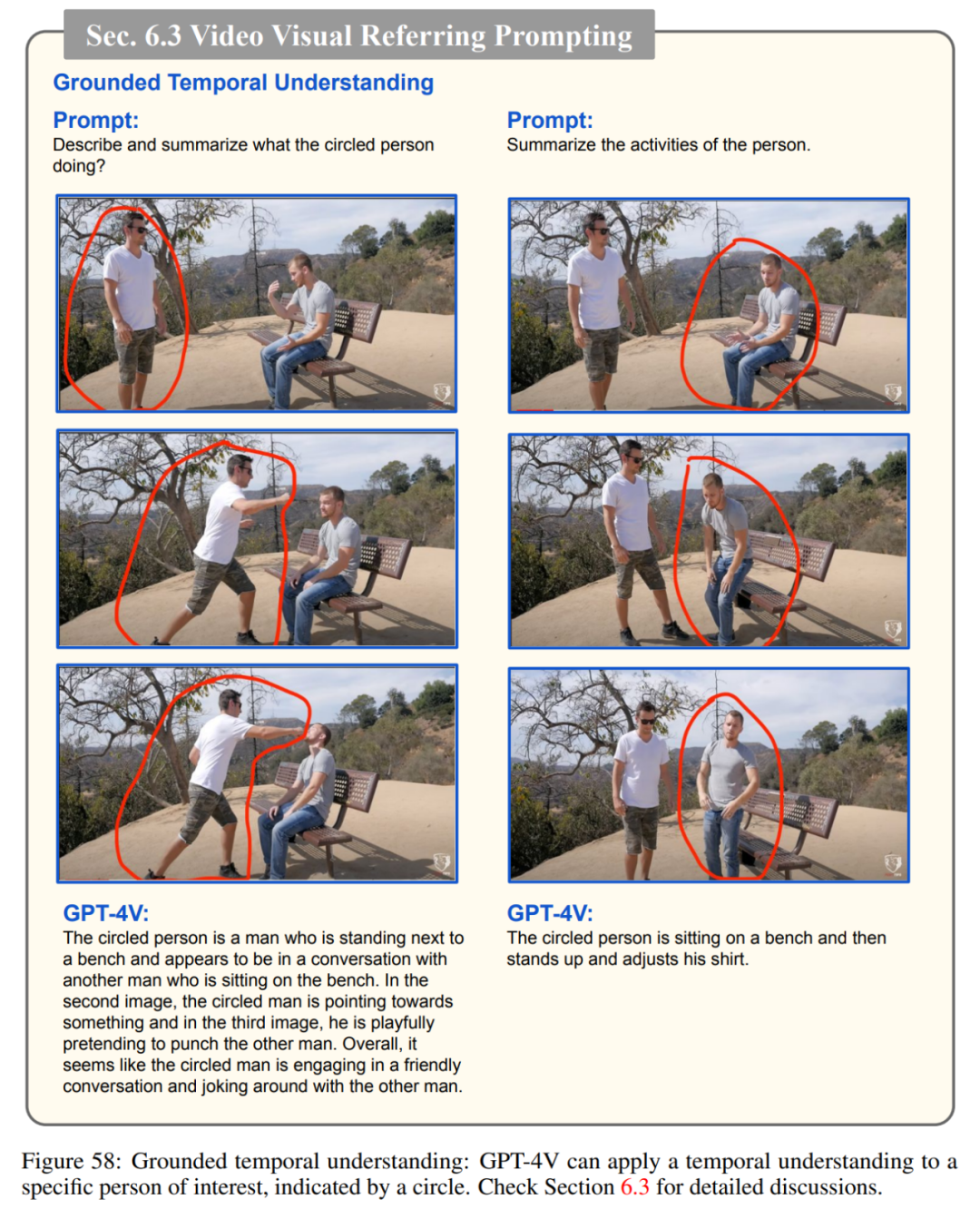

时间和视频理解

在第六章,作者讨论了GPT4V 的时间和视频理解能力。尽管 GPT4V 主要以图像作为输入,但评估其对时间序列和视频内容的理解能力仍然是对其整体评估的一个重要方面。这是因为现实世界中的事件会随着时间的推移而展开,而人工智能系统理解这些动态过程的能力在现实世界的应用中至关重要。时序预测、时序排序、时序定位、时序推理和基础时序理解等能力有助于衡量模型在一系列静态图像中理解事件顺序、预测未来事件发生和分析随时间变化的活动的能力。

尽管 GPT-4V 以图像为中心,但它能够以类似人类理解的方式理解视频和时间序列。为了提高像 GPT-4V 这样复杂的人工智能模型的通用性和适用性,这方面的测试对其发展和完善至关重要。

在这一章的实验中,研究者使用了多个选定的视频帧作为输入,以测试模型在理解时间序列和视频内容方面的能力。

多图像序列

视频理解

基于时间理解的视觉参考提示

视觉推理与智商测试

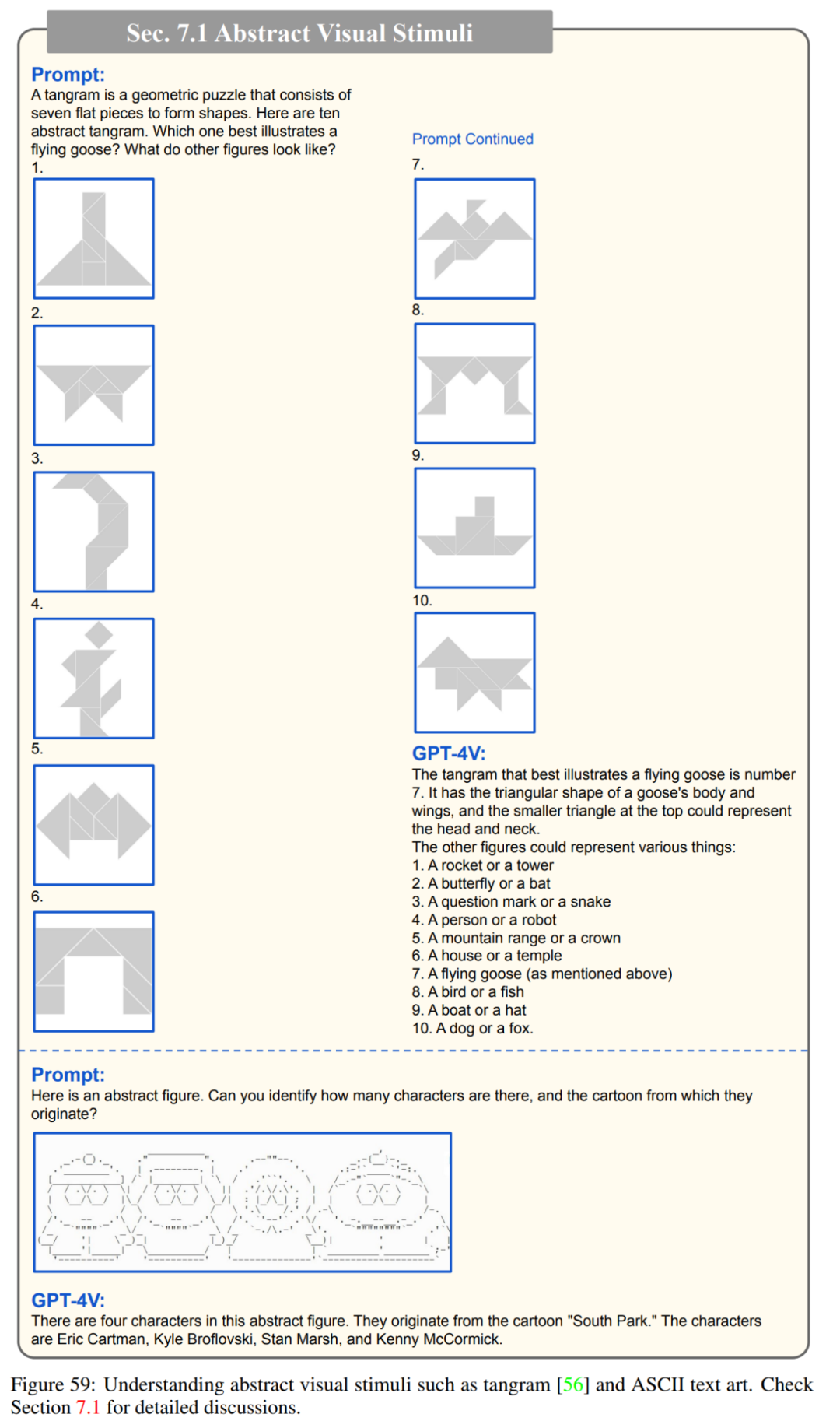

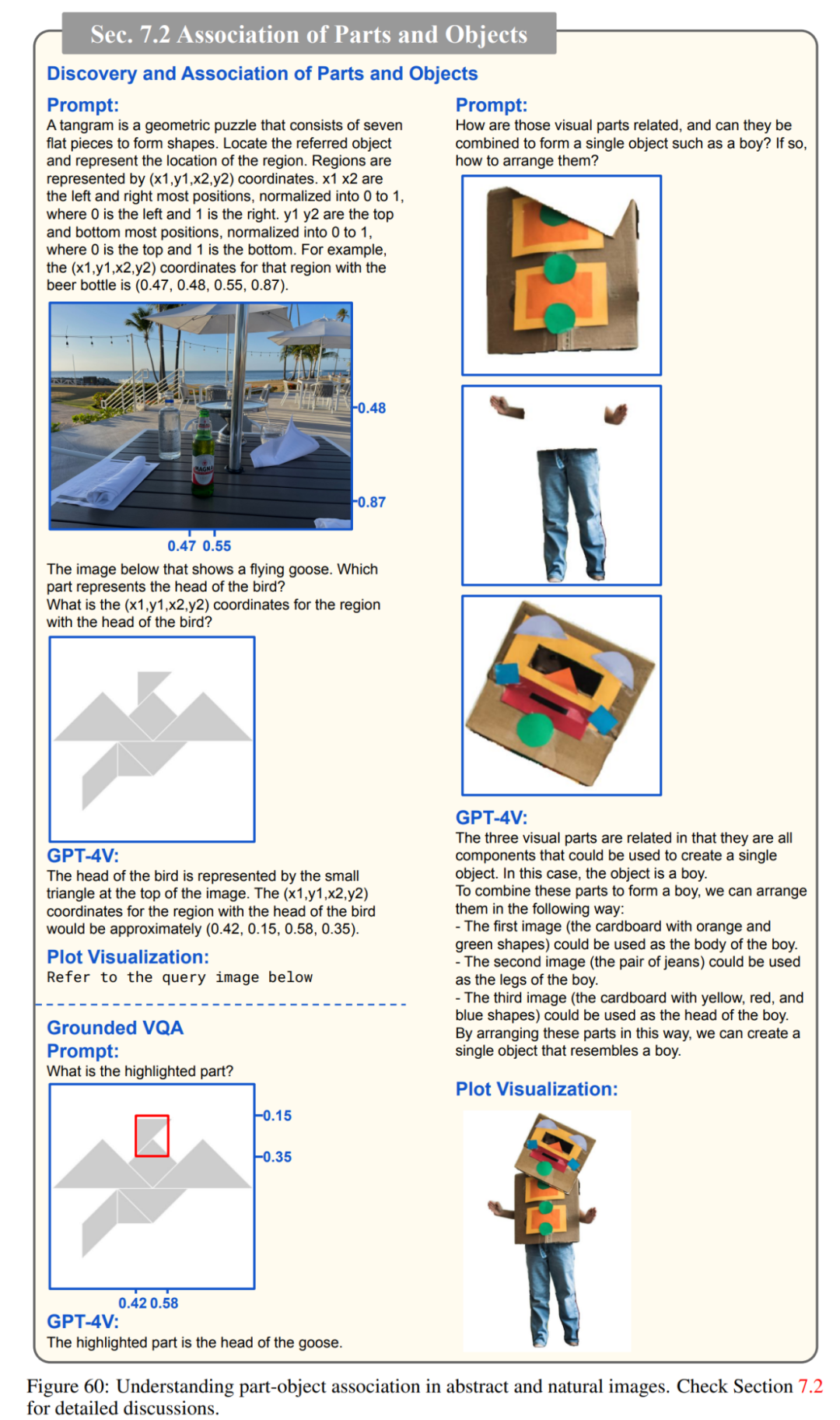

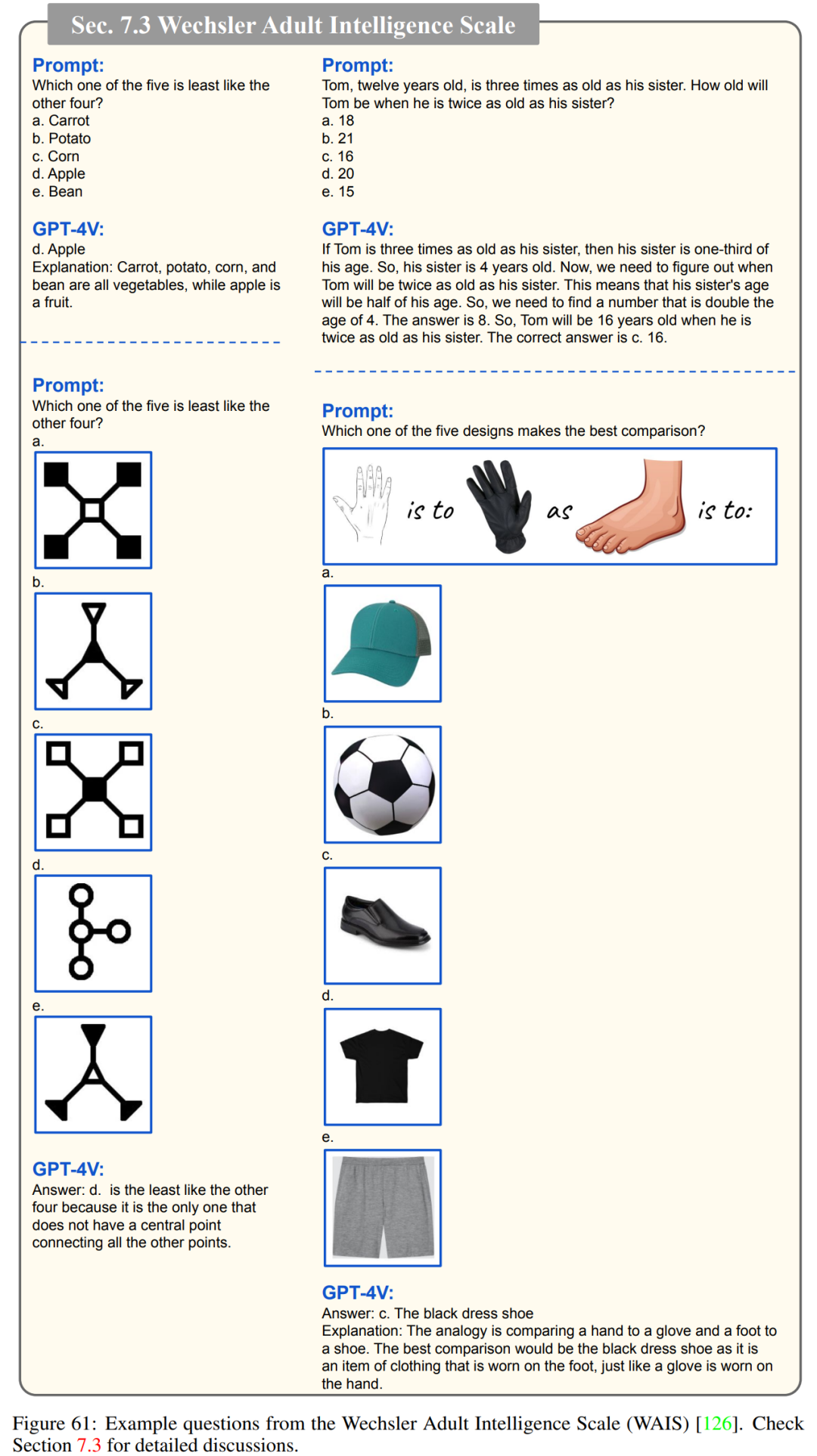

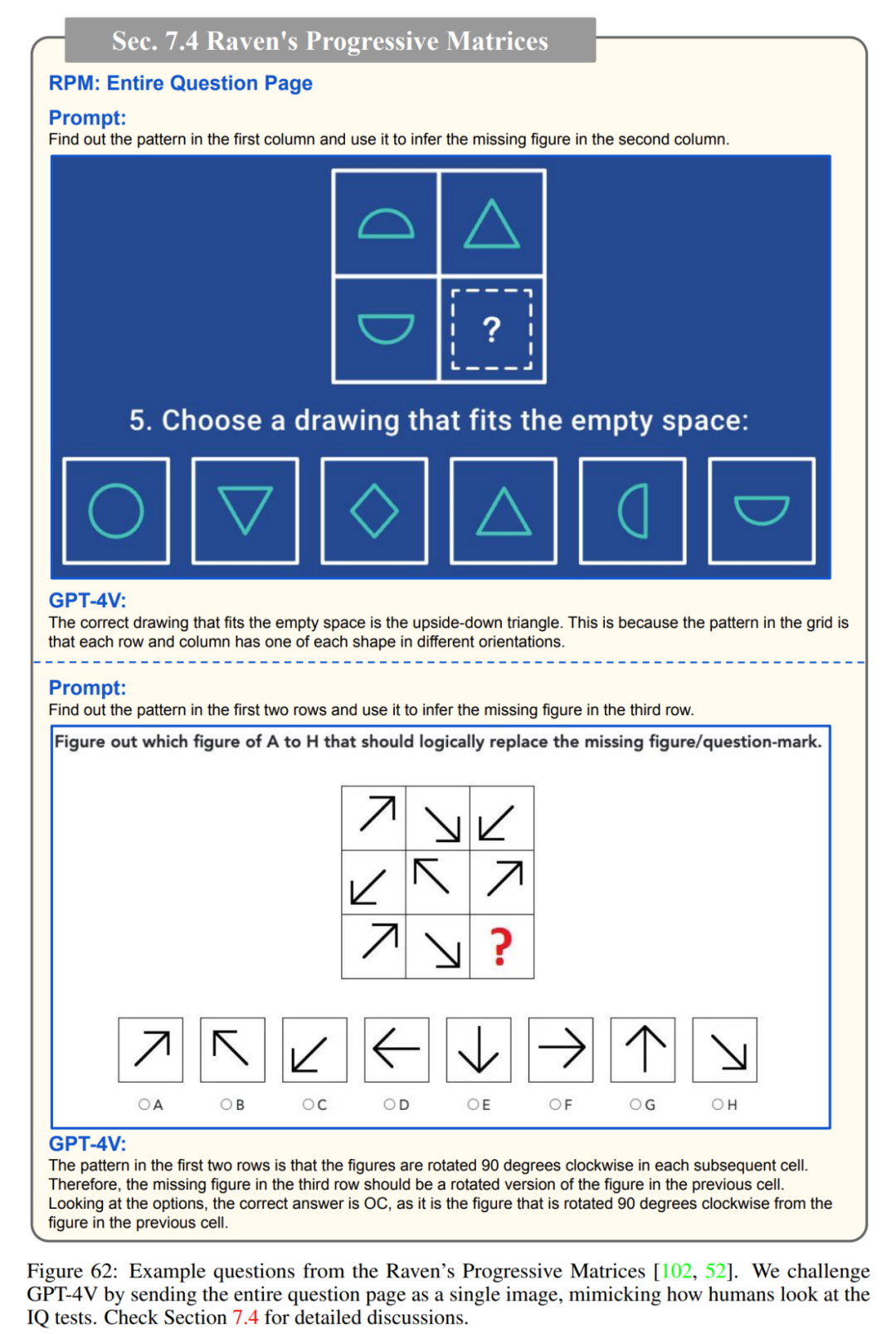

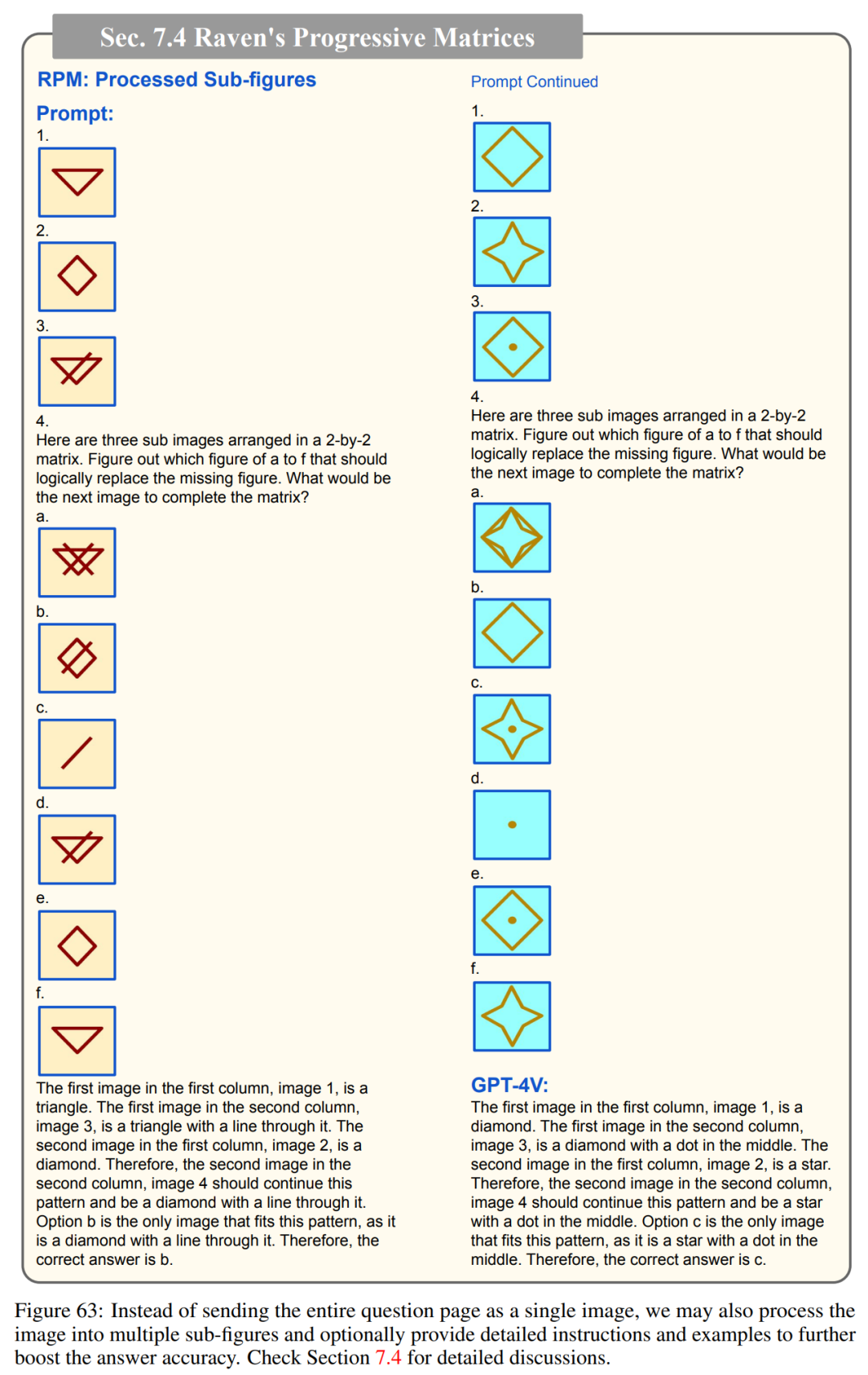

对抽象视觉刺激和符号的理解和推理是人类智能的一项基本能力。论文第七章测试了GPT-4V是否可以从视觉信号中抽象语义,并可以执行不同类型的人类智商(IQ)测试。

抽象视觉刺激

部件和物体的发现与关联

韦氏成人智力量表

瑞文推理测验

情商测验

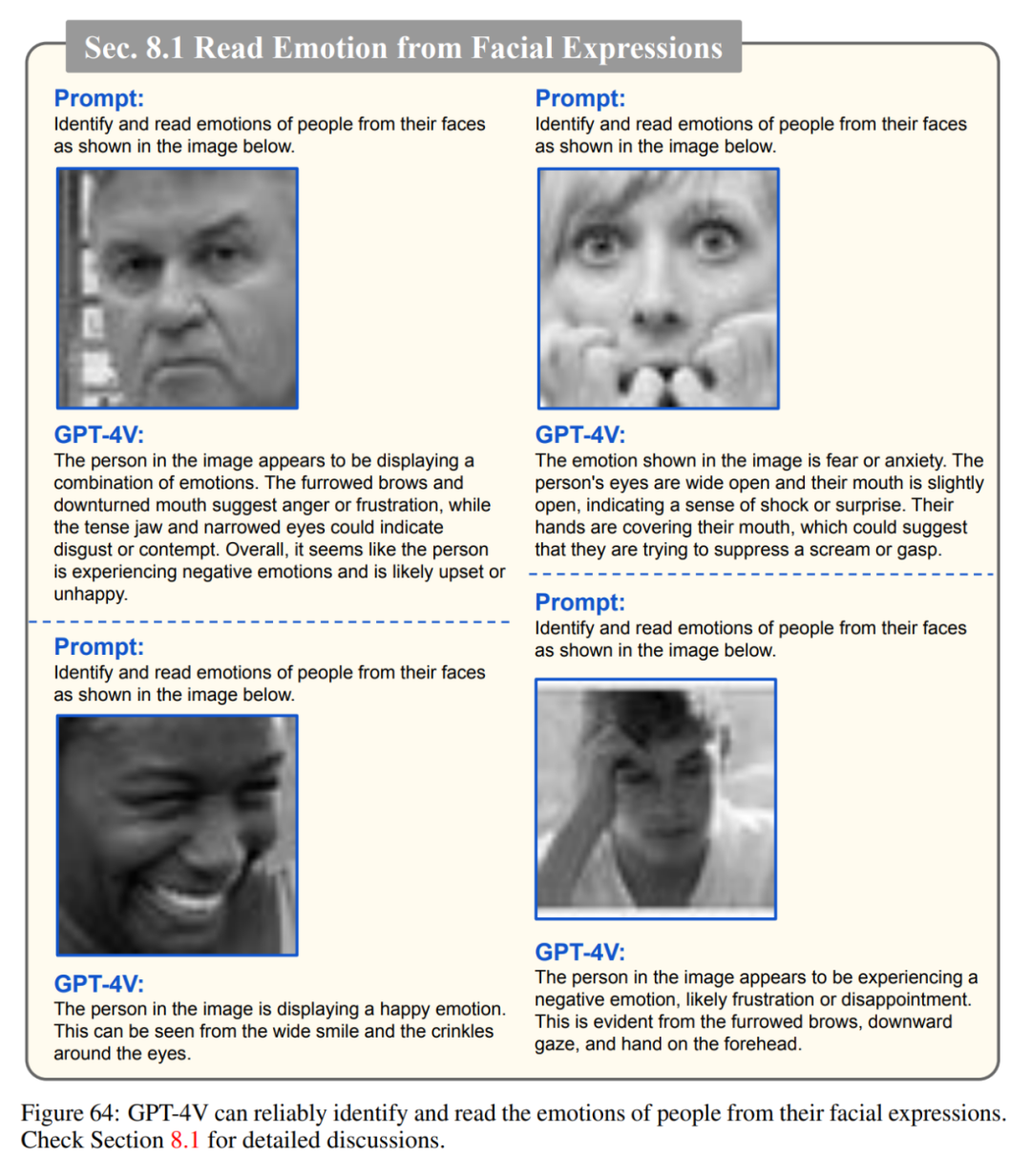

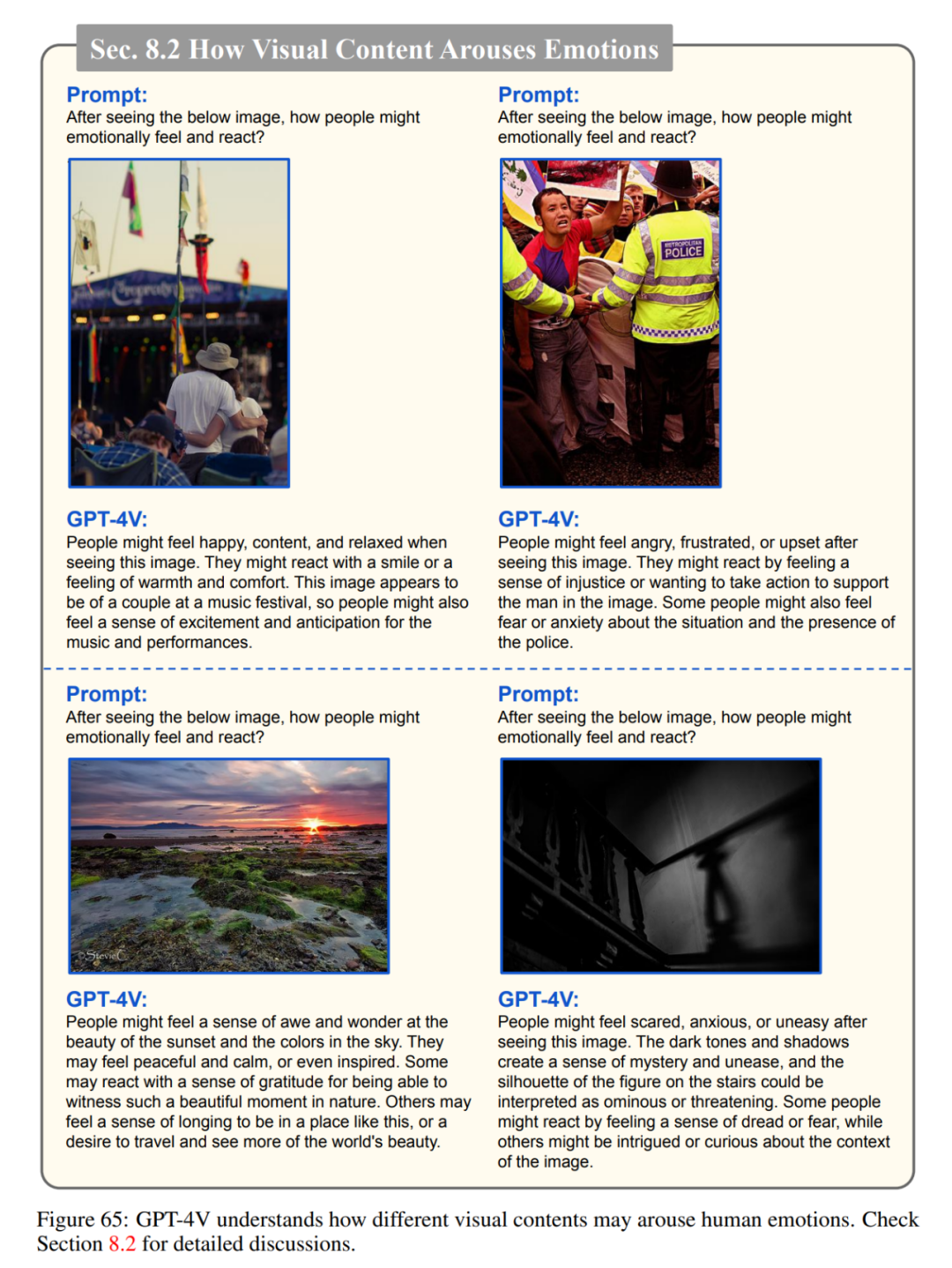

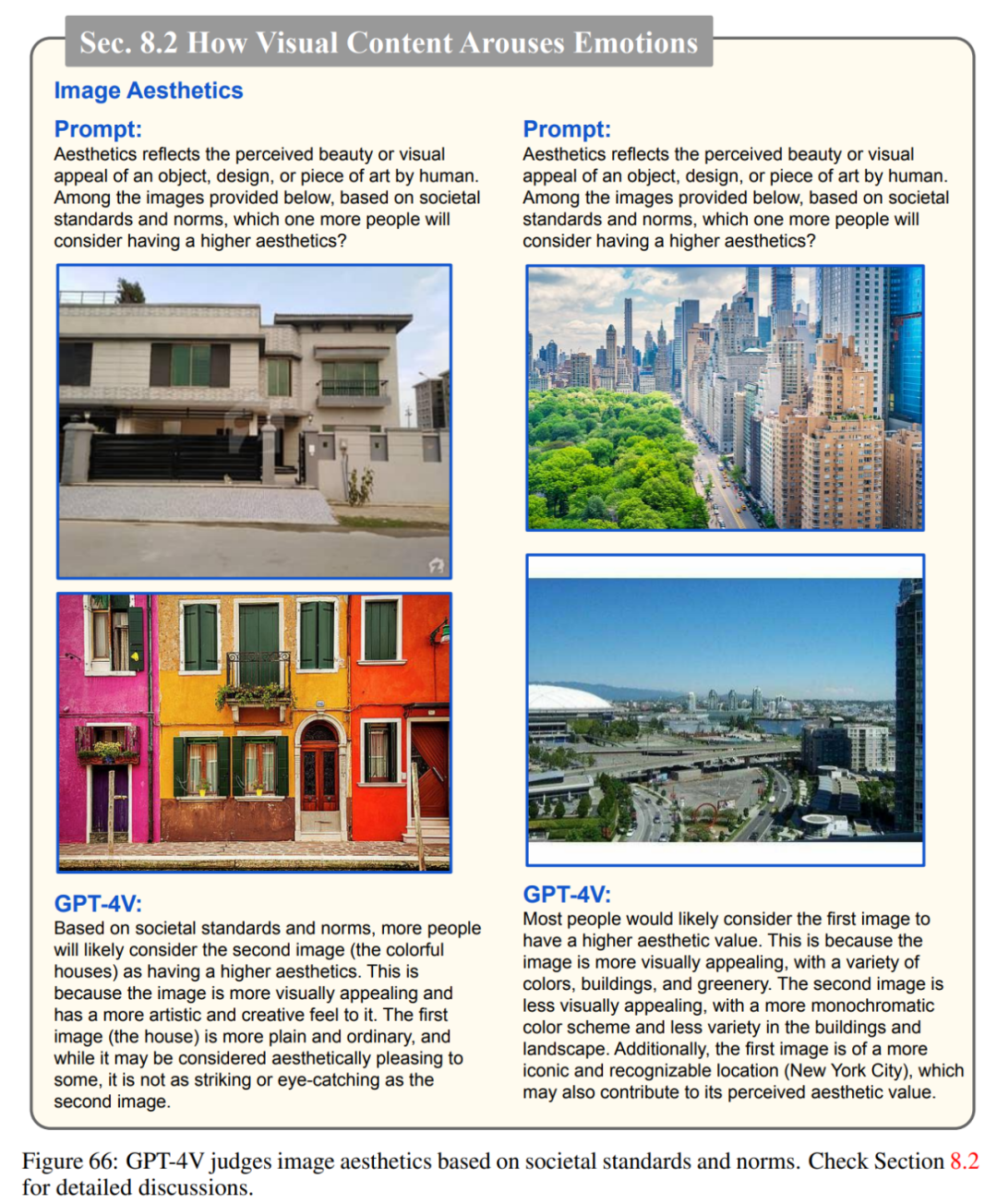

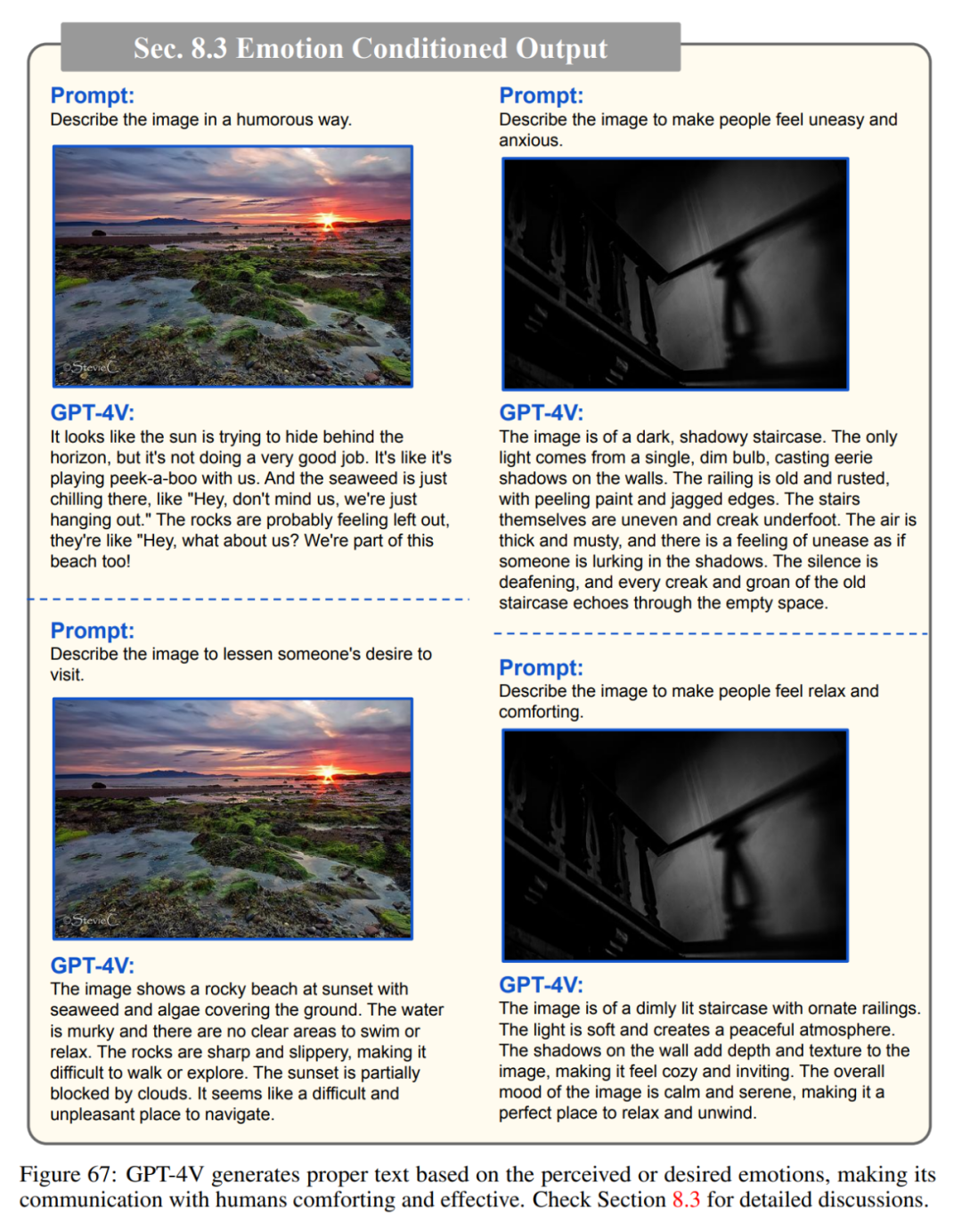

在与人类互动时,GPT-4V 必须具备同理心和情商(EQ),以理解和分享人类的情感。受人类情商测试定义的启发,作者研究了 GPT-4V 在以下方面的能力:从人的面部表情中识别和解读人的情绪;理解不同的视觉内容如何激发情绪;根据所需的情绪和情感生成适当的文本输出。

从面部表情中读出情感

理解视觉内容如何激发情感

情绪条件输出

新兴应用亮点

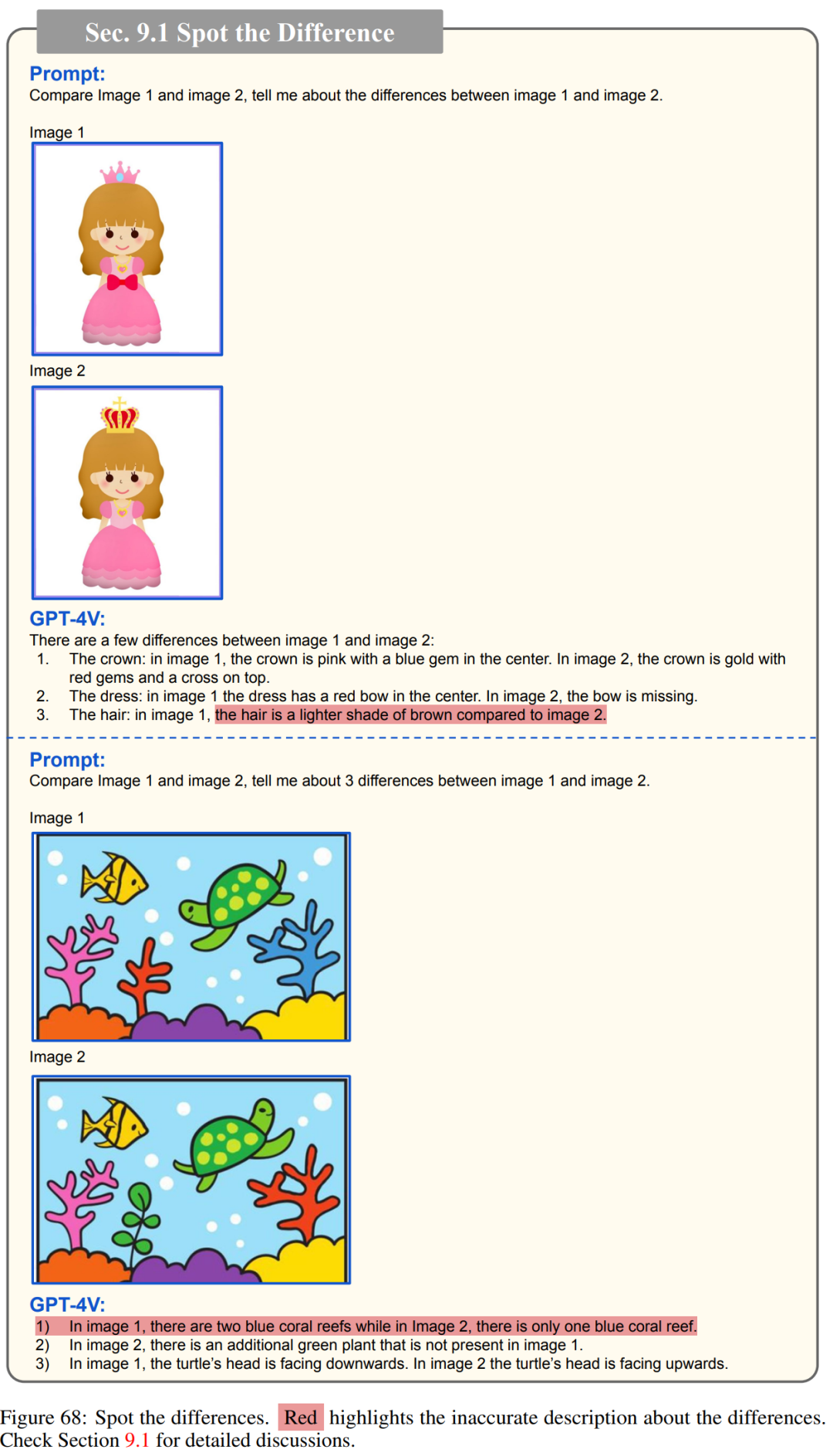

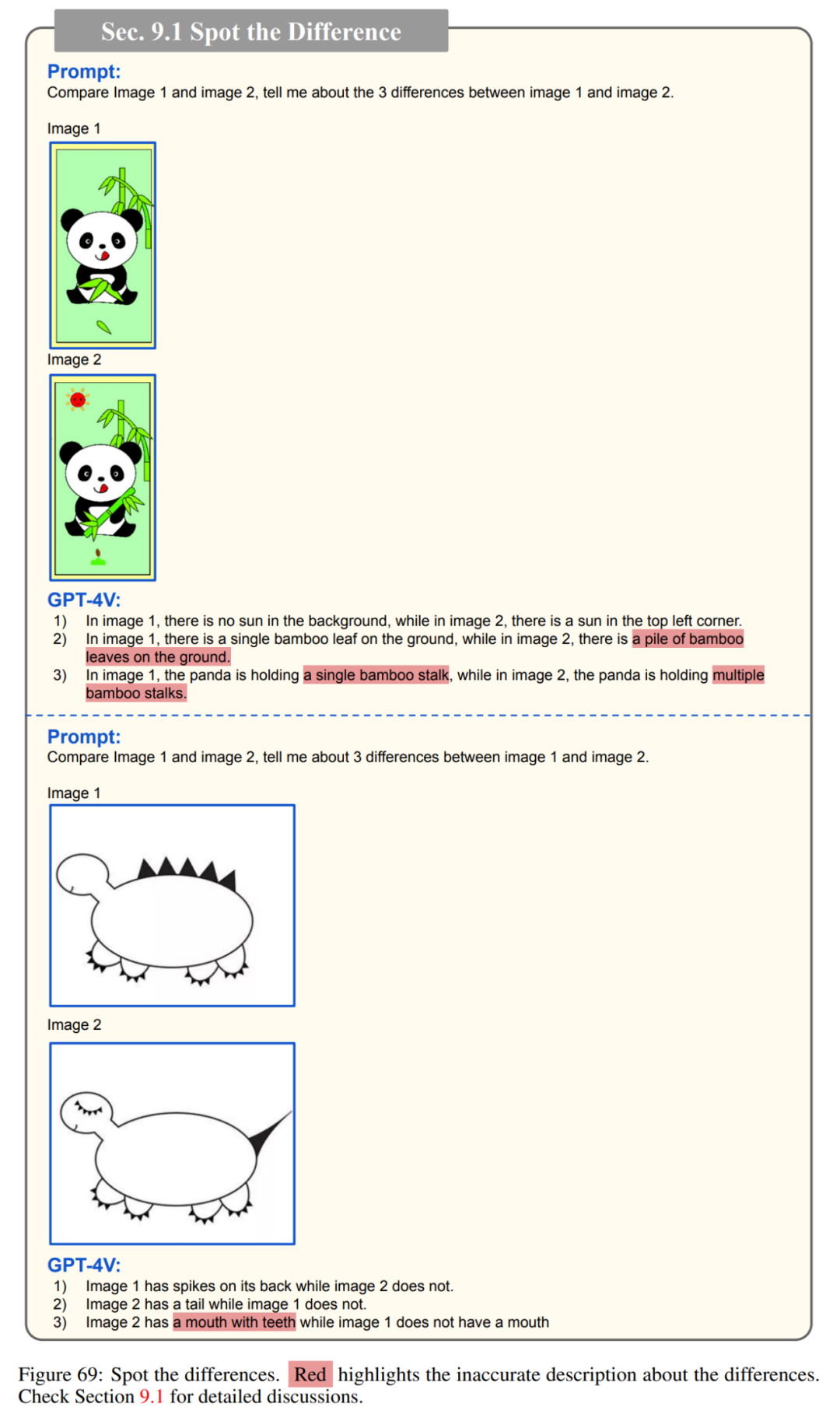

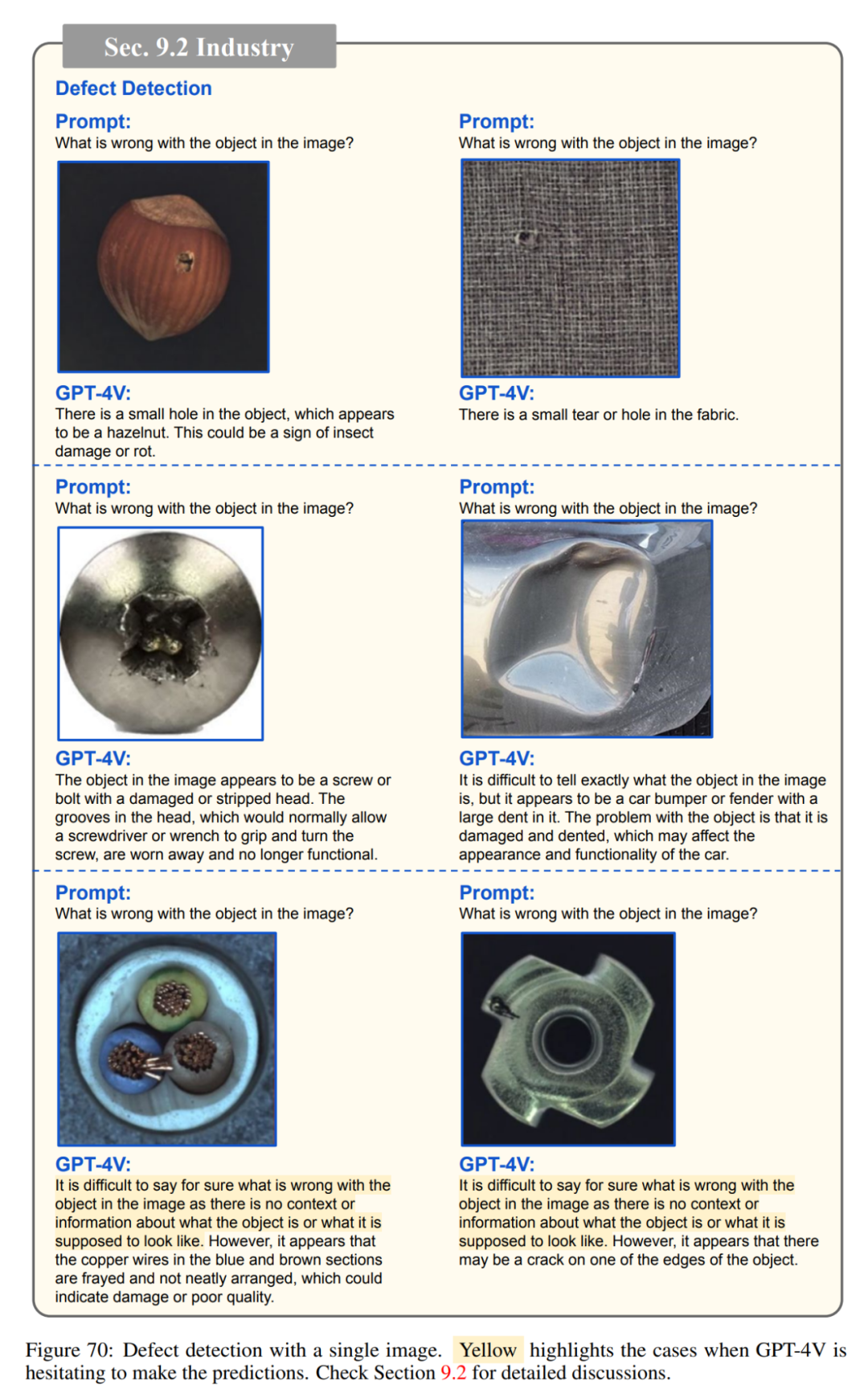

这一章展示了 GPT-4V 的卓越功能可能带来的无数高价值应用场景和新用例。诚然,其中一些应用场景可以通过精心策划用于微调现有视觉和语言(VL)模型的训练数据来实现,但作者想强调的是,GPT-4V 的真正威力在于它能够毫不费力地实现开箱即用。此外,他们还介绍了 GPT-4V 如何与外部工具和插件无缝集成,从而进一步拓展其潜力,实现更多创新和协作应用。

** **

找不同

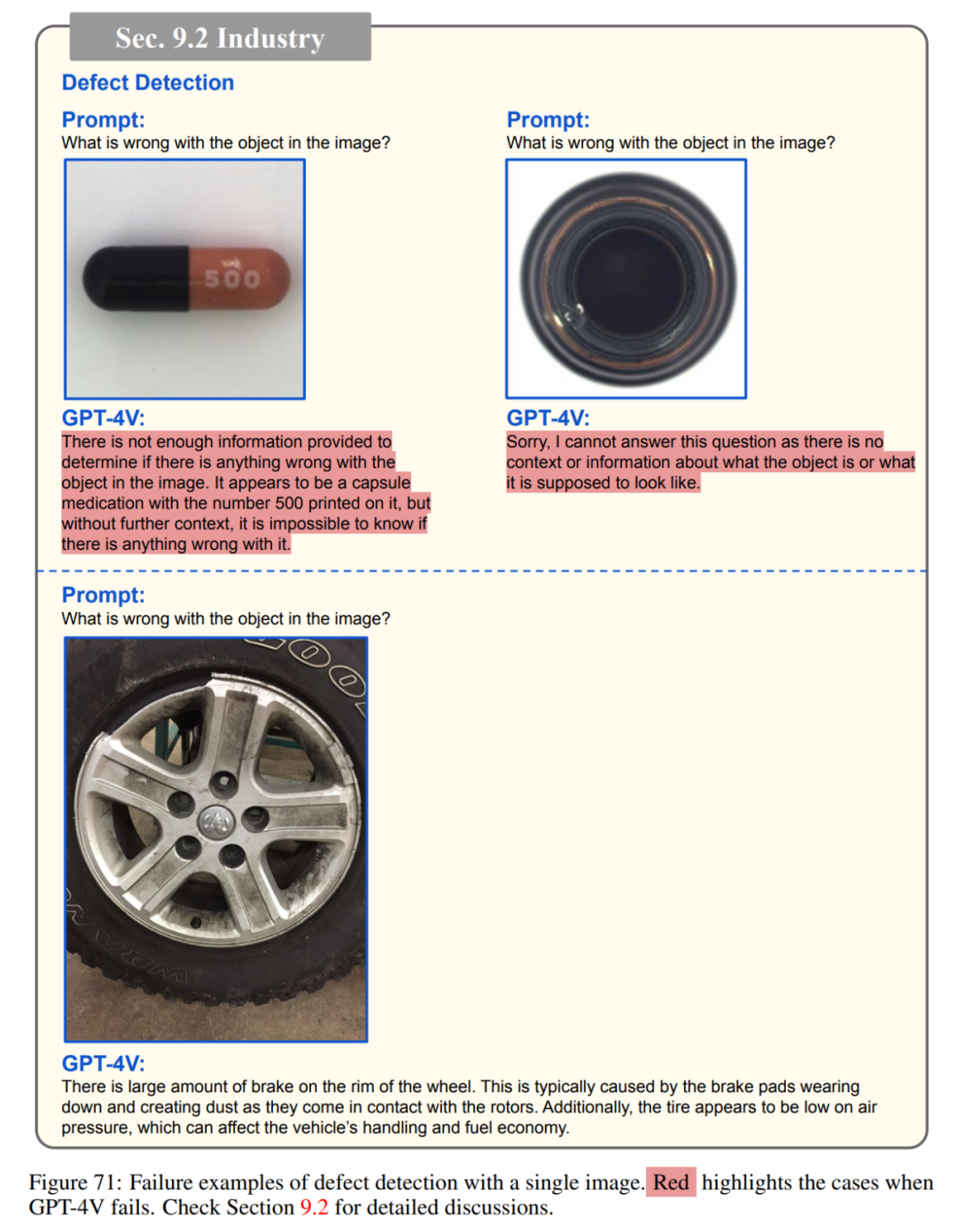

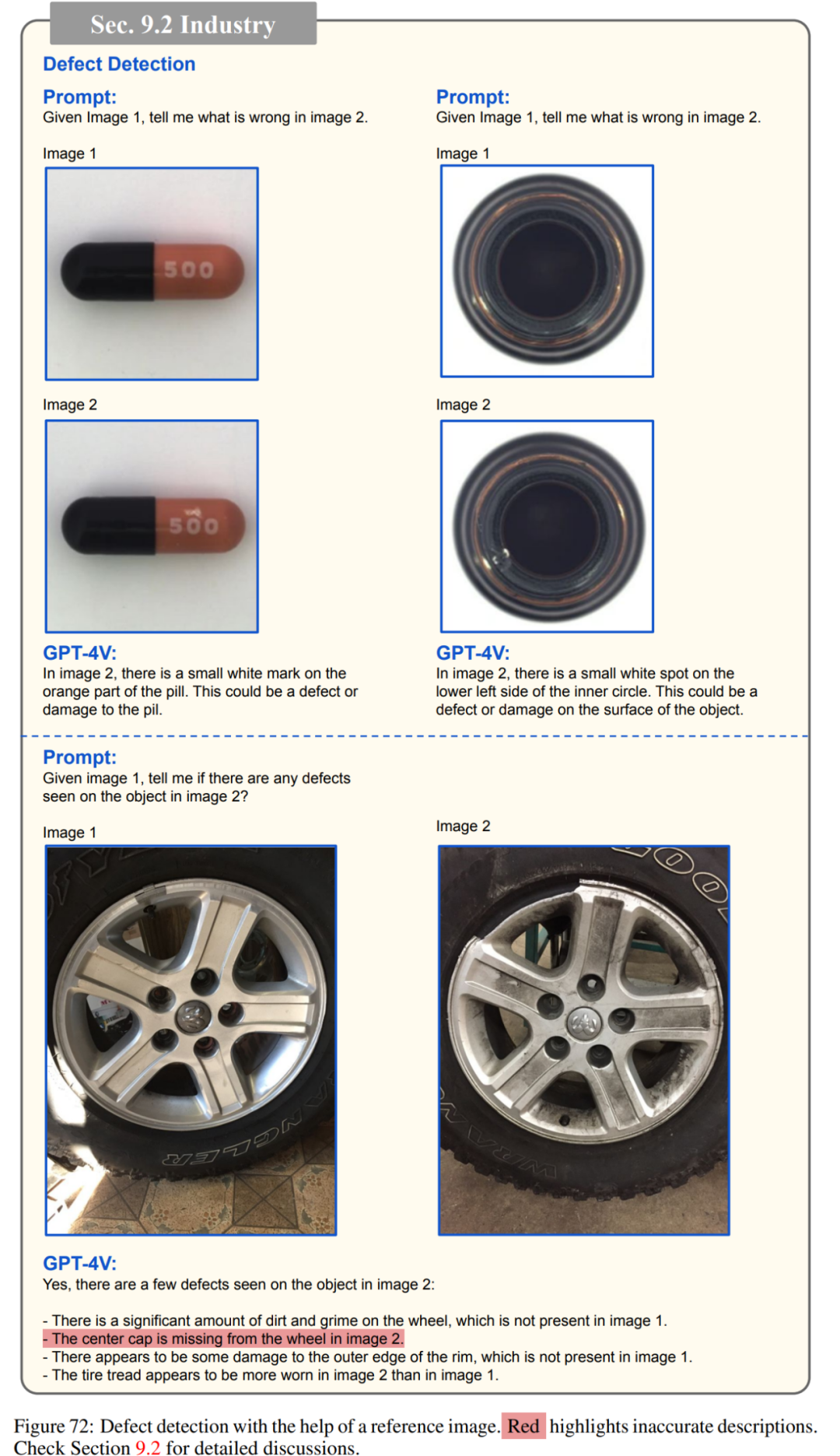

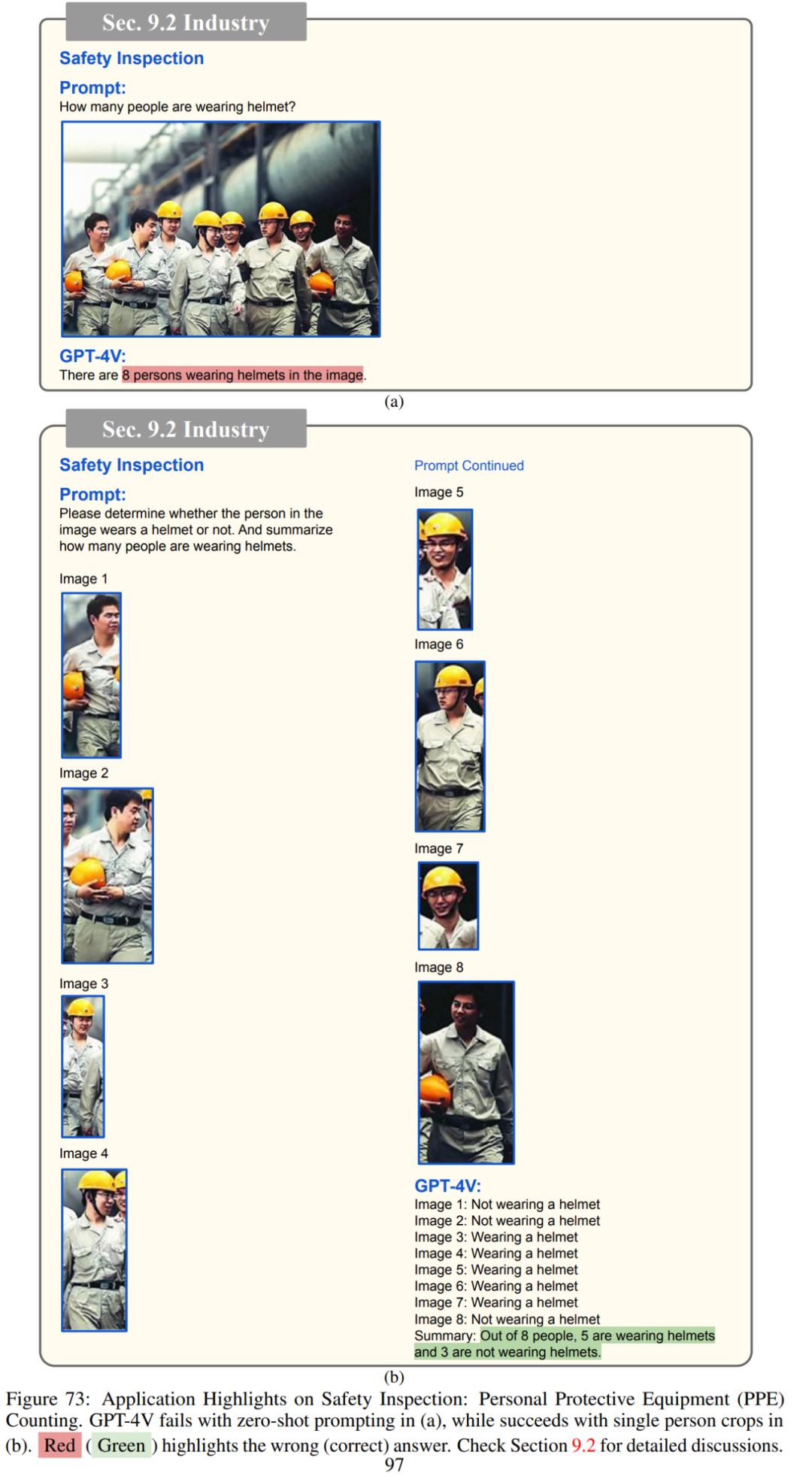

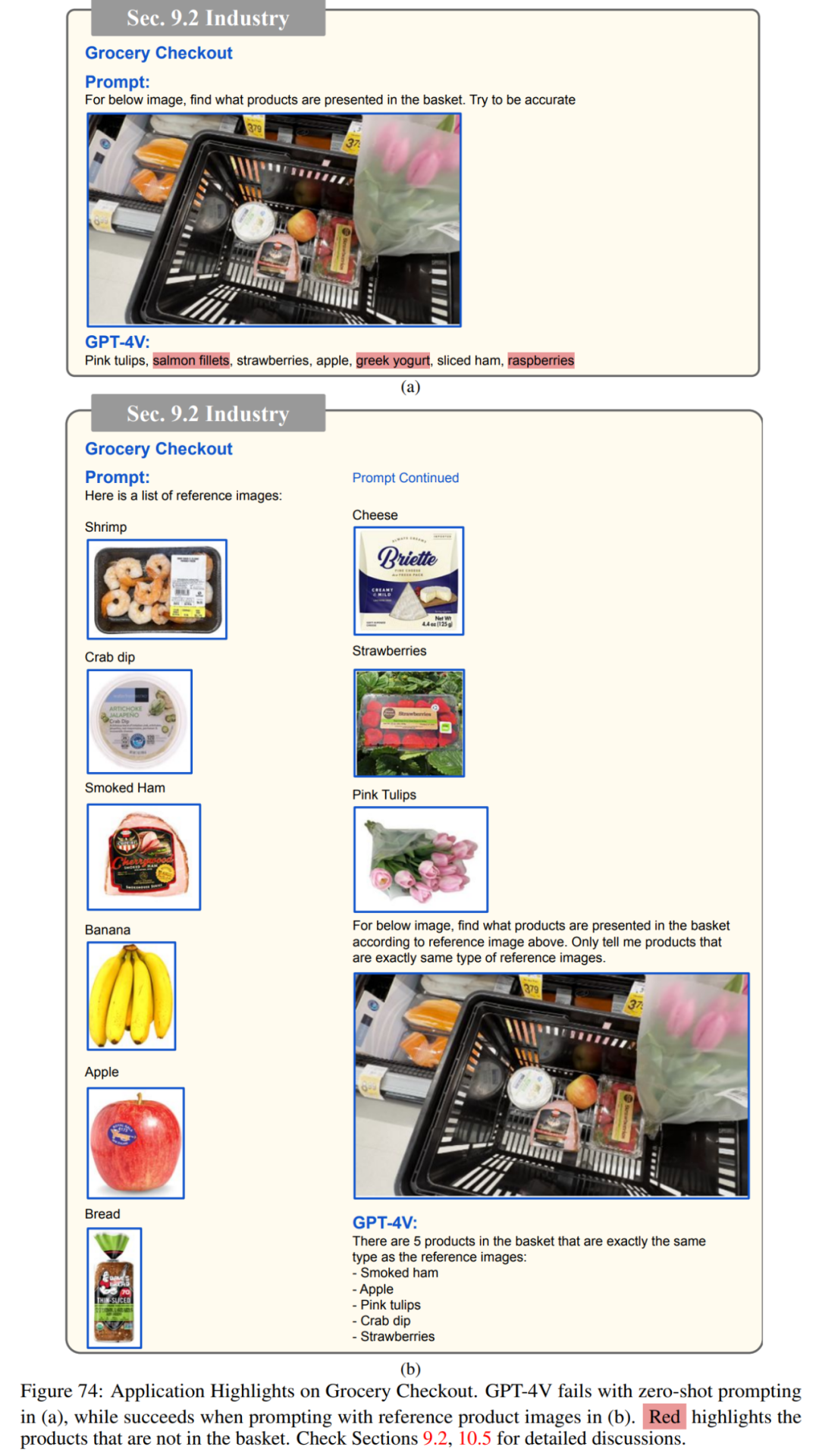

工业

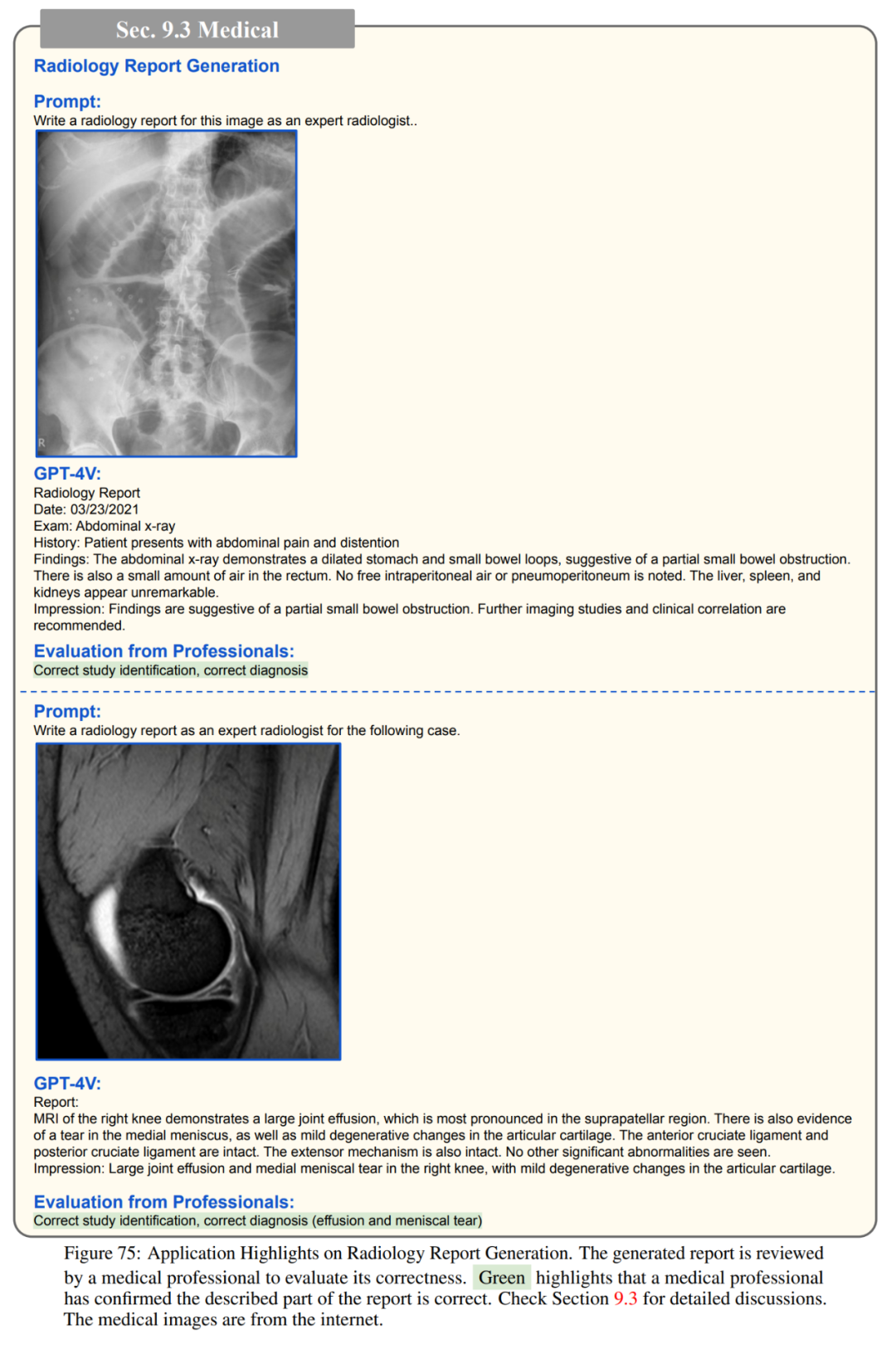

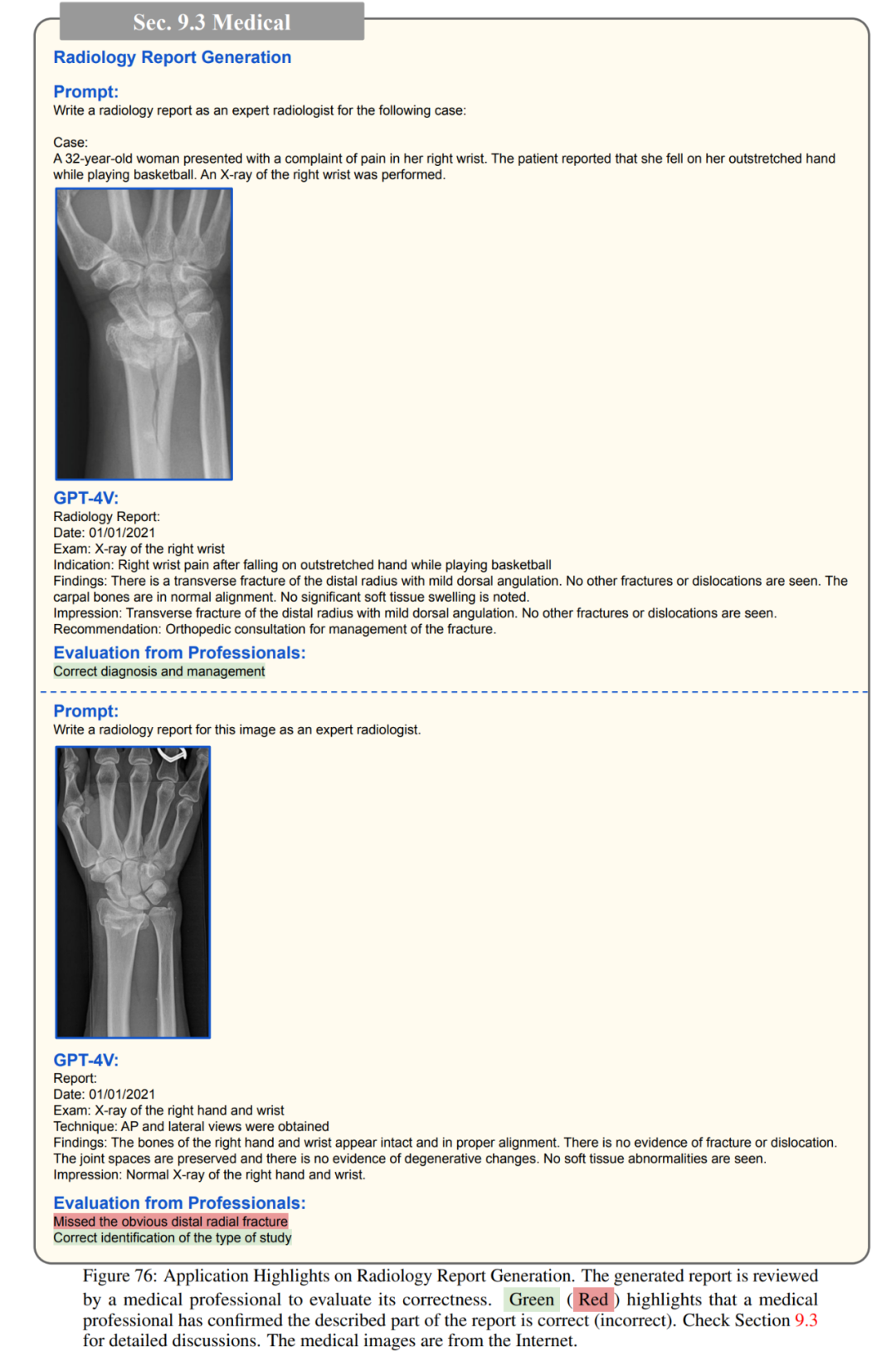

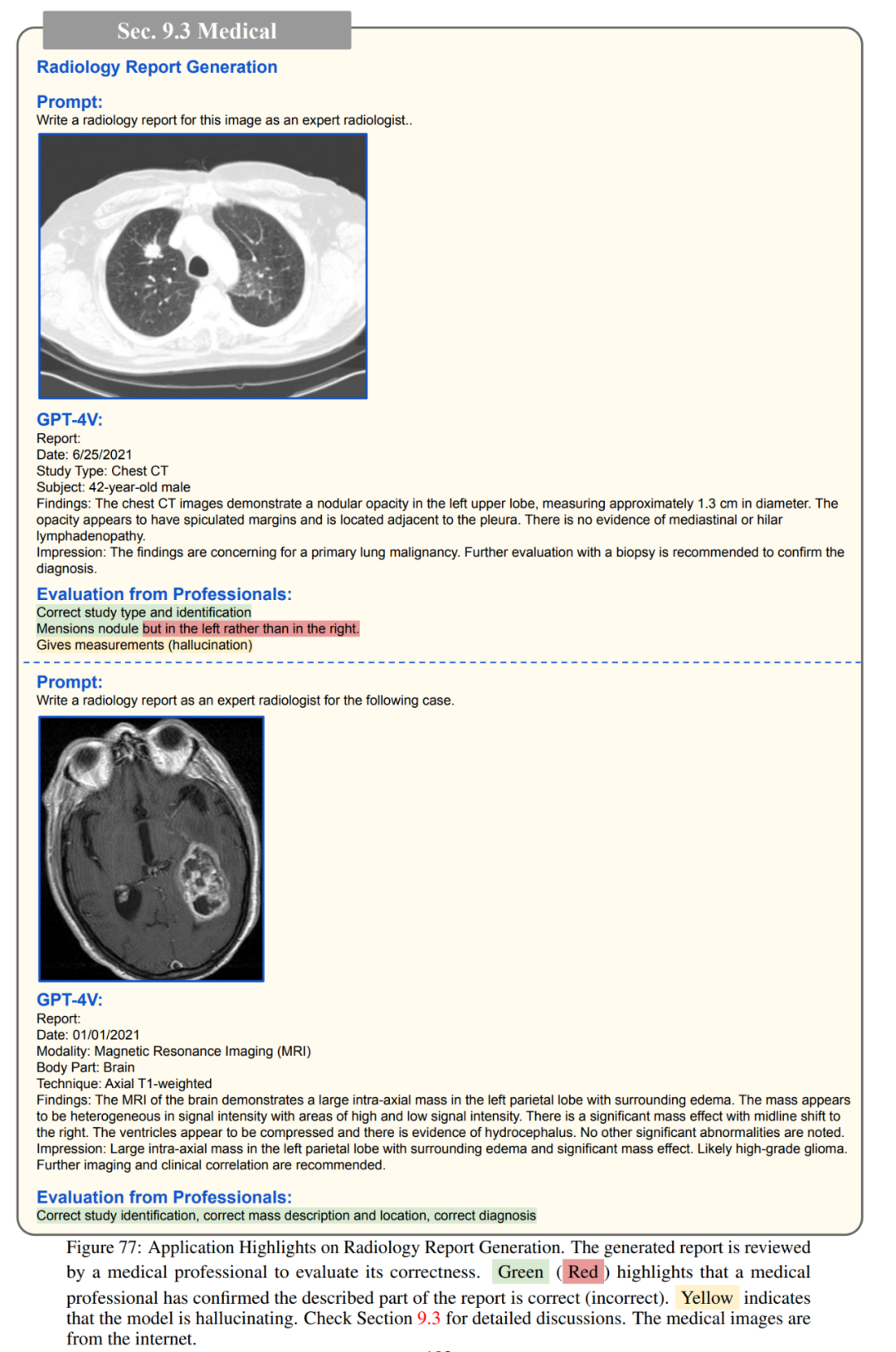

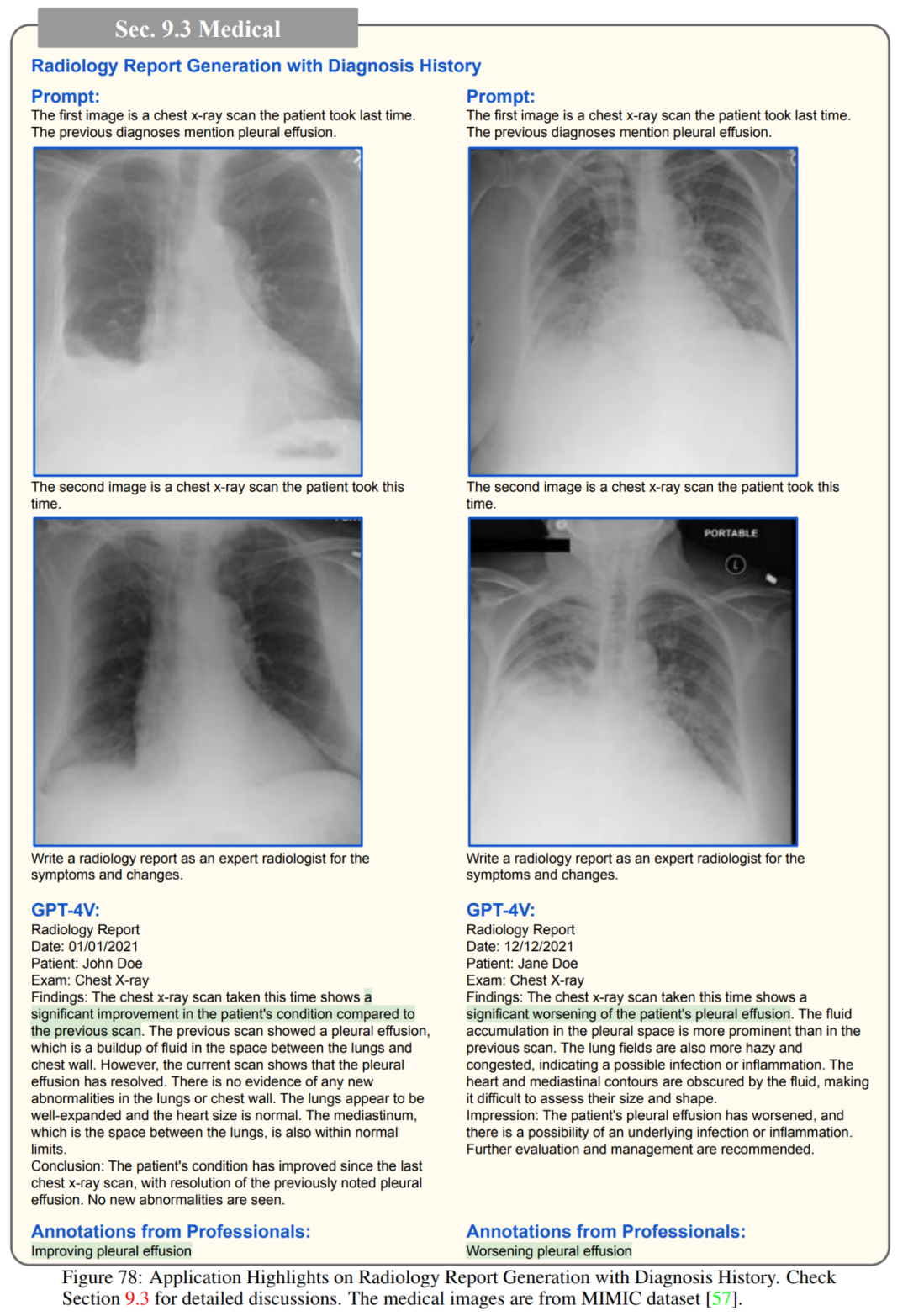

医药

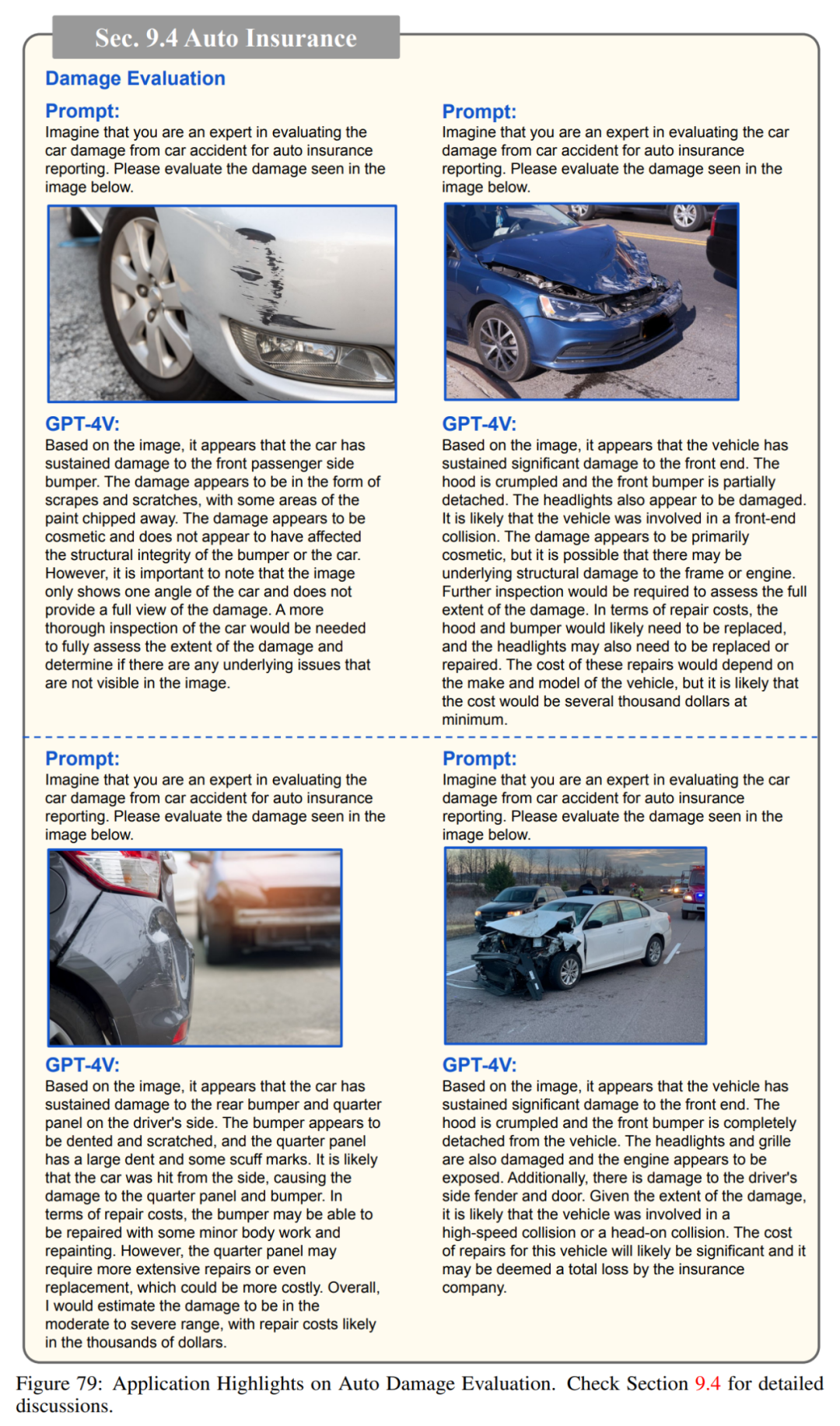

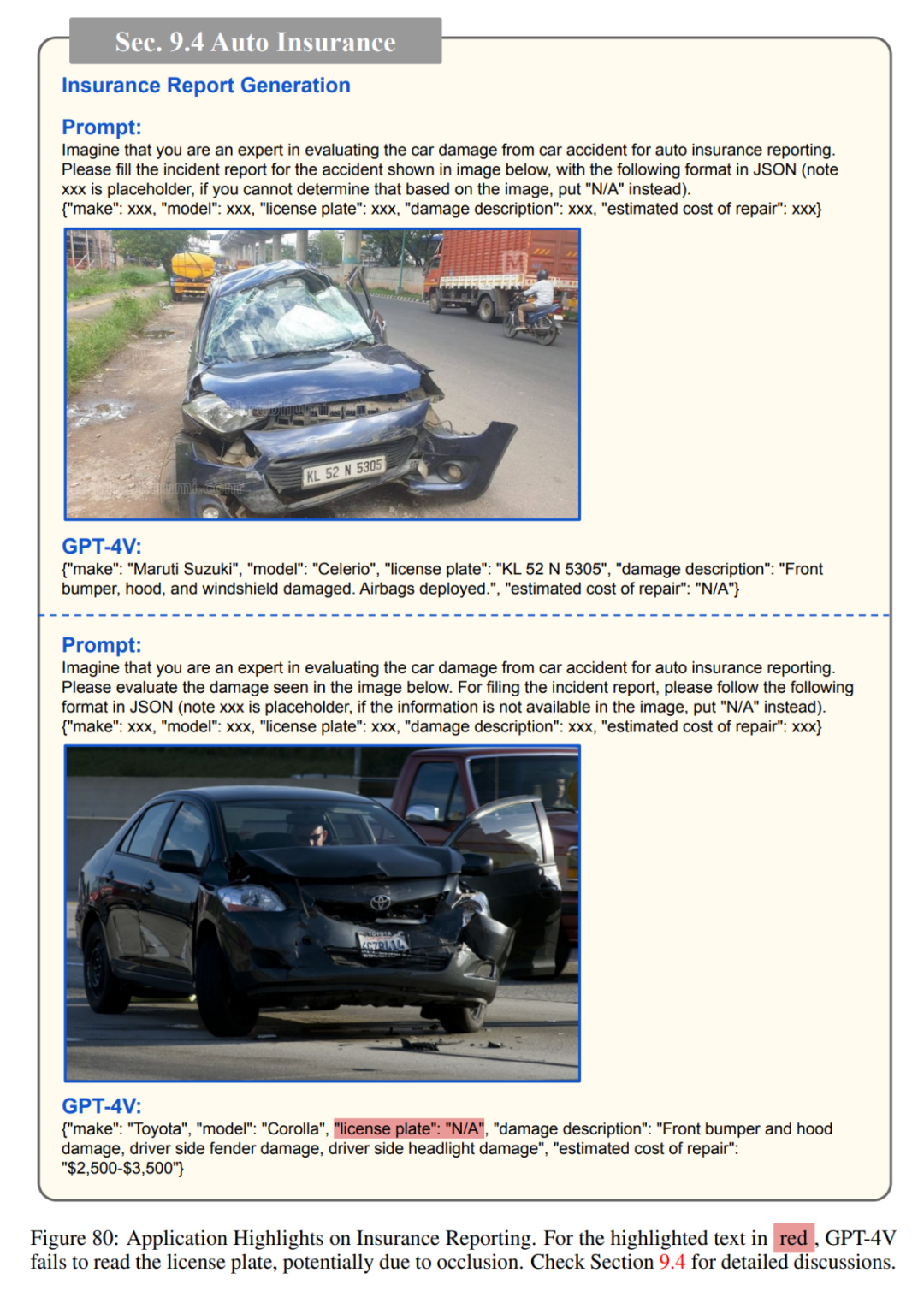

汽车保险

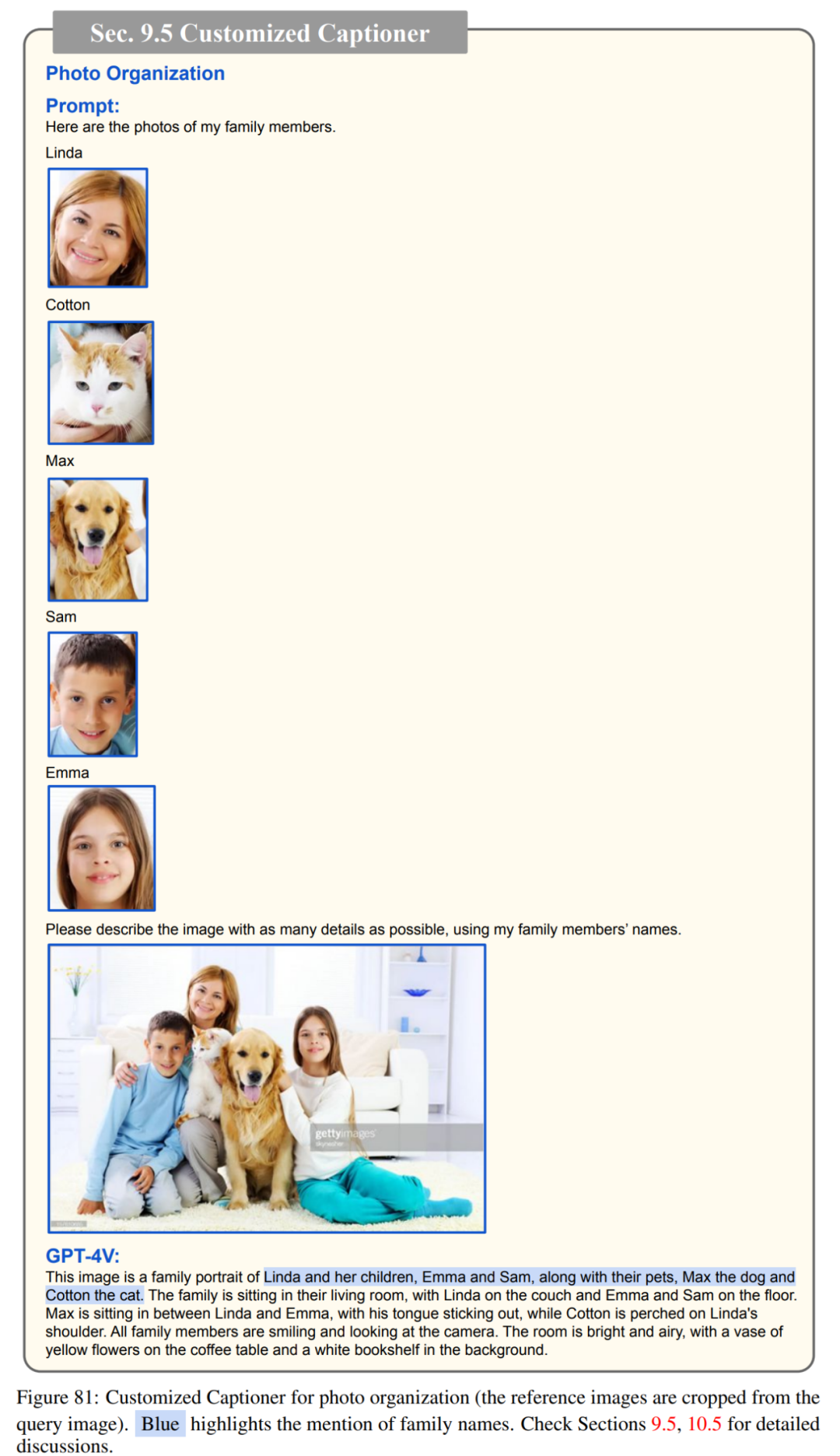

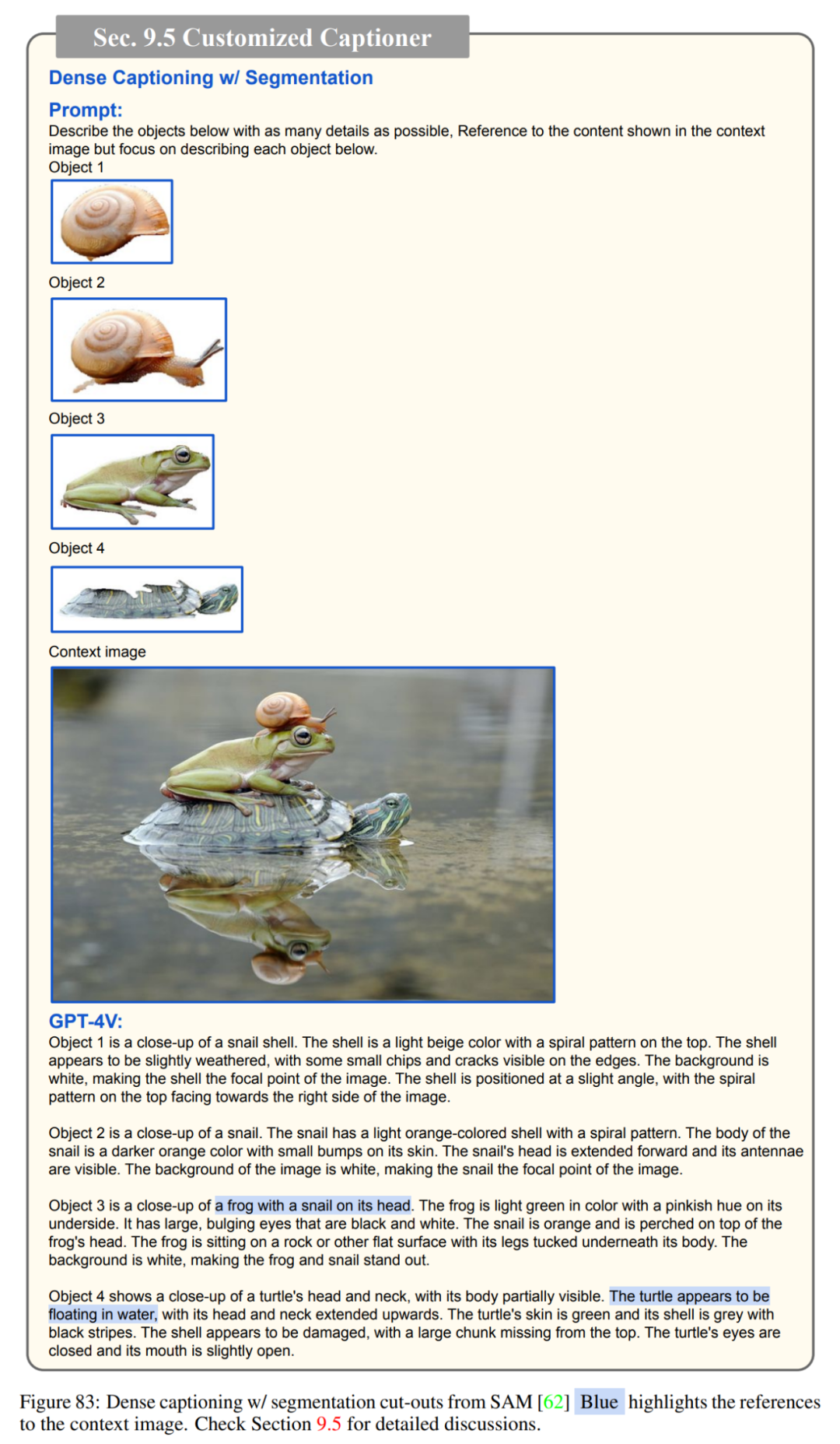

编写照片说明

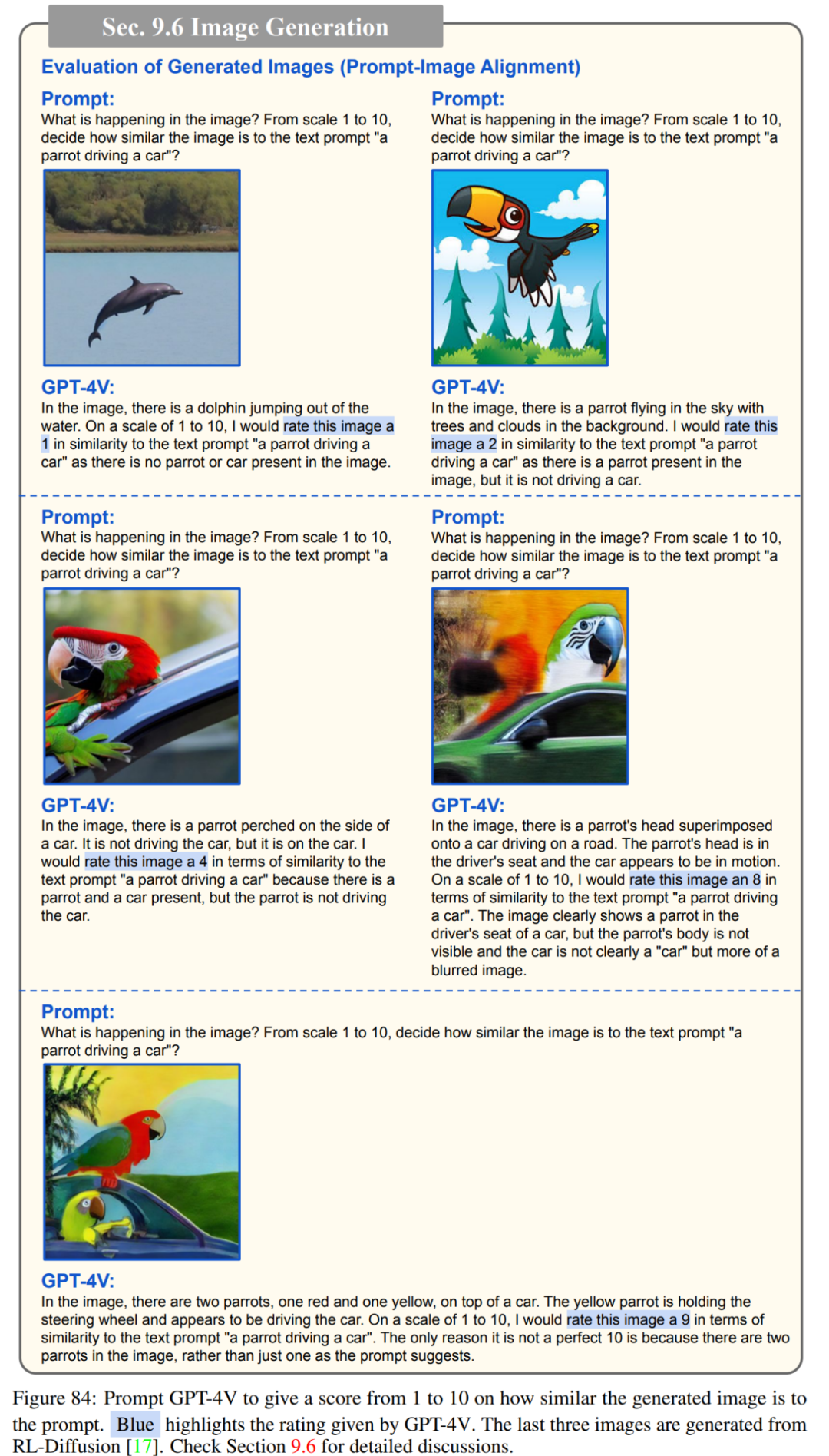

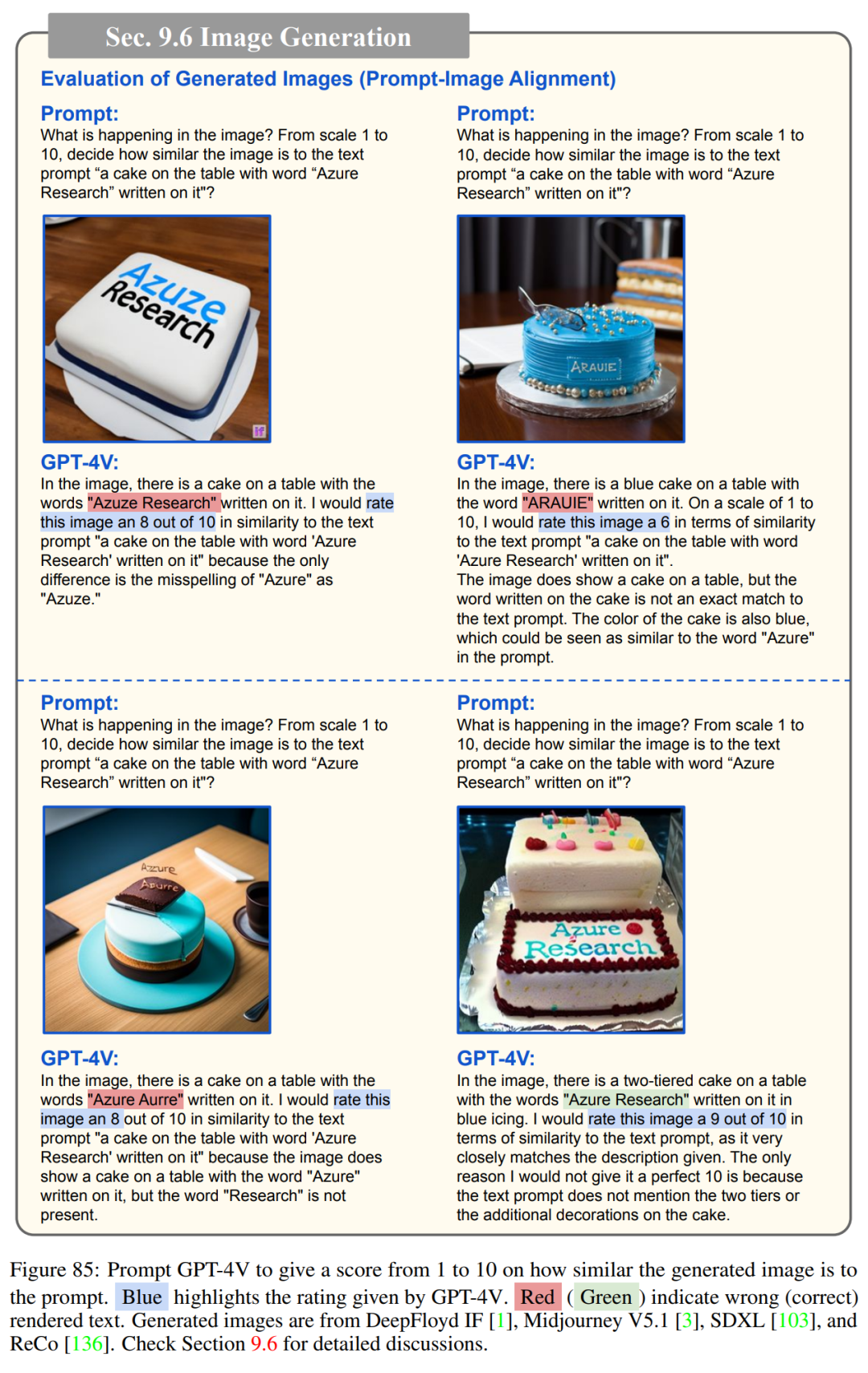

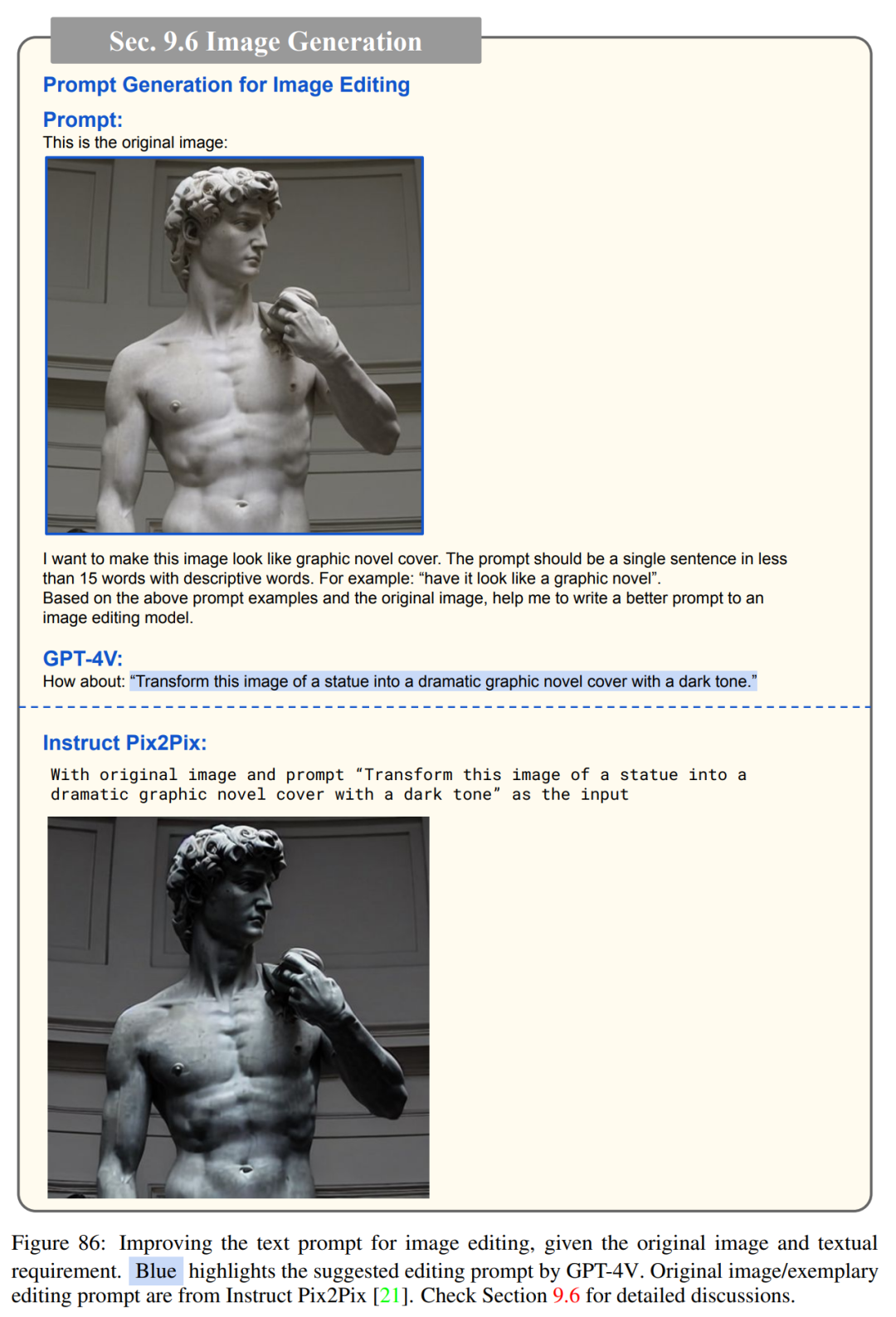

图像理解与生成

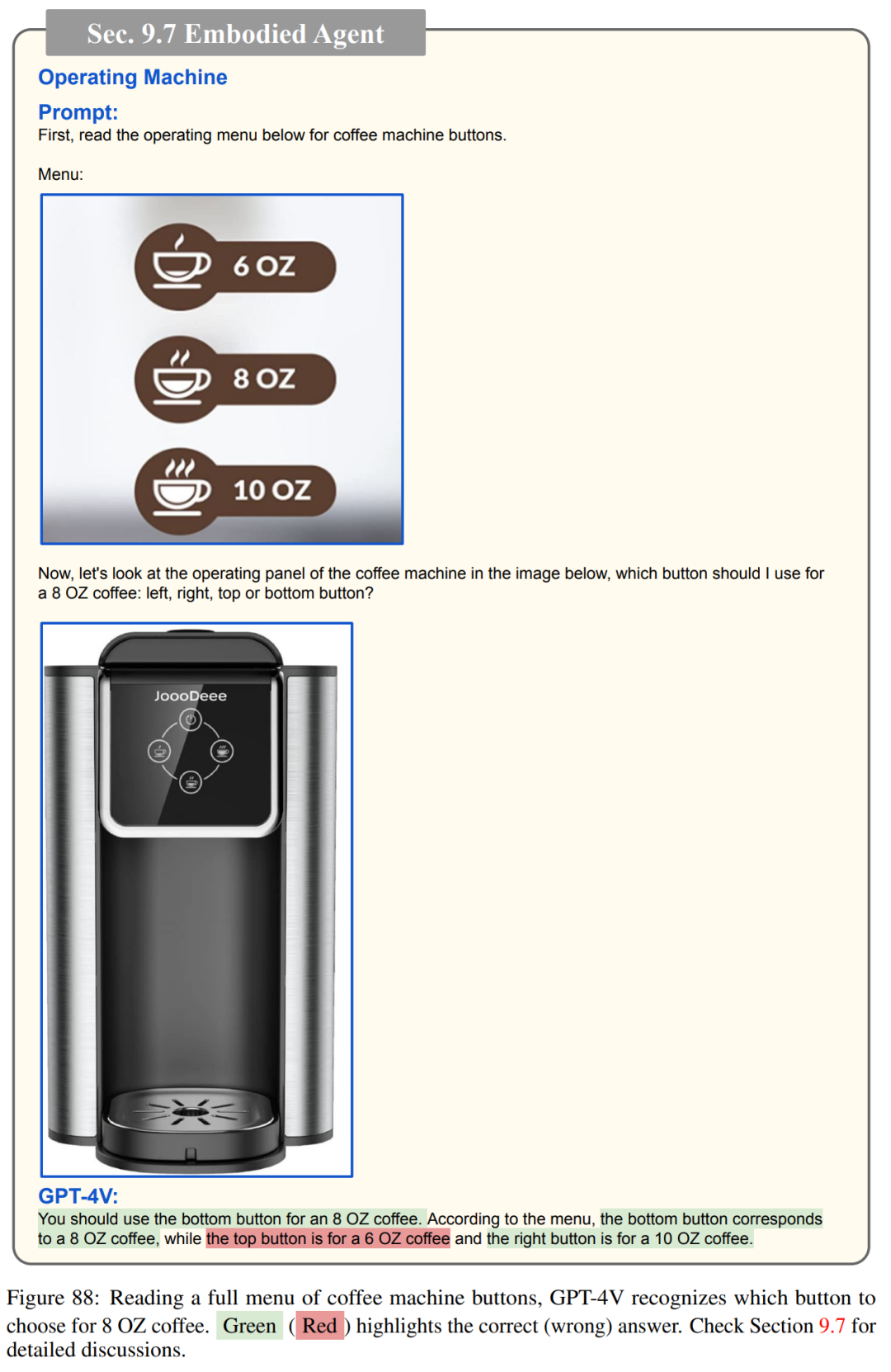

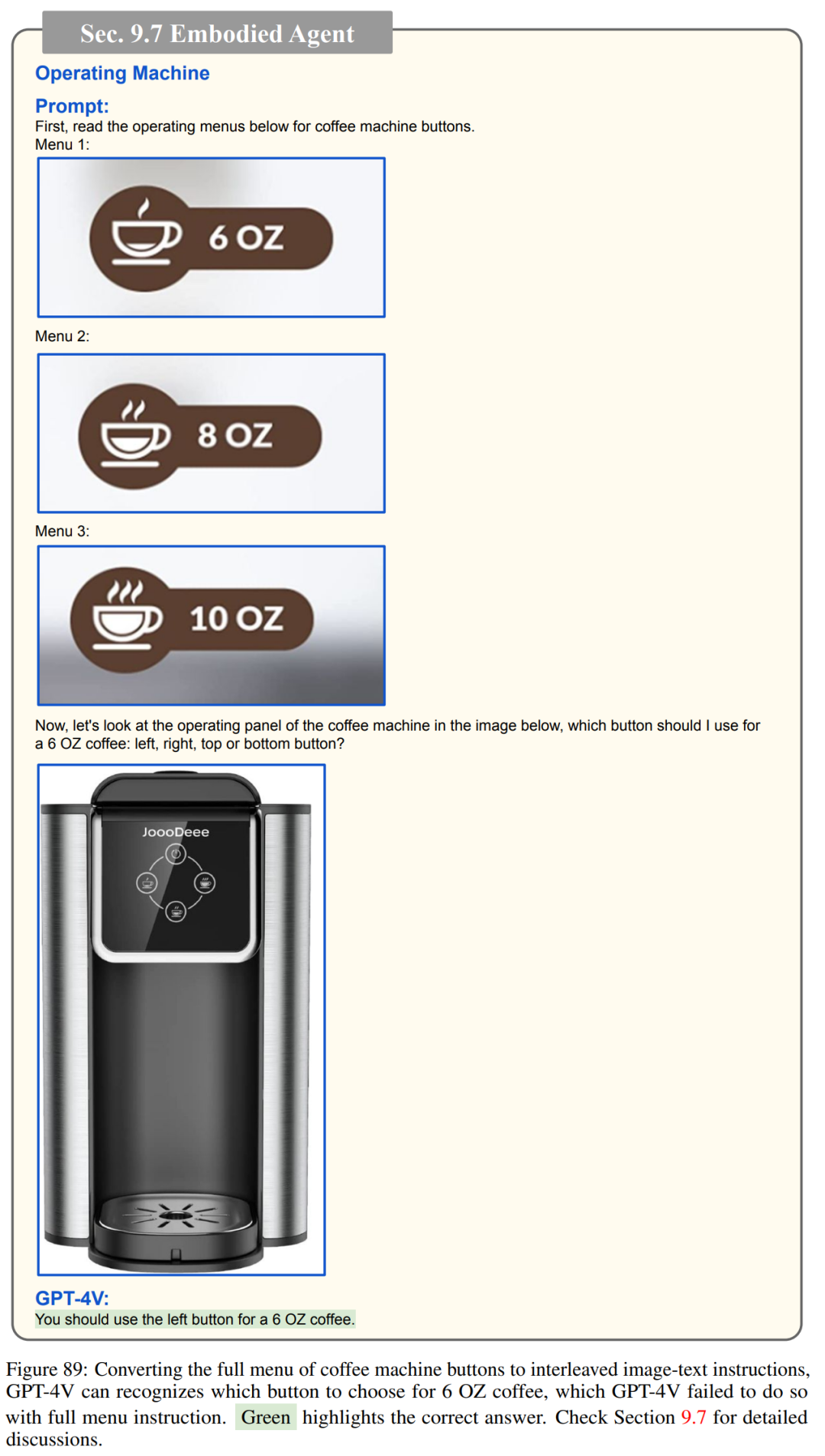

具身智能体

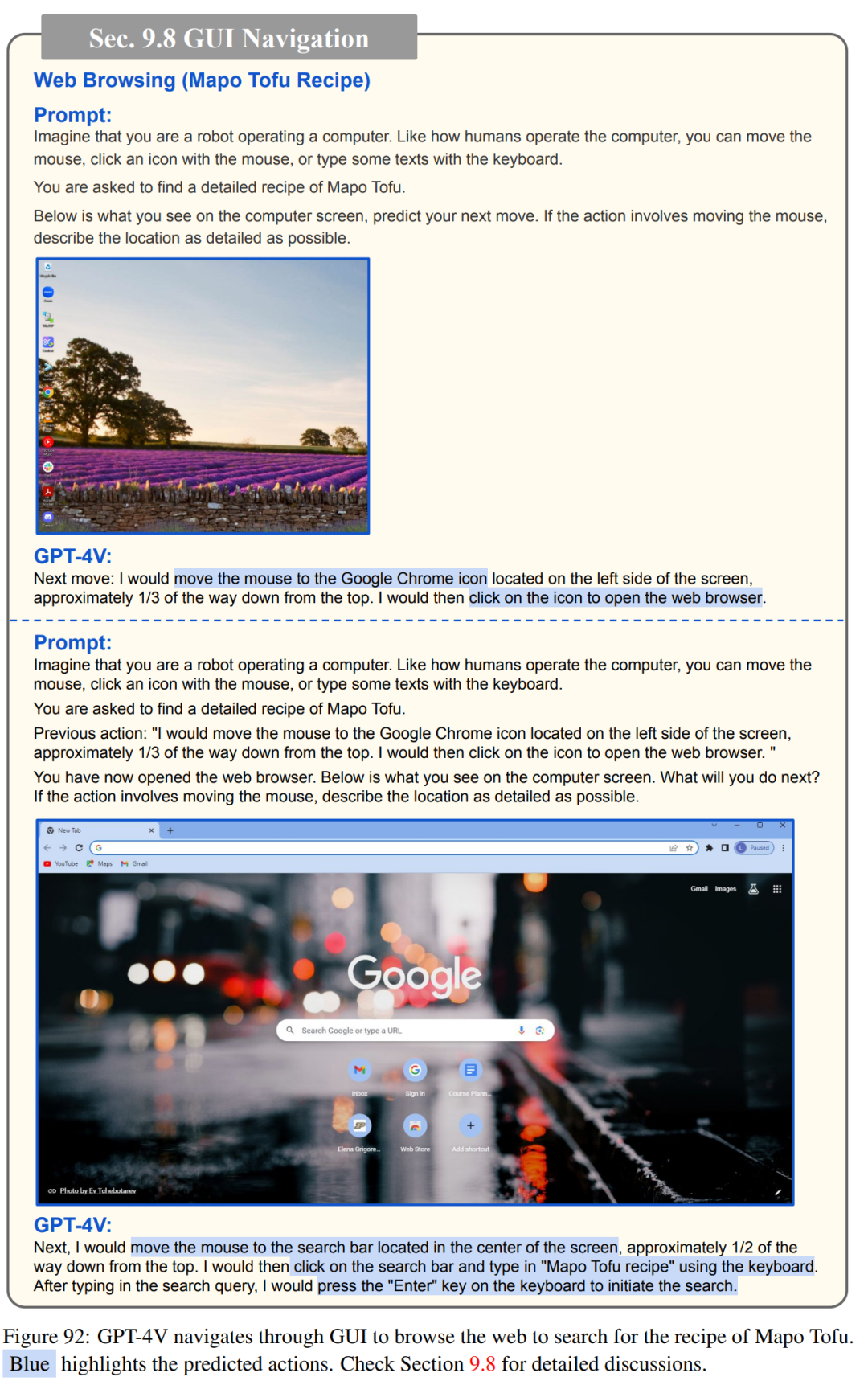

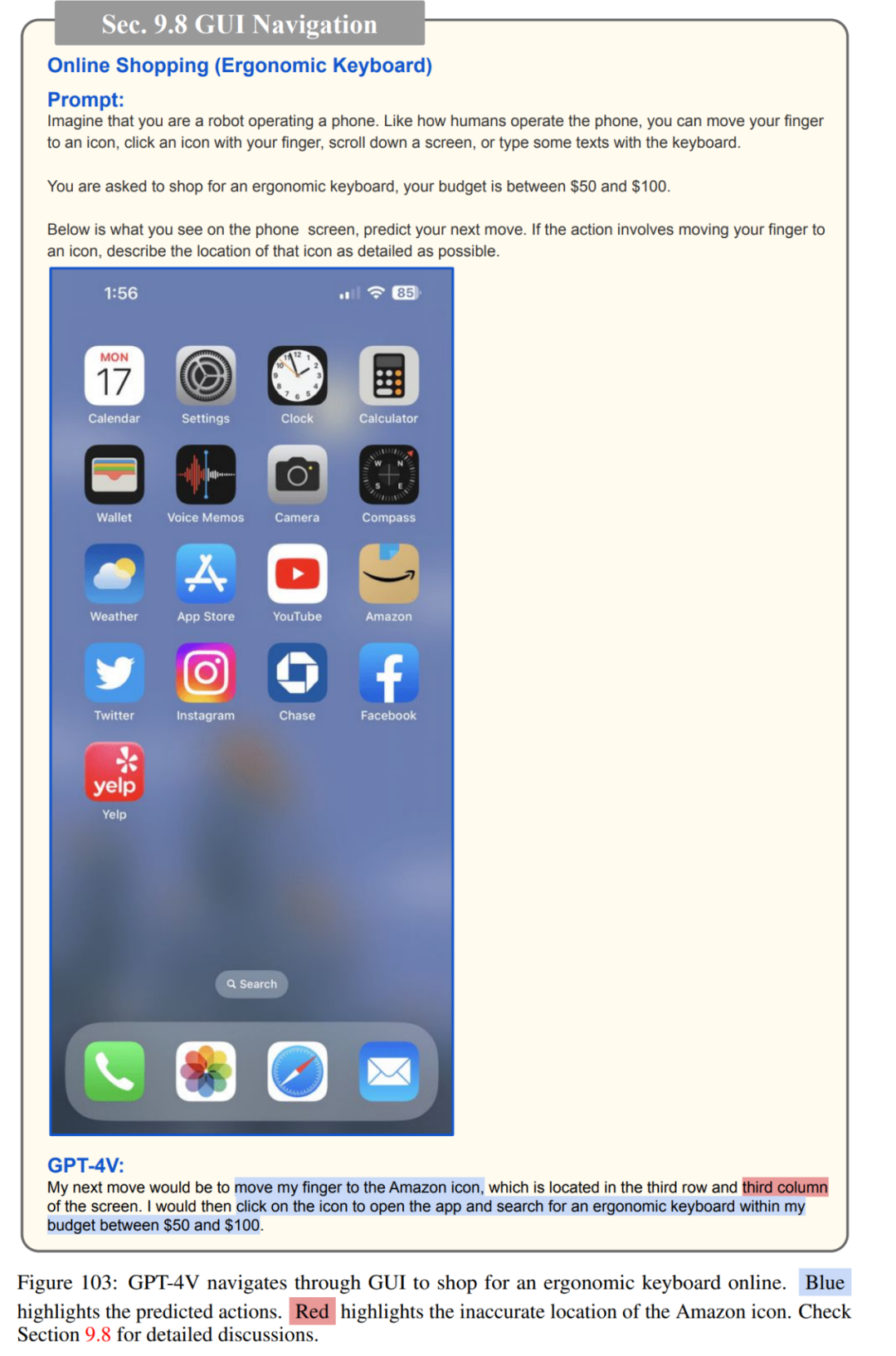

图形用户界面(GUI)交互

基于LLM的智能体

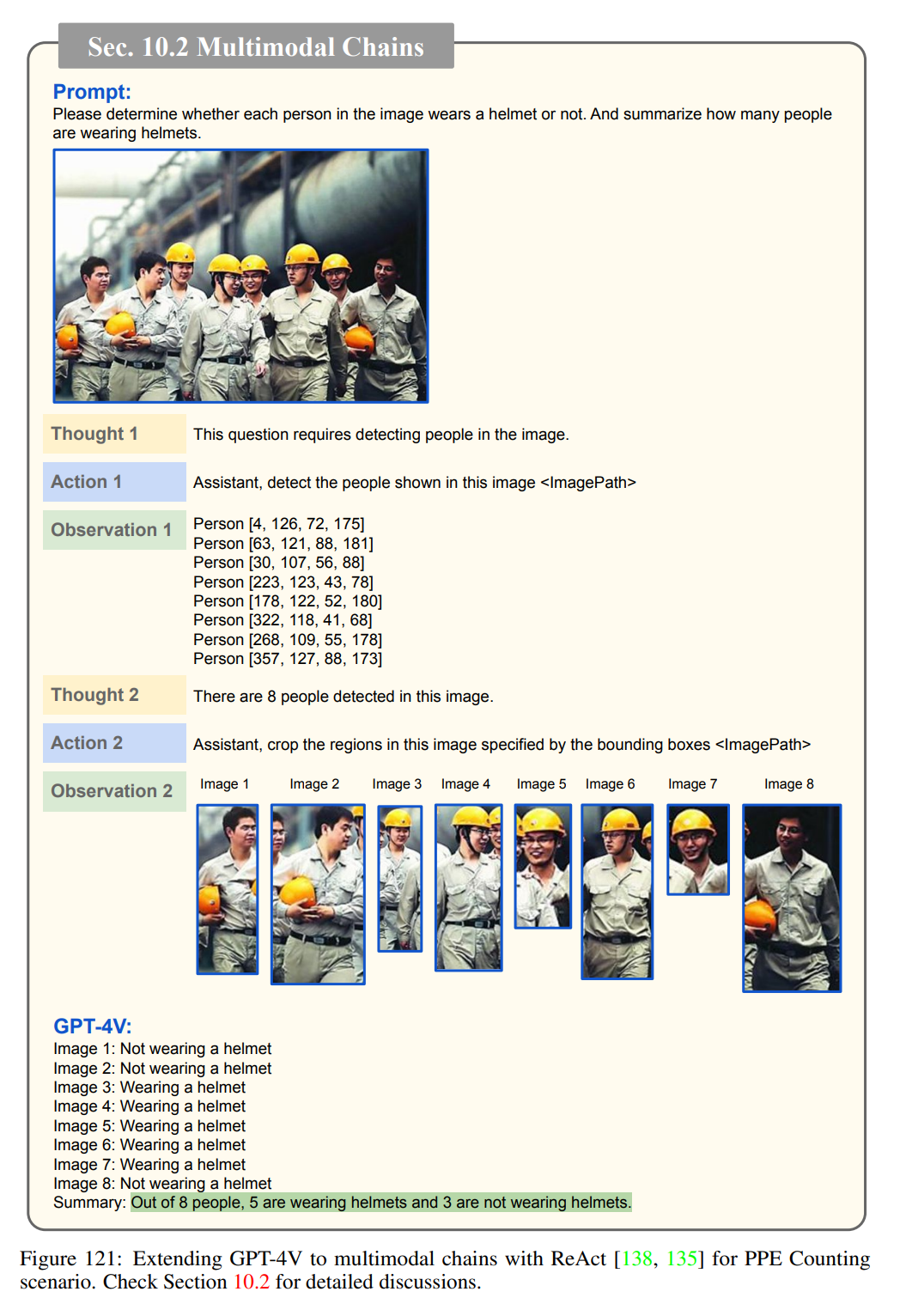

论文第十章讨论了 GPT-4V 未来可能的研究方向,重点是 LLM 中的有趣用法如何扩展到多模态场景。

基于ReAct的GPT-4V多模态链扩展:

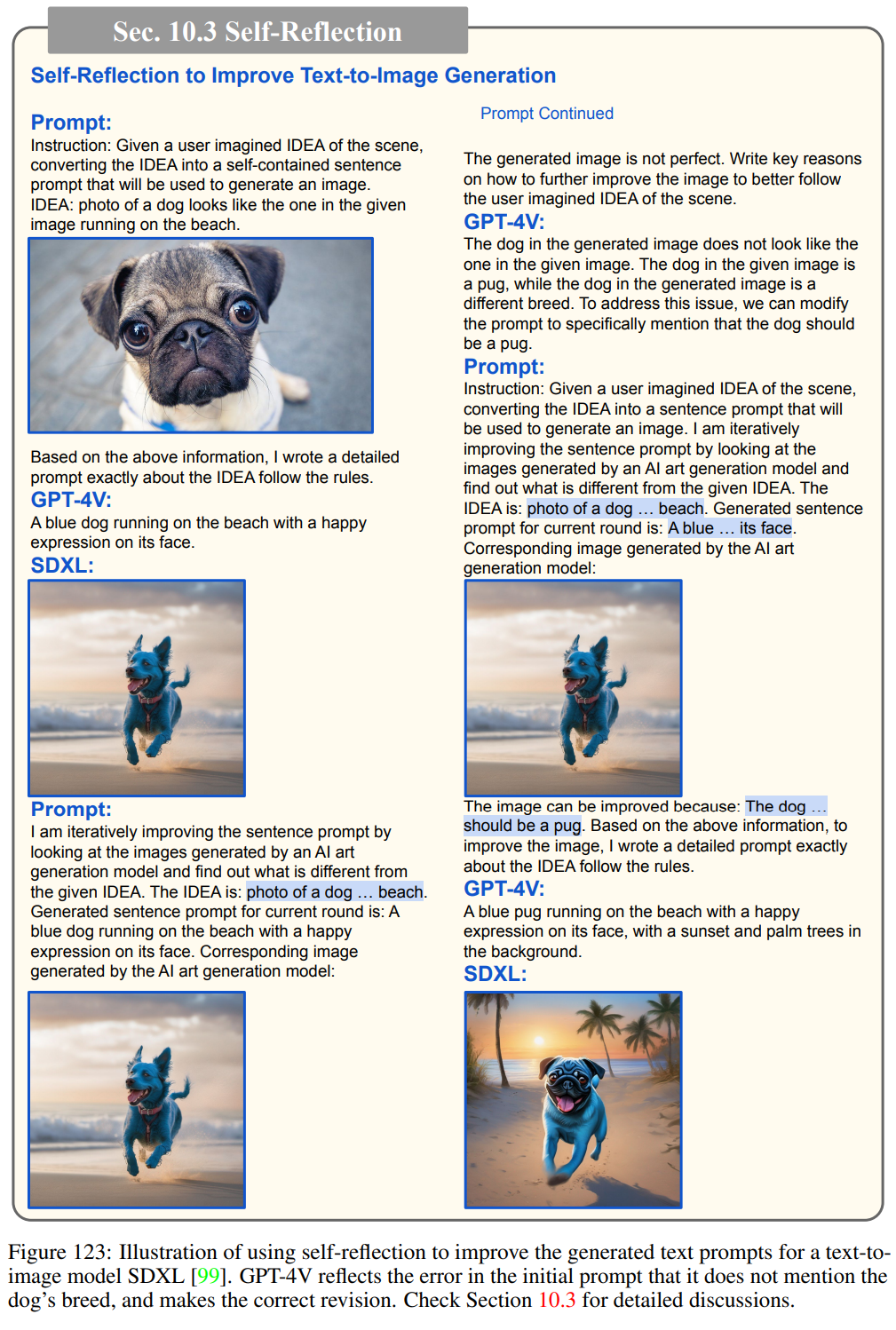

使用自我反思来改进文本到图像模型SDXL生成的文本提示的示例:

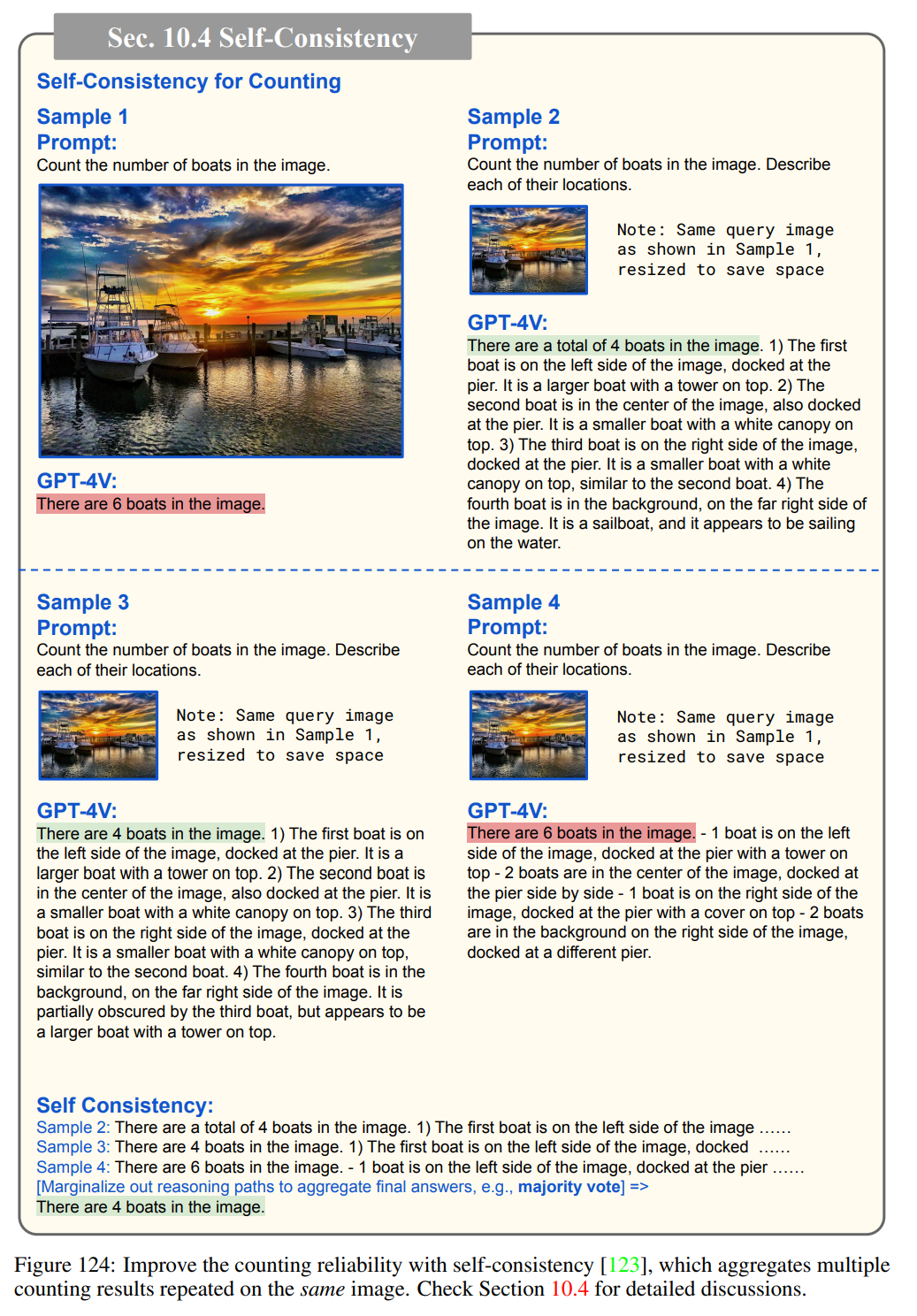

自洽性:

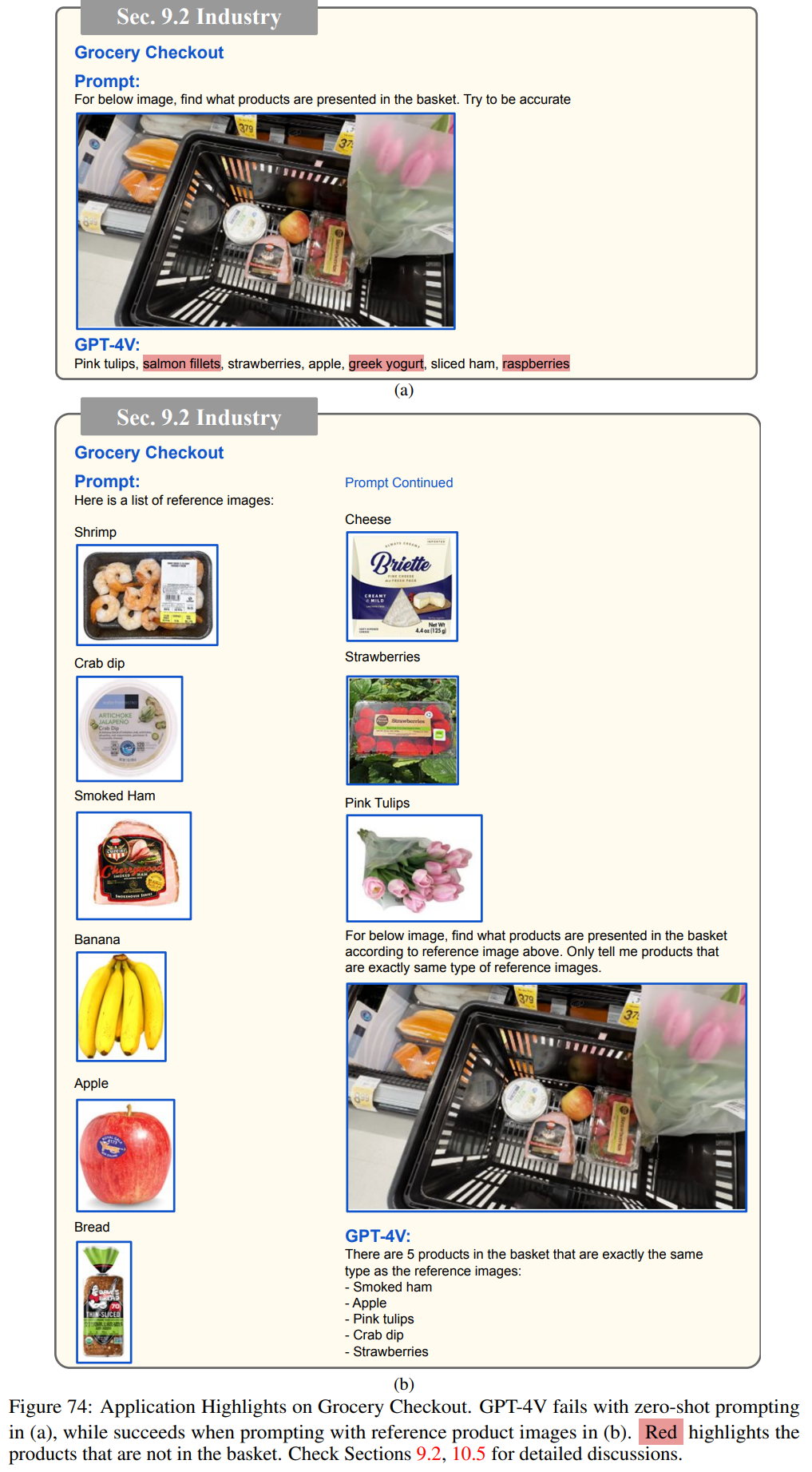

检索增强LMM,图74显示了一个检索增强的LMM帮助杂货店结帐的示例。

关于GPT-4V的更多场景应用细节,请查看原论文。

本文转自机器之心