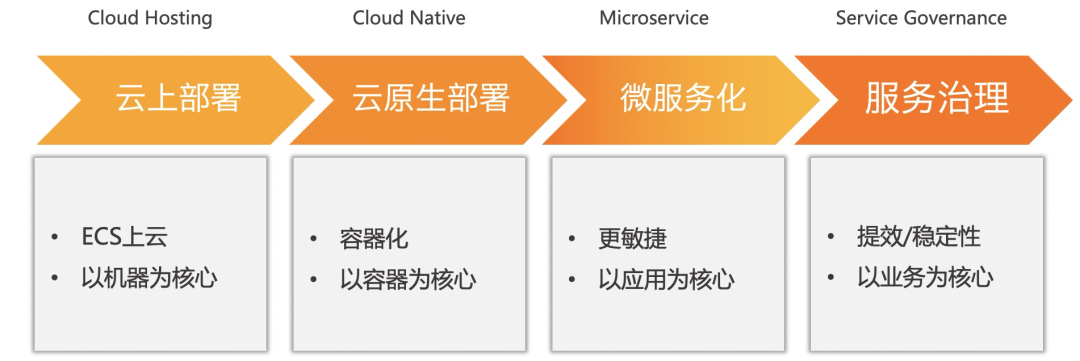

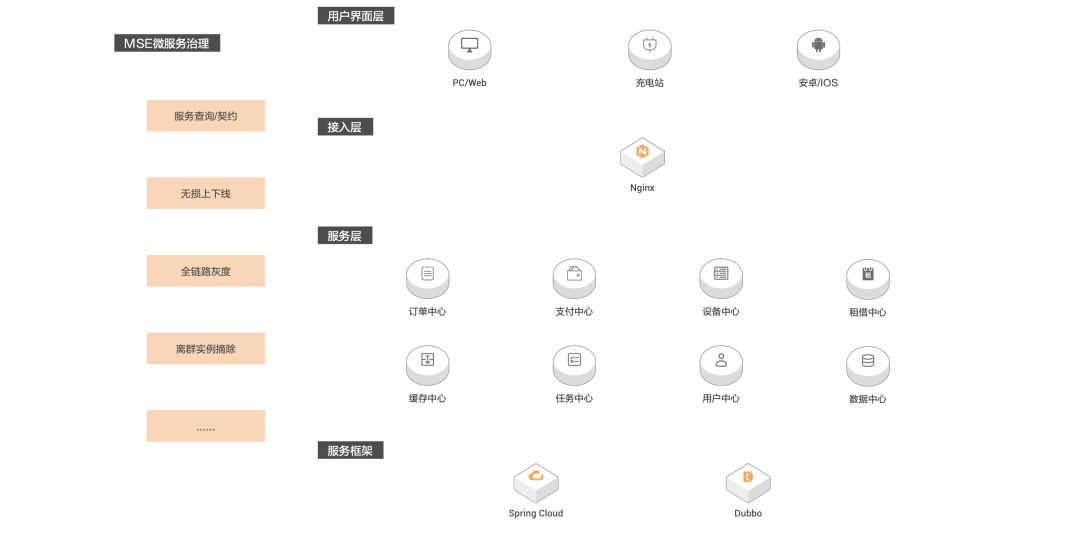

全面容器化之后,来电科技如何实现微服务治理?

MSE 服务治理帮助我们系统以很低的成本无侵入的方式快速实现了全链路灰度能力,进一步提升了我们系统的稳定性,让我们新需求的迭代上线更加地安心。

—来电科技架构师 汤长征

缘起

Cloud Native

微服务全面落地 全面接入 K8s

快速迭代,稳定发布的诉求

部署方便,发布效率大大提升 弹性扩缩容

大大节约服务器成本 运维成本降低

这次改动的内容比较小,而且上线要求比较急,就不需要测试直接发布上线好了

发布不需要走灰度流程,快速发布上线即可

灰度发布没有什么用,就是一个流程而已,发布完就直接发布线上,不用等待观察

虽然灰度发布很重要,但是灰度环境很难搭建,耗时耗力优先级并不高

接入成本高 维护成本高

功能单一,不灵活,可扩展性低 可定位性变差

初见

Cloud Native

无侵入

接入简单

功能强大,持续发展

可视化

拥抱云原生

落地

Cloud Native

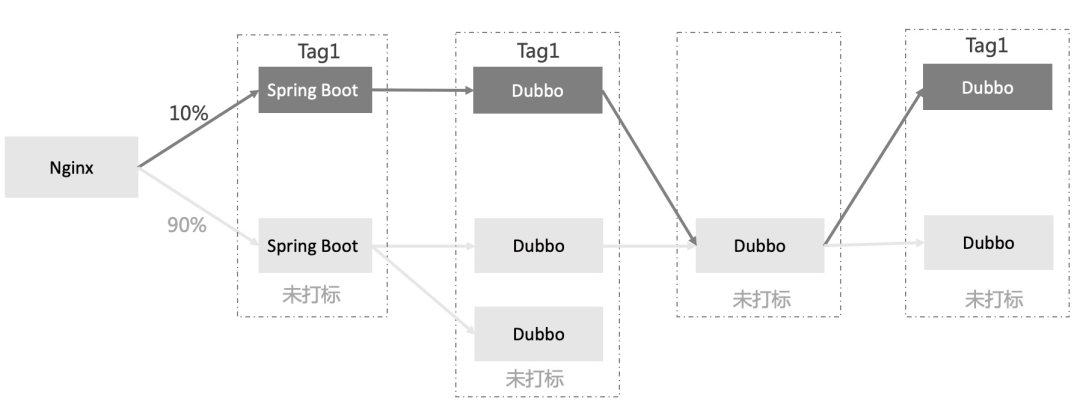

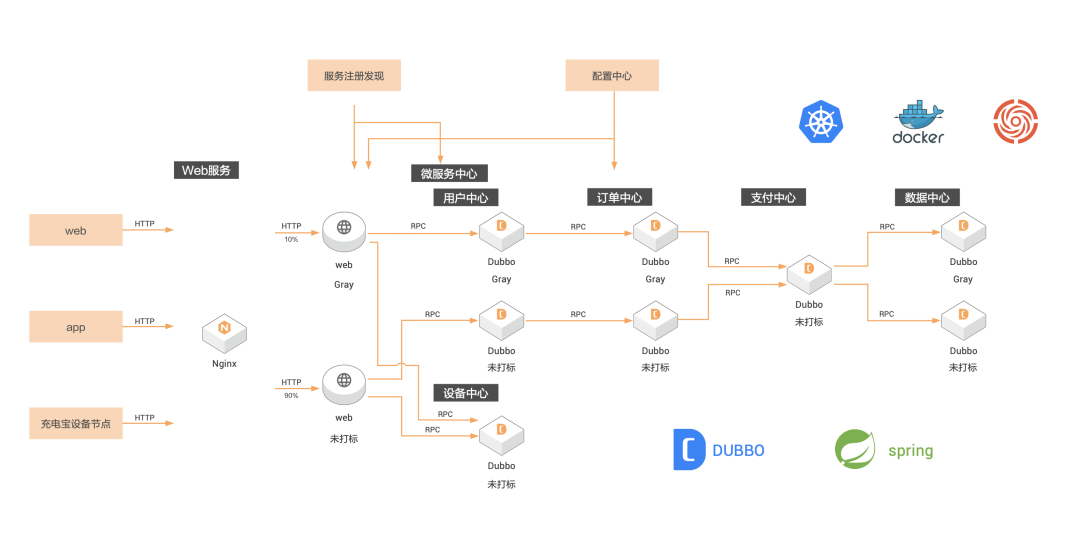

场景一:对经过机器的流量进行自动染色,实现全链路灰度

进入带 tag 的节点后续调用优先选择带有相同 tag 的节点,即对经过 tag 节点的流量进行"染色"

有 tag 的调用链路上找不到相同 tag 的节点,则 fallback 到无 tag 的节点

有 tag 的调用链路经过无 tag 的节点,如果链路后续调用有 tag 的节点,则恢复 tag 调用的模式

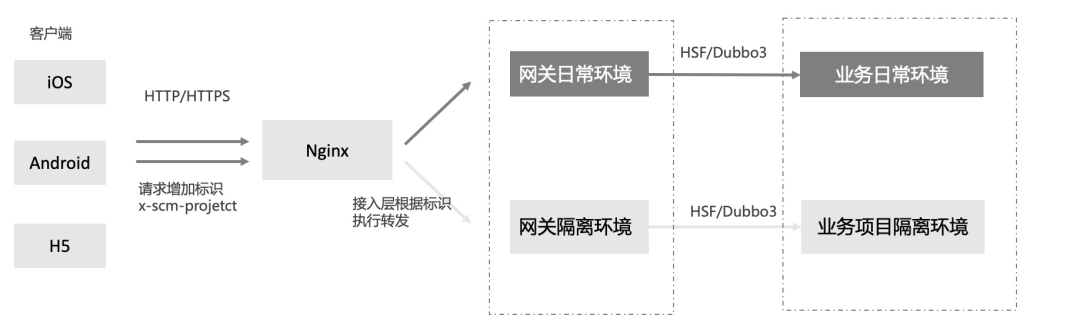

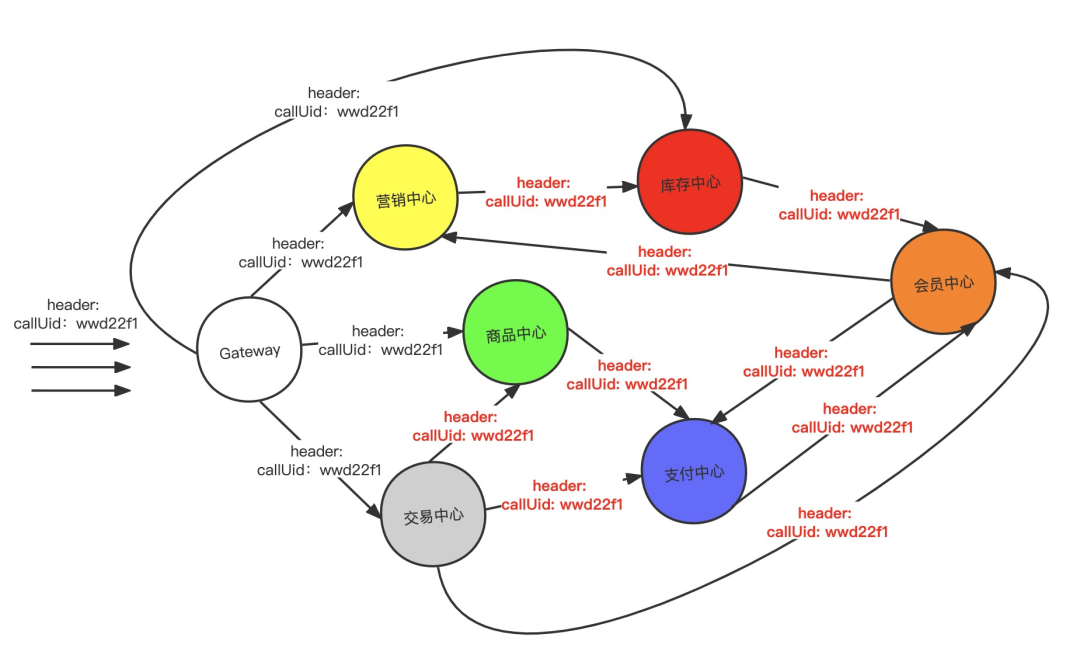

场景二:通过给流量带上特定的 header 实现全链路灰度

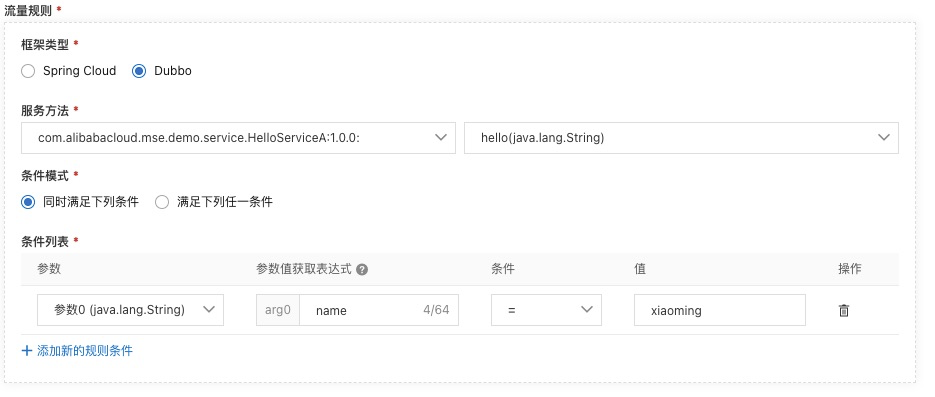

场景三:通过自定义路由规则来进行全链路灰度

未来

Cloud Native

评论