史上增长最快的SaaS公司-Slack的混沌工程实践 | IDCF

来源:混沌工程实践 首发:slack.engineering

作者:Richard Crowley 译者:龙坞道长

标题:Disasterpiece Theater: Slack’s process for approachable Chaos Engineering

引 子

开发环境成为一个对容错测试更有信心的地方 ; 测试所有系统(不仅仅是新系统) ; 不能造成影响用户的事件,所做的测试都必须安全 ; 不要虚假的信心,所做的一切都需要在生产中进行 。

识别可能发生的故障; 确保服务能够容忍这些故障; 故意在生产中引入这些故障。

演练准备

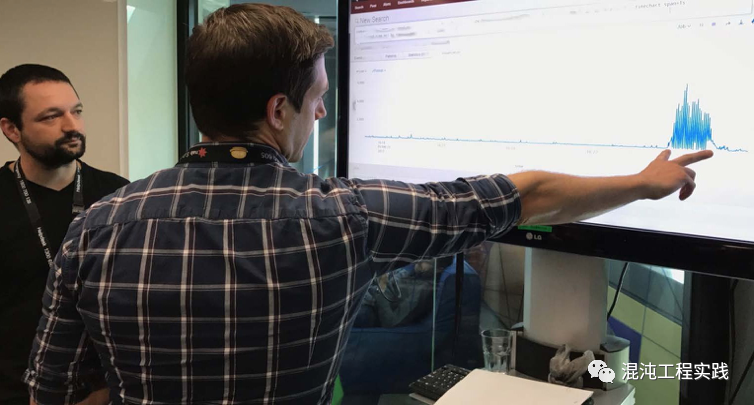

灾难来袭

找到问题根源和解决问题的时间点; 是否有用户已经注意到这个问题; 是否需要人工干预这个问题; 这个问题的严重程度; 演练计划的文档是否有差错; Grafana中的仪表板是否已过时。

演练结果

未来展望

评论