正则表达式是如何让你的网页卡住的

SegmentFault

共 5229字,需浏览 11分钟

·

2020-12-04 19:37

概述

正则表达式在我们日程的工作项目中,应该是一个经常用到的技能。在做一些字符的匹配和处理的过程中,发挥了很大的作用。我们这篇文章主要是通过一个我在工作中遇到的性能问题,来探究下正则表达式是如何影响我们的代码性能的。在我们遇到了正则表达式有性能平静的时候,我们应该如何的来对它进行优化?

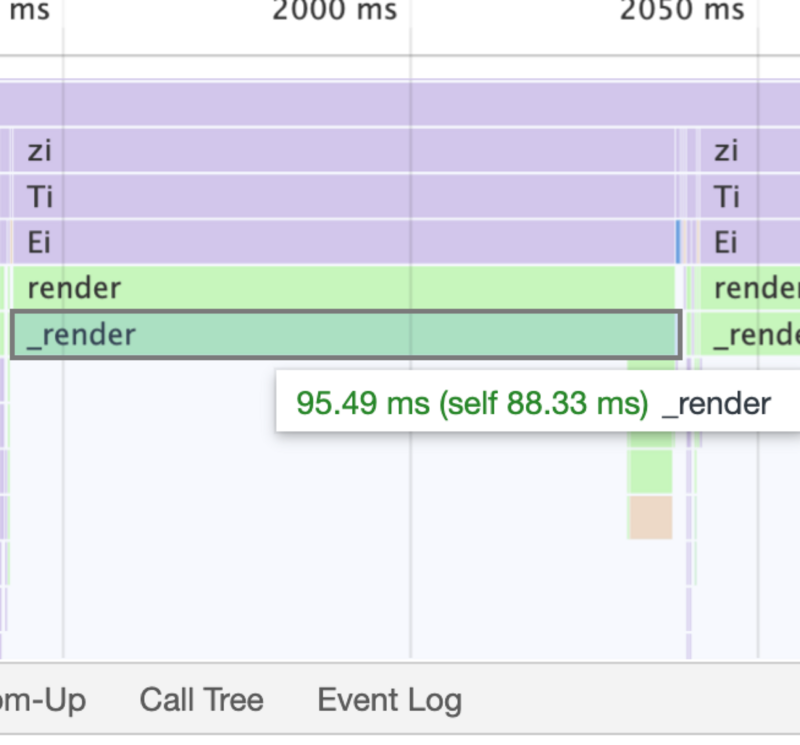

问题现状

const QUOTED_MSG_REG = /([^「]*?)「((?:[a-zA-Z0-9\u4E00-\u9FBF_\.\s]{0,40})\:(?:.|\n)*)」\n(—){10}\n((?:\S|\s)*)$/m;

const MEETING_ROOM_REG = /北京厅|天津厅|石家庄厅|济南厅|哈尔滨厅|...(此处省略200+个会议室)|台湾厅/mg;

// 引用格式

「张三:老司机」

——————————

带带我

// 会议室

张三呀,我们去 常德厅 开个会吧,叫上其他人

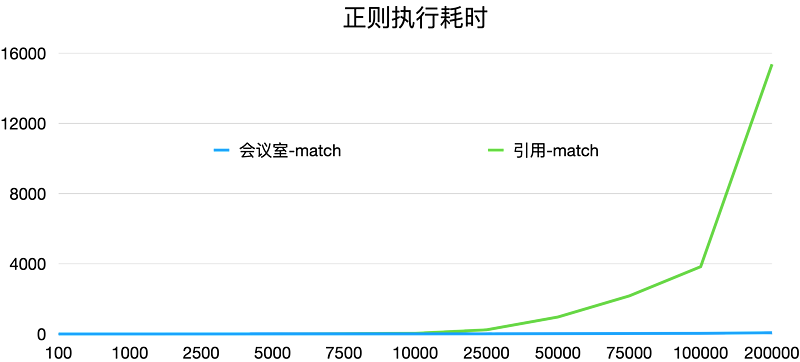

问题分析

原理分析

解决方案

优化正则表达式本身

在明确匹配规则的情况下,使用\d{1, 30}来替换.*,尽可能的去明确我们需要匹配的类型与长度。 在需要进行不明确数量匹配的时候,尽可能的使用非贪婪匹配,而不是使用贪婪匹配。

优化正则表达式匹配顺序

let str = 'xxxxxx'; //长文本

const LINE_REG = /\n(—){10}\n/m;

const QUOTED_MSG_REG = /([^「]*?)「((?:[a-zA-Z0-9\u4E00-\u9FBF_\.\s]{0,40})\:(?:.|\n)*)」\n(—){10}\n((?:\S|\s)*)$/m;

if(LINE_GER.test(str)) {

let result = str.match(QUOTED_MSG_REG);

// do something

}

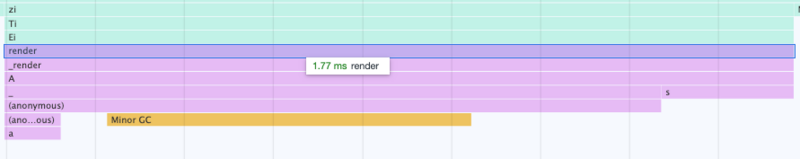

不要在主线程中执行

服务端数据处理

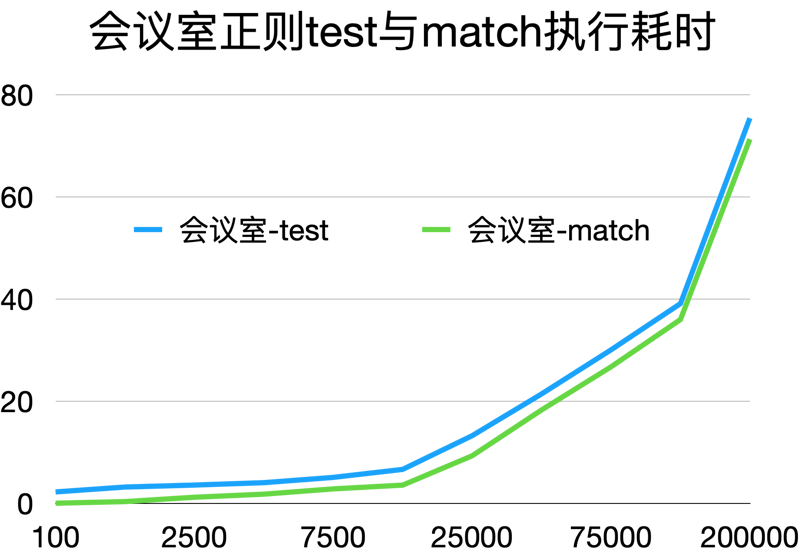

效果验证

总结

我们需要尽可能的去让我们的正则表达式准确化,越准确的正则表达式匹配时,他的回溯情况就越少,所以它的性能就越高。 在正则表达式已经没有办法再进行优化的情况下,我们可以先选取一些没有回复情况的特征值进行先置条件判断,这样的话,我们能够尽量多的去避免一些无意义的好事匹配,优化我们的性能。 借助其他线程或者服务来进行正则处理,避免用户卡顿。

评论