无人驾驶 | 为什么双目自动驾驶系统难以普及?

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

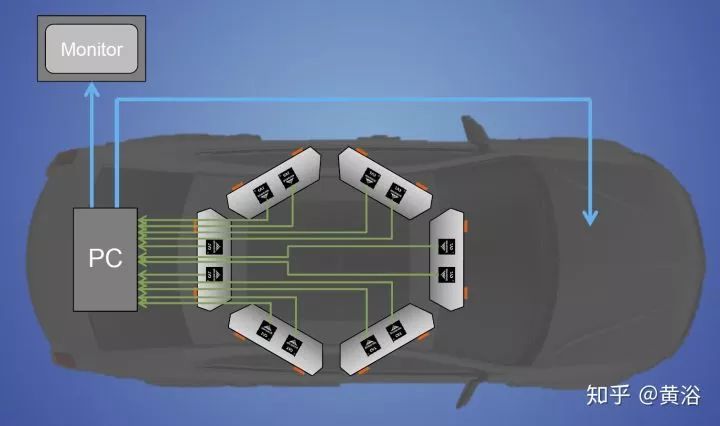

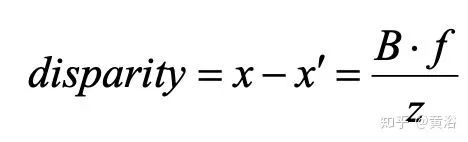

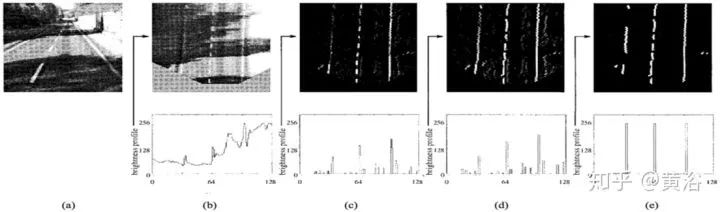

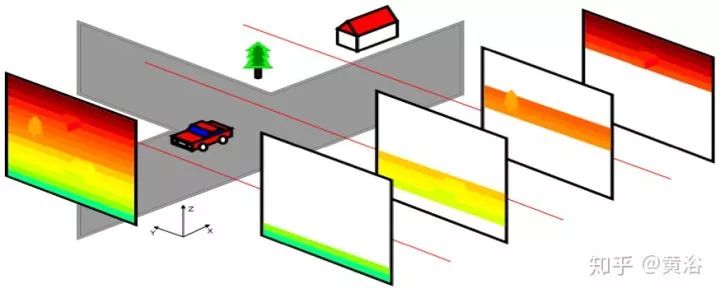

先说立体匹配,即视差/深度估计。如图假设左右摄像头焦距f,基线(两个光心连线)宽B,3-D点X的深度z,而其视差(投影到左右图像的2-D点,其坐标差)即

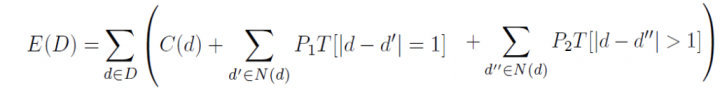

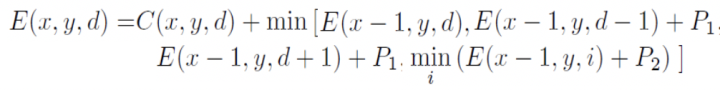

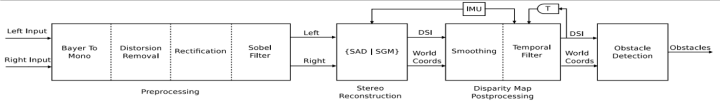

匹配成本(matching cost)计算; 成本聚集(aggregation); 视差(disparity)计算/优化; 视差修正(refinement)。

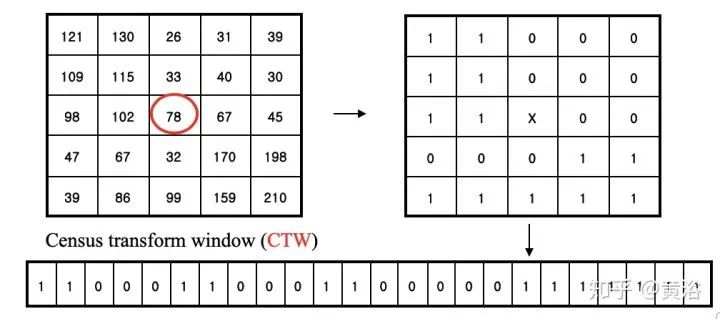

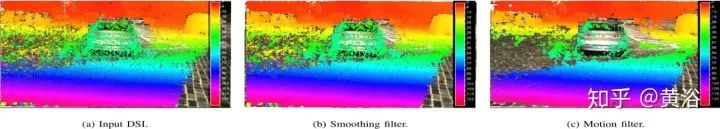

1) 空间传播(Spatial propagation): 每个像素检查左边和上边邻居视差和平面参数,如果匹配成本变小就取代当前估计; 2) 视角传播(View propagation): 其他视角的像素做变换,检查其对应图像的估计,如果变小就取代; 3) 时域传播(Temporal propagation): 前后帧考虑对应像素的估计; 4) 平面细化(Plane refinement): 随机产生样本,如果估计使匹配成本下降,更新。 5) 后处理(Post-processing): 左右一致性和加权中值滤波器去除出格点(outliers)。

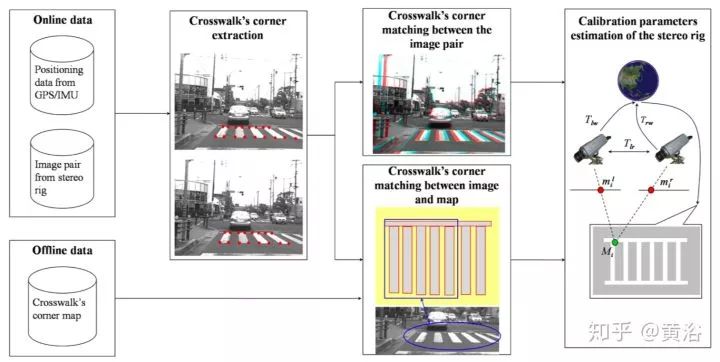

再说在线标定。

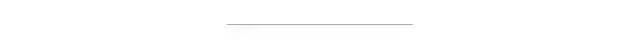

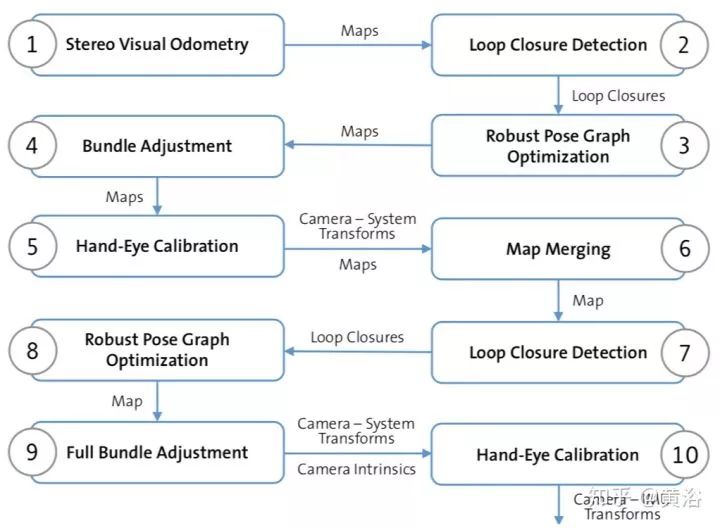

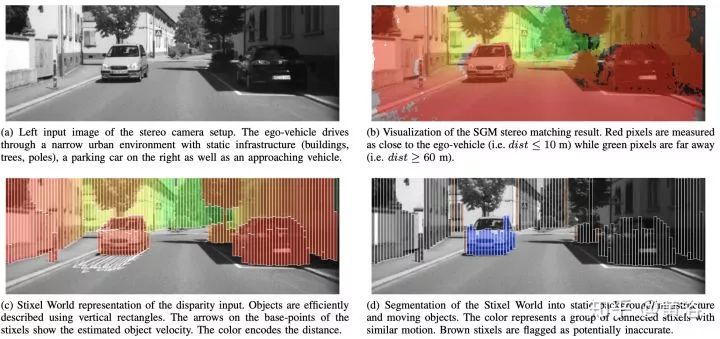

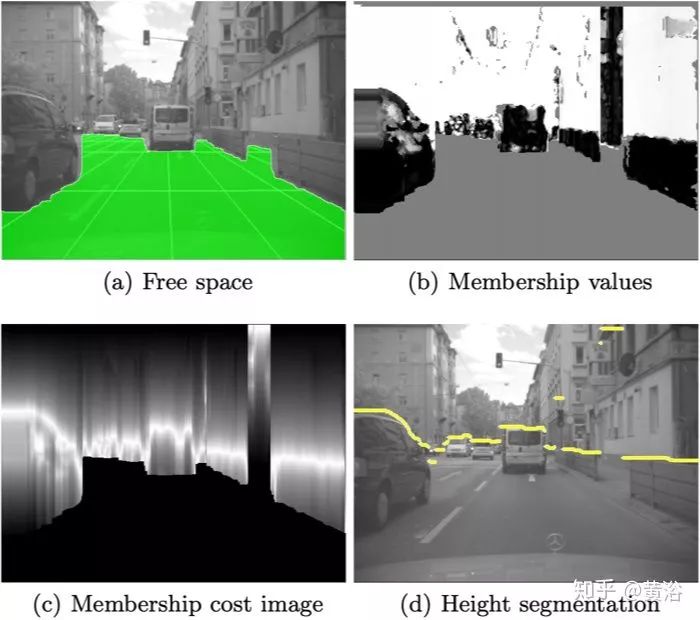

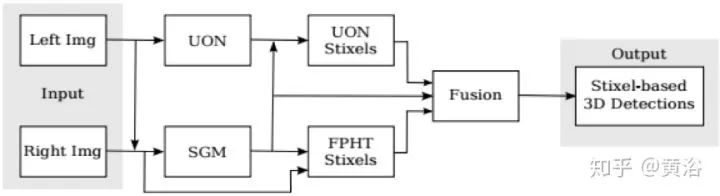

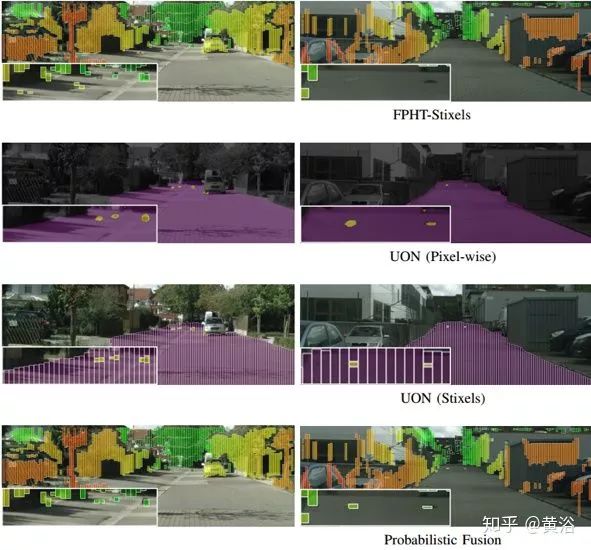

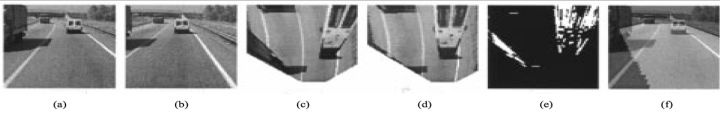

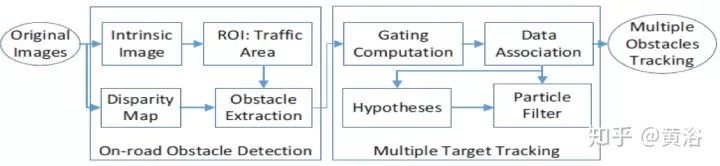

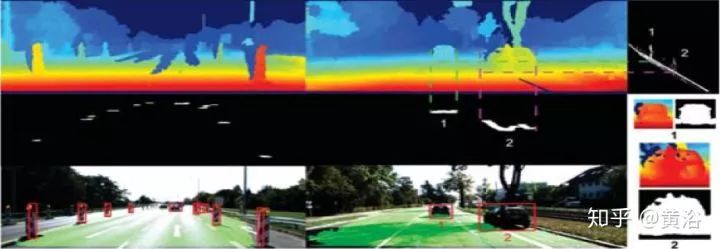

下面介绍几个典型的双目自动驾驶系统。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

评论