收藏|图神经网络综述

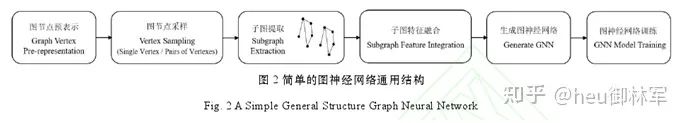

STEP1图节点预表示:通过图嵌入(Graph Embedding)的方法对图中每一个节点进行嵌入表示; STEP2图节点采样:对图中每个节点或存在的节点对的正负样本进行采样; STEP3子图提取:提取图中每一个节点的邻节点构建n阶子图,其中n表示第n层的邻节点,从而形成通用的子图结构; STEP4子图特征融合:对每一个输入神经网络的子图进行局部或全局的特征提取; STEPS生成图神经网络和训练:定义网络的层数和输入输出的参数,并对图数据进行网络训练。

作者:王健宗等 https://wwwihcm/people/euu-lin-jun-7 原文链接: https://kns.cnki.net/kcms/detail/31. 1289.tp.20201123.1641.002.html 编辑:黄继彦 校对:林亦霖

评论