人工智能的第一性原理是什么?

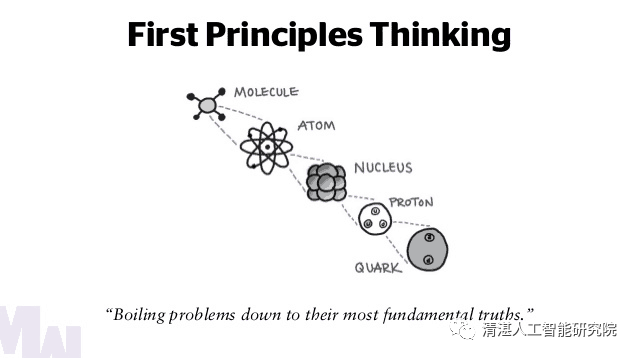

实现通用人工智能(Artificial General Intelligence,AGI)是一个长远目标。我们需要探索通往人工智能(AI)的道路,要以基础研究作为出发点。“基础研究是整个科学体系的源头,是所有技术问题的总机关。”这也说明了AI基础理论研究的意义和重要性。要加强AI的数学物理基础研究,可以将“第一性原理”(first principle)作为出发点,发展新一代AI基础理论。

人工智能领域存在第一性原理吗?

古希腊哲学家亚里士多德将第一性原理(或首要原则)表述为:“在每一个系统的探索中,存在第一性原理,这是一个最基本的命题或假设,不能被省略或删除,也不能被违反。” 在20世纪以前,第一性原理主要用于哲学、数学和理论物理。在数学中,第一性原理是一个或几个公理,且不能从系统内的任何其他公理中推导出来。在理论物理中,第一性原理是指一个计算直接从物理定律建立,不做经验模型和拟合参数等假设。生物学的第一性原理是达尔文提出的“物竞天择、适者生存”理论。在近代社会,第一性原理已经扩展到许多学科,包括生命科学、化学、经济、社会科学等。

作者:郭平,北师大学图象处理研究中心主任

来源:清湛人工智能研究院、图灵人工智能

END

评论