人类偏好的“可塑性”,从博弈说起

如何寻找奖励信号优化复杂行为?

如何让机器将人类行为转化为人类偏好?

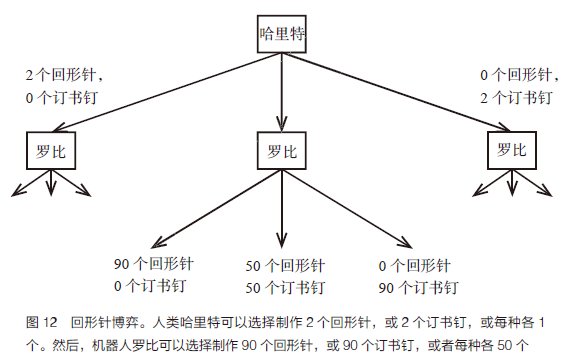

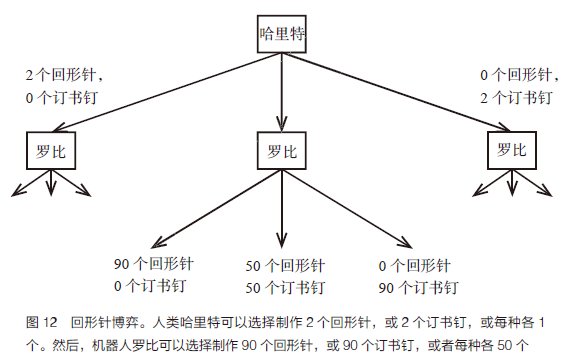

机器人罗比会梦见回形针吗?

实习/全职编辑记者招聘ing

加入我们,亲身体验一家专业科技媒体采写的每个细节,在最有前景的行业,和一群遍布全球最优秀的人一起成长。坐标北京·清华东门,在大数据文摘主页对话页回复“招聘”了解详情。简历请直接发送至zz@bigdatadigest.cn

评论

下载APP

下载APP

如何寻找奖励信号优化复杂行为?

如何让机器将人类行为转化为人类偏好?

机器人罗比会梦见回形针吗?

实习/全职编辑记者招聘ing

加入我们,亲身体验一家专业科技媒体采写的每个细节,在最有前景的行业,和一群遍布全球最优秀的人一起成长。坐标北京·清华东门,在大数据文摘主页对话页回复“招聘”了解详情。简历请直接发送至zz@bigdatadigest.cn