中国芯片现状洞察(2021)

根据WSTS和IC Insights两家机构的统计数据综合整理,我国在过去三年中对MPU和逻辑电路的份额持续增加,DRAM芯片呈下降趋势,模拟电路、Nand Flash和MCU的份额呈现波动稳定。

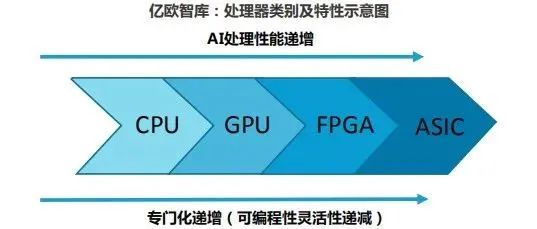

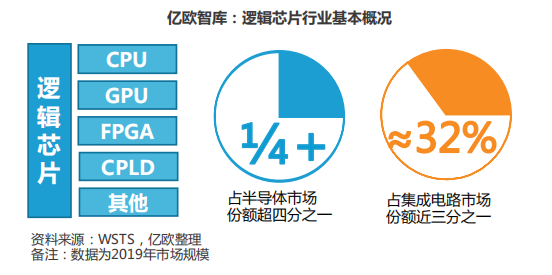

综合来看,Nand Flash和DRAM是两种主流的存储芯片,与需求量较小 的NOR Flash一起在国内芯片份额的占有率基本不低于30%,说明我国 目前对存储芯片的需求最大。随着云计算、AI等行业的发展,ASIC、 FPGA和CPU、GPU等逻辑电路的应用越来越广泛,加上传统逻辑门元件在电路中稳固的需求,使得逻辑电路份额已经占据市场总量的1/4以上。模拟电路包括通信、电源管理、显示等多种模块,是物联网、通信行业的必备元件,其份额随着应用场景的丰富和通信设备的更新持续攀升。

国内逻辑芯片发展速度较为缓慢,除了在移动端CPU领域有一定的突破之外,其他领域的发展都与世界顶尖公司存在差距。同时,我国的研发大都局限在应用端,涉及底层架构、颠覆性创新的成果较少。

CPU的中文名称是中央处理器,是负责信息处理、程序运行的执行元件。按照架构和性能的不同被广泛应用在个人计算机、移动电子设备、游戏机、路由器、激光打印机等设备上。目前,部分机构将CPU、GPU 等拥有信息处理功能的逻辑芯片归入微处理器类,在本报告中,我们遵从第 一章的分类标准,将其归为逻辑芯片。

CPU指令集是CPU中计算和控制计算机系统所有指令的集合。目前CPU可以分为复杂指令集(CISC) 、简单指令集(RISC)两大类。复杂指令 集主要为X86架构,简单指令集又可以细分为ARM、MIPS、RISC-V、 Power PC、Alpha架构,其中生态较为完善的是ARM架构,基本占据简 单指令集九成的市场。我国厂商在架构底层指令集和IP的设计上较为落 后,因此多采用IP授权或指令集授权的方式开发CPU产品。近年来,基于ARM架构和RISC-V开源架构设计的CPU越来越多,生态逐渐丰富,也为国内企业提供了许多机会。

GPU芯片最初的应用是处理图形数据,与CPU相比,其并行处理的能力更加强大。在个人计算机中,CPU、GPU和主板往往是决定机器性能的重要元件。据Jon Peddie Research数据,在过去不久的2020年第四季度,个人计算机GPU市场占有率呈现Intel一骑绝尘的现象,份额由上一季度的62%提升到69%,AMD、Nvidia瓜分剩下的市场,份额分别为17%和15%。这一领域,国内还没有企业能够切分这块规模可观的蛋糕。

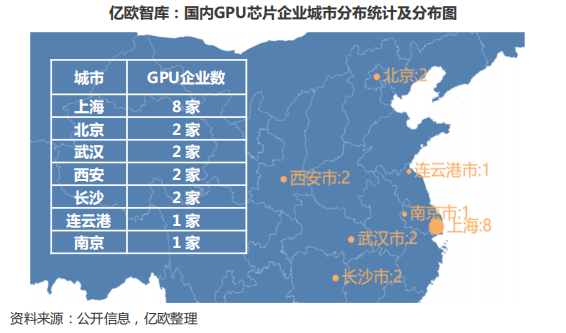

在时下热门的人工智能行业,以Nvidia等公司推出的通用GPU为核心搭 建深度学习训练平台是业内主流,由于GPU是一款通用芯片,同时被个 人消费者和企业消费者以多种目的采买,2020年至今,市场上Nvidia推 出的几款高端GPU芯片出现了长达数月的缺货和价格暴涨现象。世界上头部三家GPU设计公司Nvidia、AMD和Intel长期占领AI商用计算和民用市场的绝大部分份额,还有多家公司提供GPU IP;相比之下,截至2021年3月,国内GPU相关领域的企业或机构仅有18家,其中上市公司3家, 且部分公司至今未有产品面市。

从区域分布来看,内地GPU企业近半数分布在上海,而上海的GPU设计企业基本都位于张江高科技园区;3家上市公司分别为景嘉微、航锦科技和中船重工,其中两家的GPU设计业务在长沙,中船重工709所位于武 汉、716所位于连云港。总体上,GPU设计企业的分布集中于长江中下游,长沙市布局较早,产业自我造血能力基本实现;上海聚集了最多的 新设立企业,全部为独角兽企业,资本活跃度高。

FPGA的中文名称是现场可编程逻辑门阵列,是一种可以对电路功能进行编程定义的半定制电路。由于其可以无限次编程的特点,FPGA具有开发 时间短、延迟低、能耗低的优点,被广泛应用在视频图像处理、通信、数字系统模数转换、嵌入式系统等行业。由于FPGA的可编程性,其在人工智能行业也有一定的应用,虽然单块FPGA的计算能力没有GPU强大,但设计者可以很方便地将通用结构的FPGA芯片构造成一个规模宏大的并行的计算结构,满足应用需求。

MRFR预计2025年全球FPGA市场规模达125.21亿美元,相较于CPU、 GPU千亿美元的市场规模来说显得微不足道,但2019-2025年实现10.43%的复合增速,增长显著且稳健。据Gartner统计,2019年中国FPGA市场规模为176亿元,预计到2023年中国FPGA市场规模将接近460亿元,增长远高于世界水平。

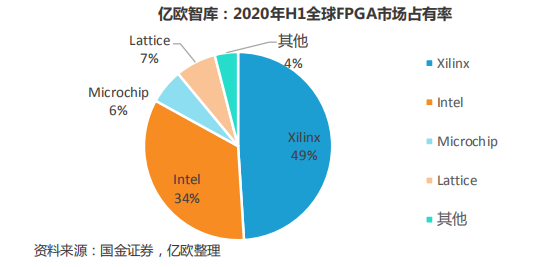

从供应厂商角度看,全球市场主要被美国Xilinx、Intel两家企业垄断,市占率分别为49%和34%;国内FPGA市场国产率低于1%。在先进FPGA 芯片领域,我国企业的产品与美国企业的产品还存在代差。报告基于2020年一级市场投资事件及行业内上市、冲刺上市公司,选取了部分行业翘楚,对其业务和投融资动态进行梳理。

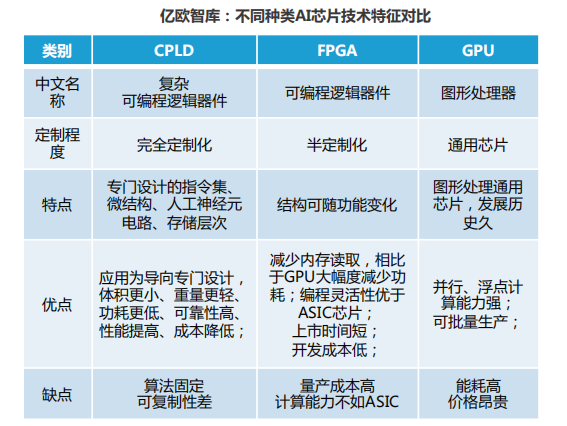

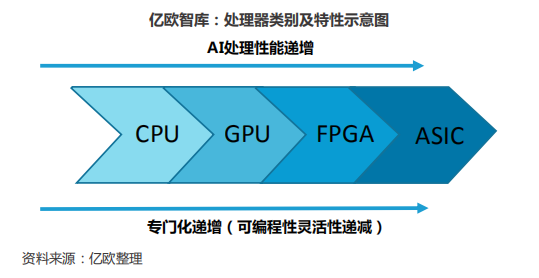

除了前文介绍的CPU、GPU、FPGA之外,目前国内最受一级市场资本关 注的当属人工智能芯片企业。随着人工智能技术在产业中的应用愈发多元化,AI芯片的使用也逐渐向着专用芯片面向应用端,通用芯片组建算力云平台的趋势发展。目前常见的AI芯片基本可以分为复杂可编程逻辑器件(CPLD)、可编程逻辑器件(FPGA)、图形处理器(GPU)。被广泛提起的ASIC芯片,中文为“专用集成电路”,通常主要是以CPLD或FPGA进行流片形成固定功能的芯片,本报告中不再专门区分ASIC与 CPLD概念,以便于梳理和阅读。

按照任务划分,AI芯片可以分为训练芯片和推理芯片;训练芯片用于完 成深度学习大数据量的运算,对芯片的算力、精度和通用性要求较高;推理芯片进行的是对成熟模型算法的一种执行,不需要进行大量的运算和过高的精度,对能耗、成本等大规模应用层面的考量更多。

目前业内比较常用的训练芯片是CPU与GPU或FPGA等协同的异构运算组 合,我国企业在这三种芯片的设计水平都与行业前列有较大的差距。目 前只有华为海思、寒武纪、天数智芯、燧原科技等企业在云端推理芯片有产品推出,涵盖ASIC、GPGPU等多种芯片。

由于起步时间较晚,我国在GPU和FPGA芯片领域都处于追赶行业发展的进程中。因此发展用途较为单一、开发难度较小的ASIC芯片,把计算单一化,在一个方向上专精可以使我们在人工智能计算领域实现弯道超车。

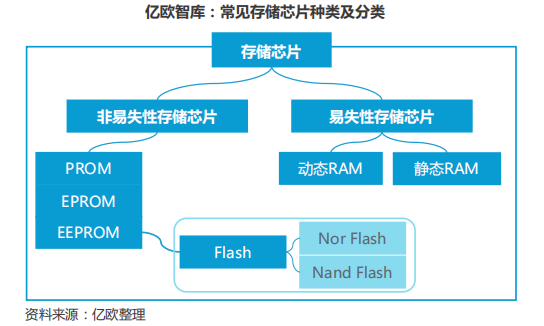

存储芯片的设计和制造是我国芯片领域最为薄弱的环节之一,除了在市场占有率5%左右的Flash闪存芯片中拥有少数企业布局之外,其他常见 的存储芯片基本都由三星、东芝、美光等老牌存储芯片企业垄断。存储芯片由其读写特性可以分为只读存储器和随机读写存储器;根据其断电后数据是否丢失又可分为易失性存储芯片和非易失性存储芯片。通常来说,行业内公认的易失性存储芯片包括静态存储器(SRAM)和动 态存储器(DRAM)。其中SRAM的读写速度较快,但制造成本高,通常用作大容量存储器的缓存器;DRAM的读写速度慢,但生产成本比较低,一般用作硬盘、大规模数据存储器等容量较大的主存储器。

非易失性存储芯片基本指的是各种只读存储器(ROM),其发展大致经 历了只读存储器(ROM)、可编程ROM(PROM)、可擦除可编程 ROM(EPROM)和电子擦除可编程ROM(EEPROM)。Flash存储器比较特殊,是一种可以快速读取数据的电子可擦除存储器,其具有ROM和RAM两种存储器的优点,可以利用专用程序擦除数据,断电后数据也 不易丢失。

Flash存储芯片还可以继续细分为两个类别,Nor Flash和Nand Flash。Nor Flash可以让应用程序在其中运行,不需要将代码读取入RAM,同时Nor Flash的传输效率比较高,但是写入和擦除速度较低;NandFlash的容量较大,改写速度较快,因此常常被用作U盘、小型移动电子设备的存储器。

综合来说,我国存储芯片的发展水平还较为落后,设计行业呈现NOR Flash单点突破,Nand Flash、DRAM仍然存在较大困难的阶段;生产制造处于产能提升过程中,即将达到规模化生产。在未来一段时间内,抓住全球芯片短缺、价格上涨的机遇,运用目前性价比高的产品抢占更 多市场;加速新一代Nand Flash和DRAM芯片研发,同时有计划地根据未来需求扩大产能,逐步实现DRAM芯片的国产化替代。

转载申明:转载本号文章请注明作者和来源,本号发布文章若存在版权等问题,请留言联系处理,谢谢。

推荐阅读

更多架构相关技术知识总结请参考“架构师全店铺技术资料打包”相关电子书(37本技术资料打包汇总详情可通过“阅读原文”获取)。

全店内容持续更新,现下单“全店铺技术资料打包(全)”,后续可享全店内容更新“免费”赠阅,价格仅收198元(原总价350元)。

温馨提示:

扫描二维码关注公众号,点击阅读原文链接获取“架构师技术全店资料打包汇总(全)”电子书资料详情。