从数据集到2D和3D方法,一文概览目标检测领域进展

小白学视觉

共 5606字,需浏览 12分钟

·

2021-05-30 01:48

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文转自:深度学习这件小事

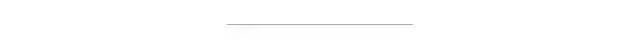

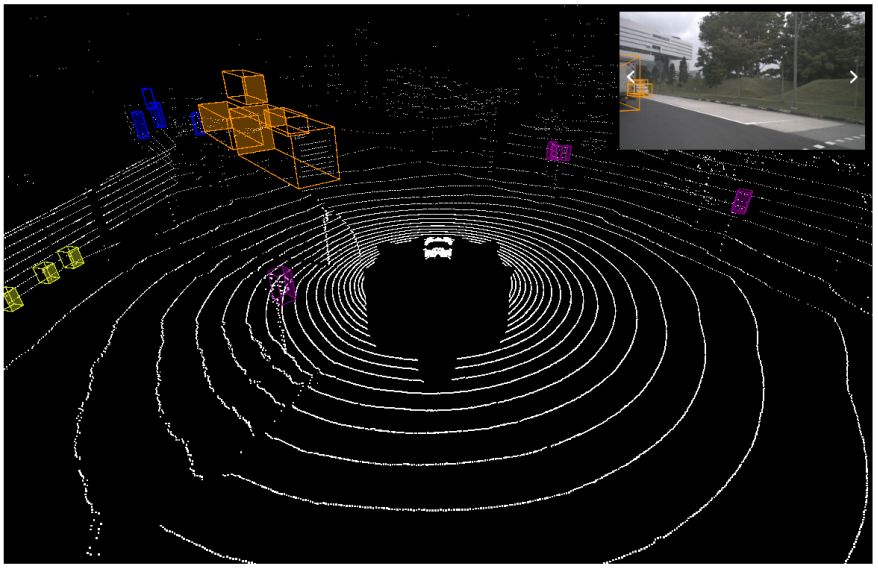

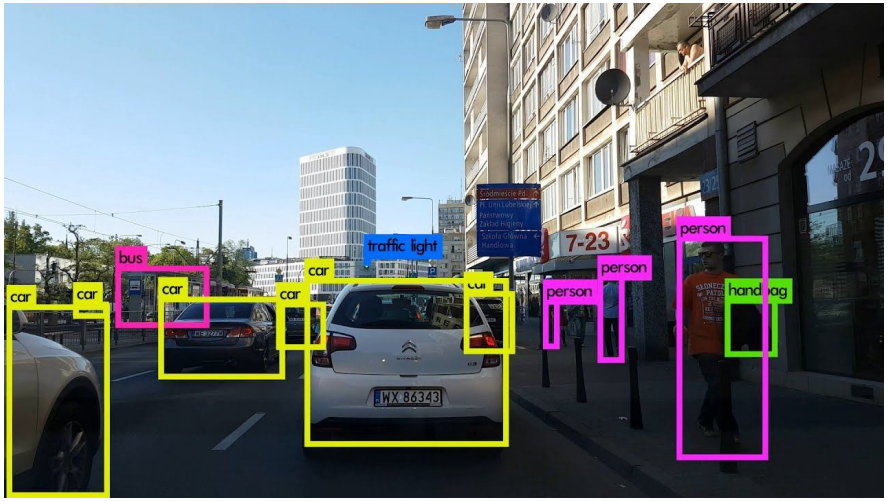

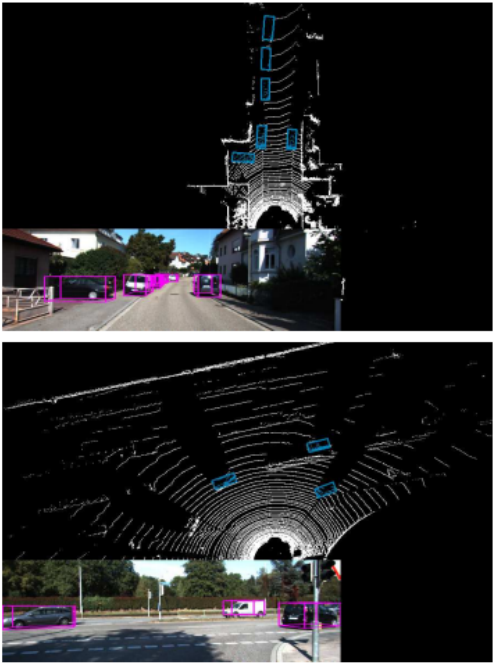

目标检测一直是计算机视觉领域中一大难题。近日,来自阿尔伯塔大学的研究者对目标检测领域的近期发展进行了综述,涵盖常见数据格式和数据集、2D 目标检测方法和 3D 目标检测方法。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

评论