[开源项目]基于FPGA的视频图像拼接融合

点击下方卡片,关注“新机器视觉”公众号

重磅干货,第一时间送达

基于FPGA的视频图像拼接融合

本项目简单来说,就是实时生成视频全景图,该架构经过优化,可以实时视频输出。

算法

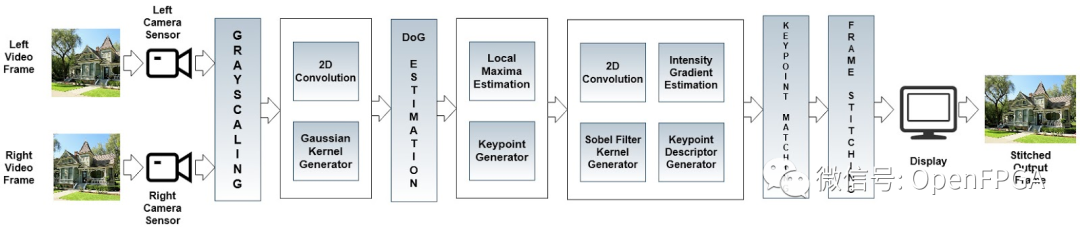

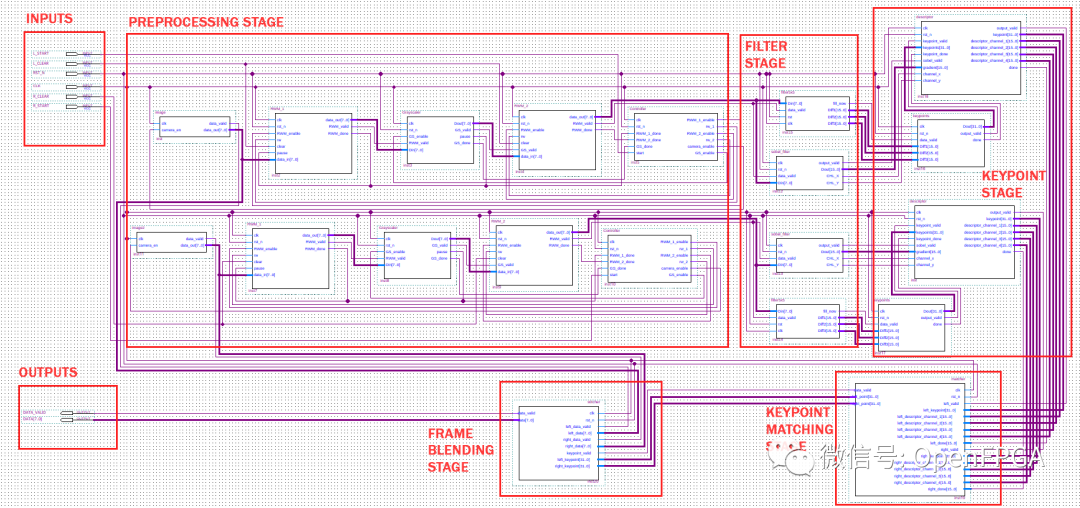

下图说明了描述算法每个步骤的系统框图

该系统大致可以分为三个子系统:

预处理

基于 SIFT 的特征提取

框架拼接融合

预处理

系统的输入视频流为 8 位 RGB 格式。输入的 8 位图像如下图所示。

视频流的每个单独帧将具有对应于红色、绿色和蓝色的三个通道。视频帧中的颜色信息不会增强特征检测。此外,与单通道 8 位图像相比,3 通道 8 位图像的计算需要更多时间。因此,RGB 视频帧被转换为 8 位灰度图像。生成的灰度图像噪声更小,阴影细节更多,计算效率更高,如下图所示。

基于SIFT的特征提取

使用SIFT算法从灰度图像中提取特征。SIFT算法可以分为两个主要步骤:

关键点检测

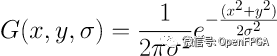

SIFT 操作从输入图像与不同高斯滤波器的离散卷积开始。高斯滤波器是一种广泛使用的图像平滑算法,定义为:

上式中,G为(x,y)点的高斯核,σ为高斯参数。使用较大的 σ 值会对图像产生更大的平滑效果。图像与高斯核的离散卷积生成具有较少噪声和较少细节的图像。在 SIFT 中,高斯核的离散卷积是用四个不同的 σ 值完成的。逐渐增大的 σ 值用于生成一组模糊图像或八度音阶(意思频率减半,低频部分对应灰度图中变化平缓的部分,高频部分对应灰度图中变化剧烈的部分)。

对于给定的 σ 值,卷积核中所有系数的总和应该等于 1。因此,核的大小随着 σ 值的增加而增加。

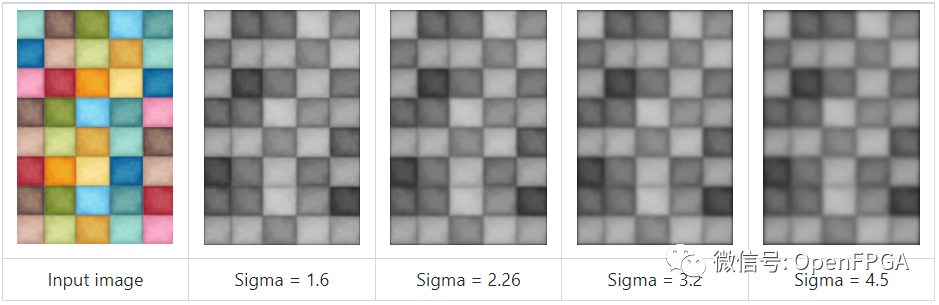

一旦生成了八度音阶,就会根据八度音阶中的四个图像构建一个 DoG 空间。DoG 代表高斯差分。DoG 是高斯拉普拉斯算子 (LoG) 的计算效率非常高的近似值。DoG 空间是通过逐像素计算两个相邻高斯尺度图像之间的差异来构建的。八度音阶中四个图像的DoG空间将具有三个级别。

通过查找局部最大值或最小值,从 DoG 空间中提取关键点。如果一个像素是由顶层 9 个像素、中间层 8 个像素和底层 9 个像素组成的 26 像素邻域内的局部最大值或最小值,则该像素被认为是关键点。

描述符生成

关键点描述符是特定关键点的唯一标识符。SIFT 使用关键点的梯度幅度和方向作为描述符的基础。一个点的梯度大小和方向可以通过图像与 Sobel 滤波器的离散卷积来计算。

为了生成关键点描述符,计算每个关键点周围 16x16 窗口内每个点的梯度幅度和方向。16x16 窗口的梯度幅度与高斯核卷积。将每个 4x4 单元格中的梯度幅度组合起来,使 16x16 窗口减少到 4x4 窗口和 16 个梯度方向。最后,这 16 个梯度方向被转移到 8 个 bin 中。因此,构建了一个 128 个元素的向量,作为关键点描述符。

框架拼接融合

框架拼接是将两个帧组合成单个图像的过程。框架拼接分两步完成:

关键点匹配

比较来自两个相机传感器的视频帧中关键点的关键点描述符。如果两个关键点(每个相机传感器一个)的关键点描述符之间的差异低于误差阈值,则将它们视为关键点对。将它们的关键点描述符之间差异最小的关键点对作为参考关键点。

图像融合

加权平均方法用于将两个帧混合成单个图像。重叠区域的像素值等于两帧像素的加权平均值。根据重叠像素和相应帧的边界之间的距离选择权重。

FPGA程序顶层设计

顶层架构的框图如下图所示。

顶层设计分为五个阶段:

预处理阶段

为了模拟相机传感器的工作,使用了 image.v 和 image2.v,它们分别输入对应于左和右相机传感器的图像。RWM_1.v 是一个读写存储器,用于存储 8 位 RGB 图像。WRITE 模式时,RGB 图像像素数据写入内存。存储完所有像素值后,将存储器置于 READ 模式。在 READ 模式下,每个像素值从内存中顺序读取.

过滤阶段

关键点阶段

关键点匹配阶段

帧混合阶段

项目地址

https://github.com/AugustinJose1221/FPGA-Build

https://github.com/AugustinJose1221/Video-Stitching

来源:OpenFPGA

本文仅做学术分享,如有侵权,请联系删文。