1000层transformer横空出世!

点蓝色字关注“机器学习算法工程师”

点蓝色字关注“机器学习算法工程师”

设为星标,干货直达!

转自新智元公众号

编辑:David 拉燕

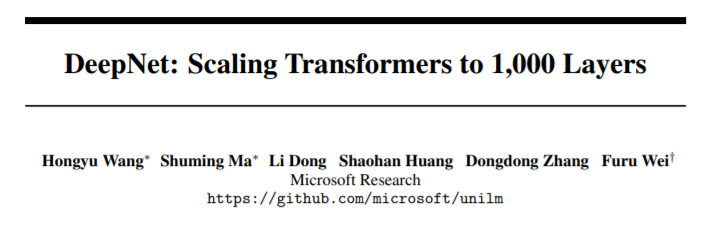

【导读】近日,微软研究院的研究人员搞出了一个1000层的Transformer,在多语种机器翻译任务上刷新多项SOTA

论文链接:https://arxiv.org/abs/2203.00555

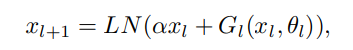

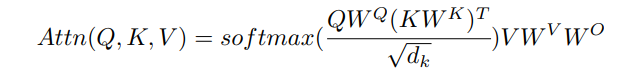

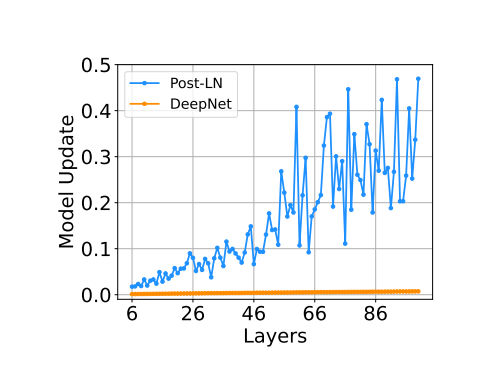

超深的Transformer:DEEPNET

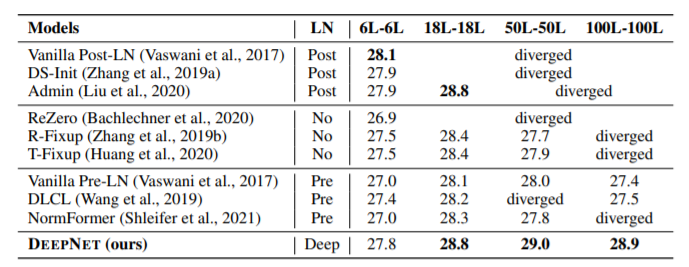

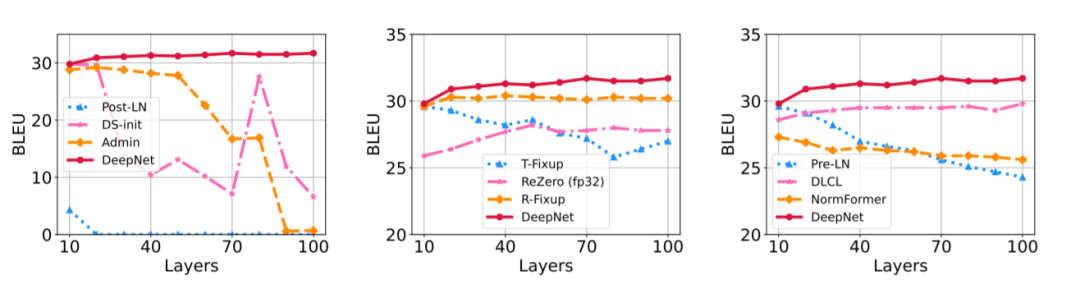

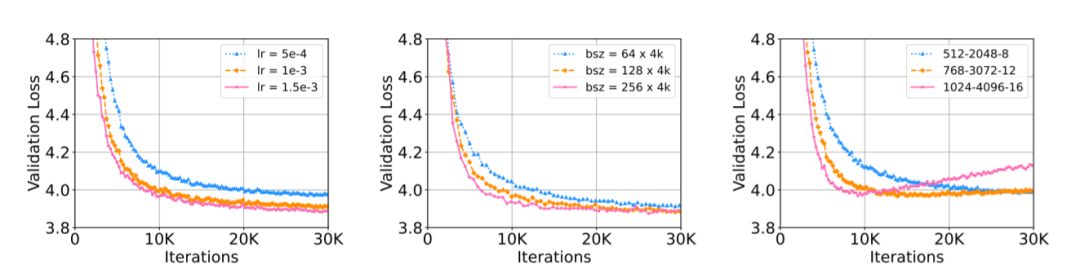

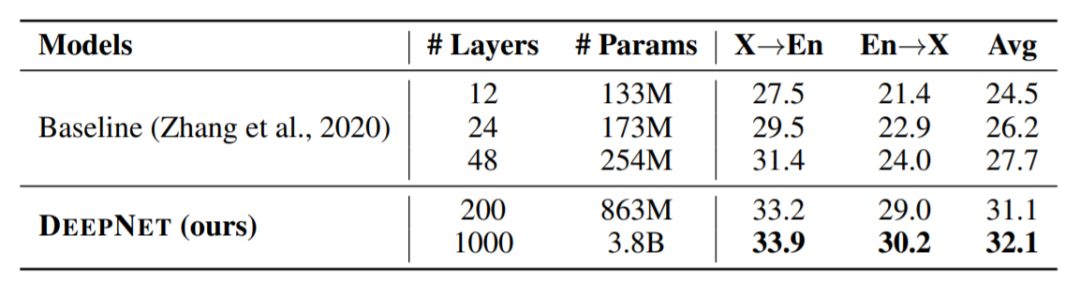

性能:1000层网络,显著提升NMT表现

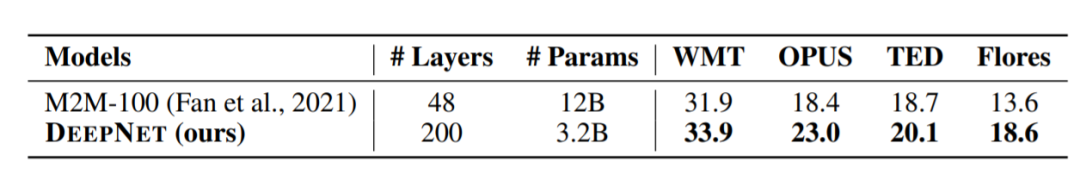

大规模多语言神经机器翻译

参考链接:

https://arxiv.org/abs/2203.00555

推荐阅读

辅助模块加速收敛,精度大幅提升!移动端实时的NanoDet-Plus来了!

机器学习算法工程师

一个用心的公众号

评论