电影荒吗?教你爬取豆瓣电影top250

点击上方蓝字关注我们

爬虫目标

项目准备

软件:Pycharm

第三方库:requests,parsel,pandas,lxml,os

网站地址:https://movie.douban.com/top250?start=

网站分析

网站首页如下:

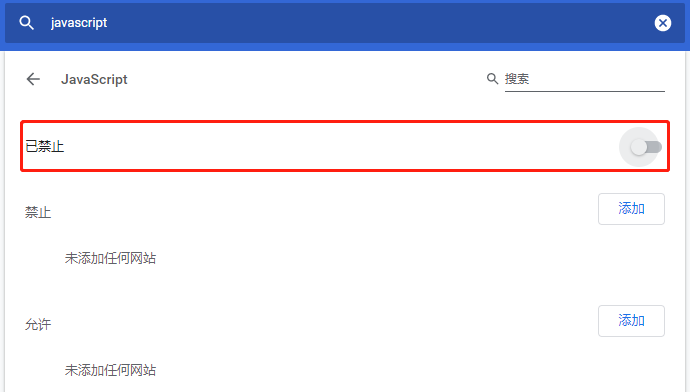

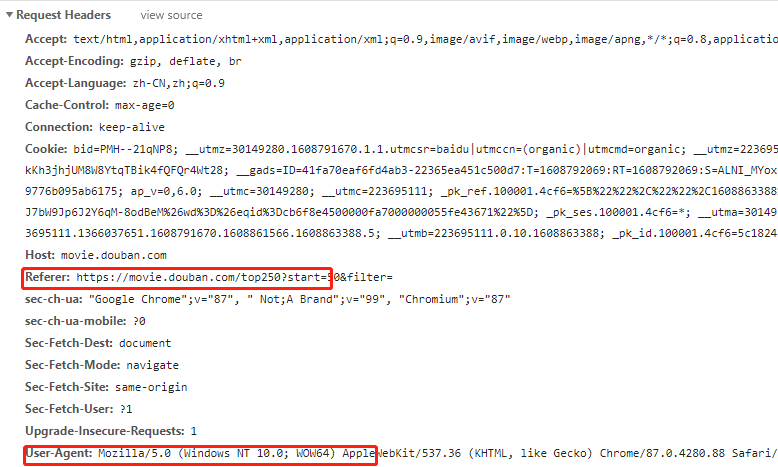

反爬分析

链接分析

第一页:https://movie.douban.com/top250?start=第二页:https://movie.douban.com/top250?start=25&filter=第三页:https://movie.douban.com/top250?start=50&filter=

可以发现,每页的电影信息会随着网站链接末尾数字变化而变化。

代码实现

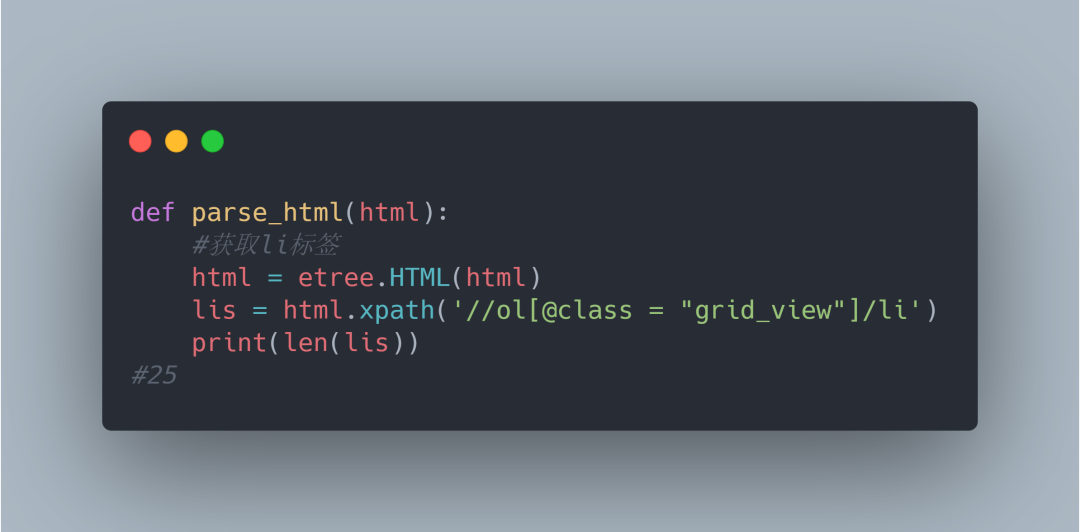

1.获取网页源码信息

25部电影信息打印如下:

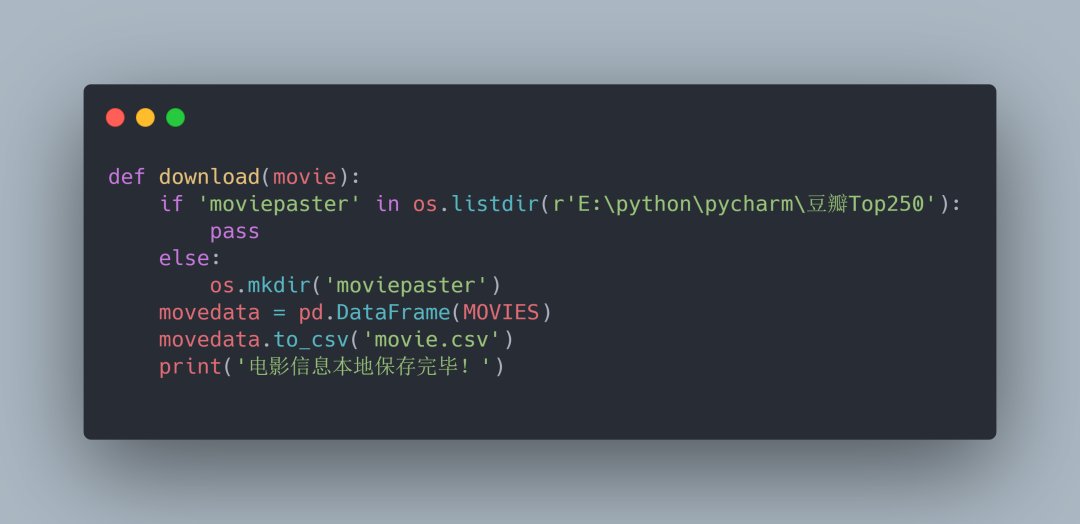

数据保存

数据保存我们需要用到pandas,首先我们导入

import pandas as pd

效果展示

csv文件如下:

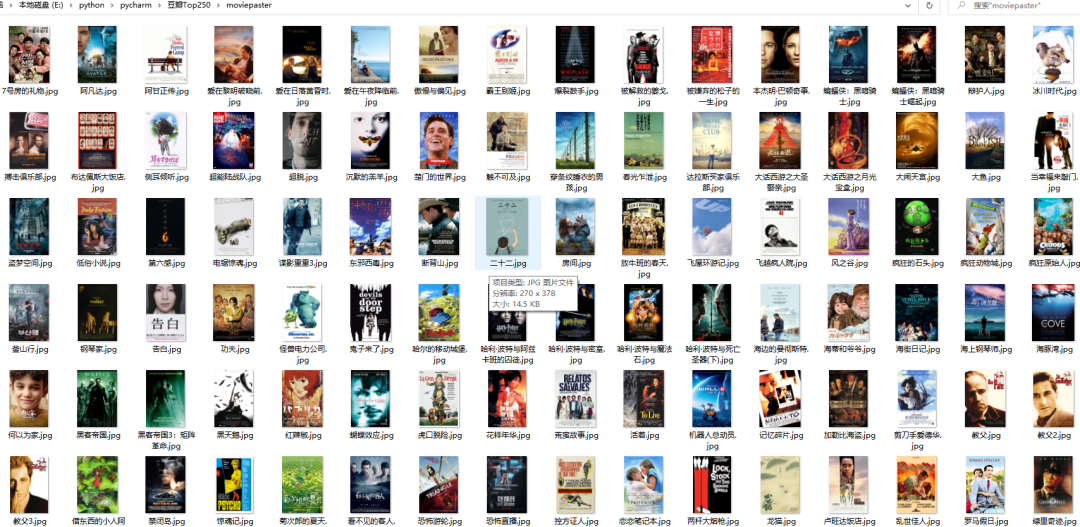

图片文件如下:

想要学习或者对源码有兴趣的小伙伴扫码回复'电影'即可

扫描二维码

获取更多精彩

python学前班

回复下方 「关键词」,获取优质资源

回复关键词 「linux」,即可获取 185 页 Linux 工具快速教程手册和154页的Linux笔记。

回复关键词 「Python进阶」,即可获取 106 页 Python 进阶文档 PDF

回复关键词 「Python面试题」,即可获取最新 100道 面试题 PDF

回复关键词 「python数据分析」,即可获取47页python数据分析与自然语言处理的 PDF

回复关键词 「python爬虫」,满满五份PPT爬虫教程和70多个案例

回复关键词 「Python最强基础学习文档」,即可获取 168 页 Python 最强基础学习文档 PDF,让你快速入门Python

推荐我的微信号

来围观我的朋友圈,我的经验分享,技术更新,不定期送书,坑位有限,速速扫码添加!

备注:开发方向_昵称_城市,另送你10本Python电子书。

点个在看你最好看

评论