GPT-4 被曝“变蠢”!为了降本,OpenAI 偷偷搞“小动作”?

“你们有没有觉得,最近GPT-4的质量有所下降?”

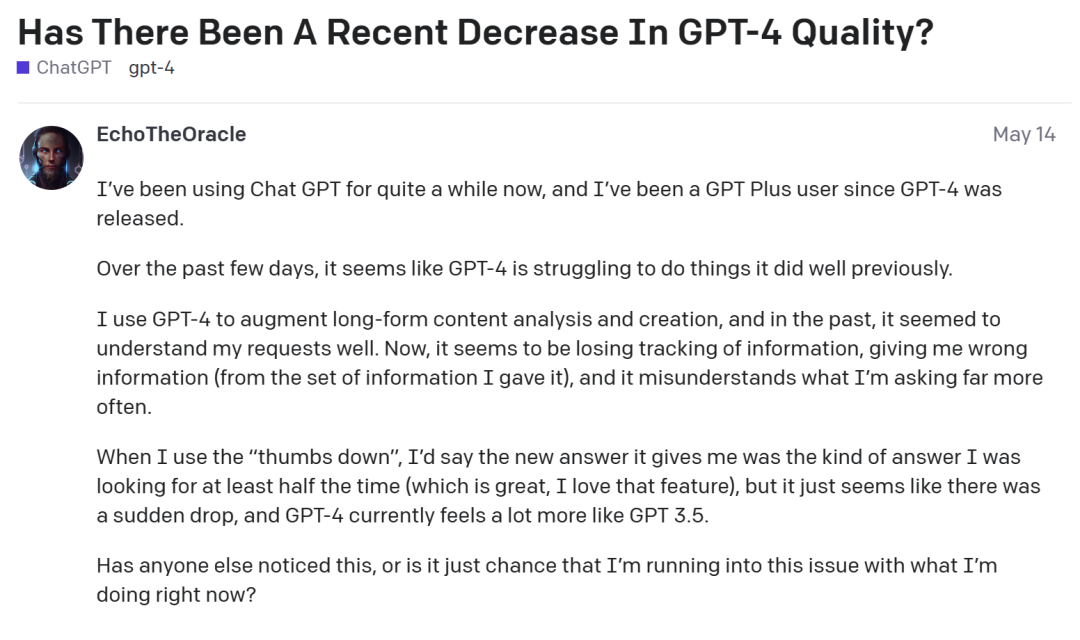

早在今年5月中旬开始,就有GPT-4用户在OpenAI的在线开发者论坛中发帖,表示GPT-4好像开始“变蠢”了:

“我使用ChatGPT已经有一段时间了,自GPT-4发布后,我就成为了GPT Plus用户。我一般会用GPT-4来助力长篇内容的分析和创作。过去,GPT-4似乎能很好地理解我的要求。但现在,它似乎失去了对信息的跟踪,给了我很多错误的信息,误解我要求的情况也越来越多……目前,GPT-4感觉更像GPT-3.5。

有没有其他人注意到这一点,还是说只有我偶然遇到了这个问题?”

事实证明,这位GPT-4用户并不是一个人——该帖下,许多用户都留言称:“我也很有同感!”

01

问题百出的新版GPT-4

根据许多使用者的反馈,GPT-4除了在长篇内容的分析和创作上表现有所退步,在写作质量上也有所下滑。

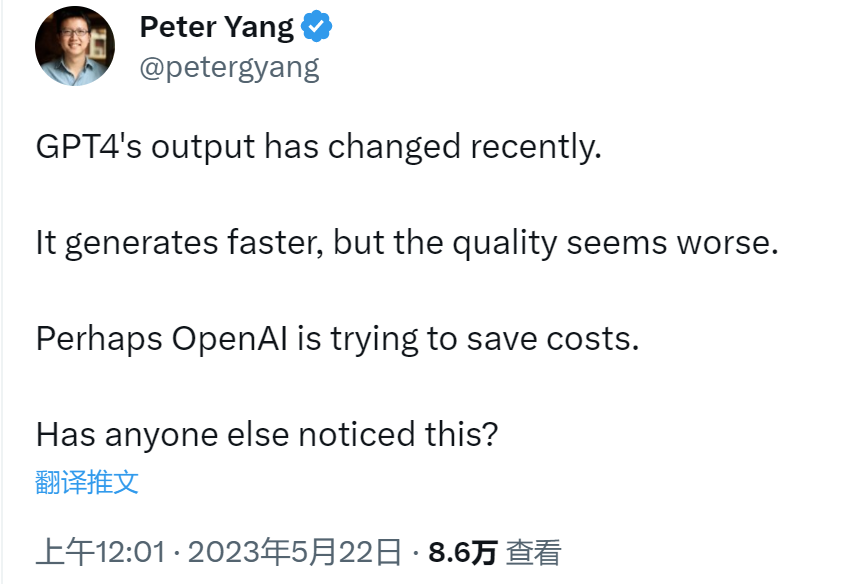

Roblox 的产品负责人Peter Yang在推特上表示,GPT-4模型的输出更快了,但质量变差了:“只是简单的问题,例如让写作更清晰简洁并提供想法……在我看来,写作质量下降了。”

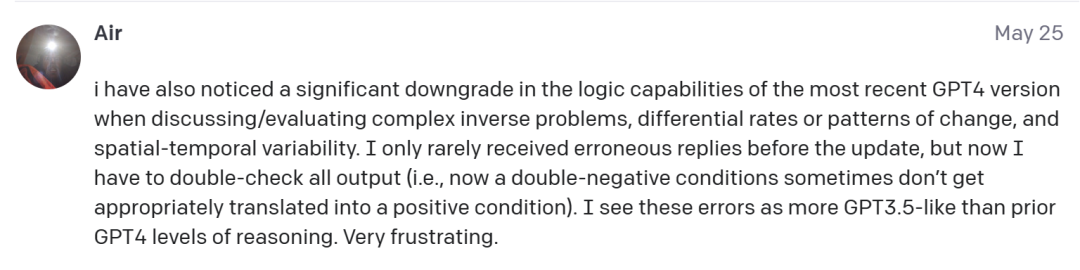

在讨论/评估复杂的逆问题、不同的变化率或变化模式以及时空变异性时,最新版 GPT-4 的逻辑能力明显下降。

“在 GPT-4 更新之前,我很少收到错误的回复,但现在我必须仔细检查所有输出(即,现在双重否定条件有时不能适当地转换为肯定条件)。我认为这些错误更类似于 GPT-3.5,而不是之前的 GPT-4 推理水平。”

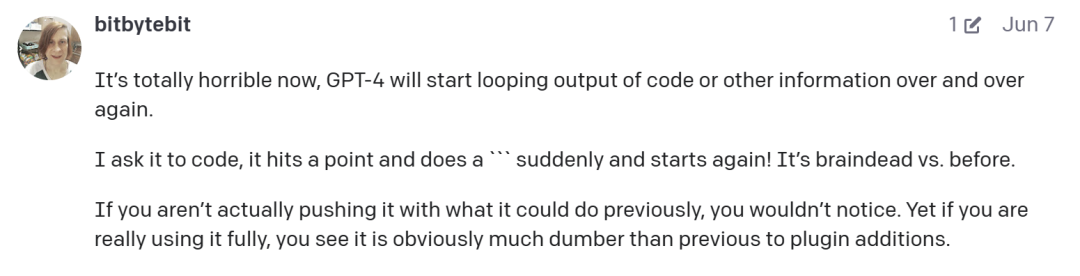

甚至在编码能力上,新版GPT-4的输出质量也不如以往。

一位用GPT-4为网站编写功能代码的开发者抱怨:“目前的GPT-4很令人失望。这就像开了一辆法拉利一个月,然后突然变成了一辆破旧的皮卡,我不确定我是否会愿意继续为此付费。”

另一位开发者也提到现在的GPT-4会循环输出代码:“完全糟透了,GPT-4开始一遍又一遍地循环输出代码或其他信息。我让它写代码,它写到一个点,突然来个"````",然后又开始!和以前相比,它现在简直就是个白痴。”

除此之外,在推特和OpenAI的在线开发者论坛中,也不断有用户反映新版GPT-4逻辑弱化、产生很多错误响应、无法跟踪提供的信息、不遵循说明要求、忘记在基本软件代码中添加括号、只记住最近的提示等种种问题。

对于GPT-4突然“降智”的表现,有用户提出猜测:“当前版本感觉跟刚推出时的版本大不相同,我猜OpenAI为了容纳更多客户选择在质量上妥协!”

如此看来,如今用户对于GPT-4的评价确实比不上它刚出道时的“风评”巅峰期。

02

GPT-4变快了,却也变“蠢”了

去年年底基于GPT-3.5的ChatGPT横空出世,其卓越的生成能力掀起了一股AIGC热潮,因此今年3月OpenAI公布比GPT-3.5更强大的GPT-4时,全世界都为之惊叹。

当时,GPT-4被称之为“史上最强大的 AI 模型”,尤其多模态的特点,意味着它既能理解图像,也能理解文字输入,于是迅速成为了开发人员和其他技术业内人士的首选模型,也产生了更多对GPT-4的赞誉:10秒生成一个网站、通过最难美国法考、满分通过MIT本科数学考试……

不过在人们惊叹于GPT-4的强大之时,其产生的费用及响应速度也令不少人感到震惊。对此,Lamini(一家帮助开发者建立定制大型语言模型的初创公司)的首席执行官Sharon Zhou表示:“GPT-4虽然速度慢,但非常准确。"

一直到5月份,GPT-4还一直保持着“又慢又贵但很准确”的状态——后来,GPT-4响应变快了,与此同时用户对其性能下降的质疑也爆发了。

对于这个现象,包括Sharon Zhou在内的几位AI专家认为:OpenAI可能正在创建几个较小的GPT-4模型,这些模型的作用与大型模型类似,但运行成本较低。

03

专家推测:或许与MoE技术有关

根据Sharon Zhou的介绍,这种方法被称为Mixture-of-Experts(MoE),即混合专家系统。MoE 技术是在神经网络领域发展起来的一种集成学习技术,也是目前训练万亿参数量级模型的关键技术——由于现阶段模型规模越来越大,导致训练的开销也日益增长,而MoE技术可以动态激活部分神经网络,从而实现在不增加计算量的前提下大幅度增加模型参数量。

具体来说,MoE会将预测建模任务分解为若干子任务,在每个子任务上训练一个专家模型(Expert Model),并开发一个门控模型(Gating Model),该模型可根据要预测的输入来学习信任哪个专家,并组合预测结果。

那么MoE技术引用到GPT-4是什么情况呢?Sharon Zhou解释道,在GPT-4中这些小型专家模型会针对不同的任务和主题领域进行训练,例如可以有针对生物、物理、化学等方面的小型GPT-4专家模型,那么当用户向GPT-4提出问题时,新系统就会知道要把这个问题发送给哪个专家模型。另外,为了以防万一,新系统可能会向两个或更多的专家模型发送查询,然后将结果混在一起。

对于这个做法,Sharon Zhou的形容是“忒修斯之船”(一种有关身份更替的悖论,假定某物体的构成要素被置换后,但它依旧是原来的物体吗?),即随着时间的推移,OpenAI会把GPT-4的各个部分替换掉:“OpenAI 正在将GPT-4变成一支小型舰队。”

基于以上推测,Sharon Zhou认为近来GPT-4“变蠢”的言论,很可能就与MoE这种训练方式有关:“当用户测试 GPT-4时,我们会问很多不同的问题,而规模较小的GPT-4专家模型不会做得那么好,但它正在收集我们的数据,它会改进和学习。”

04

GPT-4 架构曝光?

由于用户对于GPT-4“变蠢”的反馈越来越多,本周几位AI专家也发布了所谓的“GPT-4架构细节”。

其中,一位名为Yam Peleg的推特博主表示,GPT-4有大约1.8万亿个参数,横跨120层,比GPT-3大10倍以上,在约 13T token上进行训练,训练成本约为6300万美元……值得一提的是,Yam Peleg也表示OpenAI在采用MoE,即通过使用16个混合专家模型来降低GPT-4运行的成本。

截至目前,OpenAI方面并没有对这一说法做出回应。不过 Allen人工智能研究所的创始首席执行官Oren Etzioni向媒体表示:“虽然我也没得到证实,但我认为这些猜测应该大致正确。

他解释道,一般使用MOE方法有两种原因:要么想要生成更好的响应,要么想要更便宜、更快的响应。

“理想情况下MOE会让你同时获得这两方面的优势,但现实中通常需要在成本和质量之间做出权衡。”基于此,Oren Etzioni认为结合现在的情况来看,OpenAI似乎为了降低GPT-4的成本而牺牲了一些质量。

那么对于这件事,你的看法又是什么呢?

欢迎你加入我的「一起玩转ChatGPT」,赠送国内手机可以免费玩的GPT,并且带着大家一起探索ChatGPT和新的AI时代。

现在星球在运营初期,正式运营价格定为599,目前早鸟价149,额外给了50元优惠券,到手99(再送一本价值99.8元的纸质书),星球马上要来一波大的涨价,如果你还在犹豫,可能最后就要以更高价格加入了。

优惠券名额有限,先到先得

简单说下这个星球能给大家提供什么:

1、为你分享ChatGPT最新的玩法&风向标

2、定期邀请嘉宾分享副业变现案例

3、副业精华电子书1份,百位大咖内部分享资料

4、前5000人加入星球的小伙伴,可免费获得ChatGPT“独立”账号一个(账号在加入四天之内发放),还有一个国内直接登录CHATGPT的账号 ,手机电脑都可以登录。

5、前5000人额外福利:送价值99.8元的小码哥的签名新书《Python +Excel/PPT/Word 一本通》或者其他书单的书

6、不断分享如何使用ChatGPT来完成各种任务,让你更高效地使用ChatGPT,以及副业思考、变现思路、创业案例、落地案例分享。

7、分享ChatGPT的使用方法、最新资讯、商业价值。

8、探讨未来关于ChatGPT的机遇,共同成长。

9、帮助大家解决ChatGPT遇到的问题。

10、提供一整年的售后服务,一起搞副业

我们星球也绝对做让大家认可的星球,内容、交付绝对都是行业一流,所以大家大可放心让感兴趣的朋友加入交流!

最后,无论是否加入,后台回复“chatgpt”送您一套ChatGPT入门资料