人工智能|6个可解释AI的Python框架推荐

来源:DeepHub IMBA

本文

约1500

字,建议阅读

5

分钟

本文为你介绍6个用于可解释性的Python框架。

随着人工智能的发展为了解决具有挑战性的问题,人们创造了更复杂、更不透明的模型。AI就像一个黑匣子,能自己做出决定,但是人们并不清楚其中缘由。建立一个AI模型,输入数据,然后再输出结果,但有一个问题就是我们不能解释AI为何会得出这样的结论。需要了解AI如何得出某个结论背后的原因,而不是仅仅接受一个在没有上下文或解释的情况下输出的结果。

可解释性旨在帮助人们理解:

- 如何学习的?

- 学到了什么?

- 针对一个特定输入为什么会做出如此决策?

- 决策是否可靠?

在本文中,我将介绍6个用于可解释性的Python框架。

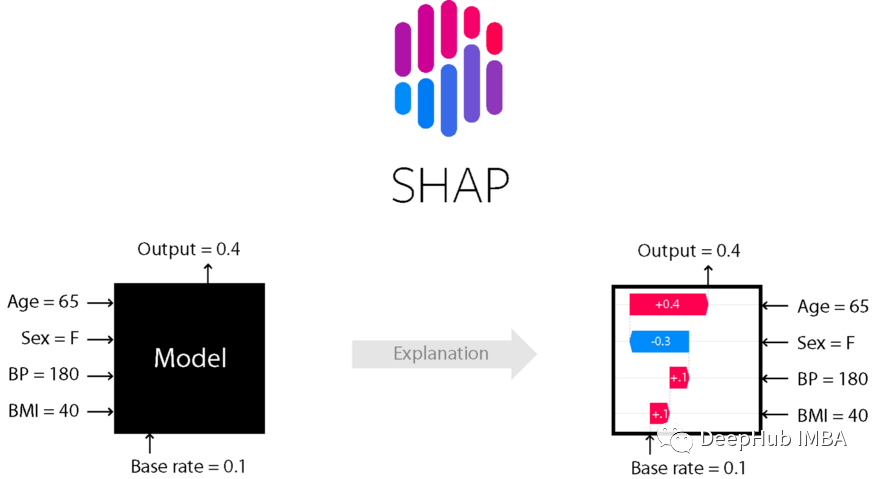

SHAP

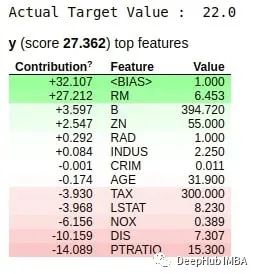

数据集中每个特征对模型预测的贡献由Shapley值解释。Lundberg和Lee的SHAP算法最初发表于2017年,这个算法被社区在许多不同的领域广泛采用。

使用pip或conda安装shap库。

# install with pip

pip install shap

# install with conda

conda install -c conda-forge shap

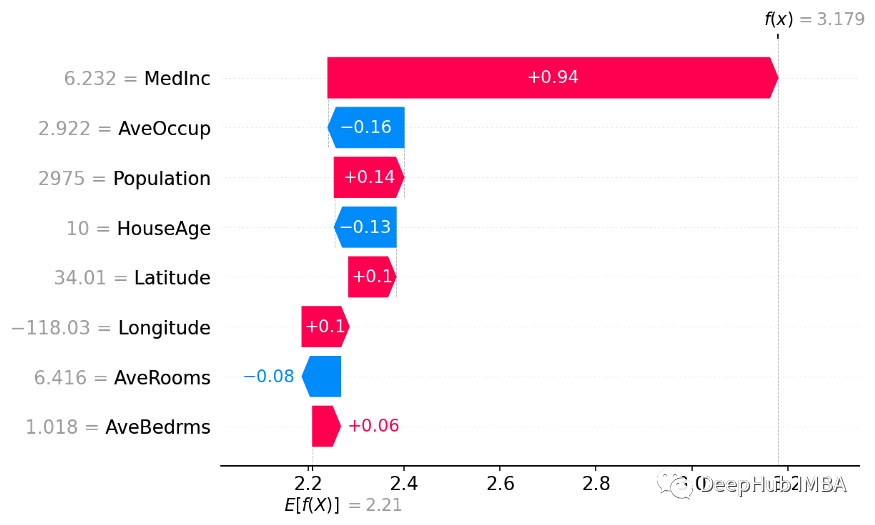

使用Shap库构建瀑布图

使用Shap库构建瀑布图

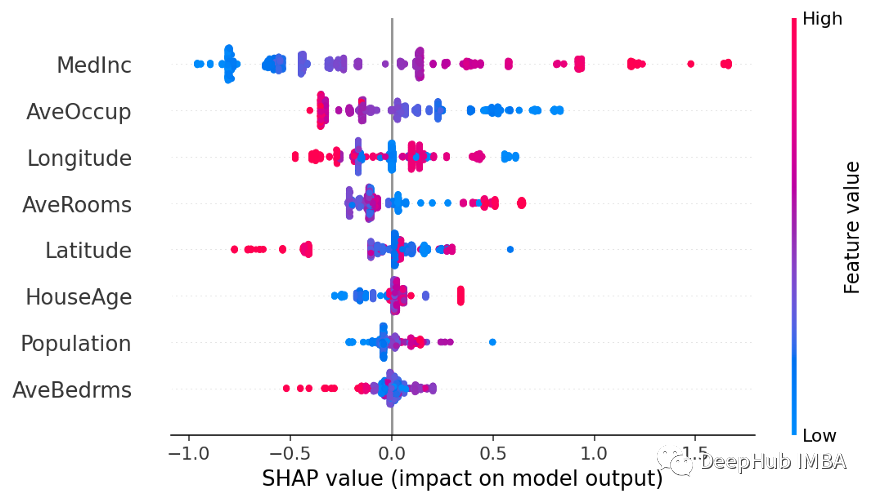

使用Shap库构建Beeswarm图

使用Shap库构建Beeswarm图

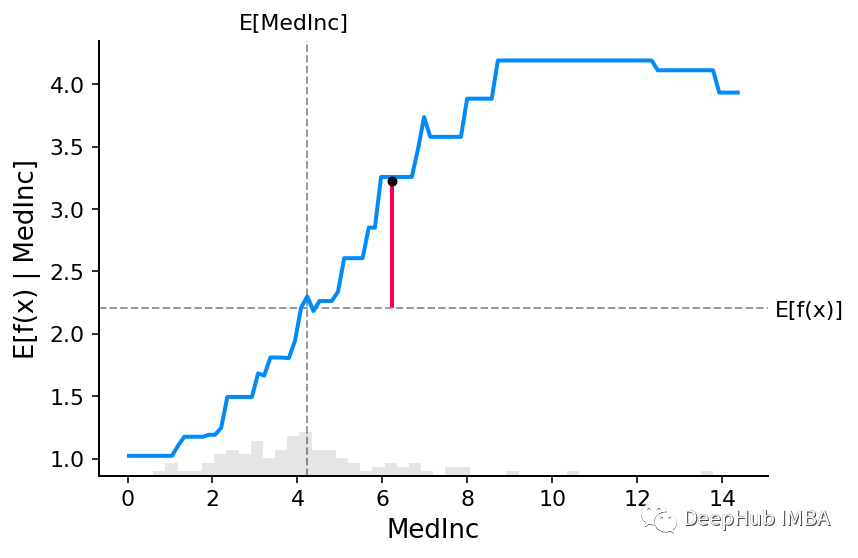

使用Shap库构建部分依赖图

使用Shap库构建部分依赖图

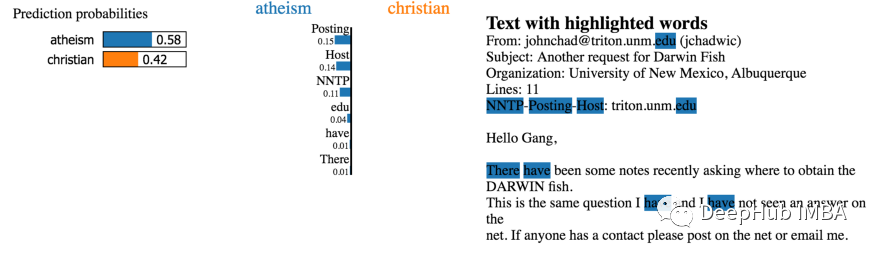

LIME

知道为什么模型会以这种方式进行预测对于调整算法是至关重要的。借助LIME的解释,能够理解为什么模型以这种方式运行。如果模型没有按照计划运行,那么很可能在数据准备阶段就犯了错误。

使用pip安装:

pip install lime

LIME 构建的局部解释图

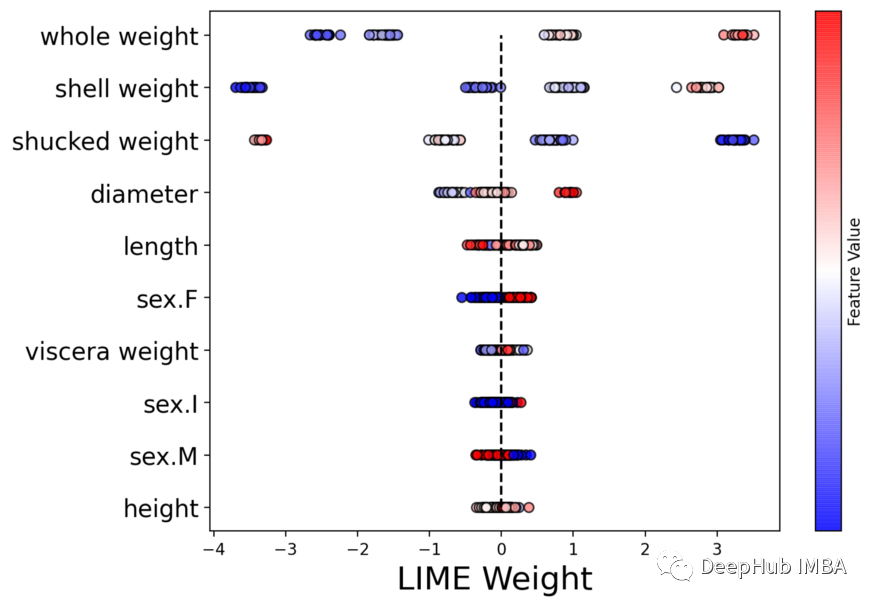

LIME构建的Beeswarm 图

LIME构建的Beeswarm 图

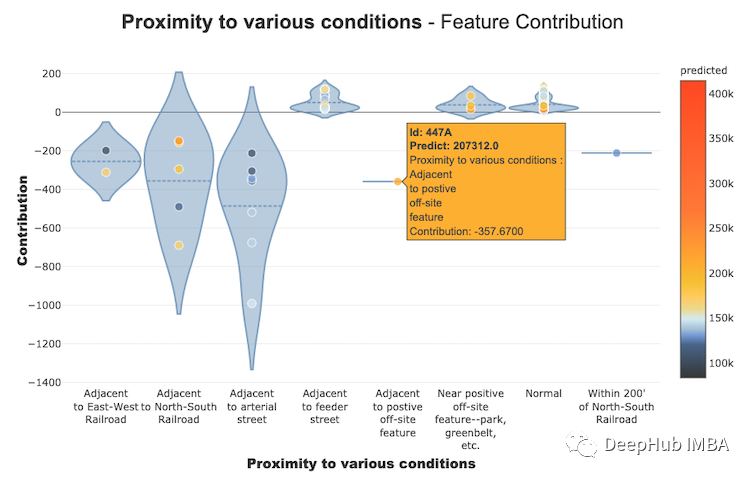

Shapash

为了表达数据中包含故事、见解和模型的发现,互动性和漂亮的图表必不可少。业务和数据科学家/分析师向AI/ML结果展示和互动的最佳方法是将其可视化并且放到web中。Shapash库可以生成交互式仪表盘,并收集了许多可视化图表。与外形/石灰解释性有关。它可以使用SHAP/Lime作为后端,也就是说它只提供了更好看的图表。

使用Shapash构建特征贡献图

使用Shapash构建特征贡献图

使用Shapash库创建的交互式仪表板

使用Shapash库创建的交互式仪表板

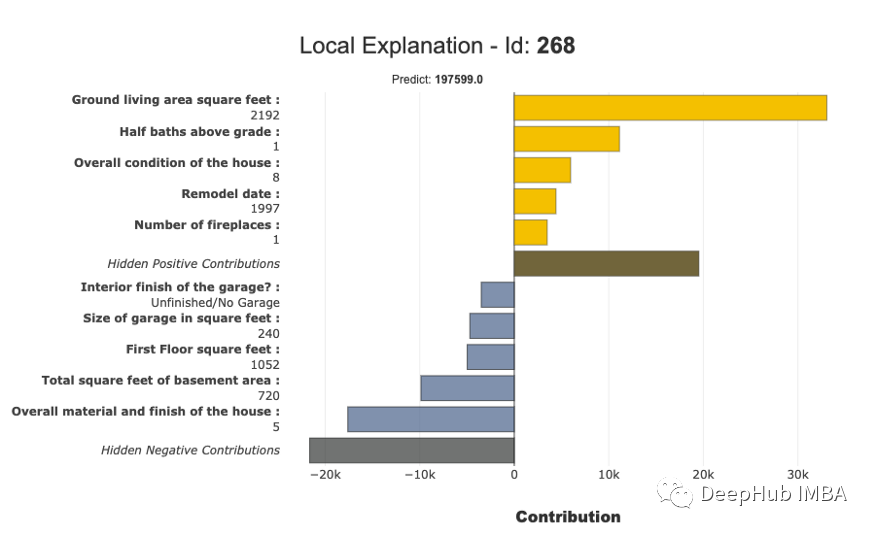

使用Shapash构建的局部解释图

使用Shapash构建的局部解释图

InterpretML

InterpretML展示了两种类型的可解释性:glassbox模型——为可解释性设计的机器学习模型(如:线性模型、规则列表、广义可加模型)和黑箱可解释性技术——用于解释现有系统(如:部分依赖,LIME)。使用统一的API并封装多种方法,拥有内置的、可扩展的可视化平台,该包使研究人员能够轻松地比较可解释性算法。InterpretML还包括了explanation Boosting Machine的第一个实现,这是一个强大的、可解释的、glassbox模型,可以像许多黑箱模型一样精确。

使用InterpretML构建的局部解释交互式图

使用InterpretML构建的局部解释交互式图

使用InterpretML构建的全局解释图

使用InterpretML构建的全局解释图

ELI5

- scikit-learn

- XGBoost、LightGBM CatBoost

- Keras

ELI5有两种主要的方法来解释分类或回归模型:

- 检查模型参数并说明模型是如何全局工作的;

- 检查模型的单个预测并说明什么模型会做出这样的决定。

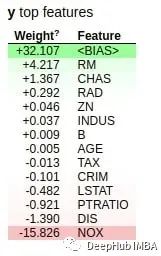

使用ELI5库生成全局权值

使用ELI5库生成全局权值

使用ELI5库生成局部权重

使用ELI5库生成局部权重

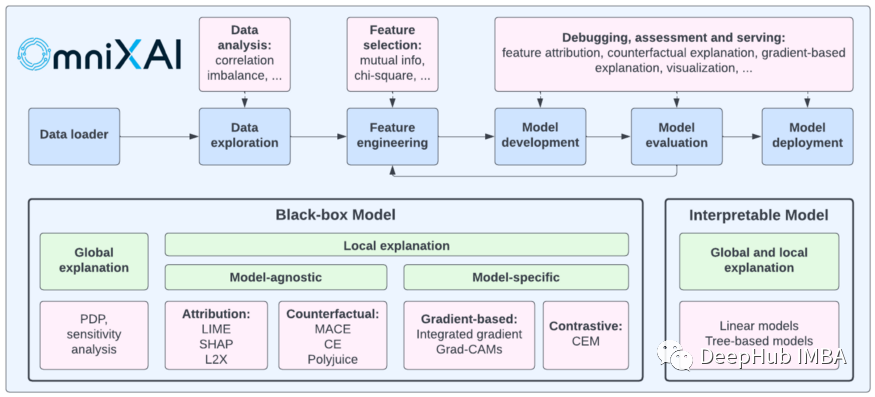

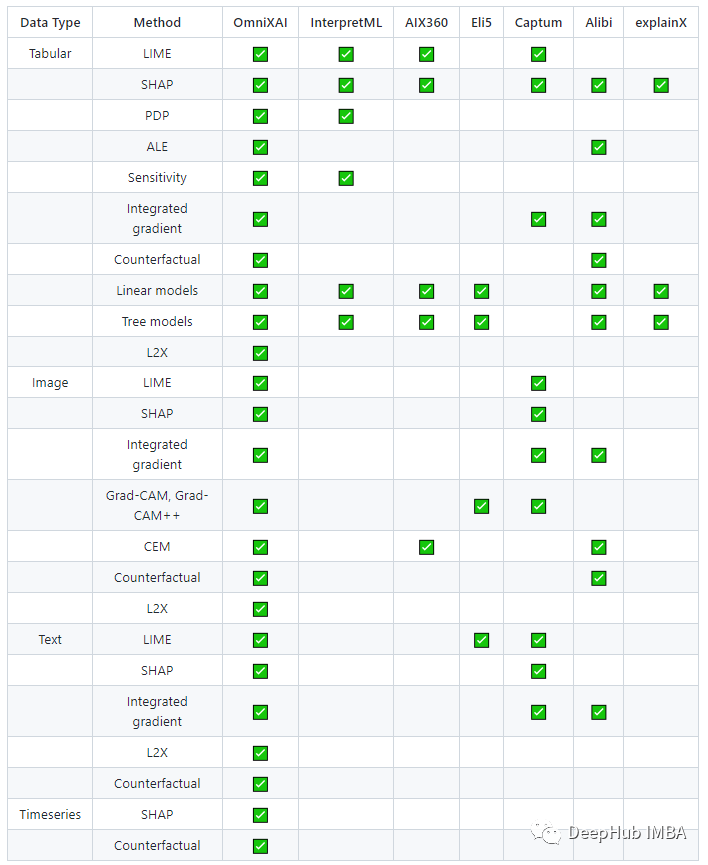

OmniXAI

以下是OmniXAI提供的与其他类似库的对比:

最后,下面是这6个框架的官方地址:

https://shap.readthedocs.io/en/latest/index.html https://github.com/marcotcr/lime https://shapash.readthedocs.io/en/latest/ https://interpret.ml/ https://eli5.readthedocs.io/ https://github.com/salesforce/OmniXAI

作者:Moez Ali 编辑:黄继彦

我真诚欢迎你加入我的金融科技数据人才群,文末有我的微信,可以连接我,请备注:金融科技

我提供付费咨询和服务。

你我连接,相互交流,创造更多价值。

—END—

你或许还想看

喜欢本文点个在看

或关注下方公众号

你将感受到一个数据科学工作者的灵魂

公众号:数据科学与人工智能

作者:陆勤

数据科学工作者。

混迹金融科技行业。

解决信贷业务风控和营销问题。

喜欢写点东西,有一颗利他之心。

只做付费咨询和服务。

连接请加微信:shushengya360

评论