200个亿参数!Cerebras凭借全球最大AI芯片打破在单个设备上训练的最大AI模型的记录

共 2564字,需浏览 6分钟

·

2022-06-24 21:48

6月23日消息,2021年曾推出全球最大AI芯片的Wafer Scale Engine 2(WSE-2)的Cerebras Systems公司近日宣布,在基于单个WSE-2芯片的CS-2系统上训练了世界上最大的拥有200亿参数的NLP(自然语言处理)人工智能模型。这也使得它能够适应,目前网络上非常热门的基于文本创建图像的OpenAI的120亿个参数的DALL-E的神经网络模型。

Cerebras Systems创始人兼首席执行官Andrew Feldman表示,在单个AI芯片中保留多达200亿个参数的 NLP 模型,显著降低了原本需要数千个GPU 训练的成本(以及相关的硬件和扩展要求),同时消除了在它们之间划分不同版本模型的技术困难。Andrew Feldman称这是“NLP 工作负载中最痛苦的方面之一”,有时“需要几个月才能完成”。

这是一个定制的问题,不仅对每个正在处理的神经网络、每个 GPU 的规格以及将它们联系在一起的网络都是独一无二的——这些元素必须在第一次训练开始之前提前解决。而且它不能跨系统移植。

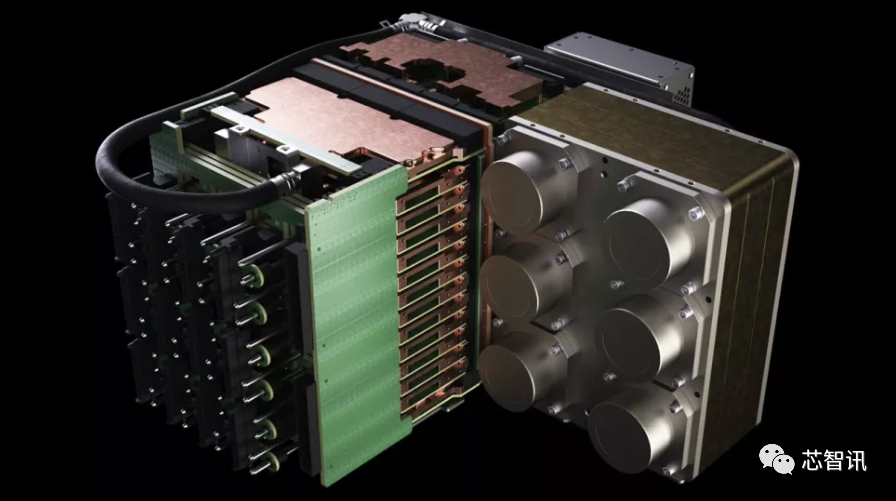

WSE-2与第一代一样,依然是基于一整张12吋晶圆制造,面积依然是462.25平方厘米,但是制程工艺由台积电16nm工艺提升到了7nm工艺,这也使得WSE-2的晶体管数量提高到了2.6万亿个,同时他的人工智能内核数量也达到了85万个,片上内存也由原来的18GB提升到了40GB,内存带宽由9PB/s提高到了20PB/s,结构带宽高达220PB/s。各项指标均打破首代WSE 处理器创造的世界纪录。

基于以WSE-2 处理器为核心的Cerebras CS-2 人工智能超级电脑系统(包括所有相关的电源、内存和存储子系统),是传统超级电脑性能的数百或数千倍,而且采用Cerebras CS-2 人工智能超级电脑的功耗和容纳空间却只有一小部分。这是因为单个WSE-2 处理器取代了成百上千个传统处理器的丛集架构,这些丛集架构需要数十个机架,使用数百千瓦的电力,并且花费数月的时间进行安装和准备。而CS-2的能耗仅需要15kW。

资料显示,OpenAI 的 GPT-3 是一种 NLP 模型,可以编写有时可能会欺骗人类读者的整篇文章,具有惊人的 1750 亿个参数。DeepMind 的 Gopher 于去年年底推出,将这个数字提高到 2800 亿。Google Brain 的大脑甚至宣布训练一个超过万亿参数的模型 Switch Transformer。

如果将CS-2所达成训练200亿参数的NLP人工智能模型的成就与上述更大规模的人工智能模型相比,CS-2的成就似乎平淡无奇。但是,事实上,CS-2极大降低了超大规模的人工智能模型训练的门槛。

Cerebras 首席执行官兼联合创始人 Andrew Feldman表示,“在 NLP 中,更大的模型将会带来更准确的结果。但传统上,只有极少数公司拥有必要的资源和专业知识来完成分解这些大型模型,并将它们分散到数百或数千个图形处理单元的能力。因此,只有极少数公司可以训练超大规模的NLP模型——这对于行业的其他人来说太昂贵、太耗时且无法使用。今天,我们很自豪能够普及 GPT-3XL 1.3B、GPT-J 6B、GPT-3 13B 和 GPT-NeoX 20B,使整个 AI 生态系统能够在几分钟内建立大型模型并在单个 CS-2 上训练它们。”

就像CPU的主频一样,AI模型的参数量只是一个指标。如何能够使用更少的参数实现更好的结果也是至关重要。例如,Chinchilla通常仅用 700 亿个参数就优于 GPT-3 和 Gopher 。所以,AI模型训练的目标是更聪明地工作,而不是更努力地工作。

此外,Cerebras公司也拥有能够支持“数千亿甚至数万亿”的模型。去年8月,Cerebras Systems就曾宣布推出了世界上第一个人类大脑规模的AI解决方案——CS-2 AI计算机,可支持超过120万亿参数规模的训练。相比之下,人类大脑大约有100万亿个突触。Cerebras实现了192台CS-2 AI计算机近乎线性的扩展,从而打造出包含高达1.63亿个核心的计算集群。

可用参数数量的爆炸式增长,还可利用Cerebras 的权重流技术,该技术可以将计算和内存占用量解耦,允许将内存扩展到存储 AI 工作负载中快速增加的参数数量所需的任何数量。这使得设置时间从几个月减少到几分钟,并且可以轻松地在 GPT-J 和 GPT-Neo 等型号之间切换“只需几次按键”。

“Cerebras 能够以具有成本效益、易于访问的方式将大型语言模型带给大众,这为人工智能开辟了一个激动人心的新时代。Intersect360 Research 首席研究官 Dan Olds 说:“看到 CS-2 客户在海量数据集上训练 GPT-3 和 GPT-J 类模型时所做的新应用和发现将会很有趣。”

编辑:芯智讯-浪客剑

编译自:https://www.tomshardware.com/news/cerebras-slays-gpus-breaks-record-for-largest-ai-models-trained-on-a-single-device

打破AI内存墙?PayPal联手至强+傲腾,漏查欺诈交易量可降到原来1/30

2021年全球NOR Flash市场:兆易创新收入暴增100%,份额升至23.2%!

台积电2nm细节曝光:功耗降低30%!成熟制程产能2025年将提升50%

行业交流、合作请加微信:icsmart01

芯智讯官方交流群:221807116