五分钟搞定VS2017+TensorRT环境搭建

小白学视觉

共 3291字,需浏览 7分钟

·

2021-09-14 15:35

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文转自|OpenCV学堂

Windows10系统GTX1050TiCUDA10.xVS2017TensorRT7.0.0.11

下载路径:

https://developer.nvidia.com/TensorRT首先需要下载TensorRT的ZIP格式文件到本地,然后解压缩到

D:\TensorRT-7.0.0.11然后打开VS2017,新建一个空项目,分别配置

1. 包含目录

D:\TensorRT-7.0.0.11\include2. 库目录

D:\TensorRT-7.0.0.11\lib3. 链接器

myelin64_1.libnvinfer.libnvinfer_plugin.libnvonnxparser.libnvparsers.lib

4. 环境变量

D:\TensorRT-7.0.0.11\lib然后在系统的环境变量中添加:

重启VS即可。

2020年初,我写过的pytorch程序有个Hello Wrold的版本的模型就是mnist.onnx,我来测试一下是否可以通过TensorRT来实现对ONNX格式模型加载。重启VS2017之后在原来的空项目上然后添加一个cpp文件,把下面的代码copy到cpp文件中:

#include <fstream>

#include <iostream>

#include <sstream>

#include "NvInfer.h"

#include "NvOnnxParser.h"

using namespace nvinfer1;

using namespace nvonnxparser;

class Logger : public ILogger

{

void log(Severity severity, const char* msg) override

{

// suppress info-level messages

if (severity != Severity::kINFO)

std::cout << msg << std::endl;

}

} gLogger;

int main(int argc, char** argv) {

std::string onnx_filename = "D:/python/pytorch_tutorial/cnn_mnist.onnx";

IBuilder* builder = createInferBuilder(gLogger);

nvinfer1::INetworkDefinition* network = builder->createNetworkV2(1U << static_cast<uint32_t>(NetworkDefinitionCreationFlag::kEXPLICIT_BATCH));

auto parser = nvonnxparser::createParser(*network, gLogger);

parser->parseFromFile(onnx_filename.c_str(), 2);

for (int i = 0; i < parser->getNbErrors(); ++i)

{

std::cout << parser->getError(i)->desc() << std::endl;

}

printf("tensorRT load onnx mnist model...\n");

return 0;

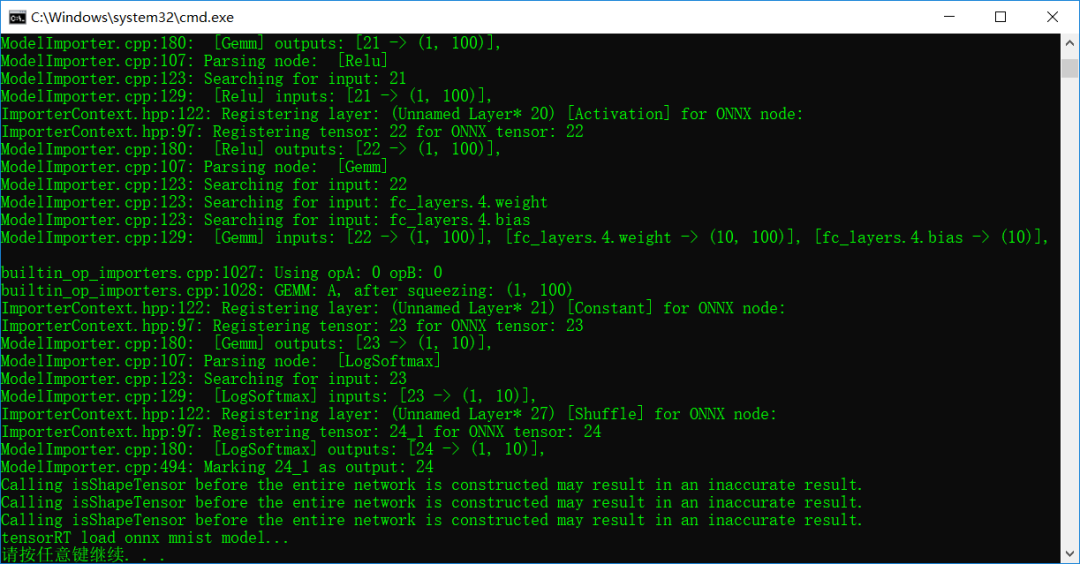

}编译运行直接运行输出:

恭喜你!TensorRT在Windows10下开发环境配置成功了!绝对在5分钟内搞定,前提是先预装好前面说的那些依赖软件与相关的库!

还不清楚,看B站视频:

https://www.bilibili.com/video/BV1Bf4y167Ty好消息,小白学视觉团队的知识星球开通啦,为了感谢大家的支持与厚爱,团队决定将价值149元的知识星球现时免费加入。各位小伙伴们要抓住机会哦!

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

评论