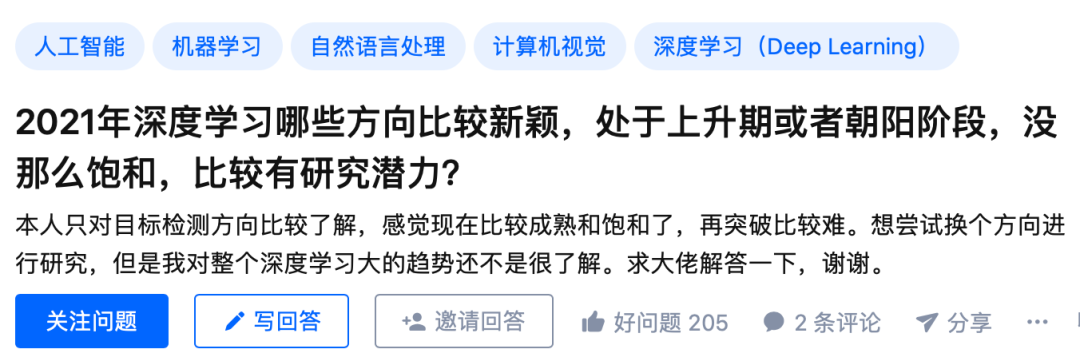

2021年,深度学习还有哪些未饱和、有潜力且处于上升期的研究方向?

共 6599字,需浏览 14分钟

·

2021-06-13 09:04

极市导读

在目前的深度学习领域,有些研究方向已经较为成熟,实现新突破的难度与过去相比显著提升。那么就目前来看,还有哪些方向处于朝阳阶段,相比之下更有研究潜力?>>加入极市CV技术交流群,走在计算机视觉的最前沿

0

1

作者:谢凌曦

我的主要研究方向是计算机视觉,所以本文也会比较偏重CV方向。

1. 不适合的研究方向

首先我要反对两个方向:对比学习为代表的自监督学习算法(包括BYOL等)和Transformer。它们的上限几乎是肉眼可见的,在没有非平凡的改进之前,很难有本质上的突破。在大量研究者投入精力的情况下,只要没有持续的产出,就必然会导致其加速衰落。前些年盛极一时的网络架构搜索(NAS)就是一个非常典型的例子。

我们首先分析NAS、对比学习、Transformer的局限性:

(1) 原本以NAS为代表的AutoML技术受到了广泛的期待,我还主张“自动机器学习之于深度学习,就好比深度学习之于传统方法”,不过后来发现它的缺陷是明显的。在搜索空间指数级扩大之后,算法就必须在精度和速度之间做出选择。后来盛行的权重共享类搜索方法,相当于追求搜索空间中的平摊精度,而平摊精度与最佳个体的精度往往并不吻合。

(2)对比学习被广泛引入图像领域作为自监督任务以后,前世代的自监督算法(如预测旋转、拼图、上色等)纷纷被吊打,甚至开始在下游任务中超越有监督训练的模型。然而,当前的对比学习类方法(包括BYOL)对于数据扩增(data augmentation)的依赖过重,因而不可避免地陷入了invariance和consistency之间的矛盾:强力的augmentation能够促进学习效果,但是如果augmentation过强,不同view之间的可预测性又无法保证。

(3)至于Transformer,虽然目前还处在比较兴盛的状态,然而它的上限也是明显的。除了更快的信息交换,似乎这种模型并没有体现出显著的优势。问题是:CV任务真的需要频繁而快速的视觉信息交换吗?遗憾的是,学界依然沉浸在“先将所有任务用Transformer刷一遍”的廉价快乐中,鲜有人愿意思考一些更深入的问题。

2. 应该关注的方向(但未必能够保证产出)

0

2

作者:数据误码率

如果以CVPR为CV的导向的话,目前发展大概是这样:

MLP(2012年的前)—>CNN(2012-约2020)—>transformer(2020年以后)—>MLP(??Google最近又把这玩意刨出来了,至于是不是,不敢推测结果如何)

先说结论:

越来越比拼硬件资源能力了。

总之就我做的医学图像分割上来说,最直观的感受就是几个点吧:

(1)传统基于CNN的文章除非在理论上、网络结构上(万年薅UNet,各种魔改)有大的创新,否则给人的感觉创新性都不大,甚至可以归为“水文”,二区都难。

(2)独立于网络之外的用于提升网络性能的模块上,attention-gate、channel- attention、spatial- attention、channel- spatial attention、non-local、scale- attention……反正就是魔改,要说最近的方向,可能就是类似ECA-module这种类似的走轻量注意力上才有的发paper。

(3)transformer:是个很新的方向,目前应该是医学图像分割上最好灌水的方向之一了,我记得去年开组会刚想把Unet的编码器或者解码器部分改成transformer,试试效果如何,结果一上知乎,我校某实验室就在编码器部分搞了出来一篇transUnet。看完swin-tranformer我一拍大腿,我去,这个好,这下解码器编码器都可以改了,对我这个小菜鸡还好理解点,结果马上有人做出来了swin-unet。总的来说就是,目前想水医学图像分割的transformer文章的,代码+硬件两手都硬的同行们,可以抓紧了。因为目前只要你速度够快,method部分不需要写大量公式计算,也不用憋着想如何写创新点,创新点统一为:

“本文首次把transformer应用于XXX检测/识别/分类/分割”

(4)大显存、多数量GPU,无论显存还是数量,越多越好,堪比挖矿。我曾经尝试把DA-Net中的PAM和CAM丢到UNet里去,结果直接out of memory….you need another 64GB。把我吓得,团队只有4卡RTX2080Ti瑟瑟发抖。transformer那种基于self-attention的大型注意力包,理论上计算资源只会多不会少,等忙完这段时间我准备搞一个3层的swin结构的编解码结构试试,但愿能跑起来,这样毕业论文就显得新一点 。

0

3

作者:Zhifeng

回答几个我最近在研究的方向~ 我主要在做生成模型,不过乱七八糟的也有涉猎。

1. 可解释性

feature-based研究的很多了,instance-based个人感觉在上升期,从研究的角度来说缺乏benchmark/axiom/sanity check. 主流方法是influence function, 我觉得这里面self influence的概念非常有趣,应该很值得研究。当然,更意思的方向是跳出influence function本身,比如像relatIF 加一些regularization,也是水文章的一贯套路(relatIF是好文章)。

Influence function for generative models也是很值得做的。Influence function for GAN已经有人做了,虽然文章直接优化FID是有点问题的,但是框架搭好了,换一个evaluation换个setting就可以直接发paper.

我最近写了Influence function for VAE, 有不少比较有意思的observation (paper[1]; code repo: VAE-TracIn-pytorch).

2. 无监督生成学习

最近的denoising diffusion probabilistic model(DDPM)绝对是热坑,效果好,但是速度慢没有meaningful latent space限制了很多应用,有待发掘。我去年实习写了一篇DiffWave是这个方法在语音上的应用,效果很好,最近应该能看到这个模型的application井喷,比如3D point cloud生成。

DDPM的加速最近已经有不少paper了,目前来看有几类,有的用conditioned on noise level去重新训练,有的用jumping step缩短Markov Chain,有的在DDPM++里面研究更快的solver. 我最近写了FastDPM, 是一种结合noise level和jumping step的快速生成的框架(无需retrain, original DDPM checkpoint拿来直接用),统一并推广了目前的好几种方法,给出了不同任务(图像, 语音)的recipe (paper[2]; code repo: FastDPM_pytorch).

生成模型里的Normalizing flow模型,用可逆网络转化数据分布,很fancy 能提供likelihood和比较好的解释性但是效果偏偏做不上去,一方面需要在理论上有补充,因为可逆或者Lipschitz网络的capacity确实有限。另一方面,实际应用中,training不稳定可能是效果上不去的原因,其中initialization 和training landscape都是有待研究的问题。潜在的突破口:augmented dimension或者类似surVAE那种generalized mapping. 除此之外,normalizing flow on discrete domain也是很重要的问题,潜在突破口是用OT里面的sinkhorn network.

我对residual flow这个模型有执念,很喜欢这个框架,虽然它不火。今年早些时候我写了residual flow的universal approximation in MMD的证明,很难做,需要比较特殊的假设 (paper[3])。之后可能继续钻研它的capacity和learnability.

再补充一个:

3. 生成模型的overfitting是一个长久的问题,但是本身很难定义,很大一个原因是mode collapse和copy training data耦合在一起。我们组去年发表了data-copying test用于检测相关性质,不过这个idea还停留在比较初级的阶段,我觉得这一块需要更多high level的框架。

4. Meta learning + generative model方向个人十分看好,meta learning 框架可以直接套,loss改成生成模型的loss就可以了。Again, GAN已经被做了,不过GAN的paper那么多,随便找上一个加上meta learning还是很容易的。类似可以做multitask + GAN.

如果觉得有用,就请分享到朋友圈吧!

公众号后台回复“79”获取CVPR 2021:TransT 直播链接~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~