快手广告算法工程师面试题15道|含解析

10本七月在线内部电子书在文末,自取~

公众号福利

👉回复【100题】领取《名企AI面试100题》PDF

👉回复【干货资料】领取NLP、CV、ML等AI方向干货资料

问题1:ReLU,LeakyReLU

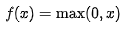

ReLU和LeakyReLU都是常见的激活函数。 ReLU的表达式为 LeakyReLU的表达式为

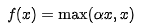

LeakyReLU的表达式为

其中α是一个小于1的常数。

问题2:ReLU的优缺点

ReLU的优点在于它具有快速收敛和计算的优势,同时还能够缓解梯度消失的问题。ReLU的缺点是当输入为负数时,该激活函数的导数为0,从而造成部分神经元失活的问题。因此,应用ReLU激活函数时需要注意,确保输入数据的均值为0。

问题3:ReLU激活函数是如何解决梯度消失和梯度爆炸问题的

?

ReLU的梯度在正区间恒定为1,而负区间恒定为0。这使得无论神经元的输出值如何,都不会导致梯度消失或梯度爆炸的问题。因此,ReLU激活函数能够有效地解决梯度消失和梯度爆炸问题。

问题4:什么是梯度消失和梯度爆炸?什么单元更容易出现梯度消失梯度爆炸的问题?

梯度消失指的是在反向传播过程中,权重和激活值都小于1,导致梯度不断缩小,最终导致梯度消失的现象。梯度爆炸则是指在反向传播过程中,权重和激活值都大于1,导致梯度不断增大,最终导致梯度爆炸的现象。其中,输出值小于0的sigmoid神经元更容易出现梯度消失的问题。

问题5:ReLU如何解决梯度消失问题?

ReLU激活函数对于非负的输入值,其梯度恒定为1,不会缩小,因此能够有效地避免梯度消失。

问题6:ReLU之前常用的激活函数?

以前常用的激活函数包括sigmoid函数、tanh函数、以及softmax函数等。

问题7:写一下sigmoid函数的表达式。sigmoid函数存在的问题

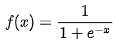

sigmoid函数的表达式为

其中α是一个小于1的常数。

问题2:ReLU的优缺点

ReLU的优点在于它具有快速收敛和计算的优势,同时还能够缓解梯度消失的问题。ReLU的缺点是当输入为负数时,该激活函数的导数为0,从而造成部分神经元失活的问题。因此,应用ReLU激活函数时需要注意,确保输入数据的均值为0。

问题3:ReLU激活函数是如何解决梯度消失和梯度爆炸问题的

?

ReLU的梯度在正区间恒定为1,而负区间恒定为0。这使得无论神经元的输出值如何,都不会导致梯度消失或梯度爆炸的问题。因此,ReLU激活函数能够有效地解决梯度消失和梯度爆炸问题。

问题4:什么是梯度消失和梯度爆炸?什么单元更容易出现梯度消失梯度爆炸的问题?

梯度消失指的是在反向传播过程中,权重和激活值都小于1,导致梯度不断缩小,最终导致梯度消失的现象。梯度爆炸则是指在反向传播过程中,权重和激活值都大于1,导致梯度不断增大,最终导致梯度爆炸的现象。其中,输出值小于0的sigmoid神经元更容易出现梯度消失的问题。

问题5:ReLU如何解决梯度消失问题?

ReLU激活函数对于非负的输入值,其梯度恒定为1,不会缩小,因此能够有效地避免梯度消失。

问题6:ReLU之前常用的激活函数?

以前常用的激活函数包括sigmoid函数、tanh函数、以及softmax函数等。

问题7:写一下sigmoid函数的表达式。sigmoid函数存在的问题

sigmoid函数的表达式为

问题11:卷积层的参数计算,以及计算量计算。

卷积层的参数数量取决于卷积核大小、输入通道数量和输出通道数量。计算量计算则取决于卷积核大小、输入图像大小、输出通道数量和步长大小。 问题12:m*n的图像,卷积核为k*k,步长为1,最后生成的图像大小 对于m×n的图像,卷积核为k×k,步长为1时,卷积后生成的图像大小为(m-k+1)×(n-k+1)。 问题13:m*n*3的图像输入进去,输出会有变化吗? 输入的m×n×3的图像经过卷积操作后输出的通道数可能会有所变化,但是图像的宽高不会发生变化。 问题14:卷积核的k值的取值,为什么取这个值 卷积核的大小k一般为奇数,这是因为奇数大小的卷积核有中心像素,可以更好地对称地影响图像的每个位置。同时,选择奇数大小的卷积核还可以保证最终卷积后的图像不会出现偏差。 问题15:ResNet中的Block,怎么用的 ResNet中的Block是指由复杂的卷积和激活层组成的模块,可以有效地解决反向传播中出现的梯度消失和梯度爆炸的问题。ResNet中的每个Block都包含有多个卷积层以及一个Skip Connection,可以逐渐构建出一个非常深的神经网络。当网络层数较深时,通过增加Skip Connection的结构可以更好地保留梯度信息,从而提高模型的性能。免费送

↓以下10本书电子版免费领,直接送↓

扫码回复【999】免费领10本电子书

(或 找七月在线其他老师领取 )

点击“ 阅读原文 ”抢宠粉 福利 ~

评论