Pandas 2.0来了~

Pandas[1]是一个用于处理数据的Python库,在Python开发者中非常流行。相信你已经对他非常熟悉了。

随着现在数据量越来越多,pandas的局限性也日渐凸显,在处理大数据时非常恼火,从而选择更加合适的工具,如pyspark等大数据处理框架。

而 Pandas 2.0 也是朝着这个方向迈出的一步,接下来我们一起聊一聊Pandas增加和改进的内容。

更快和更有效的内存操作

本次最大的亮点可谓是他们在后台增加了对pyarrow的支持,甚至被定义为一场革命(revolution)。

pyarrow后端是pandas 2.0的一个新功能,它允许用户使用Apache Arrow作为pandas DataFrames和Series的替代数据存储格式。

这意味着当你在pandas 2.0中读或写Parquet文件时,它将默认使用pyarrow来处理数据,从而使操作更快、更节省内存。

什么是Pyarrow?

Pyarrow是一个提供列式内存格式的库,它是一种组织数据的方式,使其更容易读取和并行处理。

总之,在pandas 2.0中使用pyarrow后端可以使数据操作更快、更节省内存,尤其是在处理大型数据集时。

缺失值处理

PyArrow更适合于表格数据,使其能够轻松地存储字符串,最重要的是,使空值处理也更容易。

先前Pandas依靠NumPy来保存表格数据,例如字符串、数字,也包括更复杂的数据。然而,NumPy也有其局限性,从Marc Garcia[2]的文章中可以看到,NumPy不支持字符串和缺失值。因此,对于缺失的数字,需要使用一个特殊的数字或NaN。这意味着对于每一种数据类型,缺失值的实现都很复杂,处理起来也很棘手。

而这些问题在Pandas2.0将会完美解决,在PyArrow中处理缺失数据时,在数据数组的旁边会有第二个数组,表示一个值是否存在,使得对空值的处理更加简单明了。

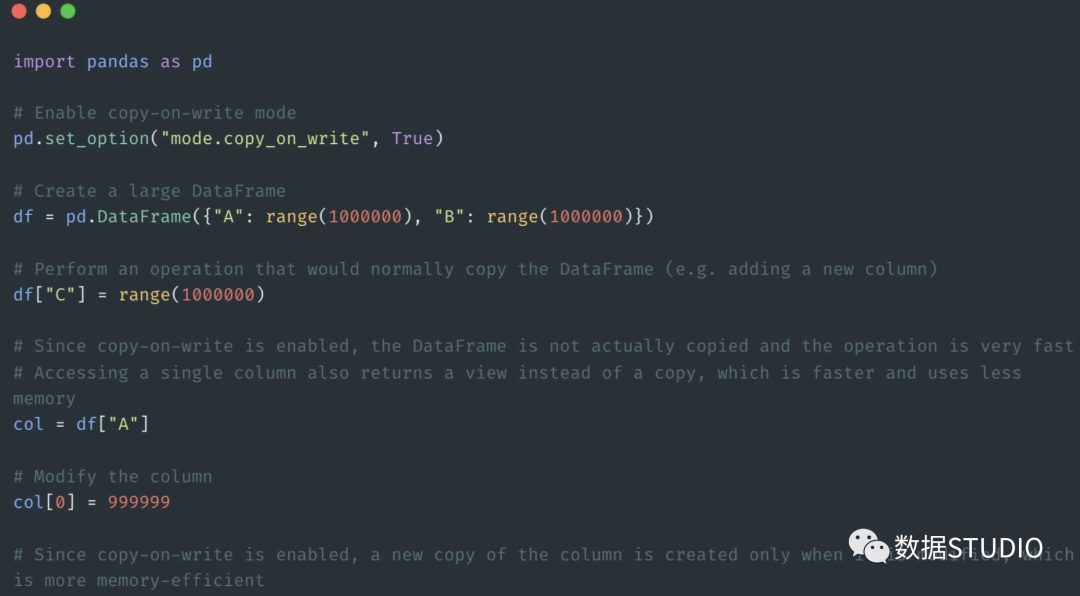

写入时复制优化

这是一种内存优化技术,类似于Spark执行代码的方式,在pandas中用来提高性能,减少处理大数据集时的内存使用。

当复制一个pandas对象,比如DataFrame或Series,pandas不是立即创建一个新的数据副本,而将创建一个对原始数据的引用,并推迟创建一个新的副本,直到以某种方式修改数据。

这意味着,如果你有相同数据的多个副本,它们都可以引用相同的内存,直到你对其中一个进行修改。这可以大大减少内存的使用,提高性能,因为你不需要对数据进行不必要的复制。

总的来说,写入时复制是一种强大的优化技术,可以帮助你更有效地处理大型数据集,并减少内存。

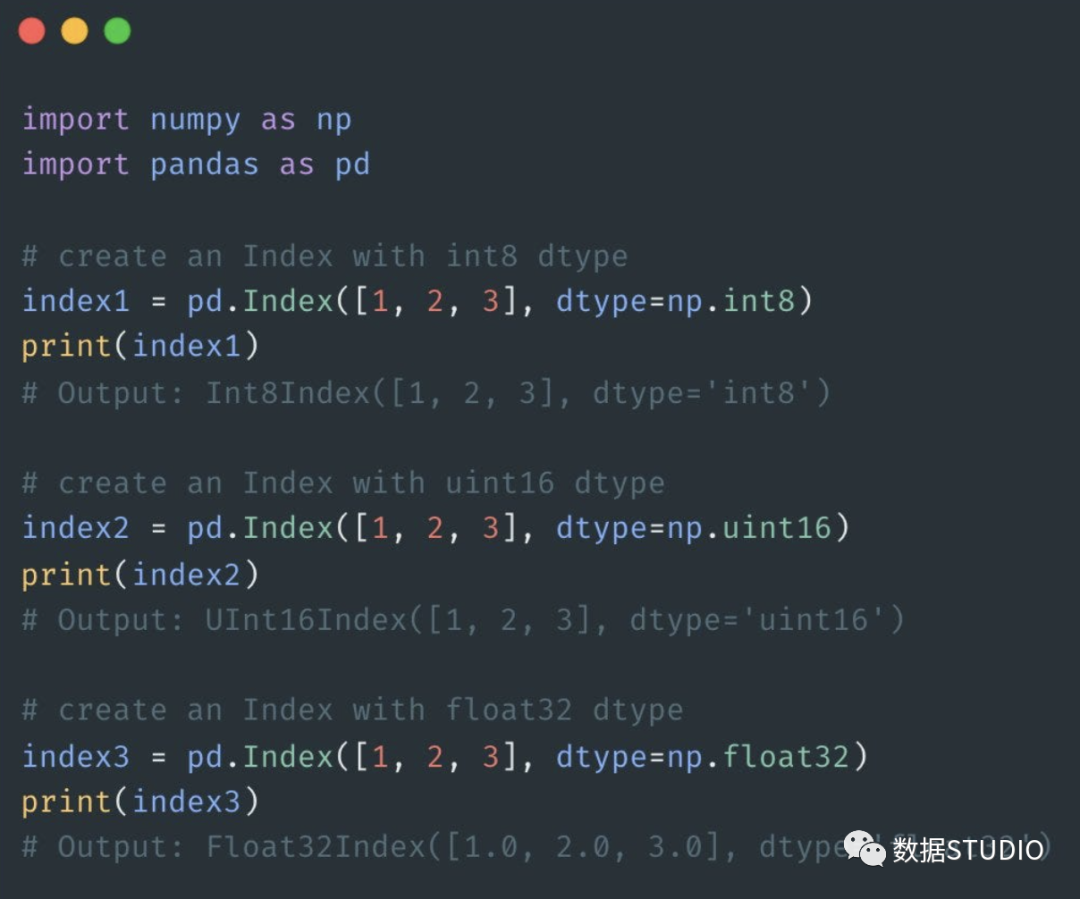

索引

更好的索引、更快的访问和计算

以前,pandas只支持int64、uint64和float64类型。

而在Pandas 2.0中,Index将支持所有NumPy的数字类型,包括int8, int16, int32, int64, uint8, uint16, uint32, uint64, float32和float64。

因此,以前创建64位索引的操作现在可以创建较低位数的索引,如32位索引。

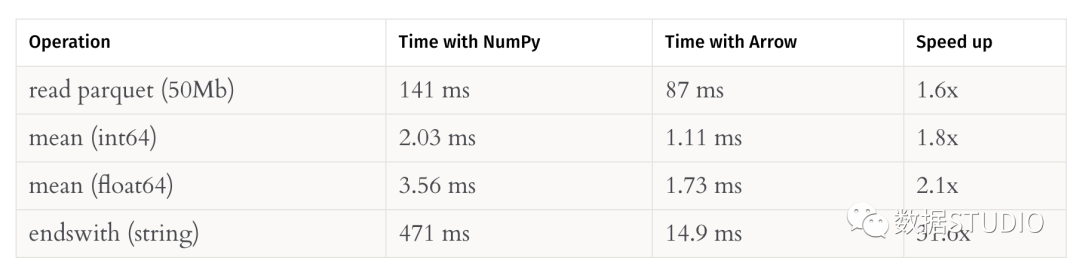

Pandas 2.0将更快

PyArrow的引入将提大地提高了pandas的性能。这里提供了一个例子,对于一个250万行的字符串系列,在笔记本电脑上使用PyArrow比NumPy快31.6倍。

对于pandas重度依赖者来说,这无疑是个非常棒的消息,让我们一起期待下吧~

来源:数据STUDIO

参考资料

Pandas: https://pandas.pydata.org/

[2]Marc Garcia: https://datapythonista.me/blog/pandas-20-and-the-arrow-revolution-part-i