来源:新智元

近日,深度学习先驱Yann LeCun接受了Gradient Podcast的采访,畅谈了他在80年代早期的AI研究以SSL的最新发展。LeCun现任Facebook副总裁兼首席AI科学家和纽约大学教授,2018年ACM图灵奖得主。他在80年代率先使用卷积神经网络进行图像处理,是AI深度学习革命的关键人物。

在采访中,LeCun首先聊到了他的早期求学和科研历程。出于对物理学的喜爱,LeCun最早选择了工程学作为大学专业,1983年,他从巴黎ESIEE大学毕业。

本科时,LeCun逐渐发现自己对科研的兴趣胜过普通的工程学,特别是人类以及其他动物智慧如何产生的问题。至于机器学习(当然当时还没有这个学科),他的灵感则来自一本哲学书籍,书中介绍了一场上世纪70年代著名的辩论——语言学家和心理学家讨论了语言究竟是先天还是后天习得的。辩论中提到了通过感知器,让简单的机器也能够学习复杂的概念。这个话题启发了LeCun。于是,他开始着手研究相关文献,但是他发现大多数发表的内容都集中在上世纪60年代。

到了80年代初期,专家系统变得炙手可热。但LeCun觉得这类系统不靠谱,那时关于机器学习的想法已经成型。他自嘲到,「可能是因为我懒,或是发现了自己能力有限,所以当时觉得造一台能够进行自我决策的机器基本是不可能的」。LeCun还对自我组织系统和神经网络十分痴迷,但当时世界上进行相关研究的人并不多,且没有一个统一的组织。于是,LeCun和巴黎的一个小型独立实验室联系,开始展开自己的研究(注:当时的皮埃尔和马居里大学,今天的索邦大学,LeCun 1987年在那里获得了计算机专业博士学位)。

从那时起,一些新颖的观点便从众多简单元素的相互碰撞中产生了。

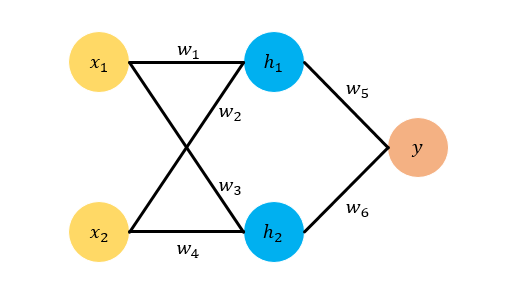

上世纪80年代,LeCun开始着手研究反向传播算法。

「在研究中,我意识到为什么60年代进行的神经网络早期尝试都失败了,因为研究它的人们都在试图寻找网络运行的规则」。

所以LeCun开始研究用多层网络来覆盖每个神经元,无论目标输出是什么,这样的方法更容易计算出答案来。从60年代经典的优化控制算法中,LeCun得到了启发,建立了反向传播梯度算法。

1986年,LeCun曾写过一篇关于计算机深度学习的论文,不过是用他的母语法语写的。而且,他后来的导师Geoffrey Hinton看到这篇论文时,觉得写得「十分糟糕」。但不可否认的是,这篇论文中已经有不少关于机器学习成熟的理论。

同之前的研究一样,LeCun展开CNN研究的时候,灵感也来自于图书馆。从前人对于视觉系统的生物学研究中,LeCun发现了图像的秘密。在博士即将毕业之前的6个月,LeCun开始与Leo一起开始编写一个深度学习框架。最终他们在1989年发表论文,通过使用梯度下降方法训练的CNN进行图像识别,这成为了日后计算机视觉研究的基础理论。

「当时还没有Python,所以我基本上使用的是自己的语言编写的代码」,那时由于多伦多有更好的研究条件,所以LeCun搬到了多伦多继续自己的研究。在多伦多的前六个月进展并不理想,以至于Hinton多次在质疑LeCun是不是在「摸鱼」。

LeCun(右)与导师Hinton(中)、Bengio(左)合影「我当时在尝试手机一些小数据集,简而言之,就是用鼠标把一个个字符连起来」。然而当LeCun去贝尔实验室时,他被实验室的一个包含上千个样本的数据集震惊到了。「当时我想这太疯狂了。」在1988年,贝尔实验室在2个月内做出了最好的结果。LeCun搭建研究框架,张量引擎,以及一套前端语言,基本的机器学习流程就这样搭建出来了。可以说,后来的TensorFlow、PyTorch等等都是基于这个概念打造的。

在谈到自监督学习时,LeCun说道在近些年的研究中,它在计算机视觉领域的确产生了许多令人兴奋的成果。

当然,与基于全球巨大的图像识别数据集的研究相比,自监督学习仍然没有胜算。但是在语音识别等其他领域,监督学习的确带来了许多成果。比如,它可以在10分钟以内训练一套语音识别系统。

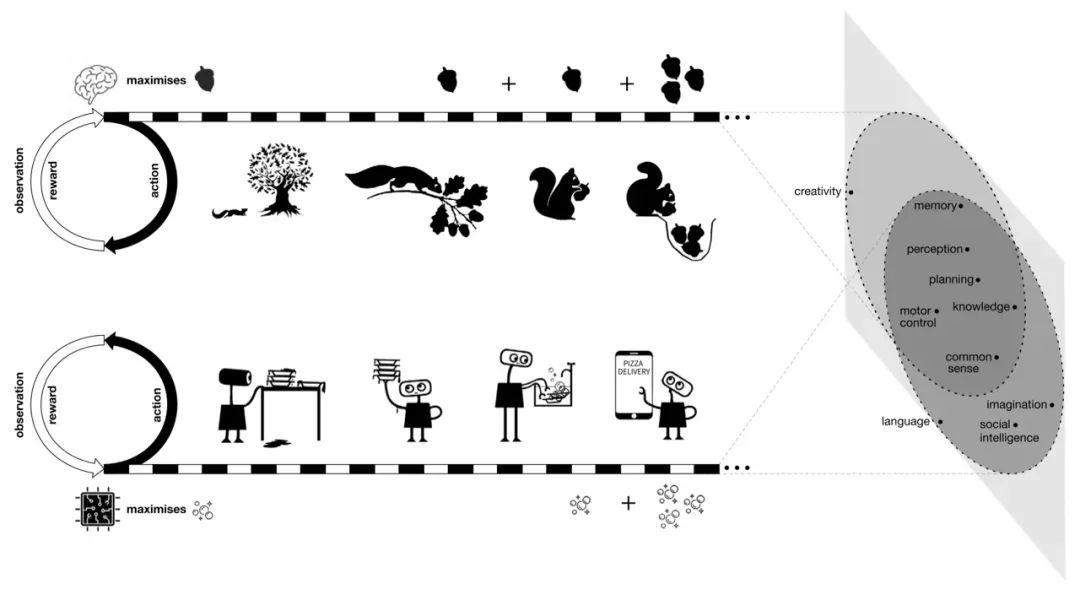

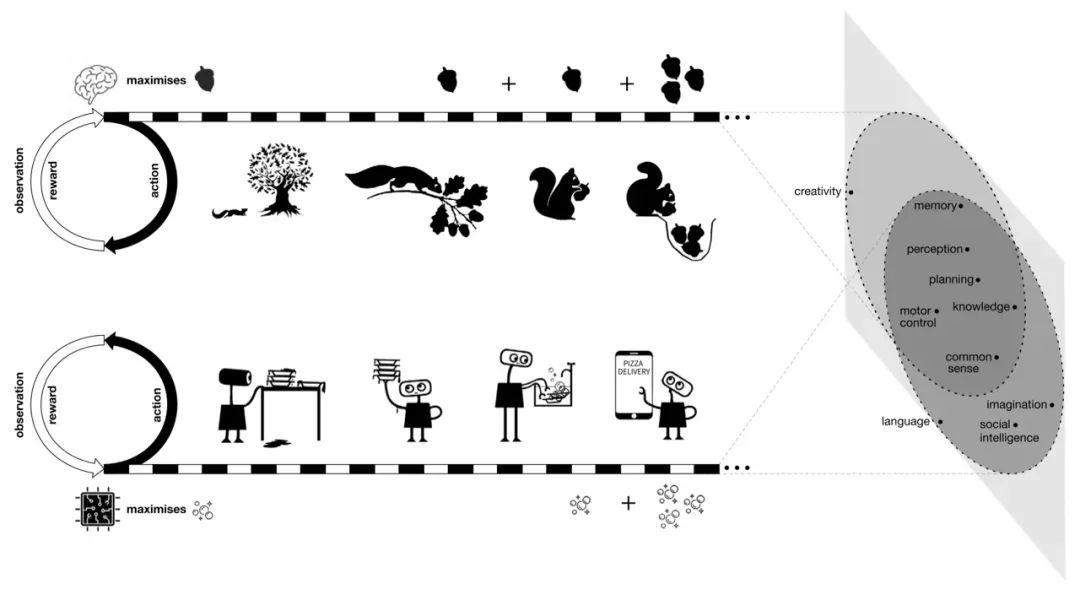

之前DeepMind两位大神David Silver以及Richard Sutton不久前发表过惊人言论:通过奖励最大化结合强化学习就能实现通用人工智能。

关于这个论调LeCun也在采访中表明了自己的态度:「他们的观点非常可笑,要在现实世界里进行数千年的训练。我完全不同意这种说法,我认为这完全是错误的。所以我们未来也不打算向那个方向前进」。目前的SSL系统关键问题在于现在有一个监督系统,你只提供很少的样本,然后你使用监督系统让机器学会从一个输入部分来对另一部分进行基本的预测。比如说, 提供一幅图像的左边和右边,那系统能否判断出两个部分是来自于同一图像呢?又「比如通过输入两段分割的视频,AI能否自动判断两个视频的逻辑关系?」「所以在计算机视觉方面,我认为最大的挑战是让机器通过看视频来了解这个世界的运作方式」。

谈及上半年做了哪些工作,LeCun阐述了如何让机器进行SSL?花一个小时让机器「随机」观看Instagram上10亿张公开照片。

也就是说,这些图片并未做过通常用于算法训练的标签和注释处理。接下来,使用SwAV算法在这些图像上进行预训练。也就是,利用数据集一边学习一边处理数据,完成快速分组、物体检测等任务。在这些任务中,SwAV表现都出奇地好,所以如果你有一个足够大的未经标注的数据集,这些技术将会给你带来SOTA级的表现。所以SSL未来也会为计算机视觉领域带来巨大的影响。

这意味着你只需要大量的数据,而不进行人工标注,就能进行训练。在系统训练时,会产生平凡解,即不同输入的图像产生同样输入图像的问题,我们称之为崩溃(collapse)。LeCun的Facebook AI小组用了一个非对比的方法,通过最大化输出的交互信息(mutual information )来避免崩溃。事实上这个方法是LeCun的导师Hinton在上世纪90年代发明的。例如,假设有两个神经网络观察图像或视频的两不同部分,通过训练让他们之间的交互信息量足够大,那么崩溃就不会发生。但这个方法的难点在于如何测量两个变量之间的交互信息。虽然交互信息有明确的定义,但是没有明确的估计方法,它类似于一个概率分布。

所以你需要对于这个分布进行假设,如果假设错误,那么系统肯定不会输出理想的结果。这就是Hinton在90年代遇到的问题。

当然,目前深度学习技术仍然有许多未知理论有待于我们去探索。LeCun给了一个有意思的比喻。

比如蒸汽机在17世纪就发明了出来,但是热力动力学基本在100年之后才为我们解释了蒸汽机的局限性。

又比如显微镜和望远镜同样也是很早之前就被发明了出来,但是衍射定律也是在那之后才发现的。所以深度学习也一样,做研究需要直观地了解你究竟在做什么,如果你一味地将自己局限在模型中,你将失去接触许多其他事物的机会,只是因为你不理解它们。深度学习技术如今已经几乎渗透进每一个大型互联网公司的DNA中,LeCun介绍到,如果没有深度学习,那么Facebook可能立刻会垮台。但与此同时,指望AI达到通用智能的水平,LeCun认为需要重新审视一下通用人工智能的概念。

「在我职业生涯结束前,如果AI能够达到狗或者牛一样的智商,那我已经十分欣慰了」。「我不太相信通用智能的概念,所以我们必须降低期待。当然,不容否认的是通用智能是我们的努力方向,比如在自监督领域取得突破性进展,让系统来运行世界模型。」

智力的本质是能够基于你的行动来预测世界可能发生的结果,因为这样才能够让你具备计划的能力。

参考资料:

https://thegradientpub.substack.com/p/yann-lecun-on-his-start-in-research

往期精彩:

Swin-UNet:基于纯 Transformer 结构的语义分割网络

Swin Transformer:基于Shifted Windows的层次化视觉Transformer设计

TransUNet:基于 Transformer 和 CNN 的混合编码网络

SETR:基于视觉 Transformer 的语义分割模型

ViT:视觉Transformer backbone网络ViT论文与代码详解

【原创首发】机器学习公式推导与代码实现30讲.pdf

【原创首发】深度学习语义分割理论与实战指南.pdf