目标检测别再刷榜了,让流感知来展示真正的技术!ECCV 2020 最佳论文提名

极市导读

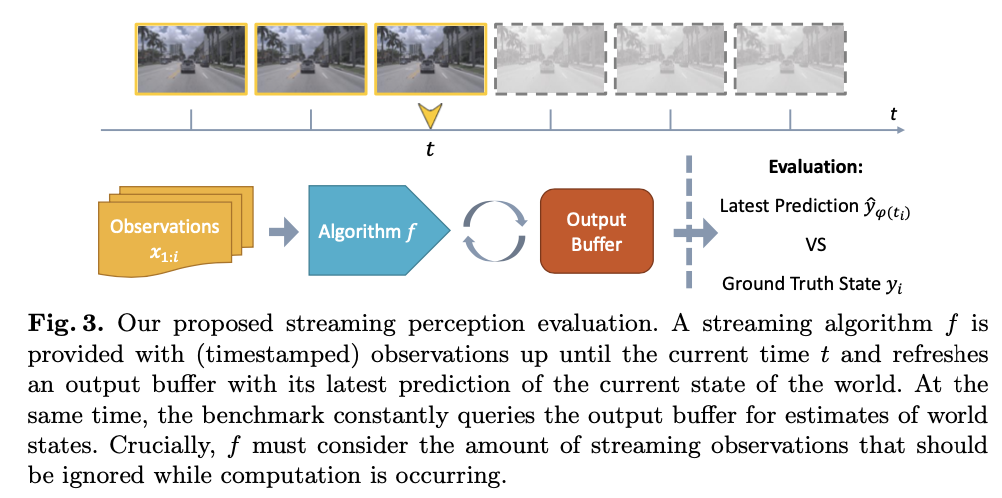

不久前,一组研究者结合实时任务中算法的准确率和延迟情况,提出了“流感知”评估函数,这一方向还存在很大的研究空间。

1 动机

2 元基准

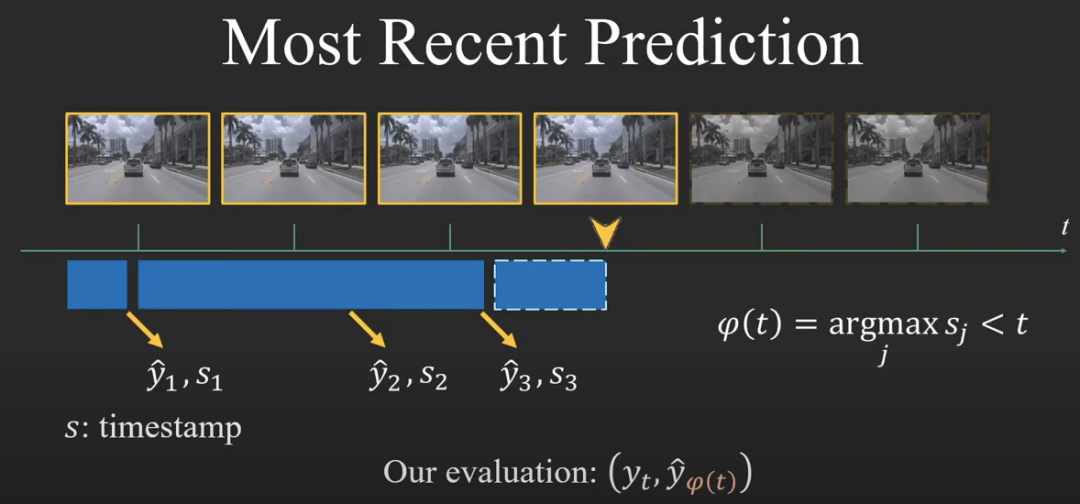

1、预测值与Ground Truth

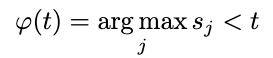

,相应的预测值为

,相应的预测值为 ,标准离线任务的评估是针对(

,标准离线任务的评估是针对( ,

,  )进行计算,而进行流式评估时,评估的对象会变为(

)进行计算,而进行流式评估时,评估的对象会变为( ,

, )。

)。

进行配对,这也正是流感知评估与离线评估不同的地方,离线评估中的预测值是与输入帧的顺序(索引)配对。由于流式感知在计算过程中会对冗余帧进行删除,作者选择了与t时刻最接近的预测值

进行配对,这也正是流感知评估与离线评估不同的地方,离线评估中的预测值是与输入帧的顺序(索引)配对。由于流式感知在计算过程中会对冗余帧进行删除,作者选择了与t时刻最接近的预测值 与GT进行计算,其中

与GT进行计算,其中 为:

为:

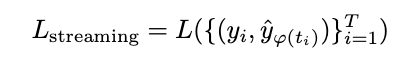

可以是图像分类任务中的Acc,目标检测任务中的AP,或者是实例分割任务中的mIoU。

可以是图像分类任务中的Acc,目标检测任务中的AP,或者是实例分割任务中的mIoU。2、流式感知处理实时算法

来执行运算,它只能使用时间

来执行运算,它只能使用时间 之前的数据。作者认为这才是实时算法应该考虑的实际评估环境。

之前的数据。作者认为这才是实时算法应该考虑的实际评估环境。3 实验

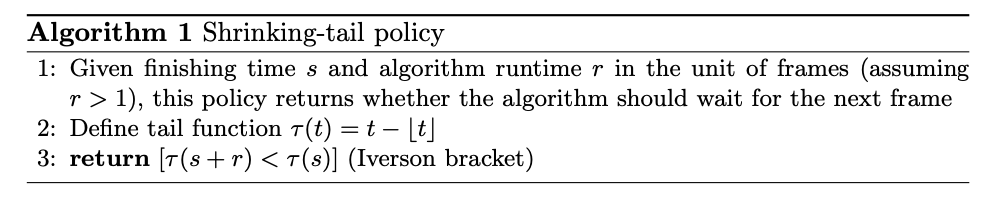

,算法处理单帧的运行时间为

,算法处理单帧的运行时间为 来计算给定时刻

来计算给定时刻 表示下一帧的算法处理结束时间,

表示下一帧的算法处理结束时间, 表示上一帧的算法处理结束时间,然后使用艾弗森括号(Iverson bracket)判断两个尾部时间的关系进而决定当前帧是否需要丢弃。

表示上一帧的算法处理结束时间,然后使用艾弗森括号(Iverson bracket)判断两个尾部时间的关系进而决定当前帧是否需要丢弃。在数学中,以Kenneth E. Iverson命名的“艾佛森括号”,是一种用方括号记号,如果方括号内的条件满足则为1,不满足则为0.

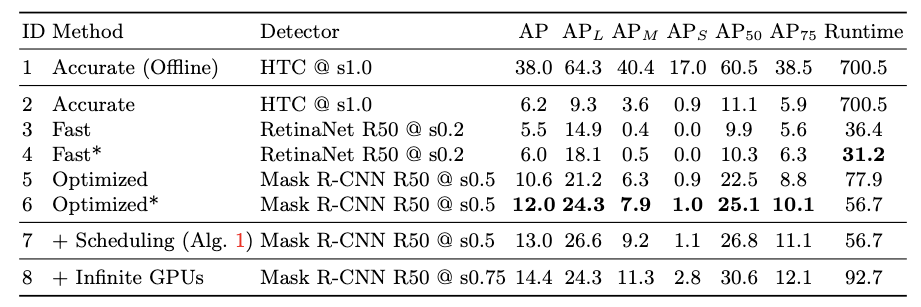

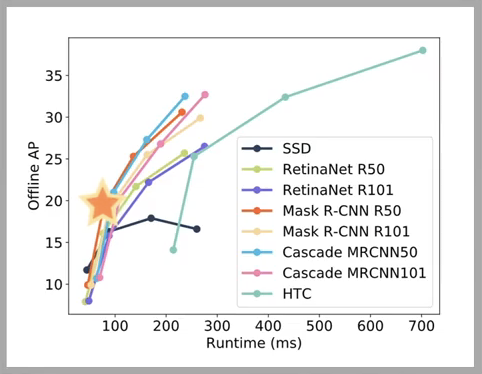

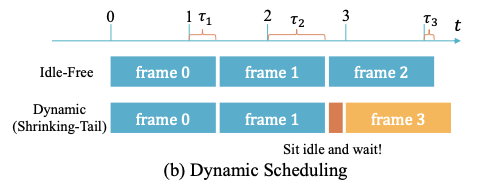

,可以判断出第2帧为冗余帧,算法直接空闲等待一会(Sit idle and wait!),直接处理第3帧。这种动态调度的方式可以将流感知的检测精度提升到13.0,与上面表格第7行对应。

,可以判断出第2帧为冗余帧,算法直接空闲等待一会(Sit idle and wait!),直接处理第3帧。这种动态调度的方式可以将流感知的检测精度提升到13.0,与上面表格第7行对应。

4 结论

推荐阅读

评论