31位学者联手,GPT-3原作获NeurIPS 2020最佳论文奖!华人「10岁论文」摘时间检验奖

新智元报道

新智元报道

来源:NeurIPS

编辑:QJP、小匀

【新智元导读】NeurIPS 2020最佳论文公布!Open AI 的 GPT-3论文与米兰理工大学、卡内基梅隆大学和加州大学伯克利分享 NeurIPS 2020年度最佳论文奖。大会还公布了「时间检验奖」,一篇10年前的华人一作论文摘得大奖。

刚刚,NeurIPS 2020在官网公布了2020年度最佳论文奖和时间检验奖。

最佳论文共收录了三篇,今年最亮眼的主角——OpenAI的GPT-3名列其中!

时间检验奖由威斯康星麦迪逊分校团队发表于NeurIPS 2011上的一篇论文获得,其一作为本科毕业于清华大学计算机系的华人Feng Niu。

神经信息处理系统大会(NeurIPS),是全球最受瞩目的AI、机器学习顶会之一,曾在美国、西班牙、加拿大多地举办。

一年一度,大神们在这里的「AI论剑」都备受瞩目。

不过今年,由于疫情原因,大会也改为了线上。

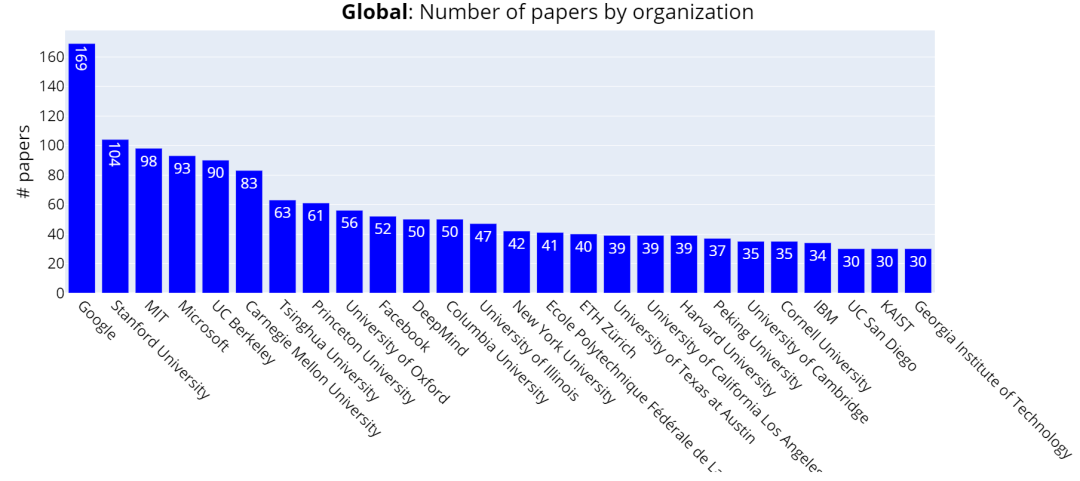

论文接收量分析:谷歌全球第一,清华国内第一

今年的NeurIPS投稿数量再次创下新高,比2019年增长了38%,一共收到了12115份摘要,但最后提交完整的只有9467篇论文,最终被收录的有1903篇,接受率只有20%。

本届 NeurIPS 2020 论文接收量全球机构排名前三甲分别为为:Google(169篇),斯坦福(104篇),MIT(98篇)。

清华大学以63篇位居第七位,北大则以37篇位居第20名。

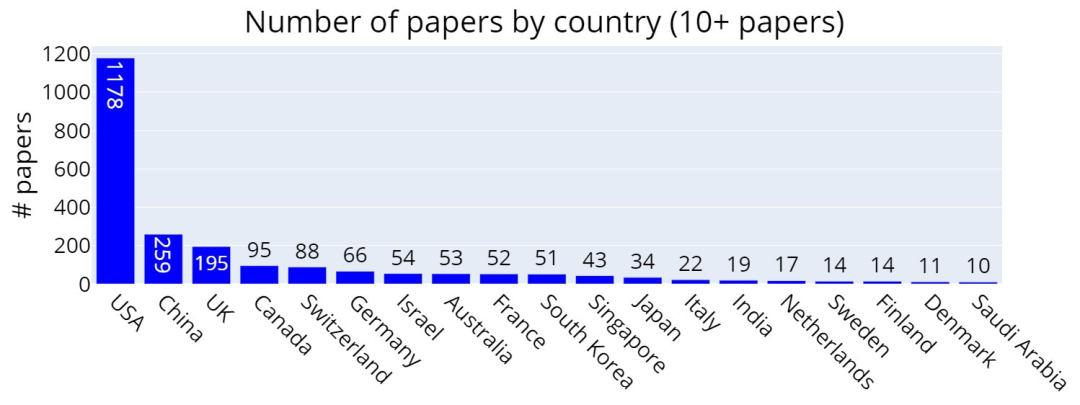

本次NeurIPS 2020论文中稿/接收量国家排名Top 5依次为:

美国:1178篇、中国:259篇、英国:195篇、加拿大:95篇、瑞士:88篇。

从论文的主题来看,算法占比29%,深度学习占比19%,应用占比18%,强化学习和规划(planning)占比9%,理论占比7%,概率方法占比5%,机器学习社会方面( Social aspects of machine learning)占比5%,优化占比5%,神经科学和认知科学占比3%。

此外,大会还公布3篇获得最佳论文(Best Paper Awards)的文章。

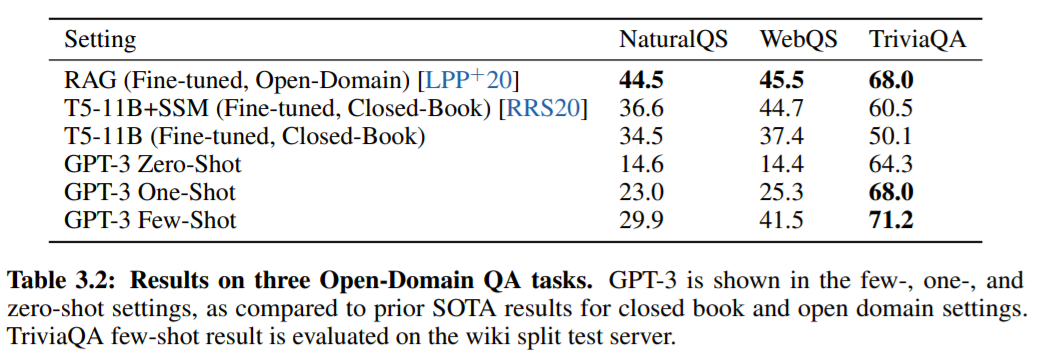

GPT-3获奖理由:地表最强语言模型

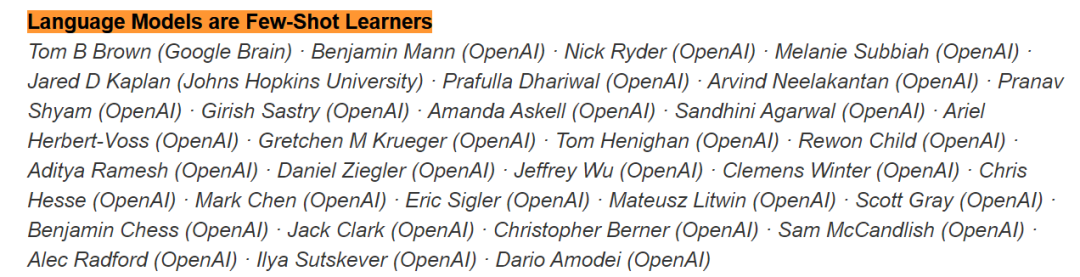

这篇论文还创下了一个「合作人数最多」的记录,作者一共为为31人。合著者分别是OpenAI 29人、谷歌大脑1人、约翰霍普金斯1人。

论文作者(部分)

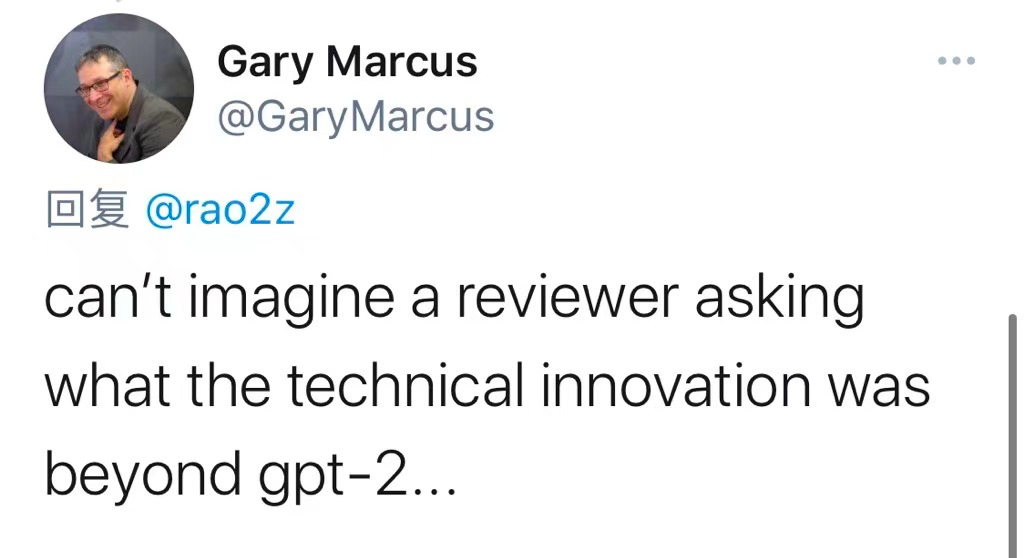

不过,一向反对GPT-3的马库斯也嘲讽了一番,「无法想象评审人员会问GPT-2之后还有什么技术创新…」

第二篇最佳论文是由来自米兰理工大学、卡耐基梅隆大学等的四位作者发布的:「No-Regret Learning Dynamics for Extensive-Form Correlated Equilibrium」,即「广义相关均衡的无悔学习动力学」。

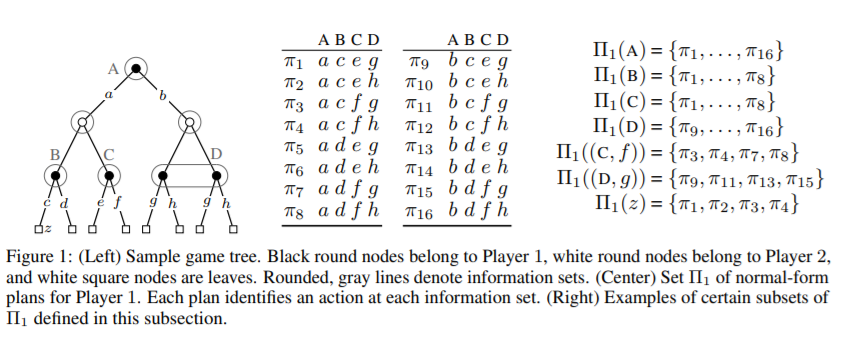

具体来说,20多年前就已经知道,当所有的参与者在一次重复的正则形式的博弈中寻求最小化遗憾,参与的经验概率会收敛到一个正常形式的相关均衡。

扩展形式(即树形式)的博弈,通过对连续的和同步的步骤以及私有信息的建模,将正则形式的博弈广义化。由于博弈的时序性和部分信息的存在,扩展形式的相关(EFCE)与标准形式的相关性具有显著不同的性质,其中许多仍然是开放的研究方向。

第三篇是由来自加州大学伯克利分校的3位作者共同创作的「Improved guarantees and a multiple-descent curve for Column Subset Selection and the Nystrom method」。

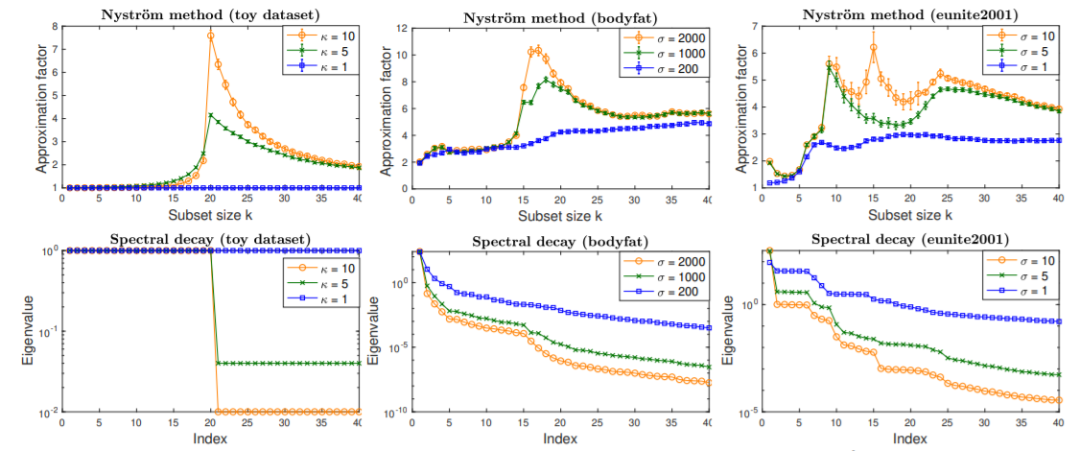

列子集选择问题(CSSP)和 Nyström 方法是机器学习和科学计算中构造大数据集小型低阶近似的主要工具。其中一个基本问题是: 大小为 k 的数据子集如何与最佳秩 k 近似相竞争?

通过这篇论文开发的技术,利用谱性质的数据矩阵,以获得改进的近似保证,这超出了标准的最坏情况分析。

作者使用的方法为已知单值衰减率的数据集提供了更好的界限,同时还揭示了一个有趣的现象: 近似因子作为 k 的函数可能呈现多个峰和谷,称之为多重下降曲线。

最后,以 RBF 核为例,证明了改进的边界和多重下降曲线都可以通过改变 RBF 参数在实际数据集上观察到。

时间检验奖:穿越时间,一篇10年前的论文获奖

此外,大会还公布了一项「Test of Time Award」,即时间检验奖。

顾名思义,就是颁发给一篇经得起时间考验的论文。大奖被10年前的一篇论文获得,这篇论文对人工智能界产生了特别重大和持久的影响。

委员会给出的获奖理由是:「机器学习是将样本数据转化为模型的问题,这些模型存储在计算机中,可以用来做出决定或采取行动。机器学习系统的核心是SGD,它搜索可能的模型空间,找到一个与样本数据匹配良好的模型。本文描述了 SGD 的一个实现,它可以在一组快速计算机上并行运行,所有这些计算机都对模型进行重复的小的改变,而不需要任何协调或同步」。

这篇论文被引用了将近2000次,证明它不仅对机器学习有影响,而且对计算机系统和优化领域也有影响。

同时值得注意的是,这篇论文的华人一作是Feng Niu,本科毕业于清华大学计算机系,博士毕业于威斯康星麦迪逊分校计算机系,目前担任苹果的研究科学家。

one more thing

大会还有很多有趣的地方,例如,一篇只有两个词的论文,被评为「题目最短」:Choice Bandits.

另外,英伟达研究开发了GAN训练的突破。一种名为ADA的新技术只需不到几千张训练图像就能生成高分辨率图像。

https://nips.cc/