深度学习经典收藏 | 开源数据集大汇总

点击上方“机器学习与生成对抗网络”,关注星标

获取有趣、好玩的前沿干货!

本文整理了国内外经典的开源数据,包含了目标检测、自动驾驶、人脸识别、自然语言处理、文本检测、医疗等方向,具体如下。

一、自动驾驶领域数据集

1. KITTI数据集

KITTI数据集由德国卡尔斯鲁厄理工学院和丰田美国技术研究院联合创办,是自动驾驶场景下的计算机视觉算法评测数据集。该数据集用于评测立体图像(stereo),光流(optical flow),视觉测距(visual odometry),3D物体检测(object detection)和3D跟踪(tracking)等计算机视觉技术在车载环境下的性能。

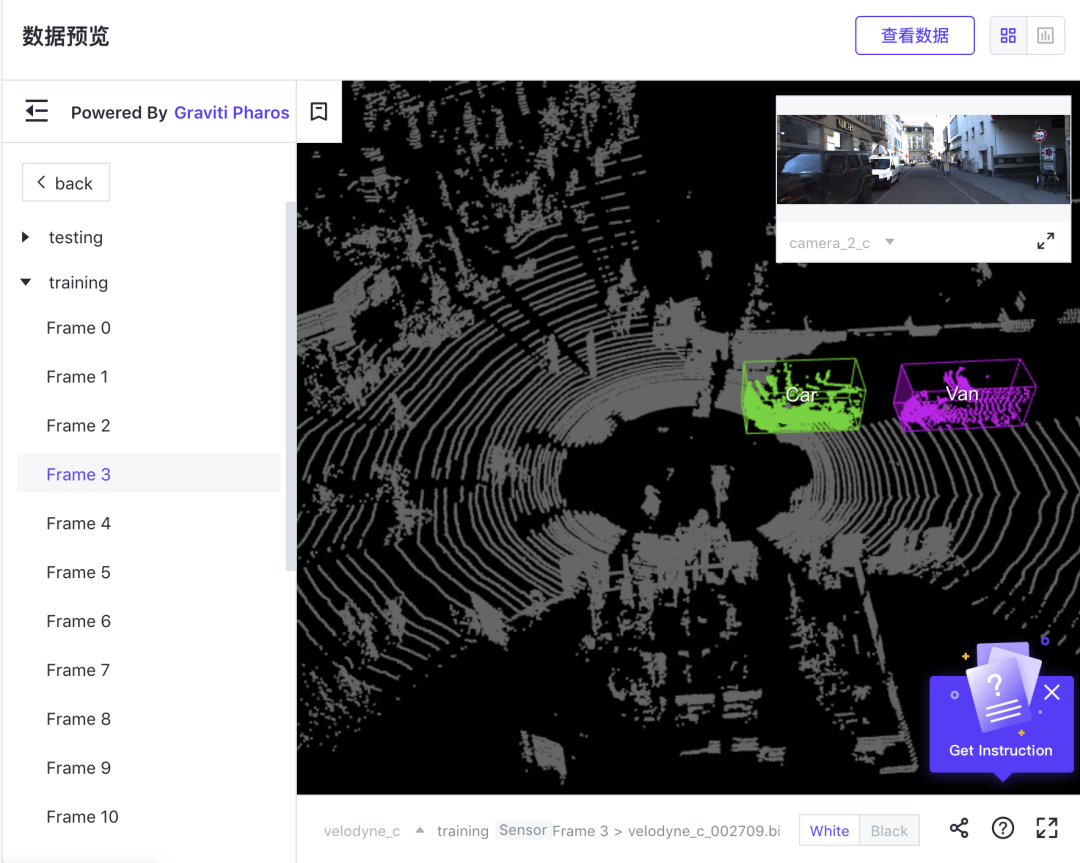

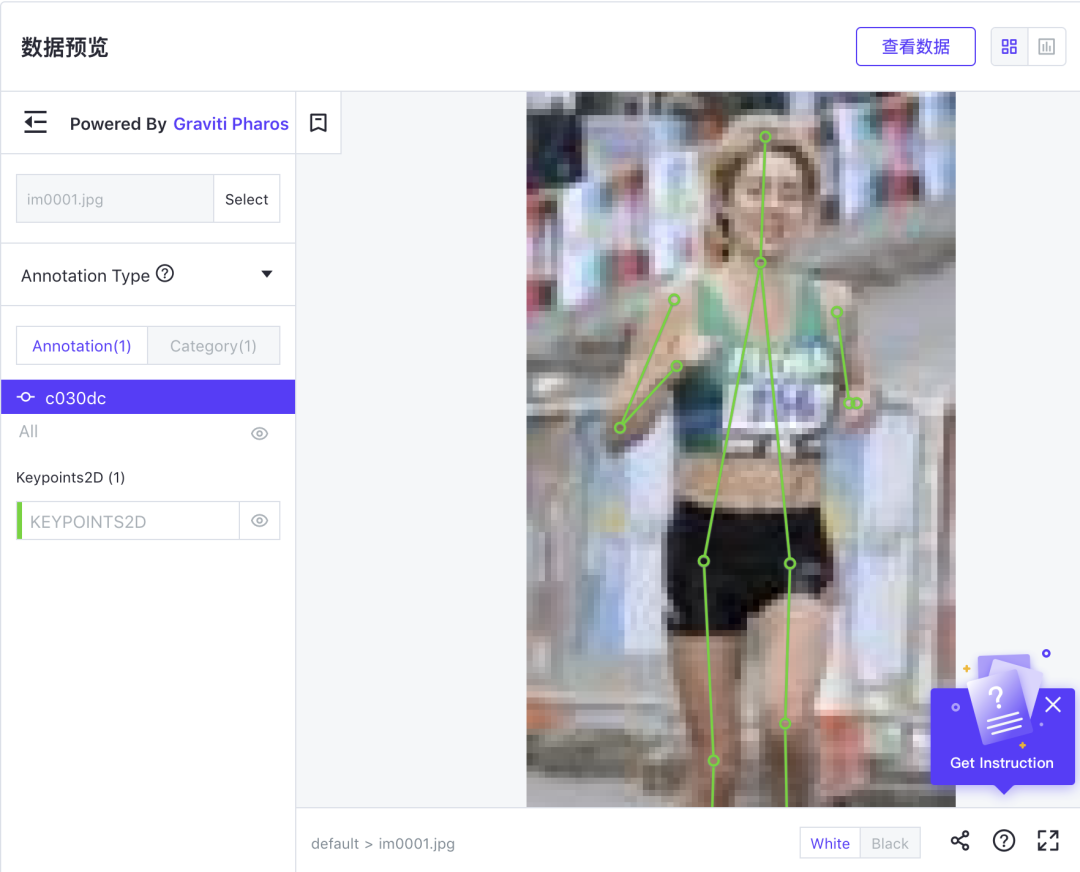

Kitti 标注情况,截取自Graviti数据可视化功能

KITTI包含市区、乡村和高速公路等场景采集的真实图像数据,每张图像中最多达15辆车和30个行人,还有各种程度的遮挡与截断。整个数据集由389对立体图像和光流图,39.2 km视觉测距序列以及超过200k 3D标注物体的图像组成 ,以10Hz的频率采样及同步。总体上看,原始数据集被分类为‘Road’, ‘City’, ‘Residential’, ‘Campus’ 和‘Person’。对于3D物体检测,label细分为car, van, truck, pedestrian, pedestrian(sitting), cyclist, tram以及misc组成。

数据集大小:312MB~440GBGraviti官网搜索「KITTI」查看更多相关数据集

获取地址:https://www.graviti.cn/open-datasets/

2.CityScapes数据集

CityScapes是由奔驰自动驾驶实验室、马克思·普朗克研究所、达姆施塔特工业大学联合发布的公开数据集,专注于对城市街景的语义理解。该数据集包含50个不同的城市,在不同的季节和天气条件下的街景中记录的各种立体视频序列,Cityscapes数据集共有fine和coarse两套评测标准,前者提供5000张精细标注的图像,后者提供5000张精细标注外加20000张粗糙标注的图像。

数据集大小:74.15GB

获取地址:https://gas.graviti.cn/dataset/graviti-open-dataset/CityScapes

3.BDD100K数据集

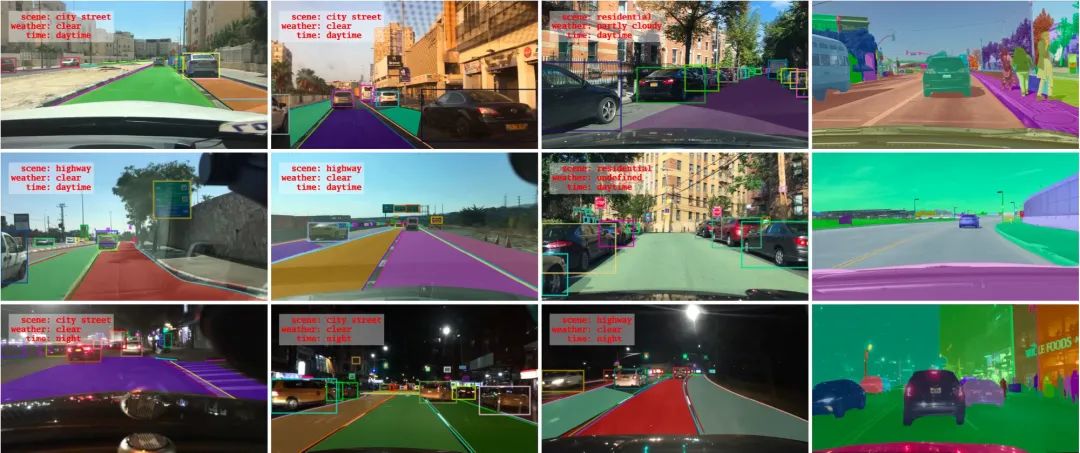

2018年5月伯克利大学AI实验室(BAIR)发布了公开驾驶数据集BDD100K,同时设计了一个图片标注系统。BDD100K 数据集包含10万段高清视频,每个视频约40秒\720p\30 fps 。每个视频的第10秒对关键帧进行采样,得到10万张图片(图片尺寸:1280*720 ),并进行标注。10万张图片中,包含了不同天气、场景、时间的图片,而且高清、模糊的图片都有,具有规模大,多样化的特点。

数据集大小:6.42GB

获取地址:https://gas.graviti.cn/dataset/data-decorators/BDD100K

4.nuScenes数据集

nuScenes数据集是由Motional(以前为nuTonomy)的团队开发的用于自动驾驶的公共大型数据集。Motional致力于实现安全,可靠和可达的无人驾驶环境。通过向公众发布部分数据,Motional旨在推进计算机视觉和自动驾驶的研究。

nuScenes数据集在波士顿和新加坡这两个城市收集了1000个驾驶场景,这两个城市交通繁忙,驾驶状况极具挑战性。nuScenes手动选择20秒长的场景,以显示各种驾驶操作,交通状况和意外行为。nuScenes收集了不同大洲的数据,能让我们进一步研究计算机视觉算法在不同位置,天气状况,车辆类型,植被,道路标记以及左右手交通之间的通用性。nuScenes完整的数据集包括约40万个关键帧中的140万个摄像机图像,39万个LIDAR扫描数据,1.4 M个RADAR扫描数据和1.4万个对象边界框。其扩展包nuScenes-lidarseg的40,000个点云和1000个场景(用于训练和验证的850个场景以及用于测试的150个场景)中包含了14亿个标注点。

数据集大小:547.98GB

获取地址:https://gas.graviti.cn/dataset/motional/nuScenes

二、目标检测数据集

图像语义分割是计算机视觉领域的经典任务之一,目的是将图像分割成几组具有某种特定语义含义的像素区域,并识别出每个区域的类别,最终获得具有像素语义标注的图像。下面为大家介绍几个常见的语义分割数据集。

1.COCO数据集

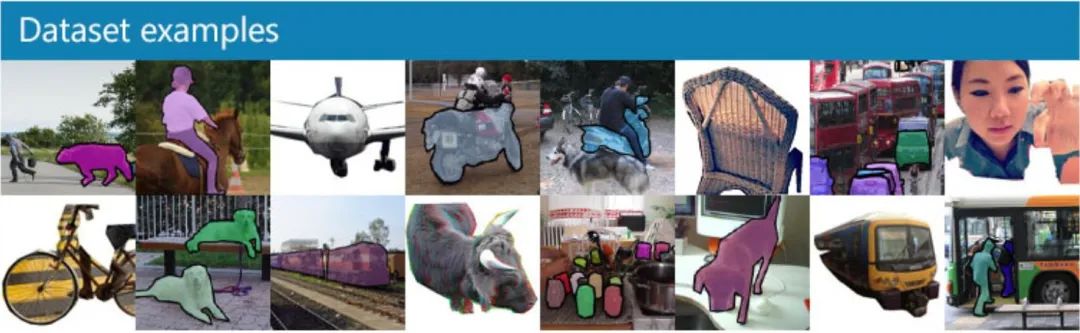

COCO的全称是Common Objects in Context,是微软团队提供的用来进行目标识别、图像分割等任务的数据集。

有如下几个特点:目标分割、上下文识别、超像素分割、330K图像(已标记> 200K)、150万个对象实例、80个对象类别、91个物品类别、每个图像5个字幕、250,000包含关键点的人。

COCO数据集支持目标检测、实例分割、全景分割、Stuff Segmentation、关键点检测、看图说话等任务类型。图片格式均为JPG格式,其中目标检测,实例分割任务对应的图像类别为80类;Stuff Segmentation,全景分割任务新增图像类别53类。

数据大小:83.39GB

获取地址:https://gas.graviti.cn/dataset/shannont/COCO

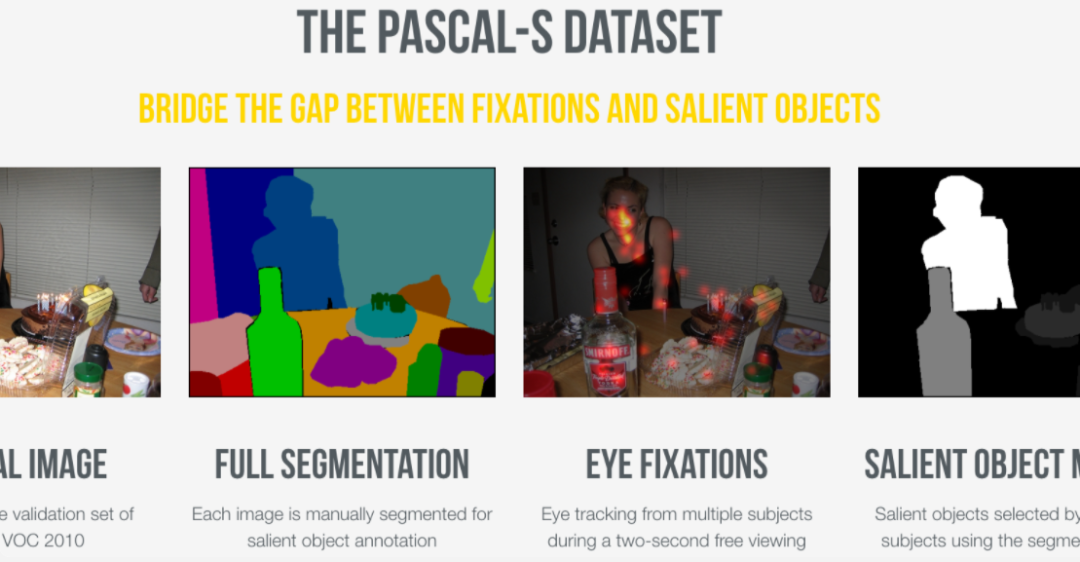

2.PASCAL VOC数据集

PASCAL VOC挑战赛 (The PASCAL Visual Object Classes )是一个世界级的计算机视觉挑战赛, 很多优秀的计算机视觉模型比如分类,定位,检测,分割,动作识别等模型都是基于PASCAL VOC挑战赛及其数据集上推出的,尤其是一些目标检测模型(比如大名鼎鼎的R CNN系列,以及后面的YOLO,SSD等)。

从2005年到2012年,VOC挑战赛每年组织一次。每年的内容都有所不同,从最开始的分类,到后面逐渐增加目标分类、目标检测、目标分割、人体布局、动作识别等内容,数据集的容量以及种类也在不断的增加和改善。

对于现在的研究者来说比较重要的两个年份的数据集是 PASCAL VOC 2007 与 PASCAL VOC 2012。PASCAL VOC 2012数据集是在2007年的基础上增加而来的,包含4个大类和20个小类。

3.OpenImage数据集

Open Image是一个由Google发布的包含约900万张图像URL的数据集,里面的图片通过标签注释被分为6000多类。该数据集中的标签要比ImageNet(1000类)包含更真实生活的实体存在,它足够让我们从头开始训练深度神经网络。

数据大小:671.41GB

获取地址:https://gas.graviti.cn/dataset/shannont/OpenImages_v6

三、人脸识别类数据集

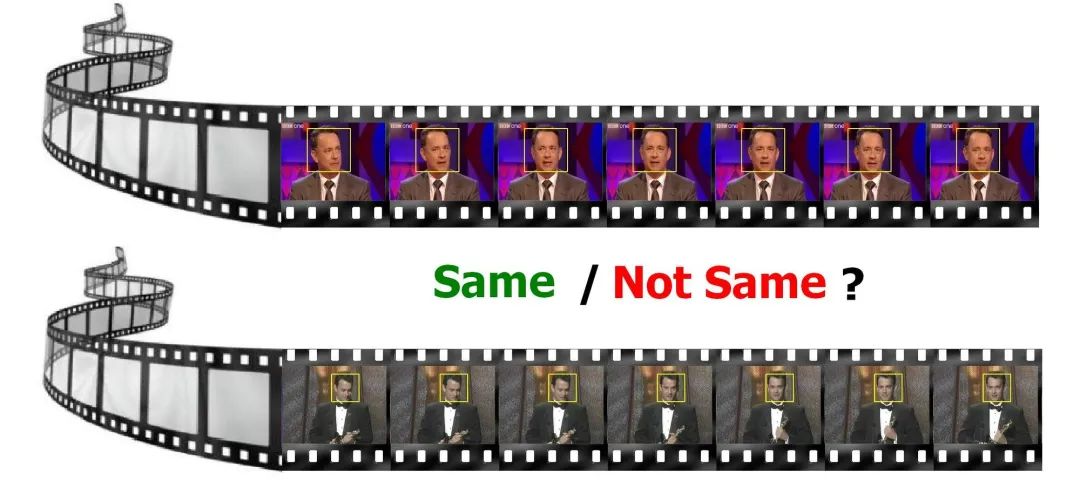

1.YouTube Face DB数据集

YouTube Face是一个人脸视频数据库,旨在研究视频中,非受限情况下的人脸识别的问题。数据集包含1,595个不同人的3,425个视频,都是从YouTube下载的。每个主题平均包含2.15个视频。视频剪辑持续时间最短为48帧,最长为6,070帧,平均长度为181.3帧。

数据集大小:671.41GB

获取地址:https://gas.graviti.cn/dataset/shannont/YouTubeFacesDB

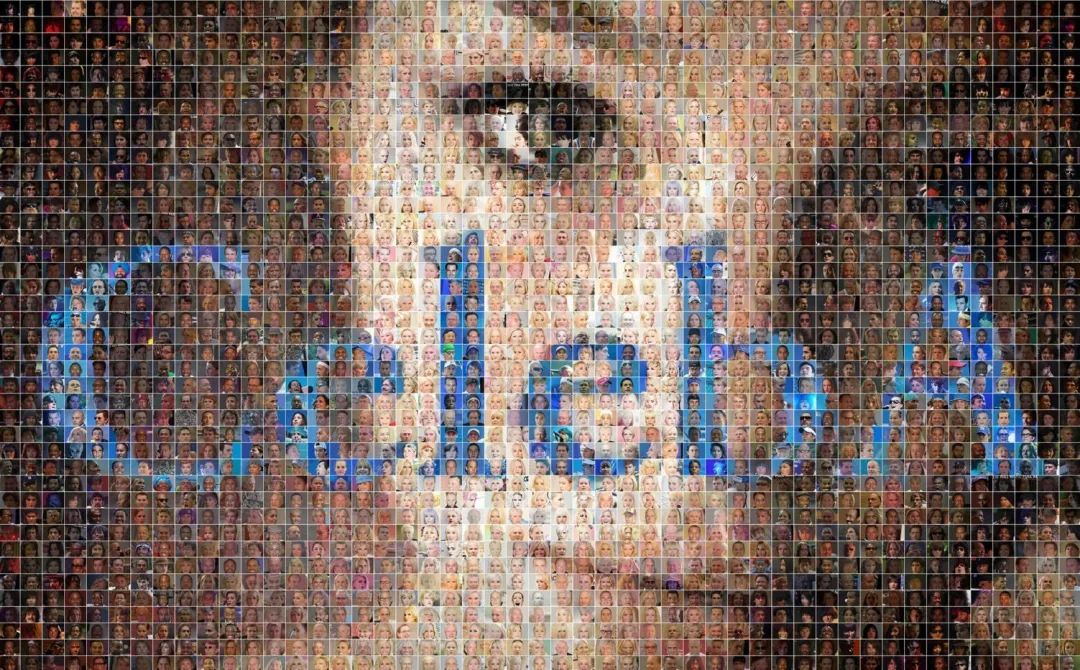

2.CelebA数据集

CelebFaces属性数据集(CelebA)是一个大规模的面部属性数据集,其中包含超过20万名人图像,每个图像都有40个属性注释。该数据集中的图像涵盖了较大的姿势变化和背景杂波。

CelebA具有多种多样,数量众多且注释丰富的特点,包括:

10,177个不同的ID 202,599张人脸图像 该数据集可用作以下计算机视觉任务的训练和测试集:面部属性识别,面部检测,五官(或面部部分)定位以及面部编辑和合成。

数据集大小:9.55 GB

获取地址:https://gas.graviti.cn/dataset/shannont/CelebA

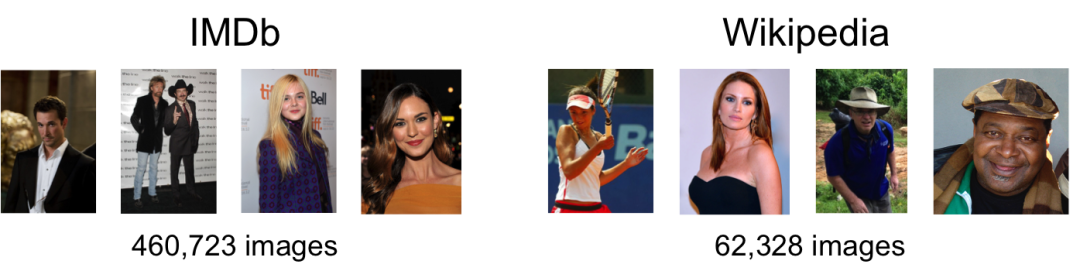

3.IMDB-WIKI数据集

IMDB-WIKI人脸数据库是有IMDB数据库和Wikipedia数据库组成,其中IMDB人脸数据库包含了460,723张人脸图片,而Wikipedia人脸数据库包含了62,328张人脸数据库,总共523,051张人脸数据库,IMDB-WIKI人脸数据库中的每张图片都被标注了人的年龄和性别,对于年龄识别和性别识别的研究有着重要的意义。

数据集大小:276.23GB

获取地址:https://gas.graviti.cn/dataset/hello-dataset/IMDbWiki

4.LFW数据集

LFW (Labeled Faces in the Wild) 人脸数据库是由美国马萨诸塞州立大学阿默斯特分校计算机视觉实验室整理完成的数据库,主要用来研究非受限情况下的人脸识别问题。是目前人脸识别的常用测试集,其中提供的人脸图片均来源于生活中的自然场景,因此识别难度会增大,尤其由于多姿态、光照、表情、年龄、遮挡等因素影响导致即使同一人的照片差别也很大。并且有些照片中可能不止一个人脸出现,对这些多人脸图像仅选择中心的人脸作为目标,其他区域的视为背景干扰。

LFW数据集主要是从互联网上搜集图像,共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片,其中有1680 人包含两个以上的人脸图像。每张图片的尺寸为250X250,绝大部分为彩色图像,也存在少许黑白人脸图片。

数据集大小:1.29GB

获取地址:https://gas.graviti.cn/dataset/graviti-open-dataset/LFW

四、人体姿态估计类数据集

1.LSP数据集

Leeds Sports Pose 是由利兹大学计算机学院于 2010 年发布的一个体育姿势数据集。被分为竞技、羽毛球、棒球、体操、跑酷、足球、排球和网球几类,共包含约 2000 个姿势注释,图像均来自于 Flickr 。通过对图像进行缩放,聚焦的人物长度约 150 像素,并且每个图像都带有14个关节位置的注释,其左侧和右侧关节始终“以本人的视角”进行标记。

数据集标注情况,截取自Graviti数据可视化功能

数据大小:33.78MB

获取地址:https://gas.graviti.cn/dataset/data-decorators/LeedsSportsPose

2.FLIC数据集

FLIC(Frames Labeled In Cinema)数据集由宾夕法尼亚大学-工程与应用科学学院 GRASP 实验室于 2013 年发布。该数据集是从好莱坞流行电影中自动收集的图像数据集,包含5003张图像。这些图像截取了30部电影的整十倍的帧数,通过最先进的人物检测器获得。每个图像由五个人标注10个上半身关节。此外,图像中拥有 5 个中值标记以保证异常值注释具有鲁棒性。最后,如果该人被遮挡或严重不正面,将被手动删除。

数据集大小:1.38GB

获取地址:https://gas.graviti.cn/dataset/data-decorators/FLIC

3.MPII Human Pose数据集

MPII Human Pose人体姿势数据集是人体姿势预估的一个 benchmark。数据集中包含约25000张标注图像,标注人数超过 4万人,涵盖了410中人类活动。这些图像是从 YouTube video 中抽取出来的。此外,在测试集中还收录了身体部位遮挡、3D 躯干、头部方向的标注。

数据集大小:11.26GB

获取地址:https://gas.graviti.cn/dataset/shannont/MPIIHumanPose

五、文本检测类数据集

1.MNIST数据集

MNIST是深度学习领域的“Hello World!”。MNIST是一个手写数字数据库,有60000个训练样本集和10000个测试样本集,每个样本图像的宽高为28*28。此数据集是以二进制存储的,不能直接以图像格式查看,不过很容易找到将其转换成图像格式的工具。

数据集大小:12MB

获取地址:https://gas.graviti.cn/dataset/data-decorators/MNIST

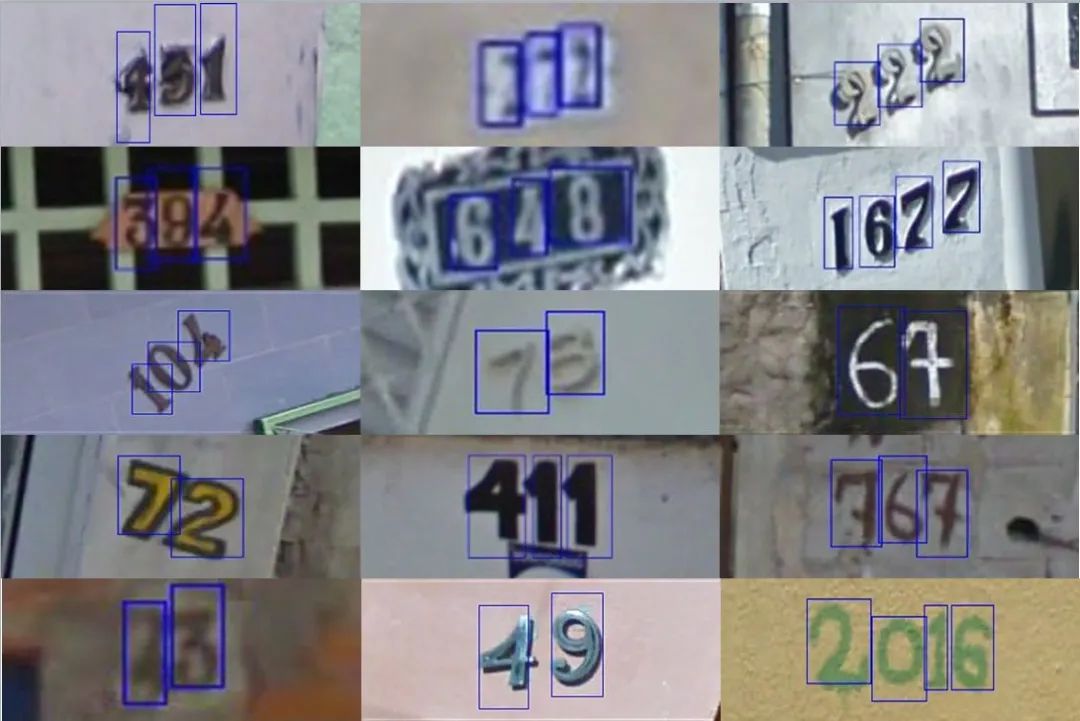

2.SVHN数据集

SVHN是从Google街景图像中的门牌号获得的一个来自现实世界的图像数据集,用于开发机器学习和对象识别算法,同时对数据预处理和格式化的要求最低。它的风格与MNIST相似,但有更多数量级的标记数据(超过600,000位数字图像),并且希望解决一个更加困难,难以解决的现实问题(识别自然场景图像中的数字)。

数据集中包含10个类别,数字1~9对应标签1~9,而“0”的标签则为10。训练集中共有73257张图像,测试集中有26032张图像。

数据集格式:带有字符级边界框的原始图像。

数据集大小:3.92GB

获取地址:https://gas.graviti.cn/dataset/data-decorators/SVHN

3.CCPD数据集

CCPD(Chinese City Parking Dataset)数据集是一个用于车牌识别的大型国内停车场车牌数据集,是由中科大团队建立的。该数据集在合肥市的停车场采集得来,采集时间早上7:30到晚上10:00。停车场采集人员手持Android POS机对停车场的车辆拍照并手工标注车牌位置。拍摄的车牌照片涉及多种复杂环境,包括模糊、倾斜、阴雨天、雪天等等。CCPD数据集一共包含将近30万张图片,每种图片大小720x1160x3。一共包含8项,具体如下:

数据集大小:23.48GB

获取地址:https://gas.graviti.cn/dataset/data-decorators/CCPD

六、NLP数据集

1.common voice数据集【ASR】

Common Voice 是 Mozilla 发起的一项倡议,旨在推进语音识别技术,更广泛地为大众服务。Common Voice 也是一套庞大的数据库,收录了全球各地贡献的语音数据,让任何人都可以更快更轻松地训练支持所有语言的语音识别程序。除了应用最广泛的语言,common voice还收集了使用人数较少的语种语音样本。一套丰富而又公开的语音数据集能够帮助开发者、创业者以及各个社区缩小语言规模的鸿沟。

该数据集当前有 5,671 小时,54 种语言的语音数据。数据集中的每一条都包含了一组独立 MP3 录音及相应的文本文件。数据集所记录的 7,226 小时的录音中,有许多条数据同时包含了年龄、性别、口音等人口统计元数据,能够训练语音识别引擎提升其准确性。

数据集大小:50.06GB

获取地址:https://gas.graviti.cn/dataset/hello-dataset/CommonVoiceCN

2.LibriSpeechASR 数据集【ASR】

公开数据集中最常用的英文语料,其中包含了1000小时的16kHz有声书录音,这些数据来自LibriVox项目的有声读物。数据都经过切割和整理成每条10秒左右的、经过文本标注的音频文件,非常适合入门使用。

数据集大小:140.02GB

获取地址:https://gas.graviti.cn/dataset/hello-dataset/LibriSpeechASR

3. 20NewsGroups 数据集【文本分类】

20newsgroups数据集是用于文本分类、文本挖据和信息检索研究的国际标准数据集之一。数据集收集了大约20,000左右的新闻组文档,均匀分为20个不同主题的新闻组集合。一些新闻组的主题特别相似,还有一些却完全不相关。

20newsgroups数据集有三个版本。第一个版本19997是原始的并没有修改过的版本。第二个版本bydate是按时间顺序分为训练(60%)和测试(40%)两部分数据集,不包含重复文档和新闻组名(新闻组,路径,隶属于,日期)。第三个版本18828不包含重复文档,只有来源和主题。

20news-19997.tar.gz –原始20 Newsgroups数据集

20news-bydate.tar.gz –按时间分类; 不包含重复文档和新闻组名(18846 个文档)

20news-18828.tar.gz– 不包含重复文档,只有来源和主题 (18828 个文档)

数据集大小:44.31MB

获取地址:https://gas.graviti.cn/dataset/data-decorators/Newsgroups20

4. Mandarin Chinese Scripted Speech Corpus 数据集【ASR】

此数据集包含了755个小时的中文普通话朗读音频和转写文本,由1080名说话人提供。

总时长为755小时的中文普通话朗读语音音频和转写文本,语料内容为日常用语、命令控制和短信。由 Magichub 社区开源。

获取地址:https://gas.graviti.cn/dataset/magichub/MAGICDATAMandarinChineseReadSpeechCorpus_1

七、医学类数据集

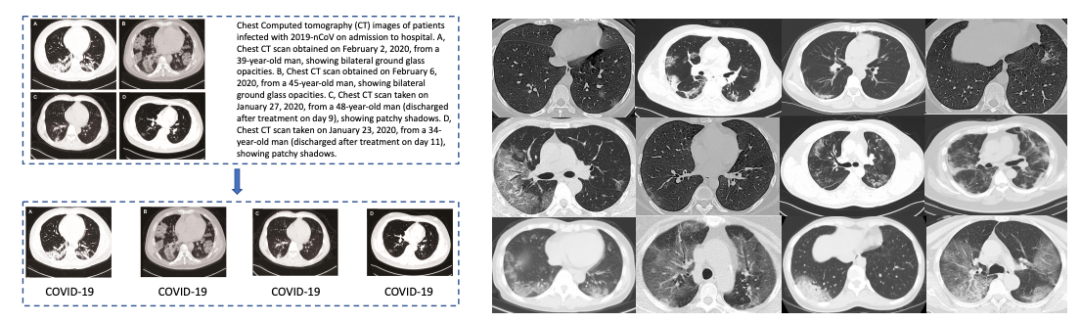

COVID-CT数据集

该数据集的图像是从medRxiv,bioRxiv,NEJM,JAMA,Lancet等与COVID19相关的论文中收集的。COVID-CT-Dataset包含来自216位COVID-19患者的349张CT图像和439张非患者的CT。图像中,还收集了从论文中提取的元信息,如患者年龄、性别、位置、病史、扫描时间、COVID-19的严重程度和放射学报告。

数据集大小:370.82MB

获取地址:https://gas.graviti.cn/dataset/data-decorators/COVID_CT

猜您喜欢:

CVPR 2021 | GAN的说话人驱动、3D人脸论文汇总

附下载 |《TensorFlow 2.0 深度学习算法实战》

附下载 | 超100篇!CVPR 2020最全GAN论文梳理汇总!