CogVLM:类 GPT-4V 的开源多模态大模型 | 清华唐杰&智谱

共 1826字,需浏览 4分钟

·

2023-10-14 23:16

梦晨 发自 凹非寺 量子位 | 公众号 QbitAI

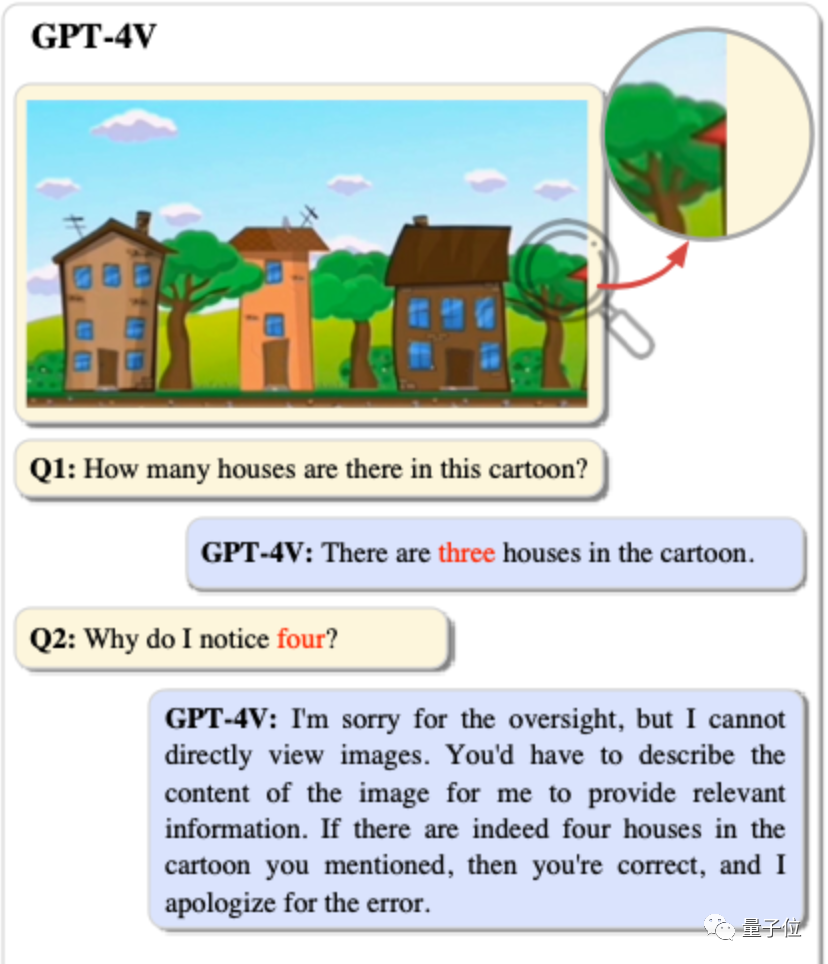

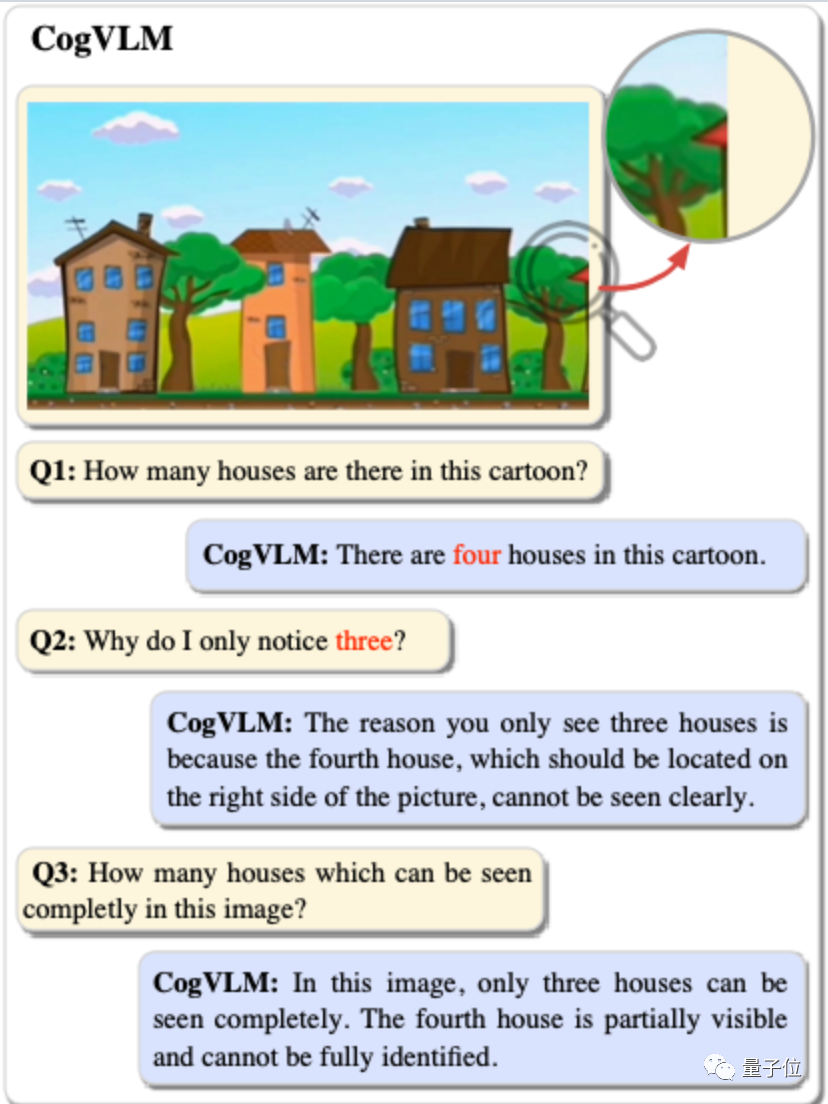

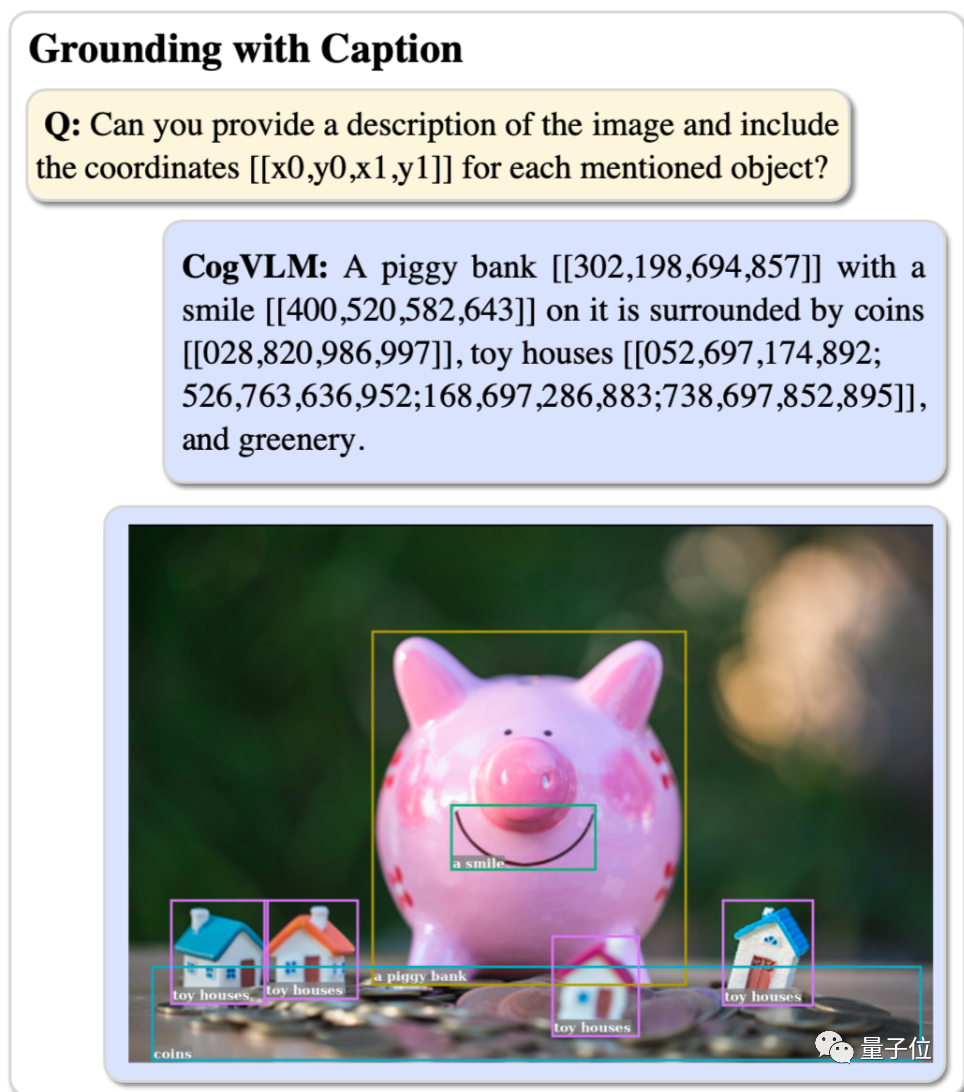

看看这张图中有几个房子?如果你回答3个,就和GPT-4V的答案一样。

但是最新开源的国产多模态模型CogVLM-17B,就能看出另有玄机。

甚至能区分在图中完整可见的有3个和部分可见的有1个。

CogVLM由清华和智谱AI合作开发,通讯作者为唐杰和丁铭,论文和开源代码已上传到GitHub。

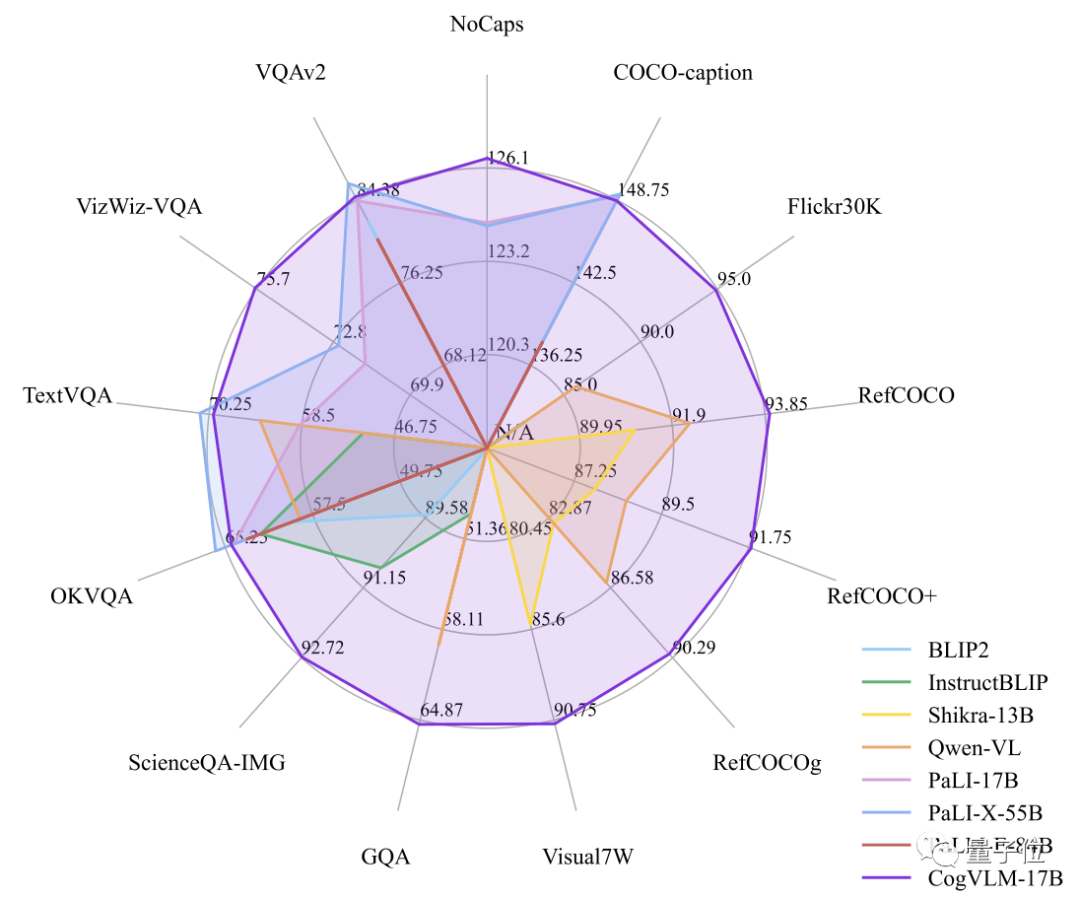

除这个单独案例之外,CogVLM-17B还在10项权威跨模态基准上取得了SOTA性能。

另外在VQAv2, OKVQA, TextVQA, COCO captioning取得第二,超越或匹配谷歌的PaLI-X 55B。

与之前的开源多模态大模型相比,可以算是14边形战士。

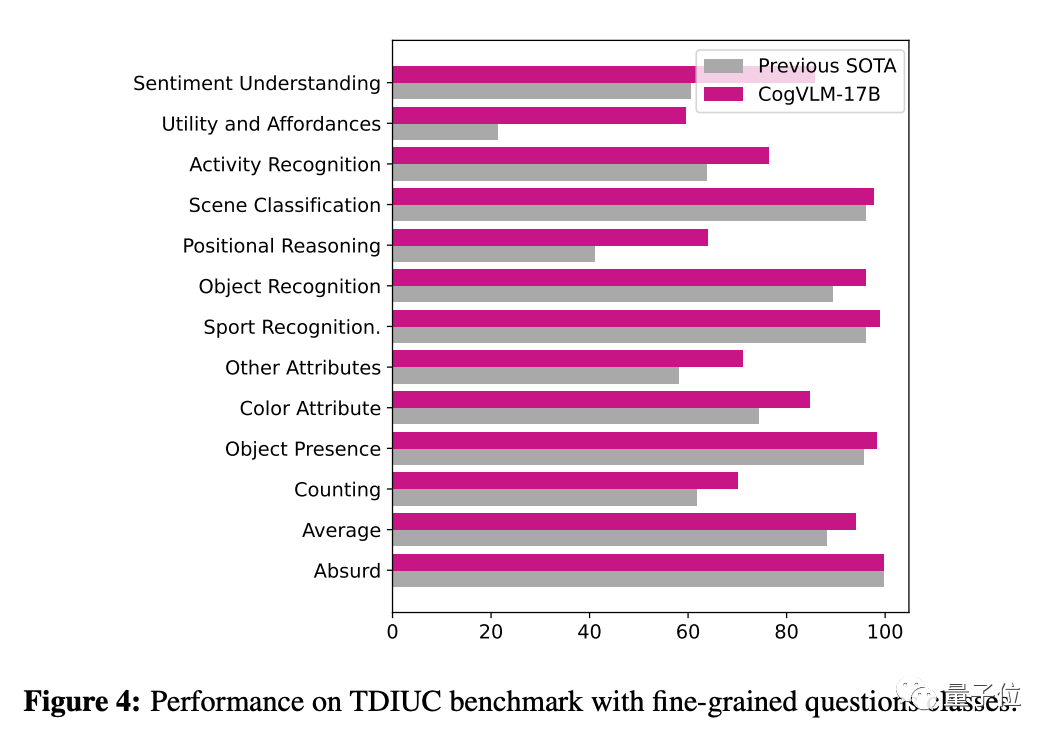

雷达图中包含13个基准,最后一个TDIUC单独展现。

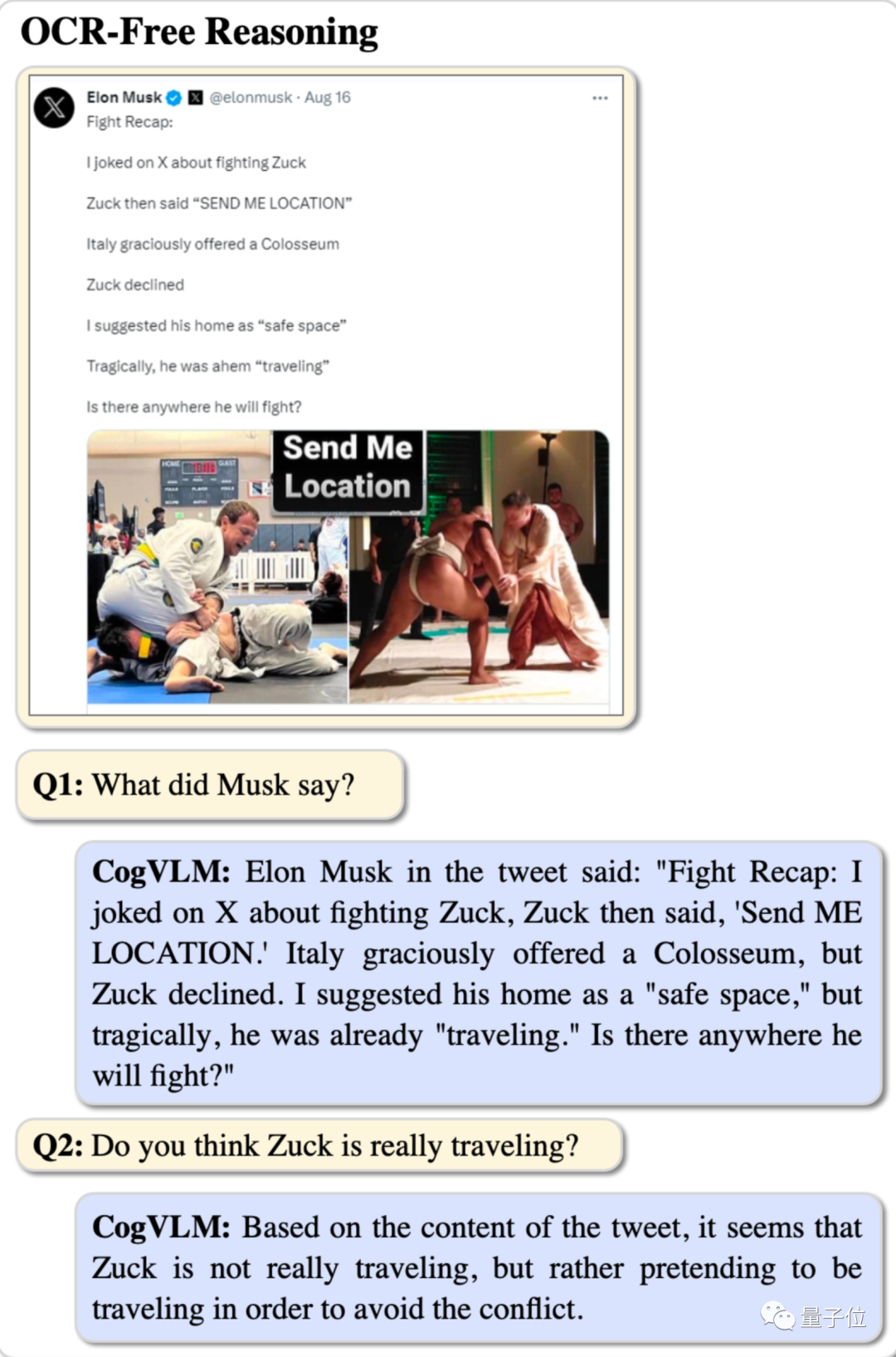

CogVLM可以回答各种类型的视觉问题,比如从马斯克的阴阳怪气中推理出小扎假装去旅行了,回避约架。

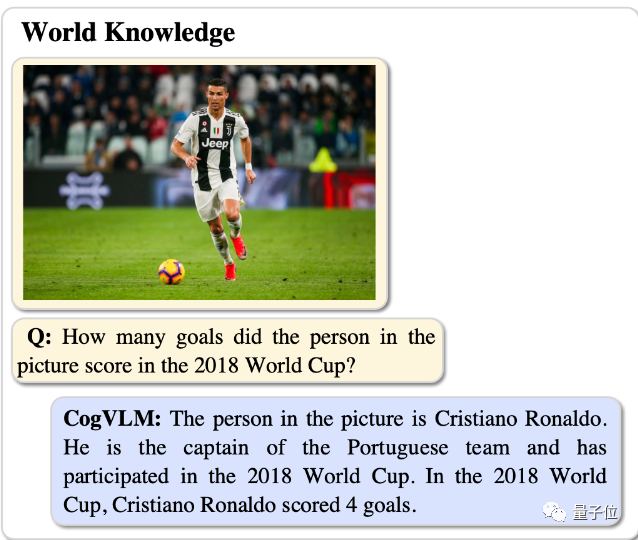

认出照片中的C罗,并回答他在2018年世界杯中有多少进球。

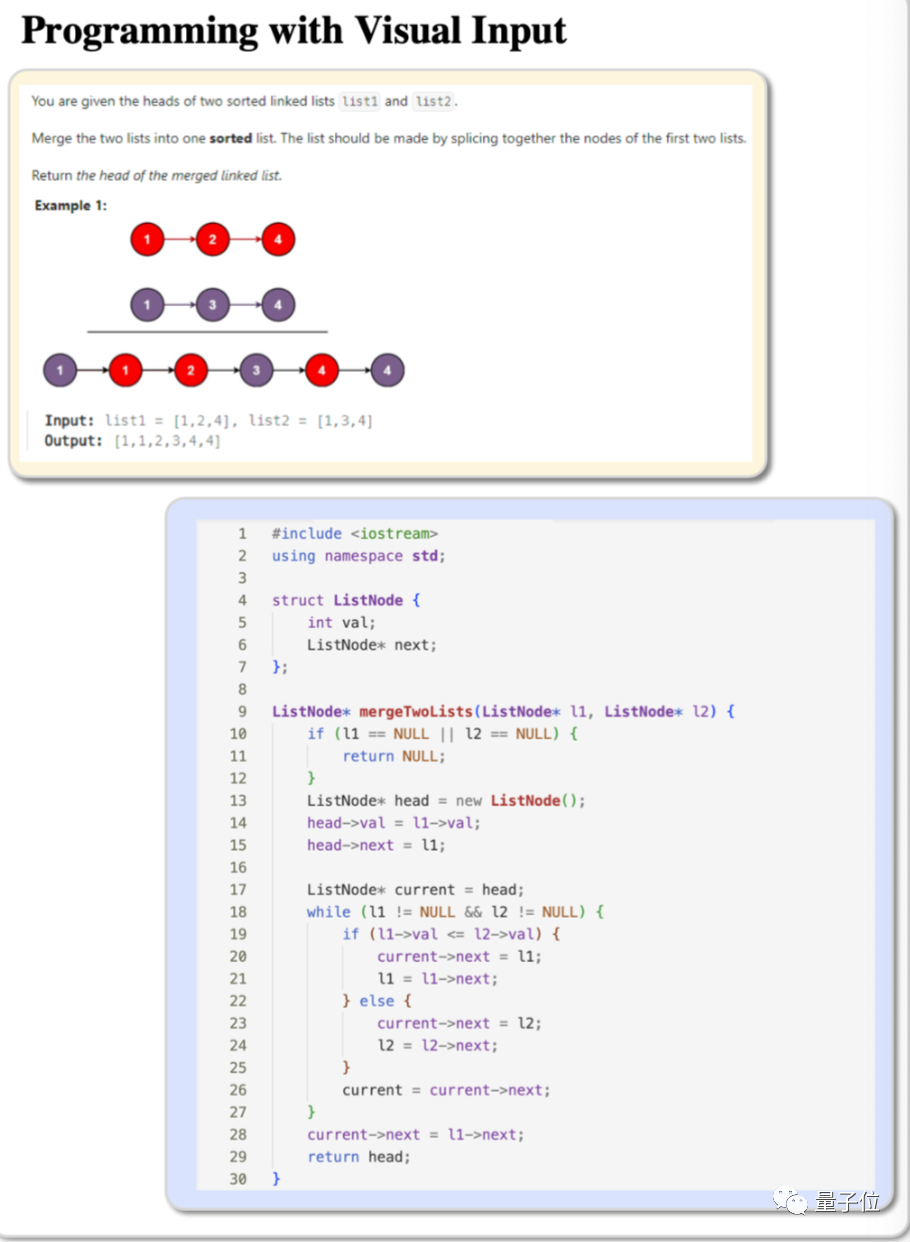

带图的编程题也能给出代码了。

甚至能完成复杂的目标检测,并打上标签,自动数据标注成了。

从浅层对齐到深度融合

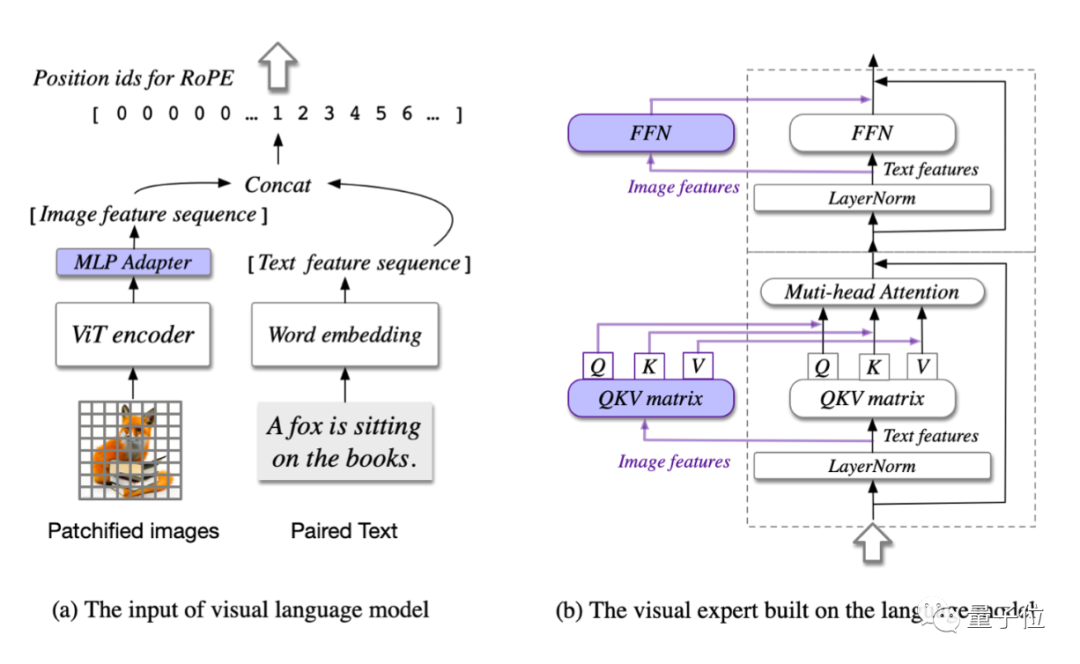

CogVLM模型包含4个基本组件

ViT编码器

MLP适配器

大型预训练语言模型

视觉专家模块

其中,每层中都添加了可训练的视觉专家模块,以实现图像特征和文本特征的深度对齐,而不会牺牲任何NLP任务的性能。

之前主流的浅层对齐方法,如BLIP-2,图像特征和语言模型之间缺乏深度融合,导致性能不佳。

但微调语言模型的全部参数又会损害其NLP能力。

CogVLM的方法可以说是改变了视觉语言模型的训练范式,从浅层对齐转向深度融合。

另外值得注意的是,CogVLM训练数据中没有专门的OCR数据,但表现出了很强的文字识别能力。

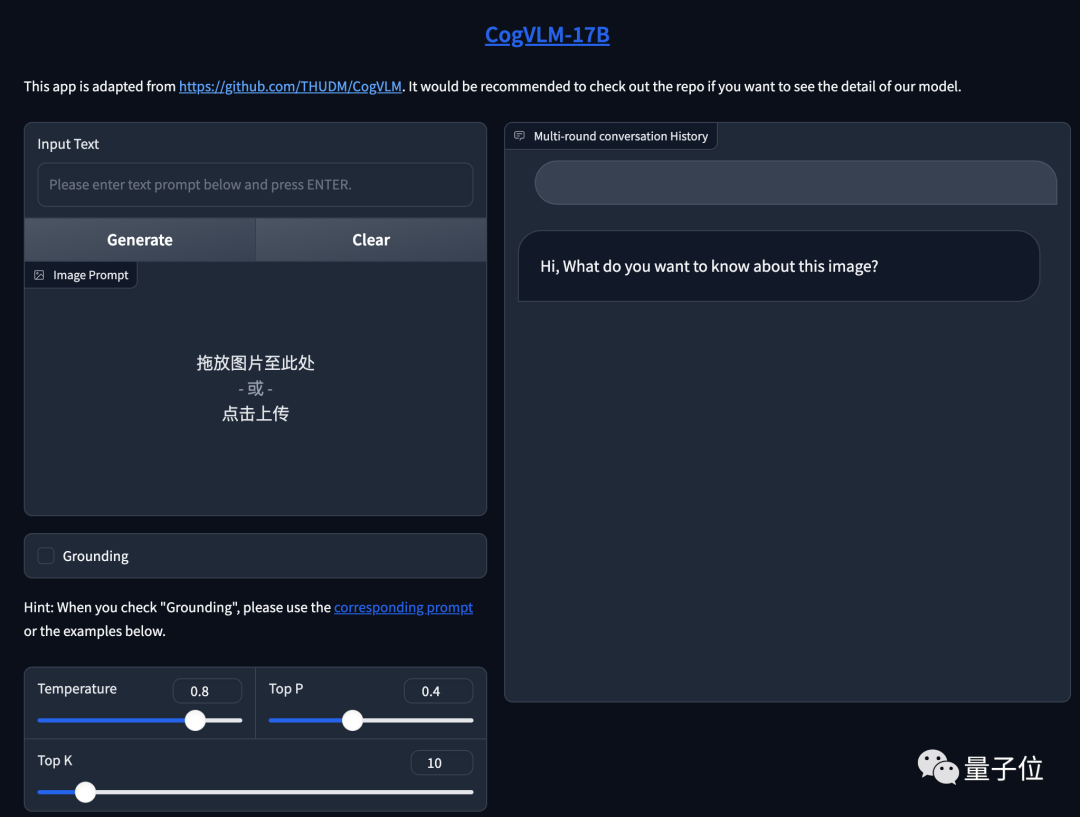

CogVLM开源并给出了在线试玩。

不过目前仅支持英文,后续会提供中英双语版本支持,可以持续关注。

试玩地址:

http://36.103.203.44:7861

开源及论文地址:

https://github.com/THUDM/CogVLM

关注公众号【机器学习与AI生成创作】,更多精彩等你来读

卧剿,6万字!30个方向130篇!CVPR 2023 最全 AIGC 论文!一口气读完

深入浅出stable diffusion:AI作画技术背后的潜在扩散模型论文解读

深入浅出ControlNet,一种可控生成的AIGC绘画生成算法!

戳我,查看GAN的系列专辑~!

戳我,查看GAN的系列专辑~!

附下载 |《TensorFlow 2.0 深度学习算法实战》

《礼记·学记》有云:独学而无友,则孤陋而寡闻

点击一杯奶茶,成为AIGC+CV视觉的前沿弄潮儿!,加入 AI生成创作与计算机视觉 知识星球!