神器 Nginx 的学习手册 ( 建议收藏 )

原文链接:https://reurl.cc/5oOQ3R

01

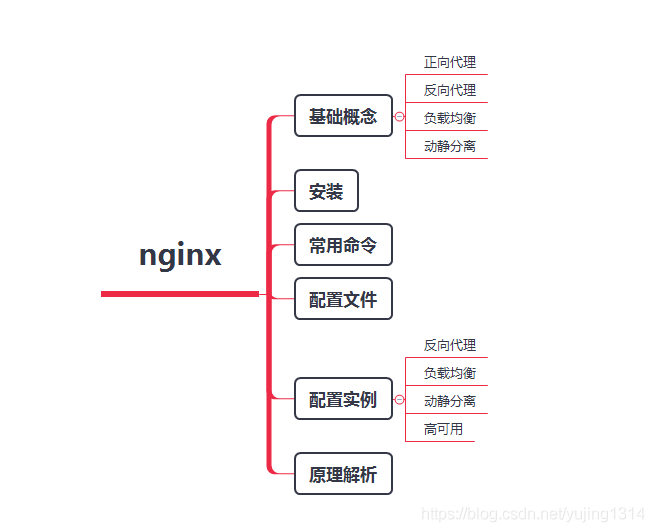

Nginx 知识网结构图

Nginx 的知识网结构图如下:

02

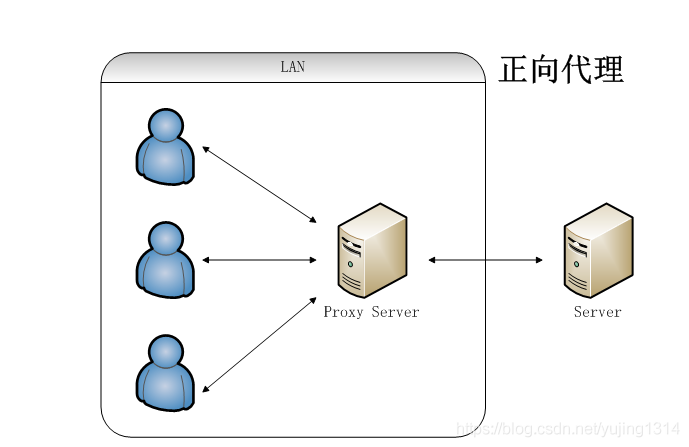

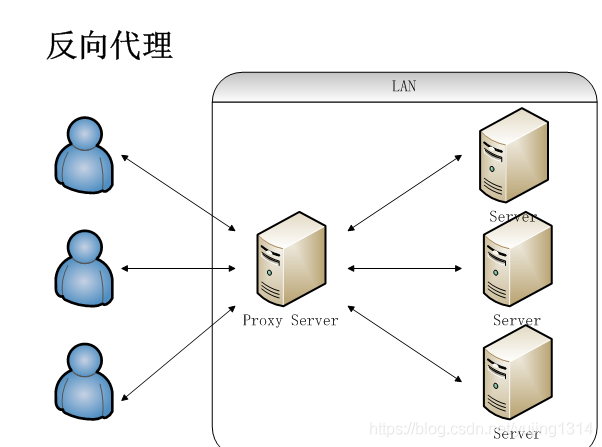

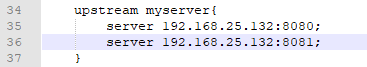

反向代理

04

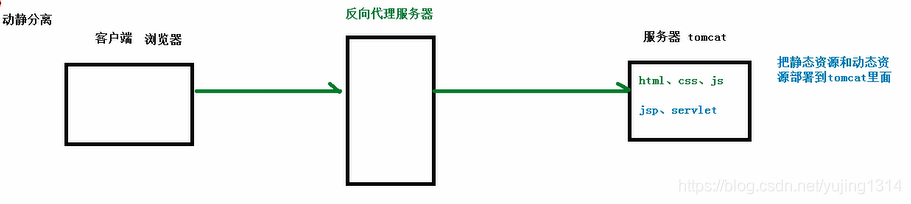

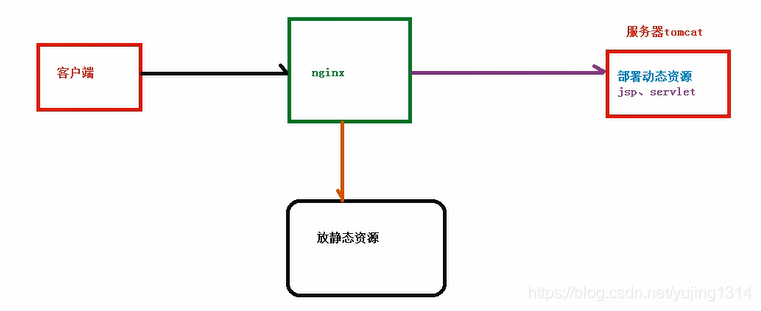

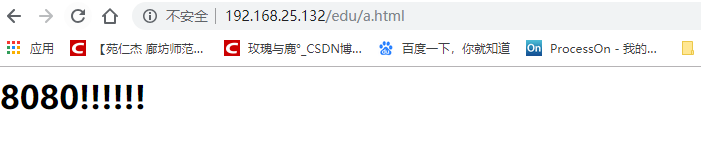

动静分离

Nginx 如何在 Linux 安装

https://blog.csdn.net/yujing1314/article/details/97267369

Nginx 常用命令

./nginx -v

./nginx

./nginx -s stop

./nginx -s quit

./nginx -s reload

Nginx 的配置文件

①全局块

②events 块

③HTTP 块

location[ = | ~ | ~* | ^~] url{

}

=:用于不含正则表达式的 url 前,要求字符串与 url 严格匹配,匹配成功就停止向下搜索并处理请求。 ~:用于表示 url 包含正则表达式,并且区分大小写。 ~*:用于表示 url 包含正则表达式,并且不区分大小写。 ^~:用于不含正则表达式的 url 前,要求 Nginx 服务器找到表示 url 和字符串匹配度最高的 location 后,立即使用此 location 处理请求,而不再匹配。 如果有 url 包含正则表达式,不需要有 ~ 开头标识。

07

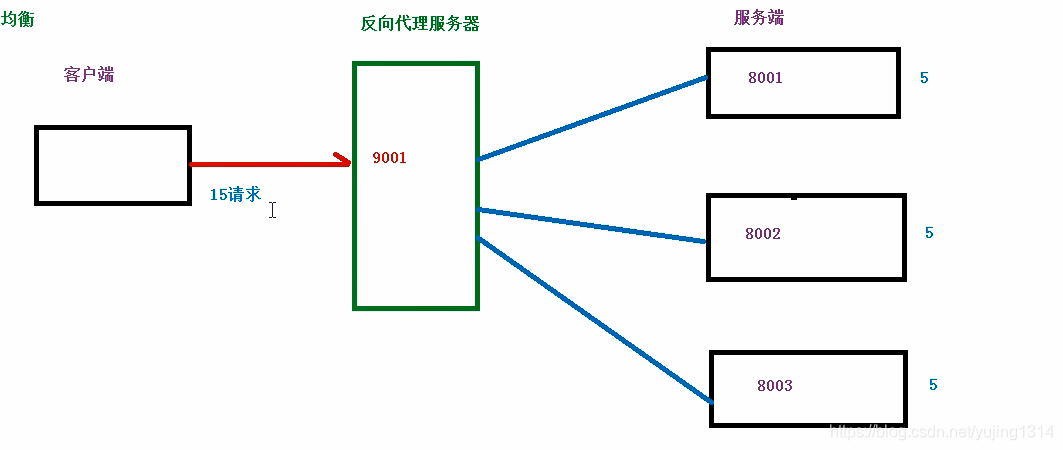

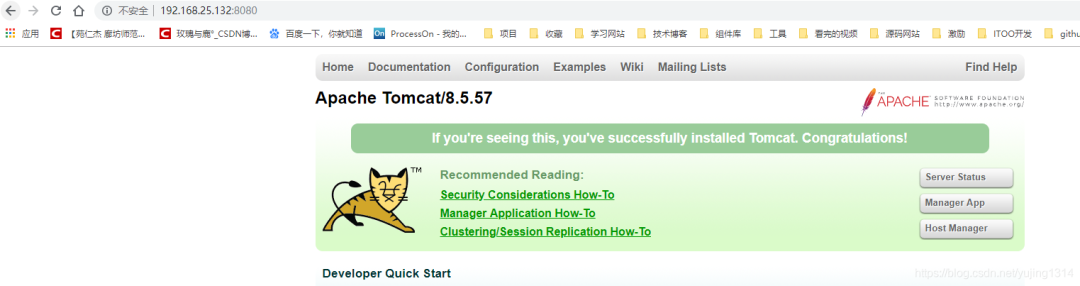

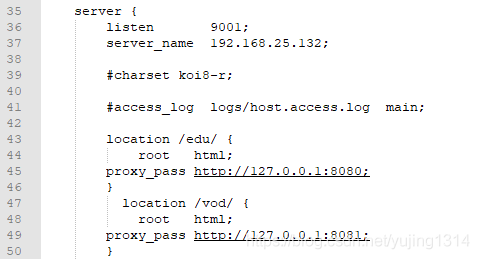

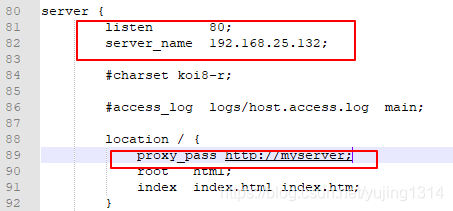

反向代理实战

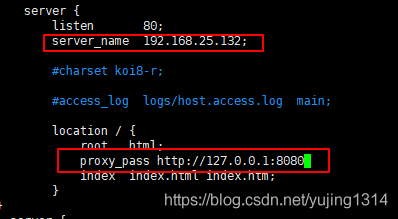

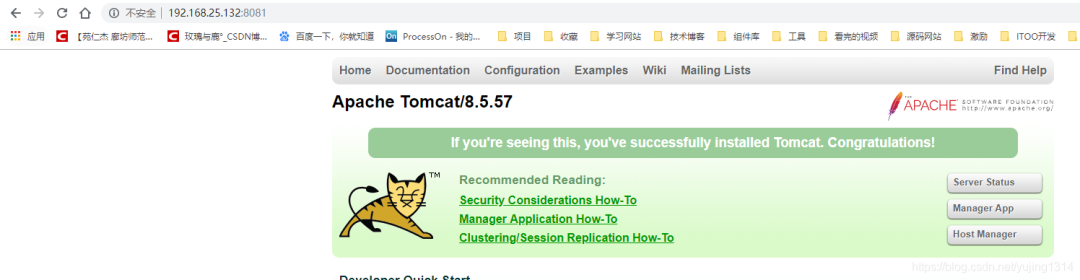

①配置反向代理

访问 http://192.168.25.132:9001/edu/ 直接跳转到 192.168.25.132:8080 访问 http://192.168.25.132:9001/vod/ 直接跳转到 192.168.25.132:8081

./nginx -s reload

192.168.25.132 www.123.com。

访问 http://192.168.25.132:9001/edu/ 直接跳转到 192.168.25.132:8080 访问 http://192.168.25.132:9001/vod/ 直接跳转到 192.168.25.132:8081

./nginx -s reload

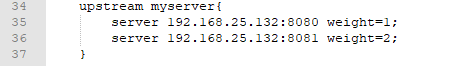

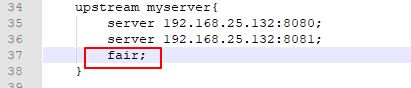

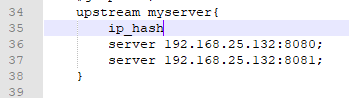

轮询(默认)。 weight,代表权,权越高优先级越高。 fair,按后端服务器的响应时间来分配请求,相应时间短的优先分配。 ip_hash,每个请求按照访问 ip 的 hash 结果分配,这样每一个访客固定的访问一个后端服务器,可以解决 Session 的问题。

09

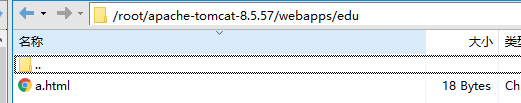

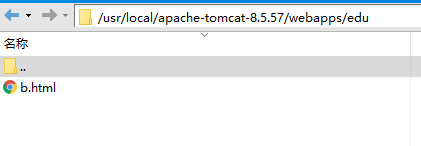

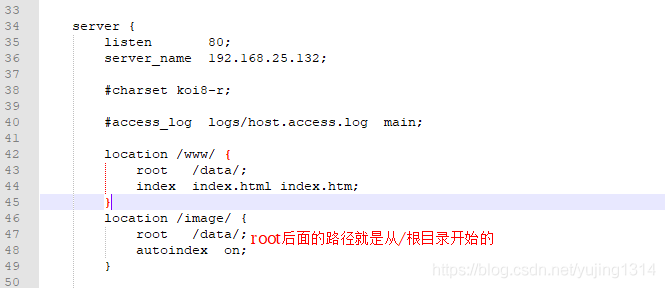

动静分离实战

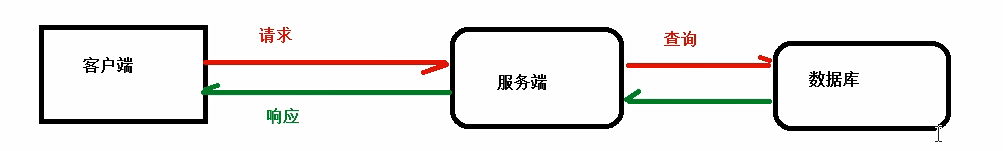

什么是动静分离?把动态请求和静态请求分开,不是讲动态页面和静态页面物理分离,可以理解为 Nginx 处理静态页面,Tomcat 处理动态页面。

纯粹将静态文件独立成单独域名放在独立的服务器上,也是目前主流方案。 将动态跟静态文件混合在一起发布,通过 Nginx 分开。

动静分离图析:

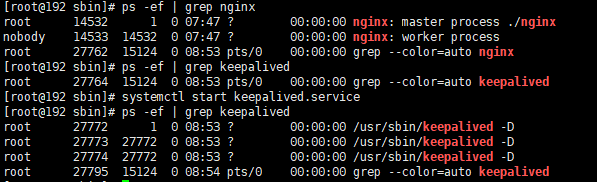

Nginx 高可用

两台 Nginx 服务器 安装 Keepalived 虚拟 ip

安装 Keepalived:

[root@192 usr]# yum install keepalived -y

[root@192 usr]# rpm -q -a keepalived

keepalived-1.3.5-16.el7.x86_64

[root@192 keepalived]# cd /etc/keepalived

[root@192 keepalived]# vi keepalived.conf

smtp_server 192.168.25.147(主)smtp_server 192.168.25.147(备) state MASTER(主) state BACKUP(备)

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 192.168.25.147

smtp_connect_timeout 30

router_id LVS_DEVEL # 访问的主机地址

}

vrrp_script chk_nginx {

script "/usr/local/src/nginx_check.sh" # 检测文件的地址

interval 2 # 检测脚本执行的间隔

weight 2 # 权重

}

vrrp_instance VI_1 {

state BACKUP # 主机MASTER、备机BACKUP

interface ens33 # 网卡

virtual_router_id 51 # 同一组需一致

priority 90 # 访问优先级,主机值较大,备机较小

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.25.50 # 虚拟ip

}

}

[root@192 sbin]# systemctl start keepalived.service

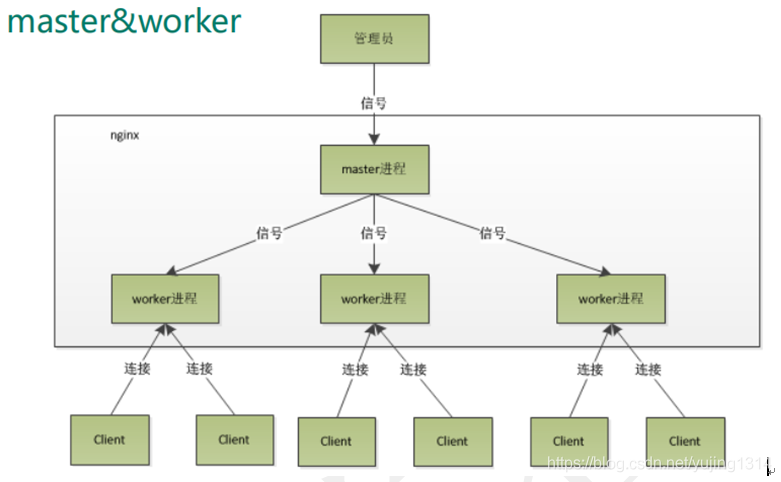

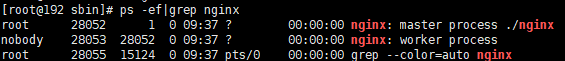

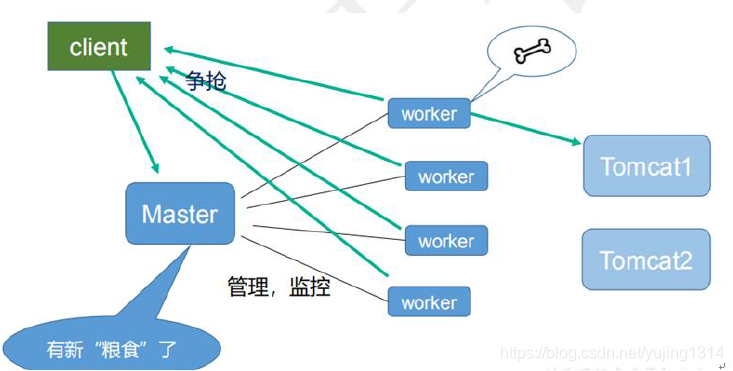

原理解析

- END -

推荐阅读 31天拿下K8S含金量最高的CKA+CKS证书! 运维必备的DevOps工具链大盘点 大规模微服务利器:eBPF 与 Kubernetes 互联网公司使用 Redis 的16个应用场景 Nginx配置中一个不起眼字符"/"的巨大作用,失之毫厘谬以千里 企业级日志系统 ELK 原理与实践详细介绍 编写 Dockerfile 最佳实践 运维工程师不得不看的经验教训和注意事项 终于搞懂了服务器为啥产生大量的TIME_WAIT! Kubernetes 网络方案之炫酷的 Cilium 12年资深运维老司机的成长感悟 搭建一套完整的企业级 K8s 集群(二进制方式)

点亮,服务器三年不宕机

评论