基于SLAM的机器人的自主定位导航解析

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文来源于新机器视觉,文章仅供学术交流,已获得授权。

来源:

https://blog.csdn.net/weixin_37251044/article/details/78515909

作者:Jack_Kuo@CSDN

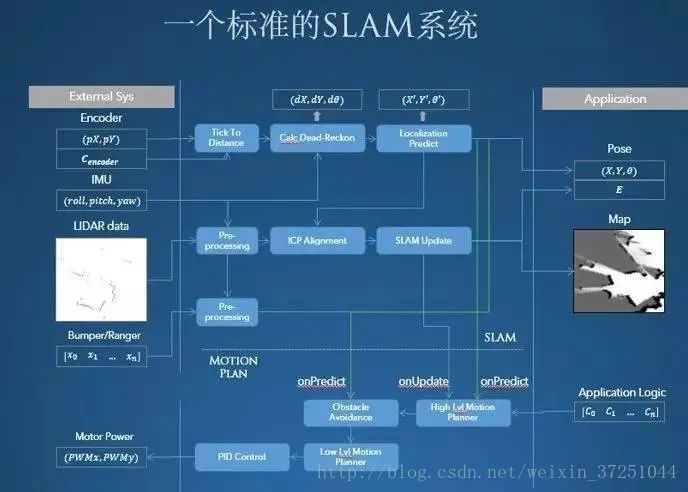

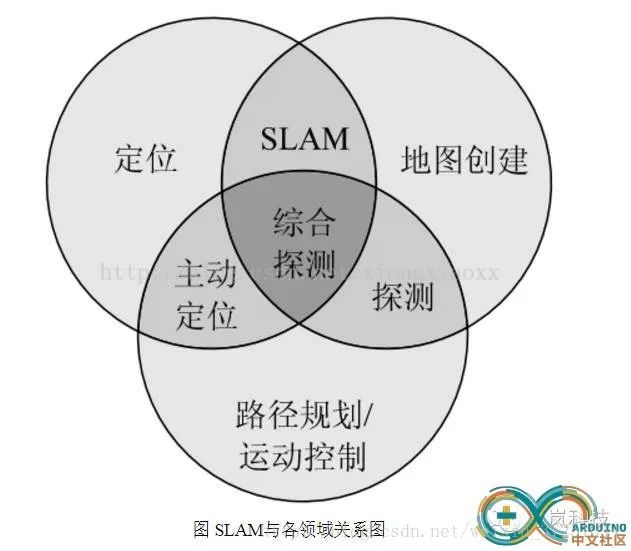

1.传统方案:SLAM+路径规划+运动控制;

2.深度学习:这一两年,深度学习成为人工智能的代名词。在这个行业,前几年还是以比较传统的概率学,或者控制论的方式进行机器人自主定位导航。但这里展现的是完全通过深度学习,直接通过摄像头数据作为信号输入,再通过神经网络直接产生出机器人的控制信号。其中像 SLAM 的过程、路径规划的过程,完全通过学习的方式就可以进行实现。

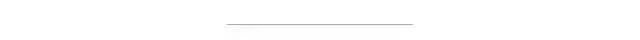

一、SLAM

1.选择地图

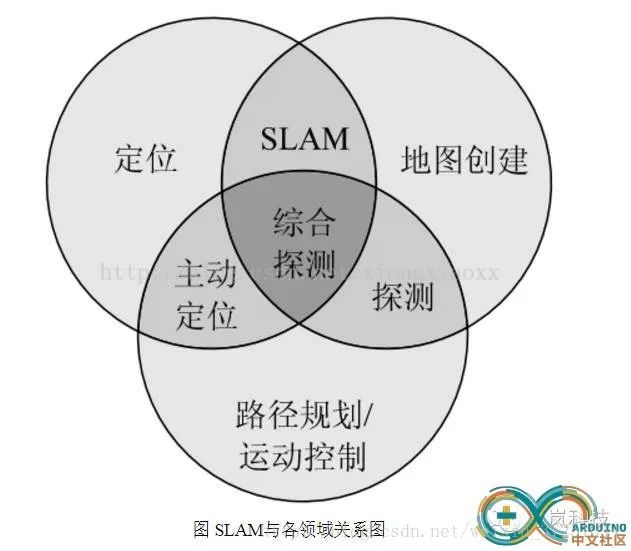

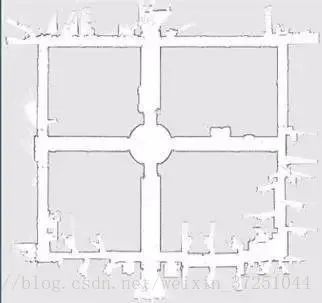

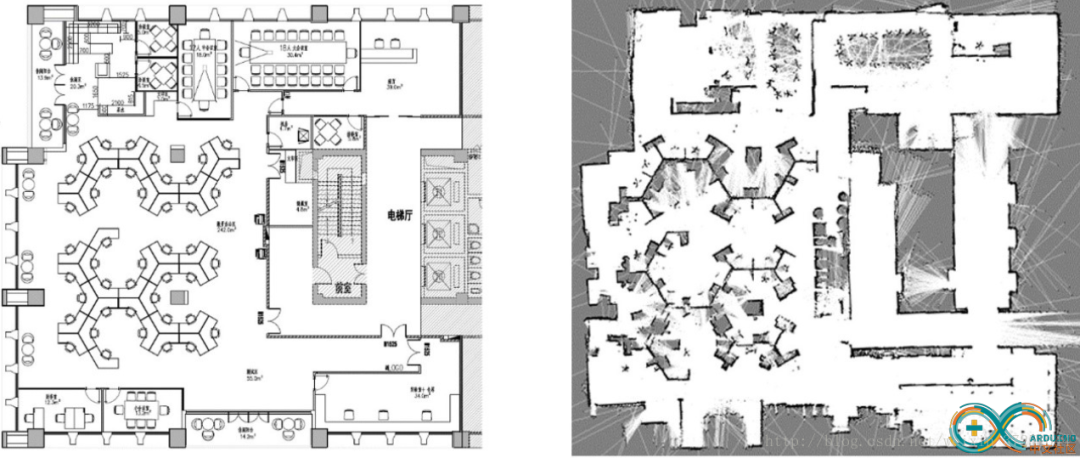

(1)栅格地图

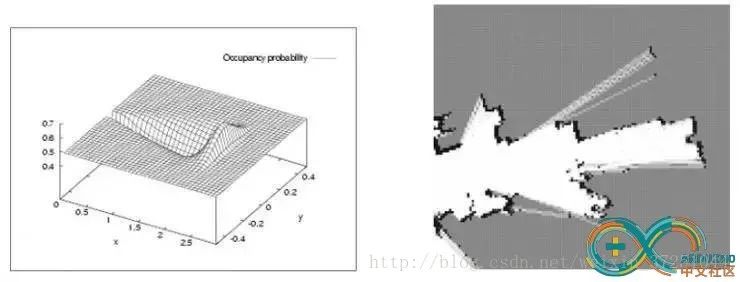

(2)特征点地图

相比栅格地图,这种地图看起来就不那么直观了。它一般通过如GPS、UWB以及摄像头配合稀疏方式的vSLAM算法产生,优点是相对数据存储量和运算量比较小,多见于最早的SLAM算法中。

(3)直接表征法

(4)拓扑地图

(5)小结

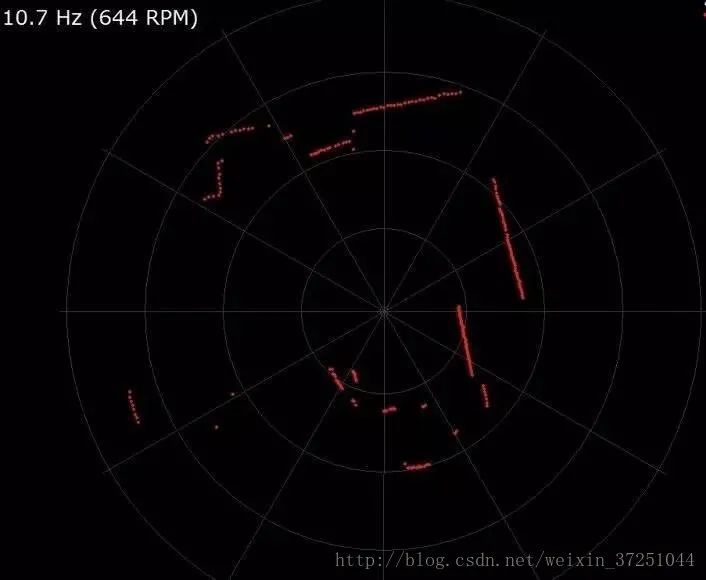

2.定位及传感器选择

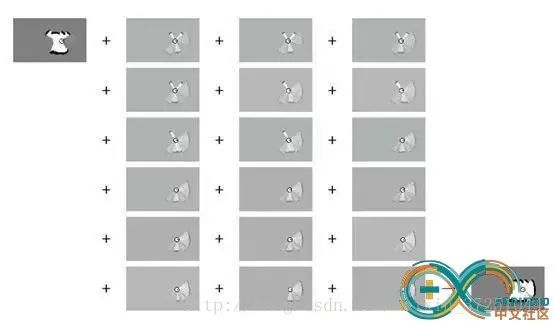

3.传感器数据预处理

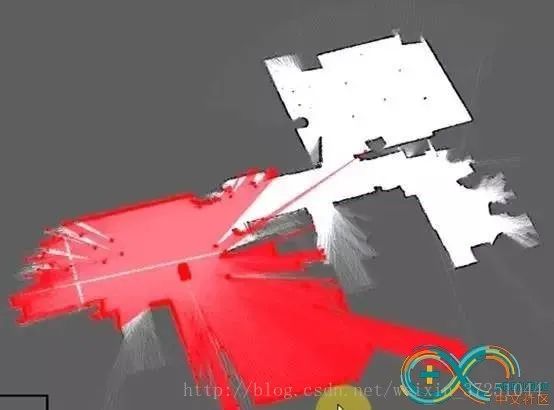

4.匹配

5.地图融合

6.Loop Closure(回环)问题

7.算法优化及商用

扩展: 这也是我们思岚科技SLAMTEC主要的努力方向,一方面,我们这7年多很好的解决了各类实际SLAM算法难点,另一方面,我们把SLAM这个复杂的系统做了很大的优化,可以放到一个硬币那么大的模块内部,降低尺寸功耗。此外,它还集成了IMU等配套传感器,力求做到对于SLAM的使用便捷性。

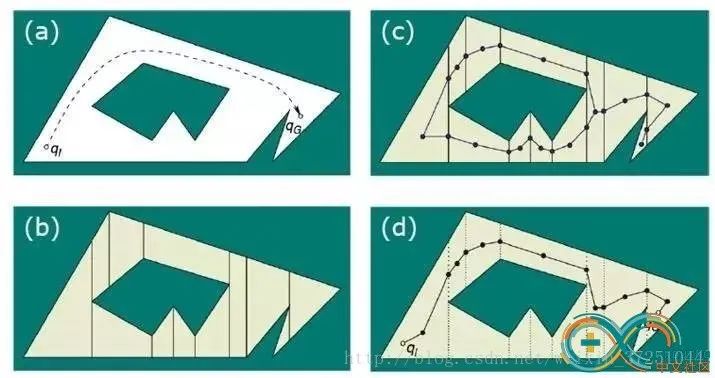

二、路径规划

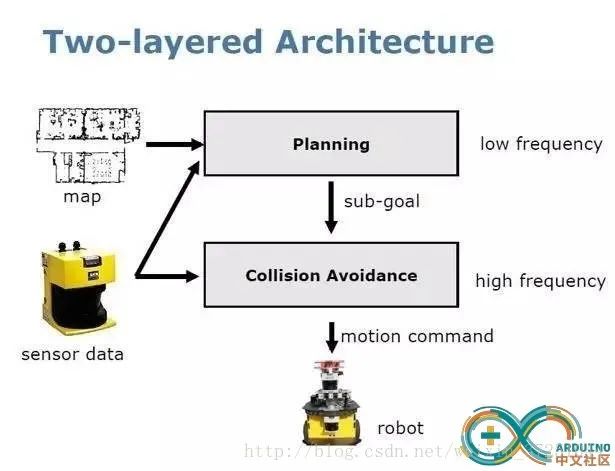

1.全局规划

2.局部规划

3.已知地图(A*)与未知地图(D*)算法

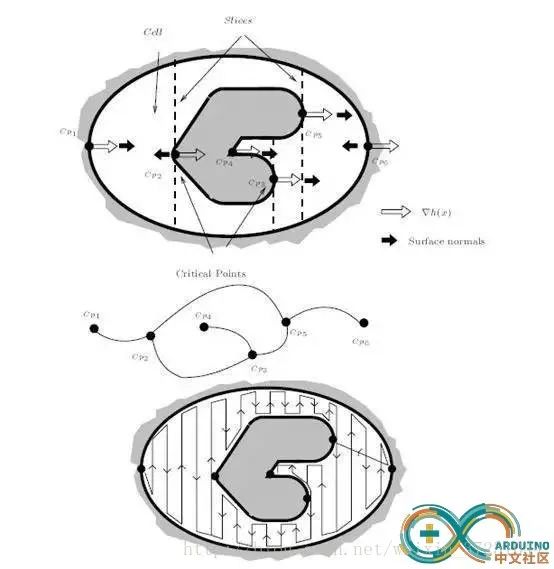

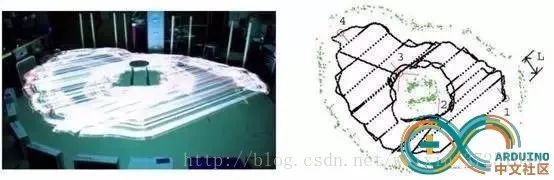

4.空间覆盖(space coverage)

扩展: 针对扫地机器人,我们将其特有的路径规划功能预先内置在SLAMWARE中,方便厂家进行整合,不需要进行二次开发。

好消息!

小白学视觉知识星球

开始面向外开放啦👇👇👇

下载1:OpenCV-Contrib扩展模块中文版教程 在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。 下载2:Python视觉实战项目52讲 在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。 下载3:OpenCV实战项目20讲 在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。 交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

评论