PPO算法的一个简单实现:对话机器人

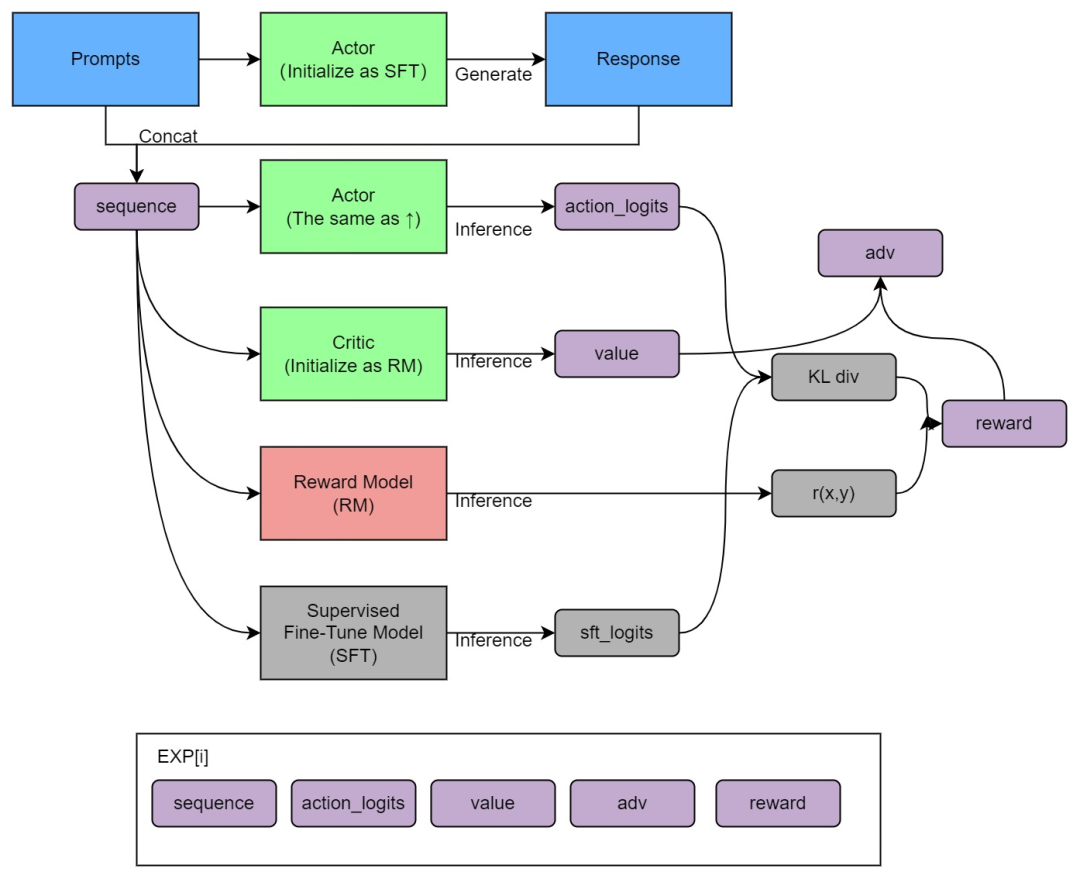

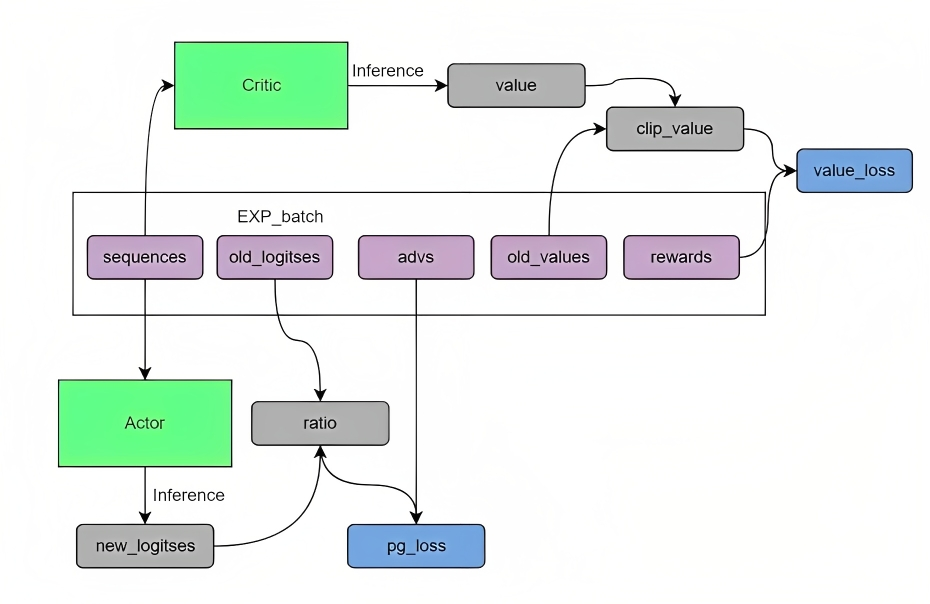

综上,PPO算法是一种具体的Actor-Critic算法实现,比如在对话机器人中,输入的prompt是state,输出的response是action,想要得到的策略就是怎么从prompt生成action能够得到最大的reward,也就是拟合人类的偏好。具体实现时,可以按如下两大步骤实现

这4个模型分别为Actor、SFT、Critic、RM,其中:

代码实现需要的话可以私苏苏老师V:julyedukefu008

✓

好消息

学术/学业/职称论文,申硕/申博,1V1辅导现在需求也越来越旺,如果你有论文需求,别犹豫,七月在线论文保发;国内外求职1V1辅导也如火如荼进行中

有意找苏苏老师(VX:julyedukefu008 )或七月在线其他老师申请试听/了解课程

(扫码联系苏苏老师)

点击“阅读原文”了解更多 -

评论