深度学习再登Science:万物皆可做神经网络处理器

共 1786字,需浏览 4分钟

·

2022-03-03 08:08

↑↑↑点击上方蓝字,回复资料,10个G的惊喜

转自:大数据文摘

想象一下,你周围的任何东西,比如一个煎锅、一个玻璃镇纸,都可以用来当成神经网络的中央处理器,那是什么感觉?

神经网络简单来说,是一种模仿大脑执行复杂任务的只能系统,给定输入,得到输出,无论是判断一张图上面是一只猫或一只小狗,还是判断这首歌是什么风格,神经网络总能根据无数次的训练得到最大概率的正确结果。

只不过,为了得到最快的速度,目前的神经网络通常在图形处理芯片(GPU)上运行的,而一项新的研究显示,理论上,你可以依赖任何物体来运行一个神经网络。

共同领导这项研究的康奈尔大学物理学家 Logan Wright 说: “一切都可以是一台计算机。”

Nature报道了这项研究。

论文地址:

声、光、电流皆可作为神经网络载体

目前的神经网络通常在图形处理芯片(GPU)上运行,最大的计算机可以每秒执行数百万或数十亿次计算,仅仅是为了,比如说,下一盘棋或者写一篇散文。

即使是在专门的芯片上,这也会花费大量的时间和电能。但 Wright 和他的同事意识到,物理对象也以被动方式计算,仅仅通过对刺激作出反应。

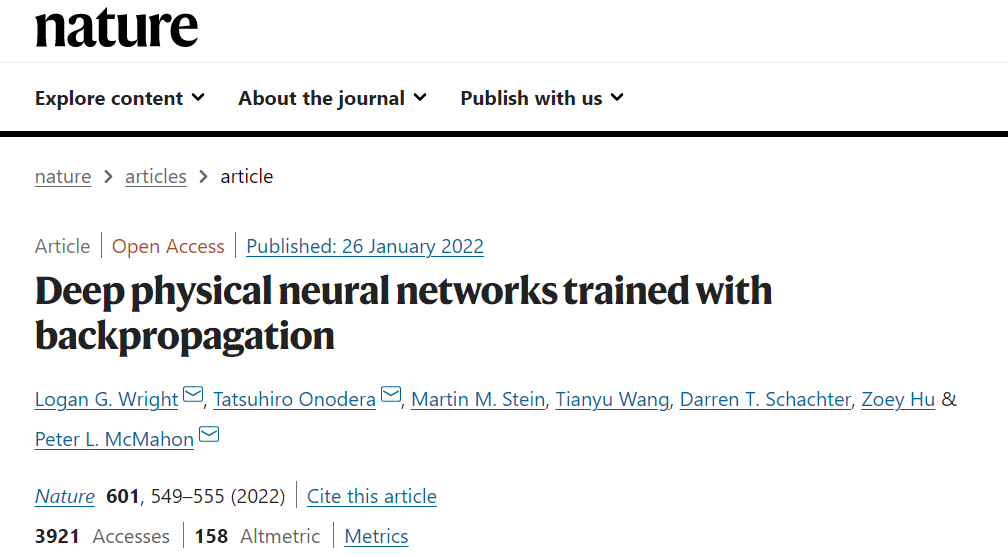

为了演示这一概念,研究人员在三种物理系统,机械系统、光学系统、模拟电子系统中构建了神经网络,每种物理系统包含多达五个处理层:

在机械系统的每一层中,他们使用扬声器振动一个小金属板,并用麦克风记录其输出;

在光学系统中,他们让光穿过晶体,用来搭建神经网络;

在模拟电子系统中,他们利用电流通过微小的电路来设计网络。

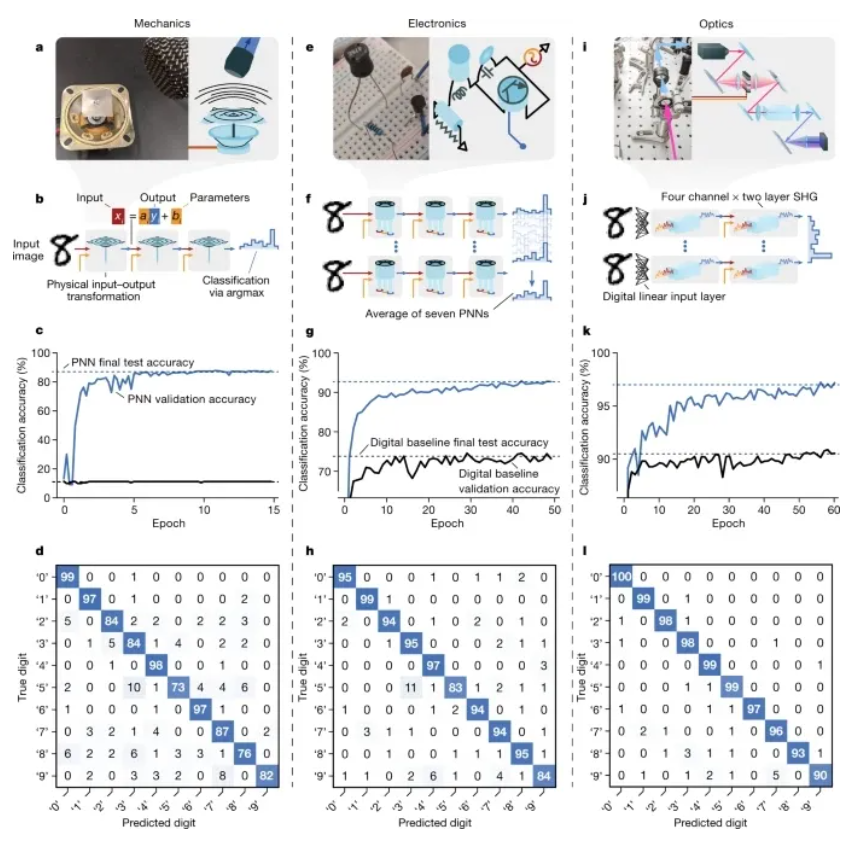

利用宽带光学SHG实验实现了一个典型的PNN

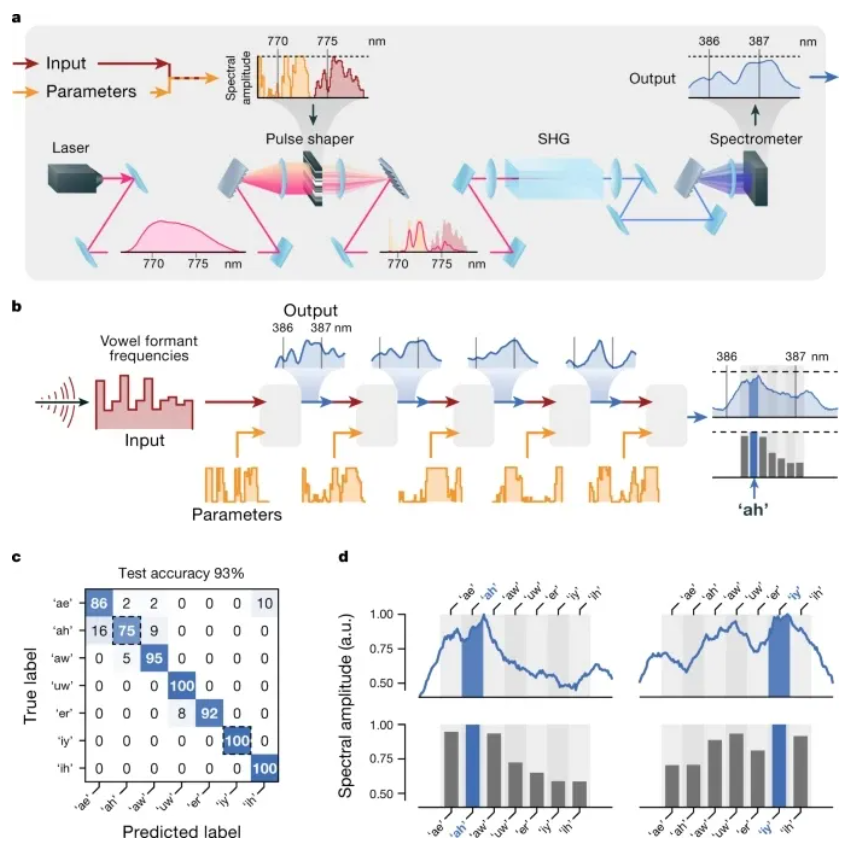

在每种情况下,研究人员都将输入数据(如未标记的图像)以声音、光线或电压进行编码,对于每个处理层,他们还对数字参数进行编码,告诉三个物理系统如何操作数据。为了训练系统,他们调整了参数,以减少系统预测的图像标签和实际标签之间的误差。

Logan Wright 说,“我们只是在寻找让硬件物理学做我们想做的事情的方法。”

强调物理过程,而不是数学运算

这些机械系统、光学系统、模拟电子系统都被称为物理神经网络系统(physical neural networks,PNNs),研究人员用这些系统来识别手写数字。

在一个实验中,PNNs识别出7个元音。他们在本周的《自然》杂志上报告说,这些任务的准确率从87%到97%不等。Wright 说,在未来,研究人员可能不会通过计算机数据调整输入参数来调整系统,而是通过调整物理对象——比如弯曲金属板。

在论文中,研究人员表示,应该强调对物理过程的训练,而不是数学操作。

这种区别不仅仅是语义上的:通过打破传统的软硬件划分,PNNs提供了从几乎任何可控制的物理系统构建神经网络硬件的可能性。任何模拟过复杂物理系统演化的人都知道,物理转换通常比数字模拟更快,消耗的能量更少。

这表明,PNNs能够最直接地利用这些物理转换,可能能够比传统模式更有效地执行某些计算,从而提供了一条更可扩展、更节能和更快的机器学习的途径。

未来可能不是在执行计算,而是硬件本身的功能

没有参与这项研究的瑞士联邦理工学院洛桑分校的物理学家和计算机科学家 Lenka Zdeborová 说,这项研究是“令人兴奋的”,她希望看到更困难任务的示范。

法国国家研究机构法国国家科学研究中心(CNRS)的物理学家达米安•奎里奥斯(Damien Querlioz)补充道: “他们在不同的背景下很好地证明了这个想法……我认为它将产生相当大的影响。”

最令人兴奋的是PNNs作为智能传感器的潜力。

显微镜的光学技术甚至可以在光线照射到数字传感器之前帮助检测癌细胞,或者智能手机的麦克风膜可以监听唤醒词。Wright 说,在这些应用程序中,你真的不会认为它们在执行机器学习计算,而是认为它们是“功能性机器”。