关于双目立体视觉的三大基本算法及发展现状的总结

共 6103字,需浏览 13分钟

·

2020-08-03 03:20

加入极市专业CV交流群,与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度 等名校名企视觉开发者互动交流!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

双目立体视觉一直是机器视觉研究领域的发展热点和难点,“热”是因为双目立体视觉有着及其广阔的应用前景,且随着光学、计算机科学等学科的不断发展,双目立体技术将不断进步直到应用到人类生活的方方面面。“难”则是因为受到摄像机、镜头等硬件设备及一些相关算法的限制,双目立体视觉的研究及如何更好的应用到生产实际中仍有待在座的各位去进行突破。

一.简介

双目立体视觉是机器视觉中的一个重要分支,自上世纪60年代中期开创以来,经过几十年的发展,如今在机器人视觉、航空测绘、军事应及医学成像、工业检测上应用极其广泛。双目立体视觉基于视差原理并利用成像设备从不同的位置获取被测物体的左右两幅图像,然后根据三角测量原理计算空间点在二维图像的位置偏差,最后再利用位置偏差进行三维重建来获取被测物体的三维几何信息(本文不对双目立体视觉的数学原理进行详细介绍)。

二.双目立体视觉的三大基本算法的原理及其代码实现(基于opencv)

双目立体视觉中常用的基于区域的局部匹配准则主要有图像序列中对应像素差的绝对值之和SAD(sum of absolute differences)、对应像素差的平方之和SSD(sum of squared differences)及半全局匹配算法SGM(semi—global matching)。

2.1 SAD(sum of absolute differences)的原理

匹配算法SAD的基本思想是对经行对准后的左右视图图像的对应像素块的对应像素差的绝对值进行求和。

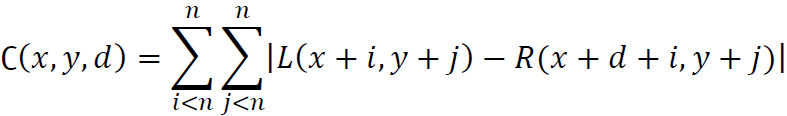

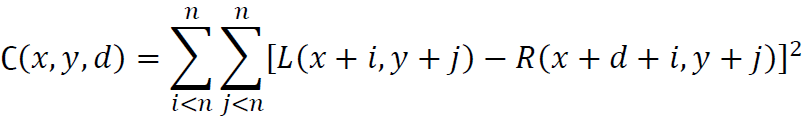

其数学公式如下:

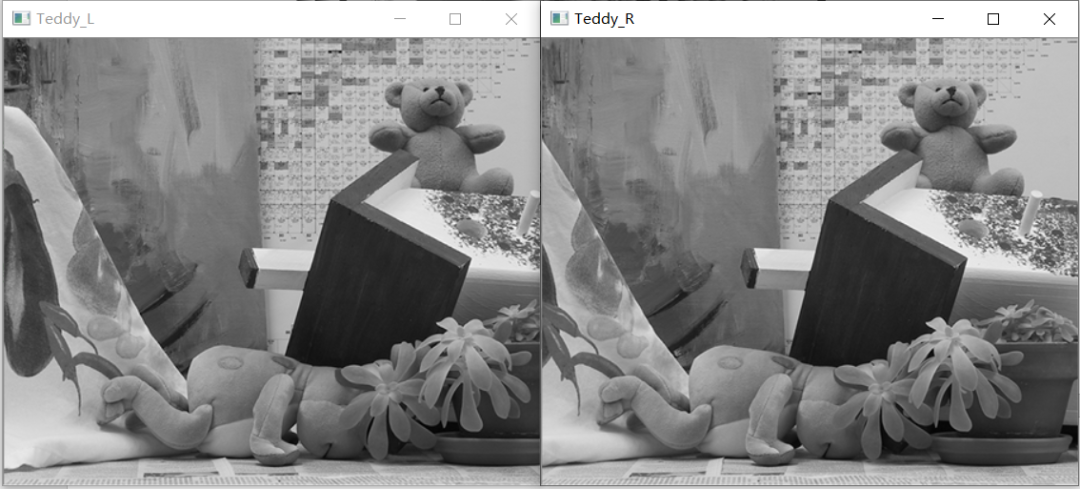

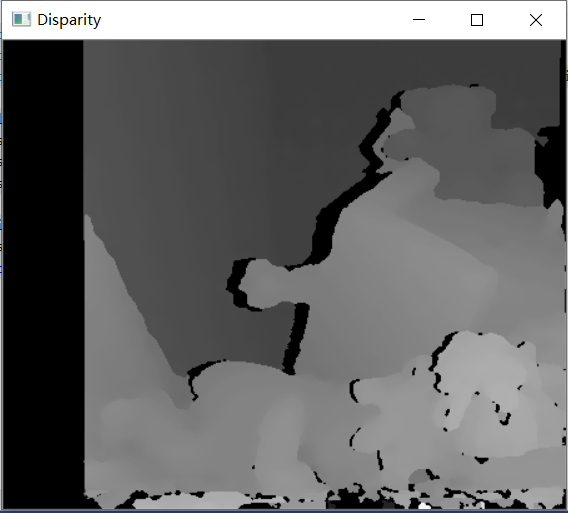

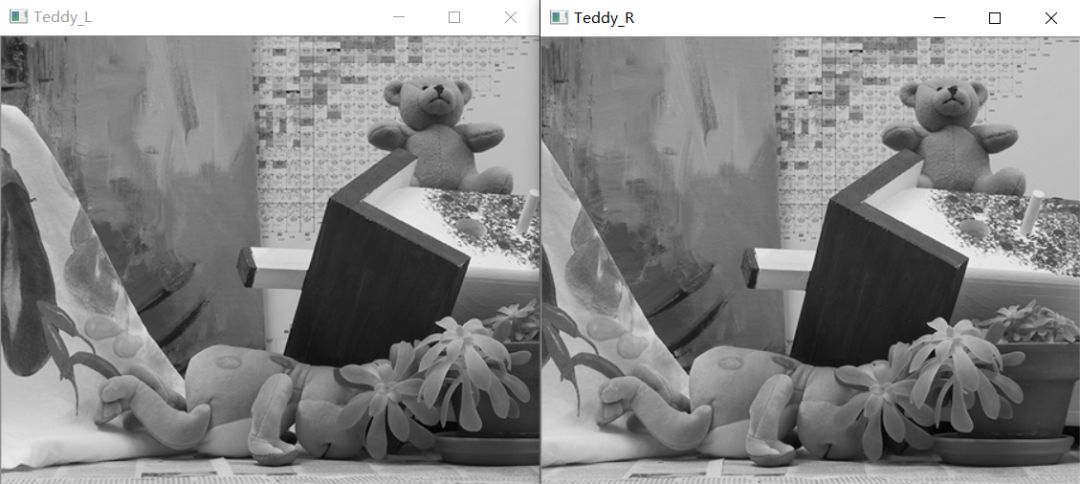

###using namespace std;using namespace cv;class SAD{public:SAD() :winSize(7), DSR(30) {}SAD(int _winSize, int _DSR) :winSize(_winSize), DSR(_DSR) {}Mat computerSAD(Mat &L, Mat &R); //计算SADprivate:int winSize; //卷积核的尺寸int DSR; //视差搜索范围};Mat SAD::computerSAD(Mat &L, Mat &R){int Height = L.rows;int Width = L.cols;Mat Kernel_L(Size(winSize, winSize), CV_8U, Scalar::all(0));Mat Kernel_R(Size(winSize, winSize), CV_8U, Scalar::all(0));Mat Disparity(Height, Width, CV_8U, Scalar(0)); //视差图for (int i = 0; i//左图从DSR开始遍历 {for (int j = 0; j{Kernel_L = L(Rect(i, j, winSize, winSize));Mat MM(1, DSR, CV_32F, Scalar(0));for (int k = 0; k{int x = i - k;if (x >= 0){Kernel_R = R(Rect(x, j, winSize, winSize));Mat Dif;absdiff(Kernel_L, Kernel_R, Dif);//求差的绝对值之和Scalar ADD = sum(Dif);float a = ADD[0];MM.at<float>(k) = a;}}Point minLoc;minMaxLoc(MM, NULL, NULL, &minLoc, NULL);int loc = minLoc.x;//int loc=DSR-loc;Disparity.at<char>(j, i) = loc * 16;}double rate = double(i) / (Width);cout << "已完成" << setprecision(2) << rate * 100 << "%" << endl; //显示处理进度}return Disparity;}调用示例:#int main(int argc, char* argv[]){Mat Img_L = imread("Teddy_L.png", 0); //此处调用的图像已放入项目文件夹中Mat Img_R = imread("Teddy_R.png", 0);Mat Disparity; //创建视差图SAD mySAD(7, 30); //给出SAD的参数Disparity = mySAD.computerSAD(Img_L, Img_R);imshow("Teddy_L", Img_L);imshow("Teddy_R", Img_R);imshow("Disparity", Disparity); //显示视差图waitKey();system("pause"); //按任意键退出return 0;}

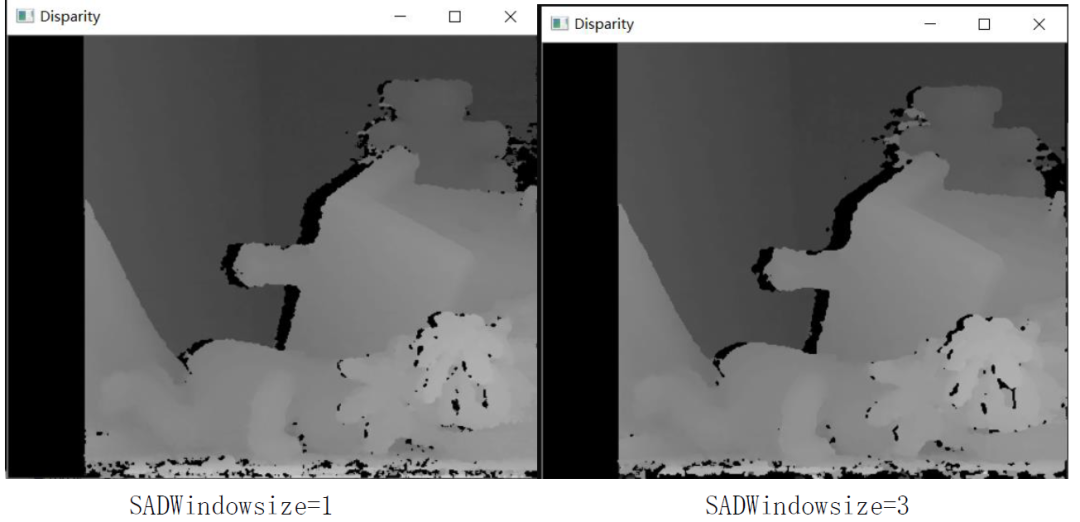

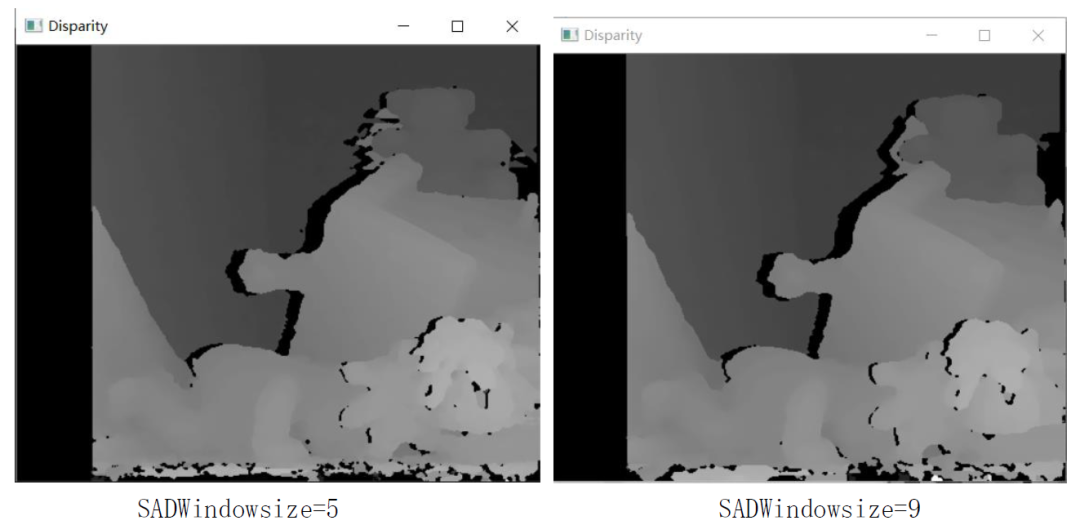

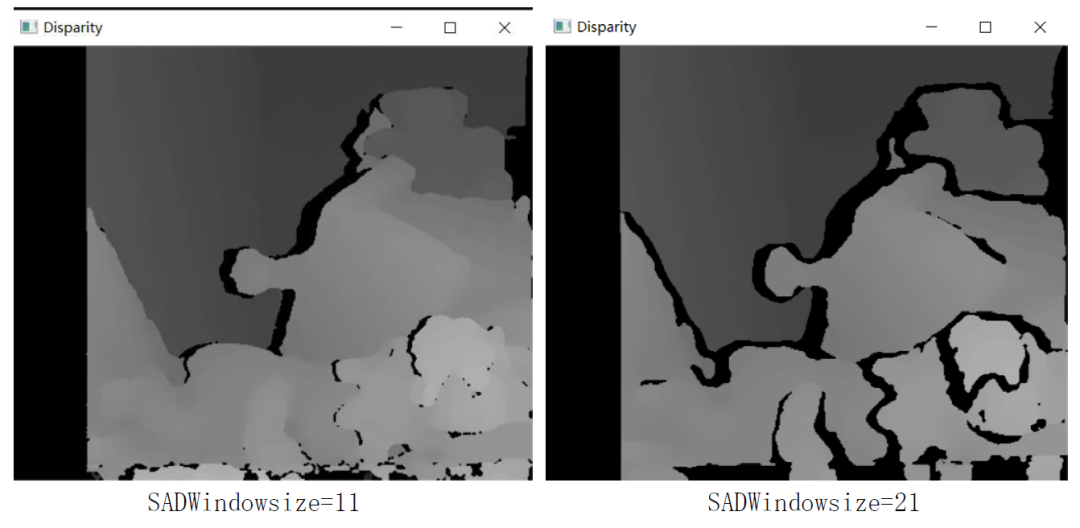

enum { STEREO_BM = 0, STEREO_SGBM = 1, STEREO_HH = 2, STEREO_VAR = 3, STEREO_3WAY = 4 };#include"iostream"#include"opencv2/opencv.hpp"using namespace std;using namespace cv;void calDispWithSGBM(Mat Img_L, Mat Img_R, Mat &imgDisparity8U){Size imgSize = Img_L.size();int numberOfDisparities = ((imgSize.width / 8) + 15) & -16;Ptrsgbm = StereoSGBM::create(0, 16, 3); int cn = Img_L.channels(); //左图像的通道数int SADWindowSize = 9;int sgbmWinSize = SADWindowSize > 0 ? SADWindowSize : 3;sgbm->setMinDisparity(0); //minDisparity最小视差默认为0;sgbm->setNumDisparities(numberOfDisparities); //numDisparity视差搜索范围,其值必须为16的整数倍;sgbm->setP1(8 * cn*sgbmWinSize*sgbmWinSize);sgbm->setP2(32 * cn*sgbmWinSize*sgbmWinSize); //一般建议惩罚系数P1、P2取此两值,P1、P2控制视差图的光滑度//P2越大,视差图越平滑sgbm->setDisp12MaxDiff(1); //左右一致性检测最大容许误差阈值sgbm->setPreFilterCap(31); //预处理滤波器的截断值,预处理的输出值仅保留//[-preFilterCap, preFilterCap]范围内的值,参数范围:1 - 31sgbm->setUniquenessRatio(10); //视差唯一性百分比:视差窗口范围内最低代价是次低代价的(1 + uniquenessRatio/100)倍时//最低代价对应的视差值才是该像素点的视差,否则该像素点的视差为 0 ,不能为负值,一般去5——15sgbm->setSpeckleWindowSize(100); //视差连通区域像素点个数的大小:对于每一个视差点,当其连通区域的像素点个数小于//speckleWindowSize时,认为该视差值无效,是噪点。sgbm->setSpeckleRange(32); //视差连通条件:在计算一个视差点的连通区域时,当下一个像素点视差变化绝对值大于//speckleRange就认为下一个视差像素点和当前视差像素点是不连通的。sgbm->setMode(0); //模式选择sgbm->setBlockSize(sgbmWinSize); //设置SAD代价计算窗口,一般在3*3到21*21之间//blockSize(SADWindowSize) 越小,也就是匹配代价计算的窗口越小,视差图噪声越大;//blockSize越大,视差图越平滑;//太大的size容易导致过平滑,并且误匹配增多,体现在视差图中空洞增多//三种模式选择(HH、SGBM、3WAY)int algorithm = STEREO_SGBM;if (algorithm == STEREO_HH)sgbm->setMode(StereoSGBM::MODE_HH);else if (algorithm == STEREO_SGBM)sgbm->setMode(StereoSGBM::MODE_SGBM);else if (algorithm == STEREO_3WAY)sgbm->setMode(StereoSGBM::MODE_SGBM_3WAY);Mat imgDisparity16S = Mat(Img_L.rows, Img_L.cols, CV_16S);sgbm->compute(Img_L, Img_R, imgDisparity16S);//--Display it as a CV_8UC1 image:16位有符号转为8位无符号imgDisparity16S.convertTo(imgDisparity8U, CV_8U, 255 / (numberOfDisparities*16.));}调用示例:#include"SGBM_Algorithm.h"int main(){Mat Img_L = imread("Teddy_L.png", 0);Mat Img_R = imread("Teddy_R.png", 0);Mat Disparity8U = Mat(Img_L.rows, Img_R.cols, CV_8UC1);//创建一个Disparity图像calDispWithSGBM(Img_L, Img_R, Disparity8U);imshow("Teddy_L", Img_L);imshow("Teddy_R", Img_R);imshow("Disparity", Disparity8U);waitKey();system("pause"); //按任意键退出return 0;}

三.双目立体视觉的发展现状

四.笔者总结

推荐阅读

双目图像超分辨:现状、挑战与展望

NeurIPS2019|首篇单目无监督深度估计与视觉里程计,效果超越双目算法,已开源

极市干货|第50期直播回放-边佳旺:NeurIPS2019_无监督且尺度一致的深度估计与视觉SLAM