长尾问题太严重?半监督和自监督就可以有效缓解!

新智元报道

新智元报道

来源:夕小瑶的卖萌屋

作者:Yuzhe Yang

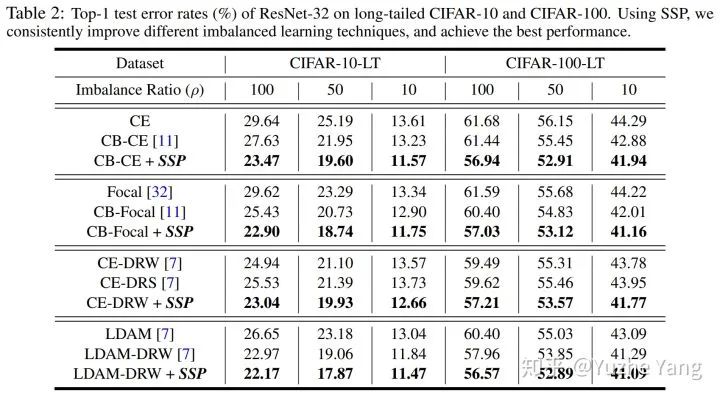

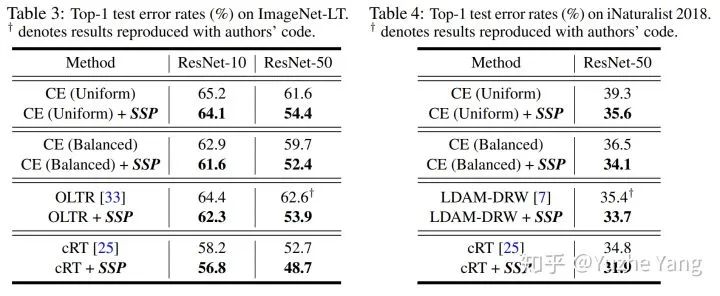

【新智元导读】论文研究了一个经典而又非常实际的问题:数据类别不平衡下的分类问题。通过理论推导和大量实验发现,半监督和自监督均能显著提升不平衡数据下的学习表现。目前论文已被NeurIPS2020接收,代码已开源。

半监督学习 --- 也即利用更多的无标签数据;

自监督学习 --- 不利用任何其他数据,仅通过在现有的不平衡数据上先做一步不带标签信息的自监督预训练(self-supervised pre-training)

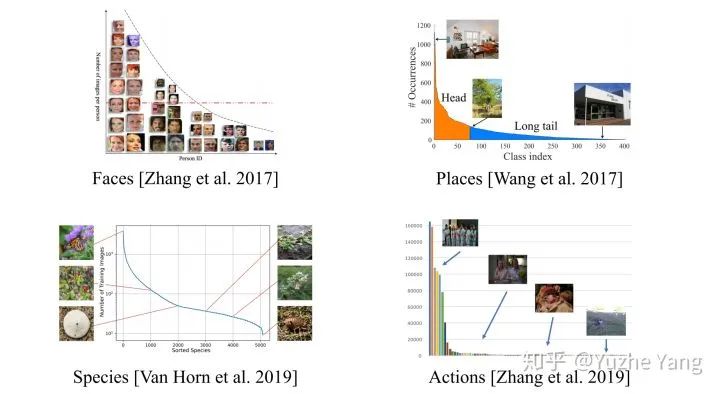

研究背景

重采样(re-sampling):更具体可分为对少样本的过采样[3],或是对多样本的欠采样[8]。但因过采样容易overfit到minor class,无法学到更鲁棒易泛化的特征,往往在非常不平衡数据上表现会更差;而欠采样则会造成major class严重的信息损失,导致欠拟合发生。

数据合成(synthetic samples):即生成和少样本相似的“新”数据。经典方法SMOTE[9],思路简单来讲是对任意选取的少类样本,用K近邻选取其相似样本,通过对样本线性插值得到新样本。这里会想到和mixup[10]很相似,于是也有imbalance的mixup版本出现[11]。

重加权(re-weighting):对不同类别(甚至不同样本)分配不同权重。注意这里的权重可以是自适应的。此类方法的变种有很多,有最简单的按照类别数目的倒数来做加权[12],按照“有效”样本数加权[1],根据样本数优化分类间距的loss加权[4],等等。

迁移学习(transfer learning):这类方法的基本思路是对多类样本和少类样本分别建模,将学到的多类样本的信息/表示/知识迁移给少类别使用。代表性文章有[13][14]。

度量学习(metric learning):本质上是希望能够学到更好的embedding,对少类附近的boundary/margin更好的建模。有兴趣的同学可以看看[15][16]。

元学习/域自适应(meta learning/domain adaptation):分别对头部和尾部的数据进行不同处理,可以去自适应的学习如何重加权[17],或是formulate成域自适应问题[18]。

解耦特征和分类器(decoupling representation & classifier):最近的研究发现将特征学习和分类器学习解耦,把不平衡学习分为两个阶段,在特征学习阶段正常采样,在分类器学习阶段平衡采样,可以带来更好的长尾学习结果[5][6]。这也是目前的最优长尾分类算法。

我们的研究动机和思路

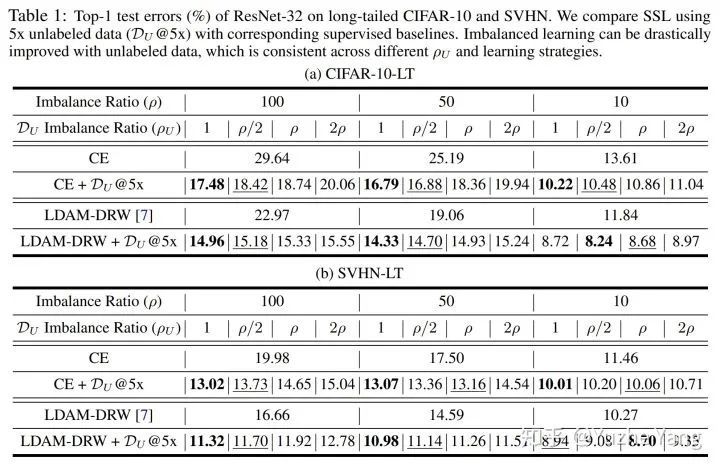

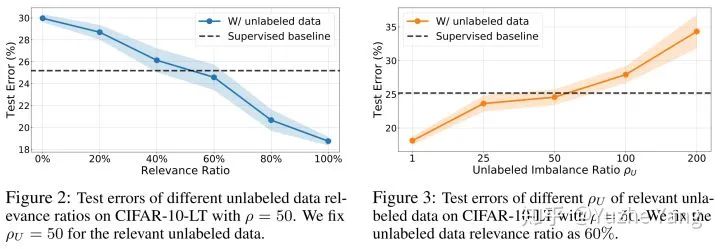

从正面价值的角度,我们发现当有更多的无标签数据时,这些不平衡的标签提供了稀缺的监督信息。通过利用这些信息,我们可以结合半监督学习去显著的提高最后的分类结果,即使无标签数据也存在长尾分布。

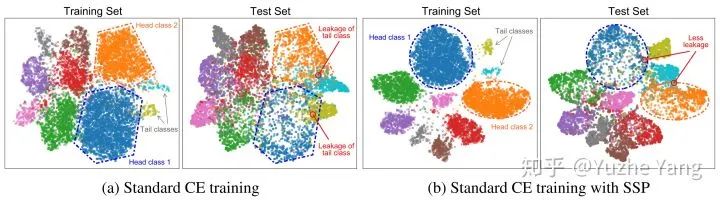

从负面价值的角度,我们证明了不平衡标签并非在所有情况下都是有用的。标签的不平衡大概率会产生label bias。因此在训练中,我们首先想到“抛弃”标签的信息,通过自监督的学习方式先去学到好的起始表示形式。我们的结果表面通过这样的自监督预训练方式得到的模型也能够有效的提高分类的准确性。

半监督框架下的不均衡学习

和

和  ,但是相同方差的Guassian mixture模型,我们可以很容易验证其贝叶斯最优分类器为:

,但是相同方差的Guassian mixture模型,我们可以很容易验证其贝叶斯最优分类器为:

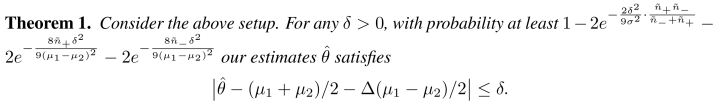

以及一定量的无标签的数据,我们可以通过这个基础分类器给这些数据做pseudo-label。令

以及一定量的无标签的数据,我们可以通过这个基础分类器给这些数据做pseudo-label。令  和

和  代表pseudo-label为正和为负的数据的数量。

代表pseudo-label为正和为负的数据的数量。 ,最简单的方法我们可以通过pseudo-label给这些对应的没有标签的数据取平均得到

,最简单的方法我们可以通过pseudo-label给这些对应的没有标签的数据取平均得到  。假设

。假设  代表基础分类器对于两个类的准确度的gap。这样的话我们推出以下定理:

代表基础分类器对于两个类的准确度的gap。这样的话我们推出以下定理:

原始数据集的不平衡性会影响我们最后estimator的准确性。越不平衡的数据集我们expect 基础分类器有一个更大的

。越大的

。越大的  影响我们的estimator

影响我们的estimator  到理想的均值之间的距离。

到理想的均值之间的距离。

无标签数据集的不平衡性影响我们能够得到一个好的estimator的概率。对于还不错的基础分类器,

可以看做是对于无标签数据集的不平衡性的近似。我们可以看到,当:

可以看做是对于无标签数据集的不平衡性的近似。我们可以看到,当: ,如果无标签数据很不平衡,那么数据少的一项会主导另外一项,从而影响最后的概率。

,如果无标签数据很不平衡,那么数据少的一项会主导另外一项,从而影响最后的概率。

上正常训练获得一个中间步骤分类器

上正常训练获得一个中间步骤分类器  ,并将其应用于生成未标记数据

,并将其应用于生成未标记数据  的伪标签

的伪标签  ;通过结合两部分数据,我们最小化损失函数

;通过结合两部分数据,我们最小化损失函数  以学习最终模型

以学习最终模型  。

。 和

和  的学习策略,因此半监督框架也能很轻易的和现有类别不平衡的算法相结合。

的学习策略,因此半监督框架也能很轻易的和现有类别不平衡的算法相结合。 和

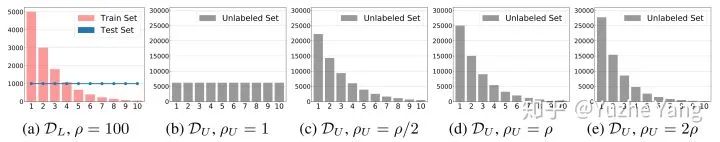

和  的典型分布如下):

的典型分布如下):

典型的原始数据分布,以及可能的无标记数据分布

关于半监督不均衡学习的进一步思考

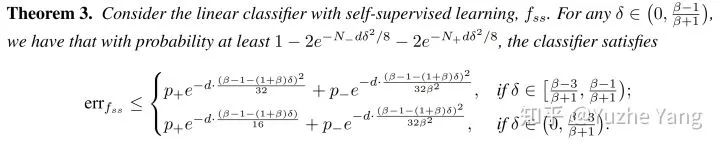

自监督框架下的不均衡学习

维Guassian mixture的toy example。这次我们考虑两个类有相同的均值(都为0)但是不同的方差,

维Guassian mixture的toy example。这次我们考虑两个类有相同的均值(都为0)但是不同的方差,  和

和  。其中,我们假设负类是主要的类(mix 概率

。其中,我们假设负类是主要的类(mix 概率  )。我们考虑线性的分类器

)。我们考虑线性的分类器  ,

,  ,并且用标准的error probability,

,并且用标准的error probability, ,作为分类器的衡量标准。

,作为分类器的衡量标准。 。在这种情况下,我们可以首先证明上述的线性分类器一定会有至少

。在这种情况下,我们可以首先证明上述的线性分类器一定会有至少  的error probability。

的error probability。 ,

, 。我们考虑用

。我们考虑用  作为线性分类器的输入。

作为线性分类器的输入。 ,

, ,满足下面的定理:

,满足下面的定理:

有很高的概率,我们能得到一个更好的分类器。这个分类器的error probability随数据维度

的增加而指数型减小。对于如今常见的高维数据(如图像)这种性质是我们希望得到的。

的增加而指数型减小。对于如今常见的高维数据(如图像)这种性质是我们希望得到的。

训练数据的不平衡性会影响我们能够得到这样一个好的分类器的概率。上文中,

和

和  代表训练数据里不同类的数量。从

代表训练数据里不同类的数量。从  和

和  这两项中我们可以发现,当数据越多且越平衡,我们就有更高的概率得到一个好的分类器。

这两项中我们可以发现,当数据越多且越平衡,我们就有更高的概率得到一个好的分类器。

结语

参考文献:

[1]Yin Cui, Menglin Jia, Tsung-Yi Lin, Yang Song, and Serge Belongie. Class-balanced loss based on effective number of samples. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 9268–9277, 2019.

[2]Tsung-Yi Lin, Priya Goyal, Ross Girshick, Kaiming He, and Piotr Dollár. Focal loss for dense object detection. In ICCV, pages 2980–2988, 2017.

[3]Samira Pouyanfar, et al. Dynamic sampling in convolutional neural networks for imbalanced data classification.

[4]Learning Imbalanced Datasets with Label-Distribution-Aware Margin Loss. NeurIPS, 2019.

[5]BBN: Bilateral-Branch Network with Cumulative Learning for Long-Tailed Visual Recognition. CVPR, 2020.

[6]Decoupling representation and classifier for long-tailed recognition. ICLR, 2020.

[7]iNatrualist 2018 competition dataset. https://github.com/visipedia/inat_comp/tree/master/2018

[8]He, H. and Garcia, E. A. Learning from imbalanced data. TKDE, 2008.

[9]Chawla, N. V., et al. SMOTE: synthetic minority oversampling technique. JAIR, 2002.

[10]mixup: Beyond Empirical Risk Minimization. ICLR 2018.

[11]H. Chou et al. Remix: Rebalanced Mixup. 2020.

[12]Deep Imbalanced Learning for Face Recognition and Attribute Prediction. TPAMI, 2019.

[13]Large-scale long-tailed recognition in an open world. CVPR, 2019.

[14]Feature transfer learning for face recognition with under-represented data. CVPR, 2019.

[15]Range Loss for Deep Face Recognition with Long-Tail. CVPR, 2017.

[16]Learning Deep Representation for Imbalanced Classification. CVPR, 2016.

[17]Meta-Weight-Net: Learning an Explicit Mapping For Sample Weighting. NeurIPS, 2019.

[18]Rethinking Class-Balanced Methods for Long-Tailed Recognition from a Domain Adaptation Perspective. CVPR, 2020.

[19]Spyros Gidaris, Praveer Singh, and Nikos Komodakis. Unsupervised representation learning by predicting image rotations. arXiv preprint arXiv:1803.07728, 2018.

[20]Kaiming He, Haoqi Fan, Yuxin Wu, Saining Xie, and Ross Girshick. Momentum contrast for unsupervised visual representation learning. arXiv preprint arXiv:1911.05722, 2019.