Yann LeCun:发现智能原理是AI的终极问题

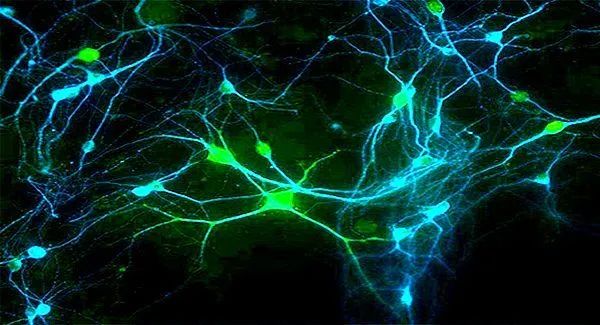

神经网络的诞生——反向传播算法的前世今生

AI:技术or科学?

关于生物启发智能

阿代尔的飞机充满了想象力,在引擎设计方面他是个天才,不过由于缺乏空气动力学的理论支撑,他的设计终究没有走远。所以对于试图从生物学中获得启发的人来说,这是一个有趣的教训,我们还需要了解基本原理是什么。生物学中有很多细节是无关紧要的。

超高速脉冲相机

如何看待大规模NLP预训练模型

关于自监督学习

写作《科学之路》的动因

如何看待中国的人工智能研究

评论

超高速脉冲相机