千层Transformer问世!多语种机器翻译水准刷新多项SOTA

新智元报道

新智元报道

编辑:David 拉燕

【新智元导读】近日,微软研究院的研究人员搞出了一个1000层的Transformer,在多语种机器翻译任务上刷新多项SOTA

论文链接:https://arxiv.org/abs/2203.00555

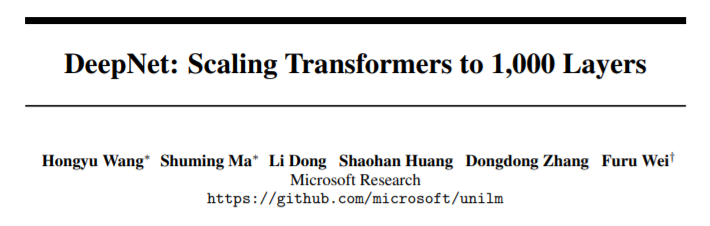

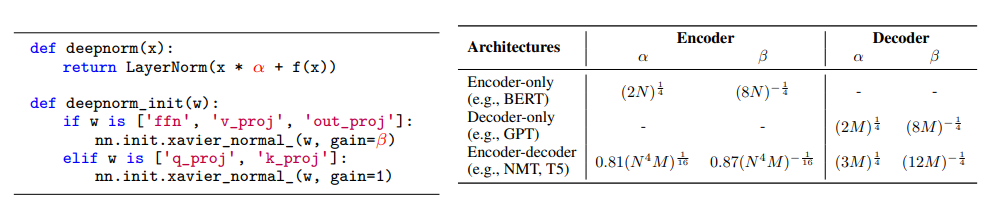

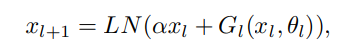

超深的Transformer:DEEPNET

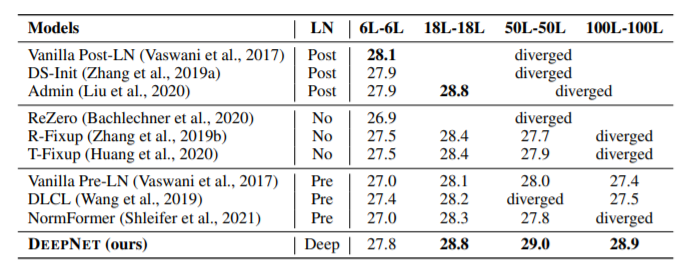

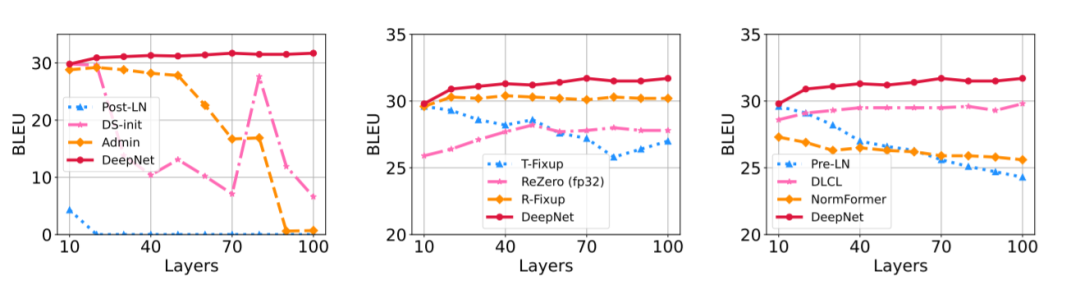

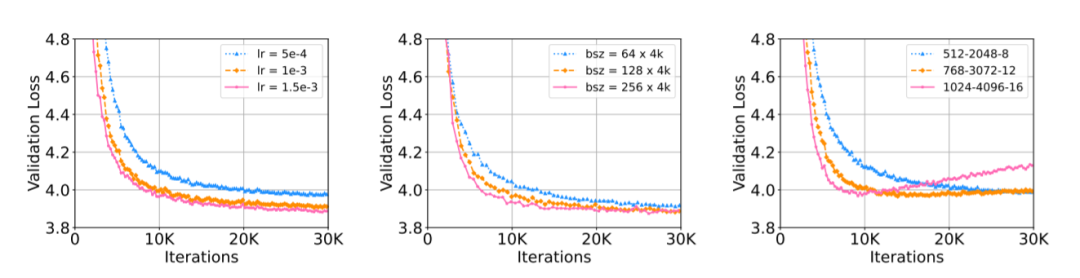

性能:1000层网络,显著提升NMT表现

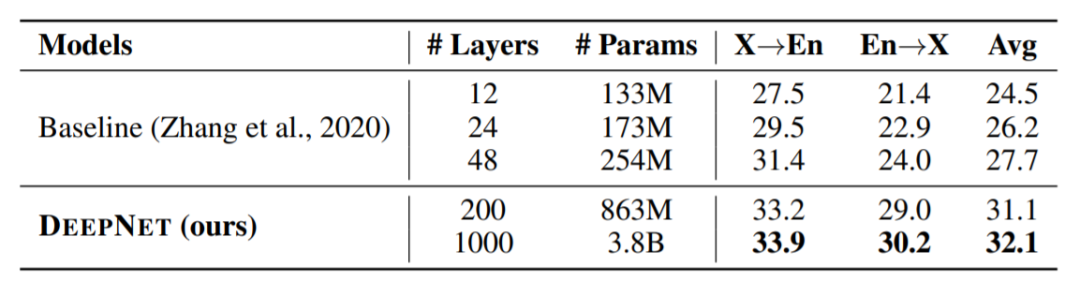

大规模多语言神经机器翻译

参考链接:

https://arxiv.org/abs/2203.00555

评论