大模型竟塞进自动驾驶,AI会解说自己怎么开车了!

共 6501字,需浏览 14分钟

·

2023-09-22 07:55

新智元报道

新智元报道

【新智元导读】Wayve推出的LINGO-1,让自动驾驶长嘴了!这车该怎么开,它自个给自个解说,大语言模型,再也不是黑盒了。

自发明以来,自动驾驶最让人担心之处,莫过于人类无法知道它的脑子里到底在想些什么。

今天开始,它居然可以把自己的想法「讲出来」了?

最近,Wayve推出了基于视觉语言行动的大模型(VLAMs)的自动驾驶交互大模型LINGO-1,把大语言模型和自动驾驶进行了深度融合。

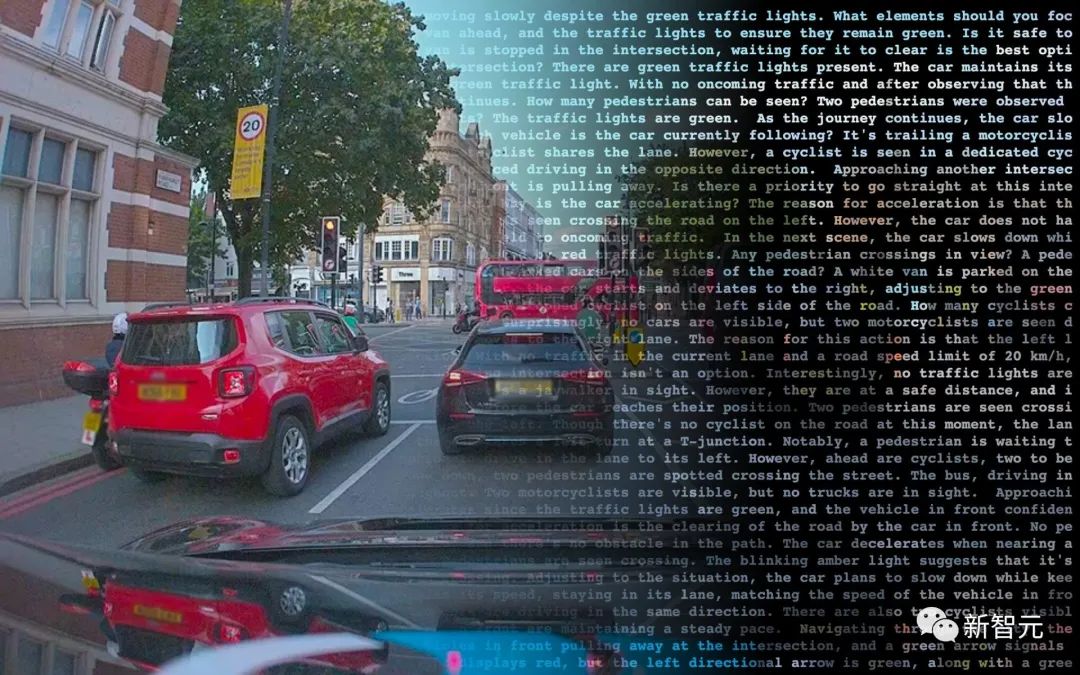

具体来说,LINGO-1训练了一个视频语言模型,它可以说是相当有个性——可以对眼前正在进行的场景发表评论!

-你在干嘛? -我在小心翼翼地穿越车流,因为目前路面情况很复杂。

-下一步你打算要做什么? -我要准备左转了。

-眼前的场景中有哪些潜在风险? -信号灯,骑自行车的人,过马路的行人

你对智驾系统的疑惑,它统统给你解释清楚。

问:为什么停下了?答:因为现在是红灯。

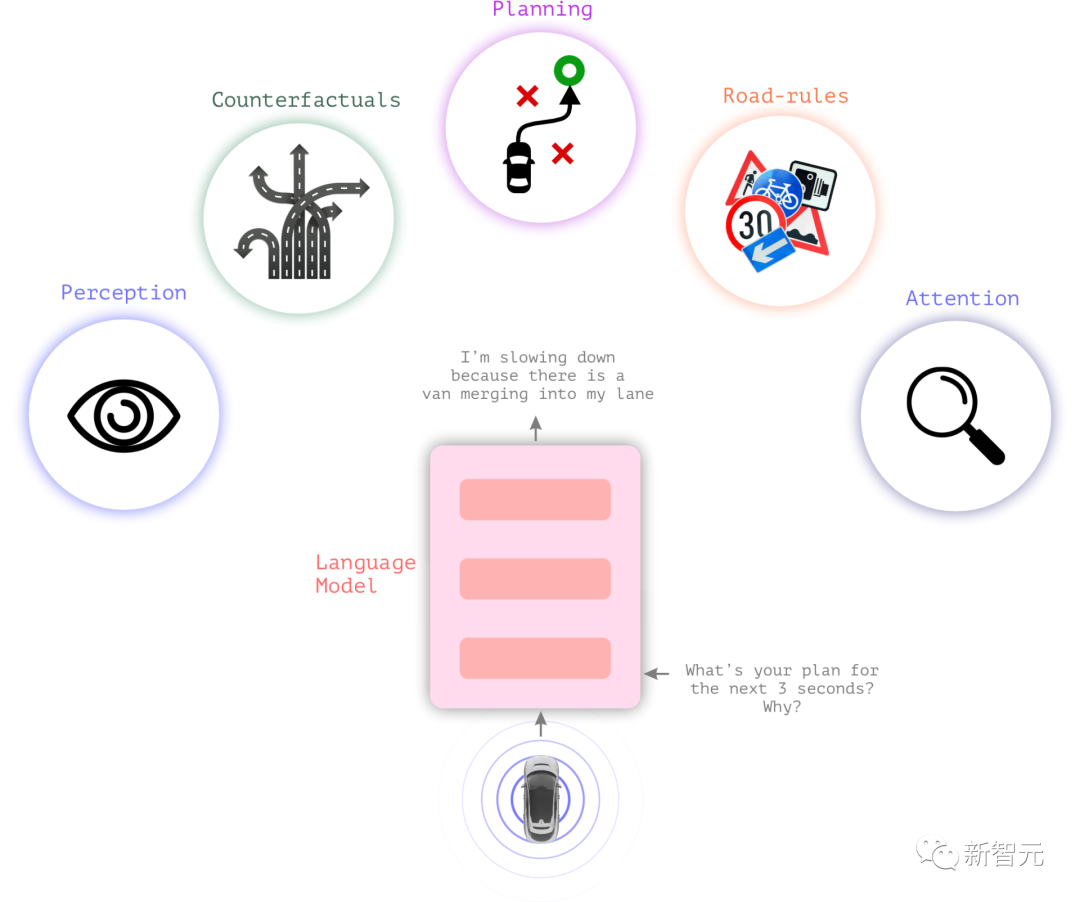

在经过各种视觉和语言数据的训练之后,LINGO-1不仅可以执行视觉问答(VQA)任务,如感知、反事实、规划、推理和注意力,而且还能对驾驶行为和推理进行描述。

也就是说,我们可以通过对LINGO-1进行提问,来了解影响驾驶决策的因素是什么。

网友感慨道:「端到端的黑盒,就这么被打开了,简直是GPT时代的大力出奇迹。自动驾驶系统离真实的物理世界交互,又前进了一大步。」

可以想象,随着我们突破具身人工智能的界限,视觉-语言-行动模型将产生巨大的影响,因为语言提供了一种新的模式,来增强我们解释和训练自动驾驶模型的方式。

自动驾驶车里进来一个捧哏的?

LINGO-1中的独特之处在于引入了一个人类专家,对驾驶场景的语言评论解说数据进行训练,让模型把环境感知、行动决策和类人的场景解读联系在一起。

这样,它就可以通过自然语言交互,来解读自动驾驶系统的决策和行动了。

英伟达高级AI科学家Jim Fan兴奋地点评道:这是我近期读到的自动驾驶领域最有趣的作品!

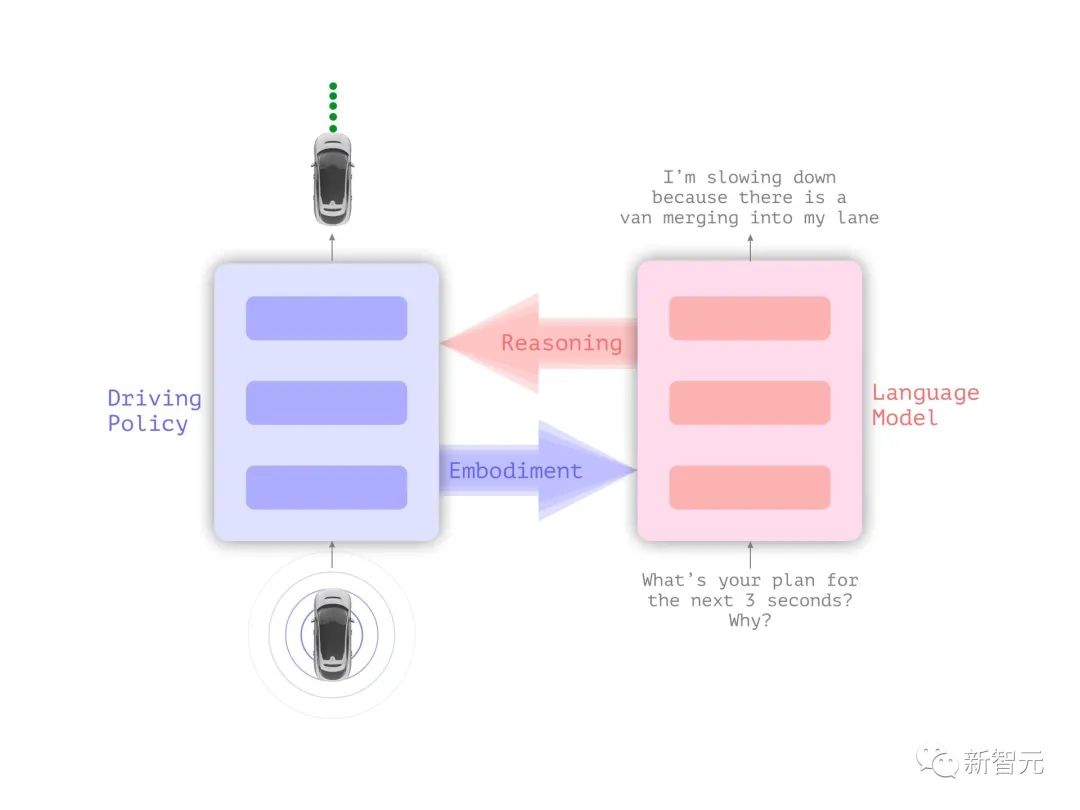

从前的自动驾驶,是「感知 -> 驾驶操作」,而以后的自动驾驶,加进了推理的这一步,是「感知->文字推理->行动」。

这个新加的显式推理步骤,有哪些优点?Jim Fan解释如下——

- 可解释性:驾驶模型不再是一个神秘的黑盒。

- 反事实情景:它能够想象出训练数据中没有的场景,并推理出如何正确地进行处理。

- 长尾编程:驾驶中存在大量边缘场景,要对所有场景进行良好的数据覆盖是不可能的。与其收集成千上万的示例来对一个案例进行「神经编程」,不如让人类专家编写提示(prompt)来解释少量的示例,从而指导系统如何处理特定或复杂的情景。

不仅如此,LINGO-1还和游戏人工智能领域的一些研究密切相关,比如MineDojo和思想克隆,它们都是AI智能体。

前者可以学习一种奖励模型,把评论文本和「我的世界」(Minecraft)游戏视频像素关联起来。后者可以实现「像素->语言->行动循环」的一整套链路。

LINGO-1——开环驾驶解说员

自个解说自个

模型在关注什么?在做什么?现在,这些都不是谜了。

LINGO-1会对你解释清楚,它的每一步行动是在干嘛。

LINGO-1:由于车流缓慢,我正在超车。

LINGO-1:我正在超越一辆停在路边的汽车。

LINGO-1:由于前方道路畅通,我正在加速。

驶近斑马线时——

LINGO-1:我正在保持车速;道路仍然畅通无阻。 LINGO-1:现在正在刹车减速。 LINGO-1:在斑马线处停下。 LINGO-1:我正在从停止的位置加速。 LINGO-1:我正在加速,因为道路通畅。

在十字路口左转时——

LINGO-1:我保持不动,因为前车也停了下来。 LINGO-1:我正在加速,因为前车已经驶离。 LINGO-1:我正在踩刹车,准备在路口停车。 LINGO-1:我正在前进,因为车道畅通。 LINGO-1:完成左转,沿着路线行驶。

视觉问答(VQA)

关键:驾驶解说数据集

- 前方车辆/交通信号灯有变,请减速 - 现在该变换车道了 - 可以加速了,注意不要超过最高限速 - 注意!其他车辆驶入道路/停在十字路口了 - 注意前方环岛和让路标志 - 前方有停放车辆/交通信号灯/学校 - 旁边车辆正在变道/超过停在路边的车辆 - 骑车的人/行人正在斑马线上等候

视觉-语言-行动模型(VLAM)

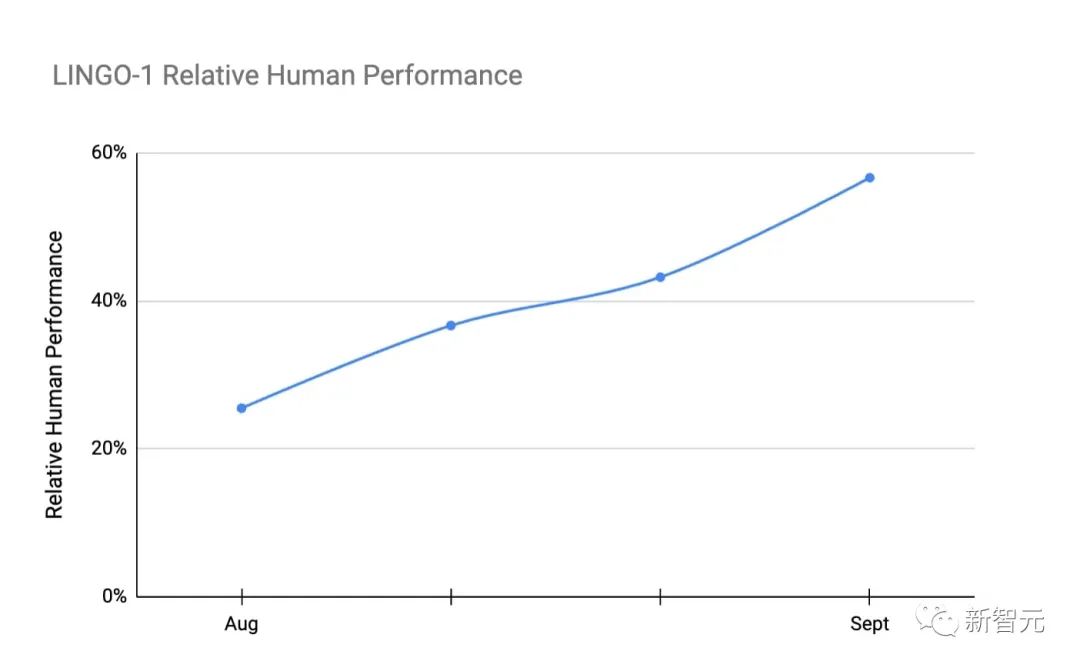

准确率60%

提高端到端模型的可解释性

更好的规划和推理,提高驾驶性能

新场景或长尾场景的高效学习

局限性

泛化

幻觉

上下文

闭环推理

网友讨论