论文推荐:在早期训练阶段预测下游模型性能

来源:DeepHub IMBA 本文约1000字,建议阅读5分钟

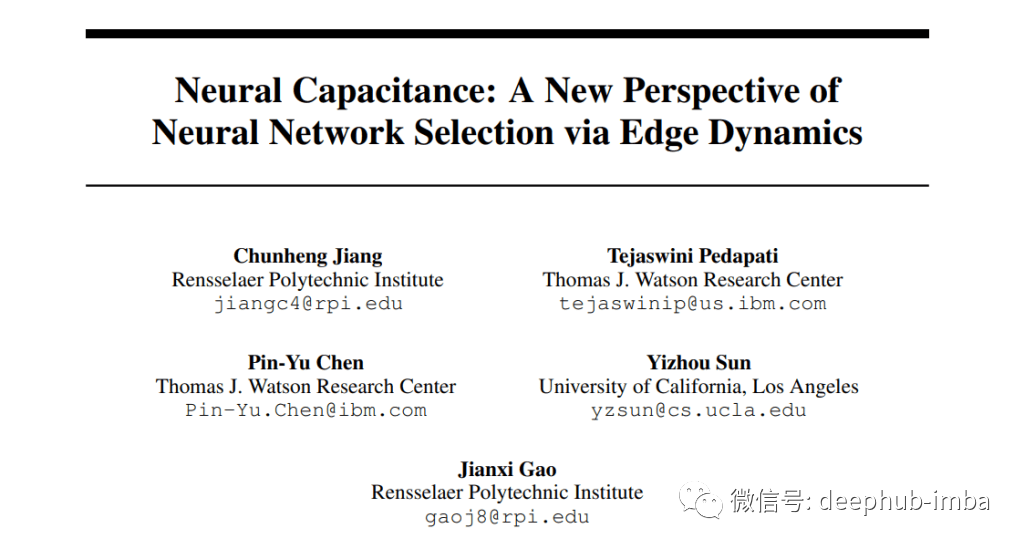

本文提出了一种针对下游任务的有效神经网络选择的新框架。

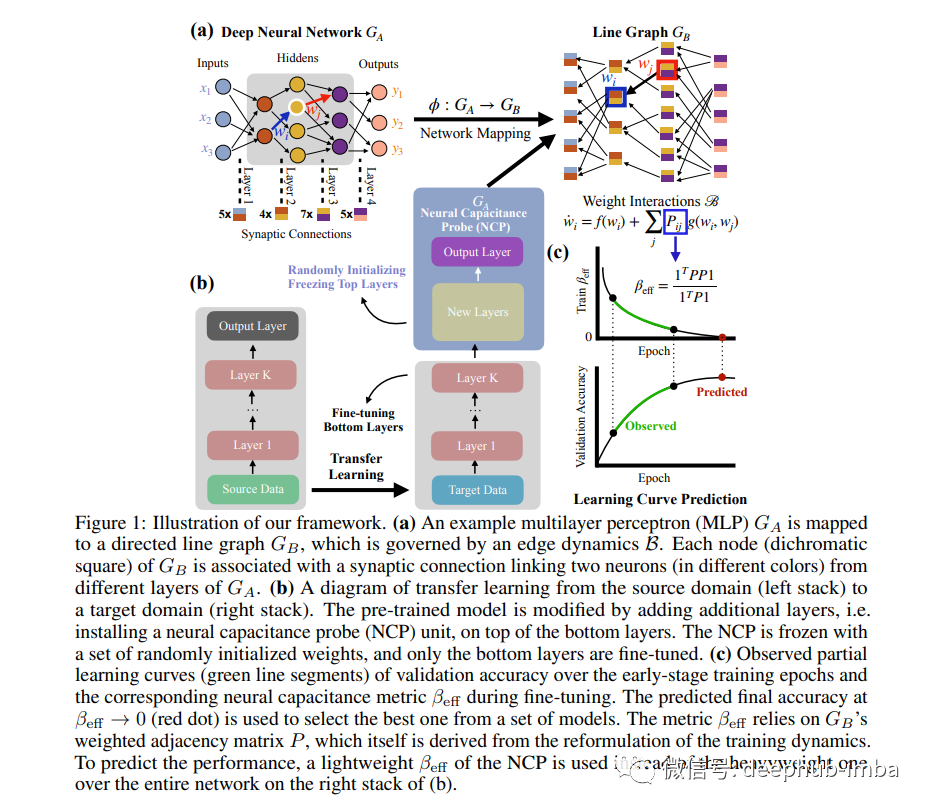

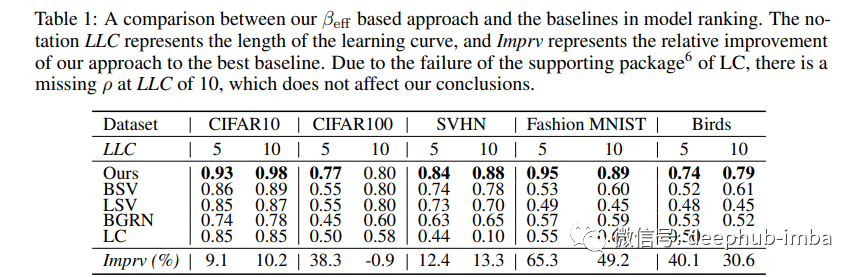

将神经网络训练看作是一个基于突触连接的动态系统,并首次从微观角度研究突触连接的相互作用。 提出了用于神经网络模型选择的神经电容度量βeff。 基于5个基准数据集的17个预训练模型的实验结果表明,我们的βeff方法优于现有的学习曲线预测方法。 在CIFAR10/CIFAR100/SVHN/Fashion MNIST/Birds上,根据训练前模型的性能,论文的方法比最佳基线提高了9.1/38.3/12.4/65.3/40.1%。

评论