CNN图像分类:从LeNet5到EfficientNet

Author:louwill

From:深度学习笔记

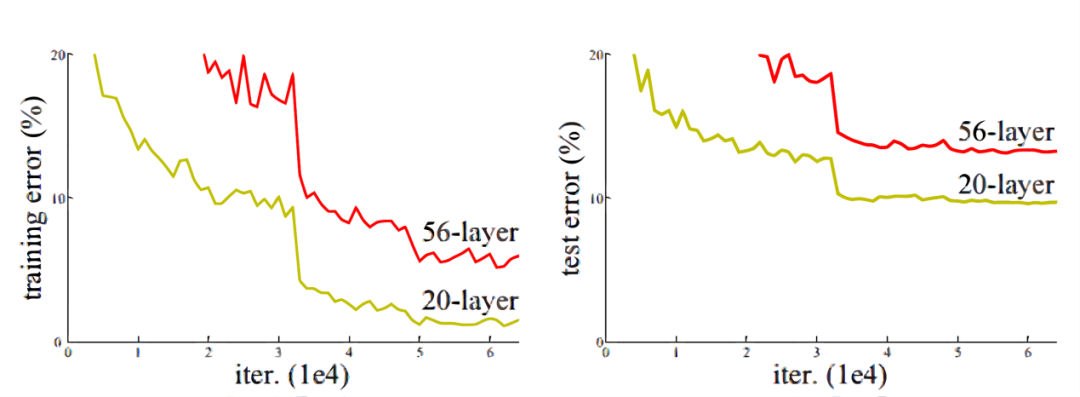

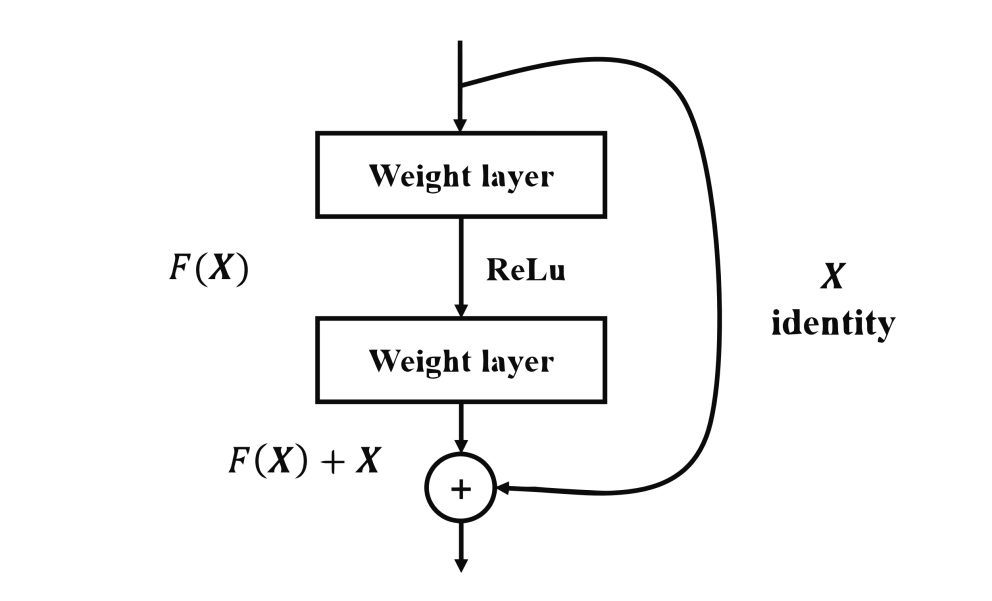

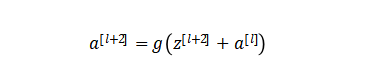

在网络中加入L2正则化进行权值衰减或者其他情形下,l+2层的权值是很容易衰减为零的,假设偏置同样为零的情形下就有等号成立。深度学习的试验表明学习这个恒等式并不困难,这就意味着,在拥有跳跃连接的普通网络即使多加几层,其效果也并不逊色于加深之前的网络效果。当然,我们的目标不是保持网络不退化,而是需要提升网络表现,当隐藏层能够学到一些有用的信息时,残差网络的效果就会提升。所以,残差网络之所以有效是在于它能够很好的学习上述那个恒等式,而普通网络学习恒等式都很困难,残差网络在两者相较中自然胜出。

在网络中加入L2正则化进行权值衰减或者其他情形下,l+2层的权值是很容易衰减为零的,假设偏置同样为零的情形下就有等号成立。深度学习的试验表明学习这个恒等式并不困难,这就意味着,在拥有跳跃连接的普通网络即使多加几层,其效果也并不逊色于加深之前的网络效果。当然,我们的目标不是保持网络不退化,而是需要提升网络表现,当隐藏层能够学到一些有用的信息时,残差网络的效果就会提升。所以,残差网络之所以有效是在于它能够很好的学习上述那个恒等式,而普通网络学习恒等式都很困难,残差网络在两者相较中自然胜出。

往期精彩:

喜欢您就点个在看!

评论