智谱AI推出第三代基座大模型

来源:GLM大模型

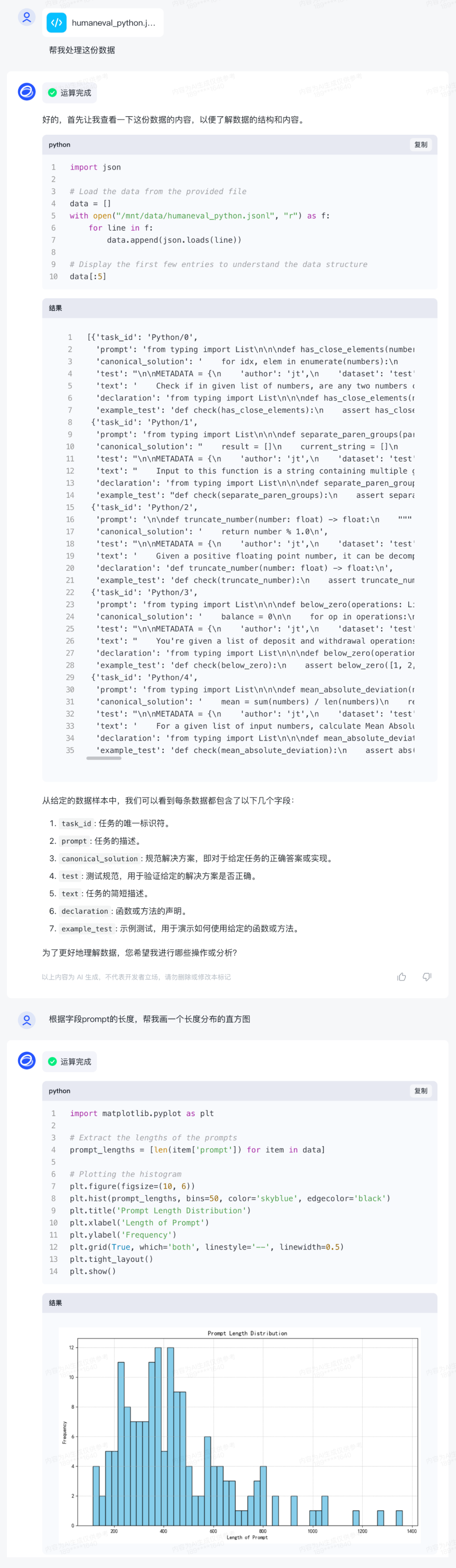

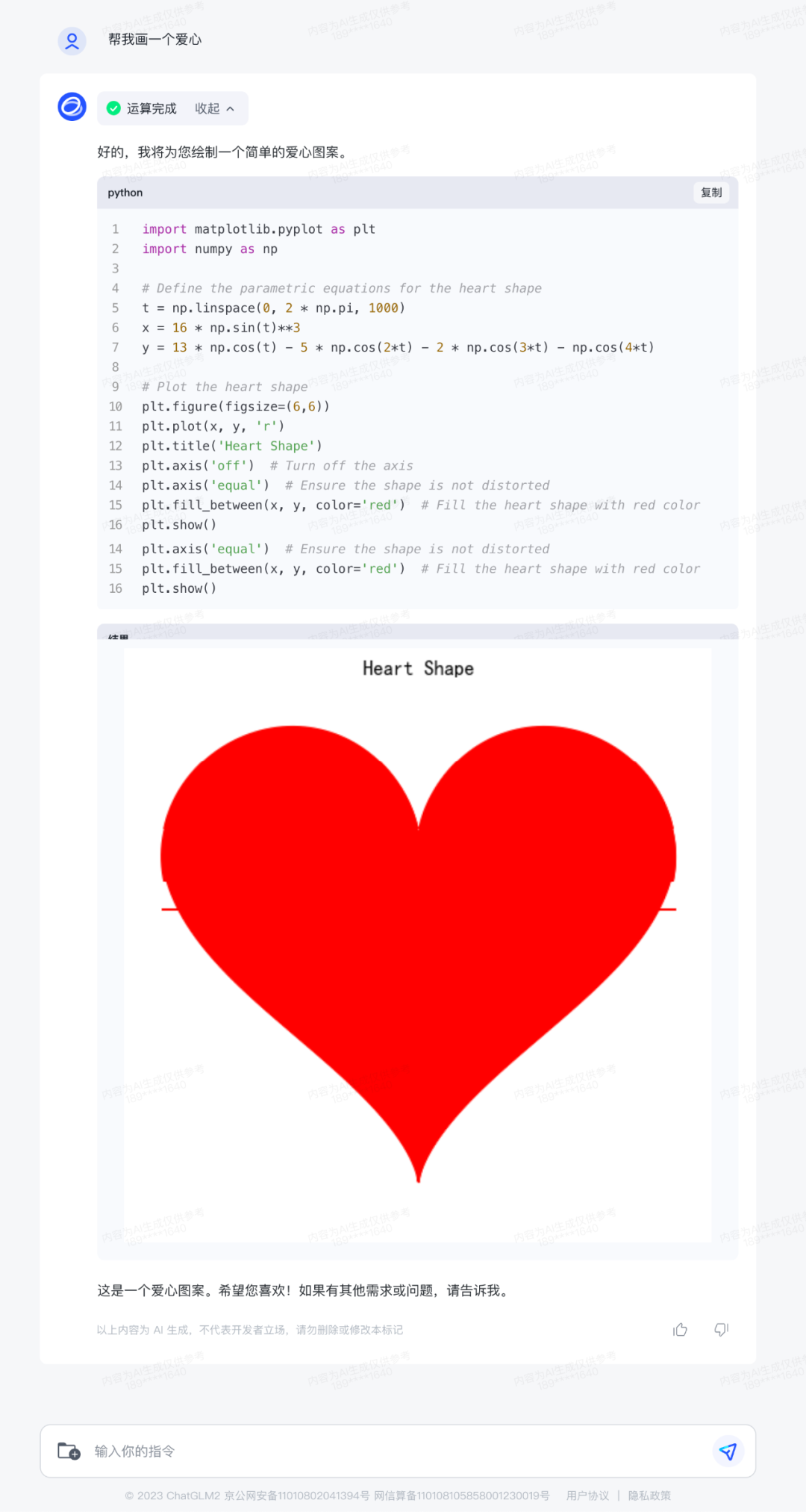

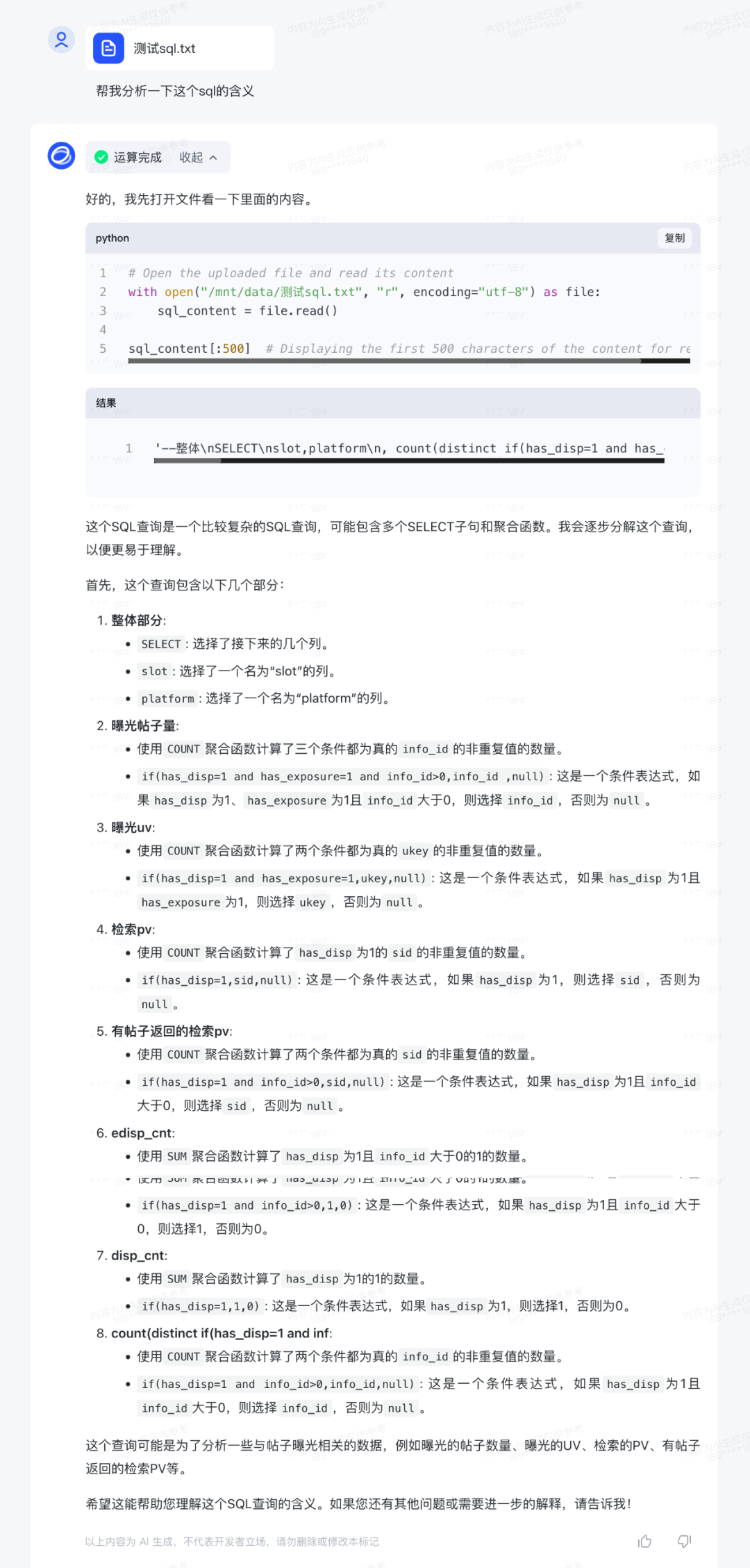

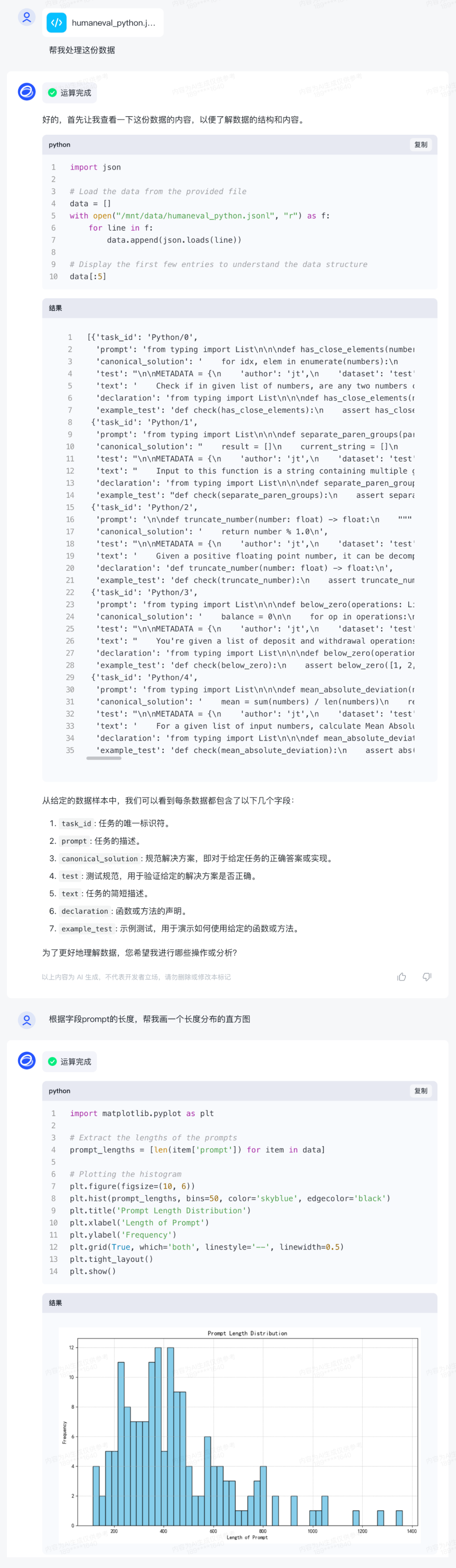

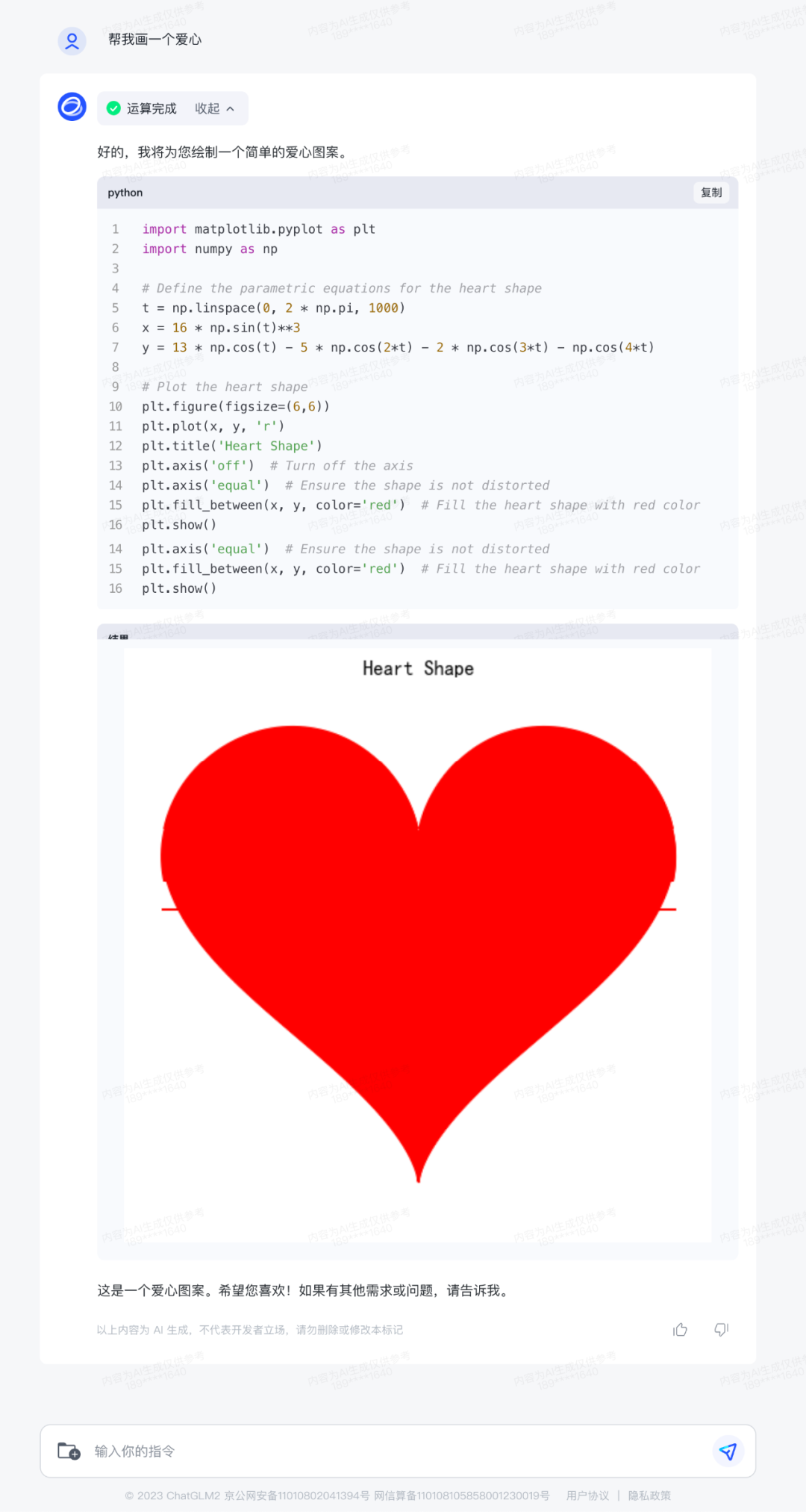

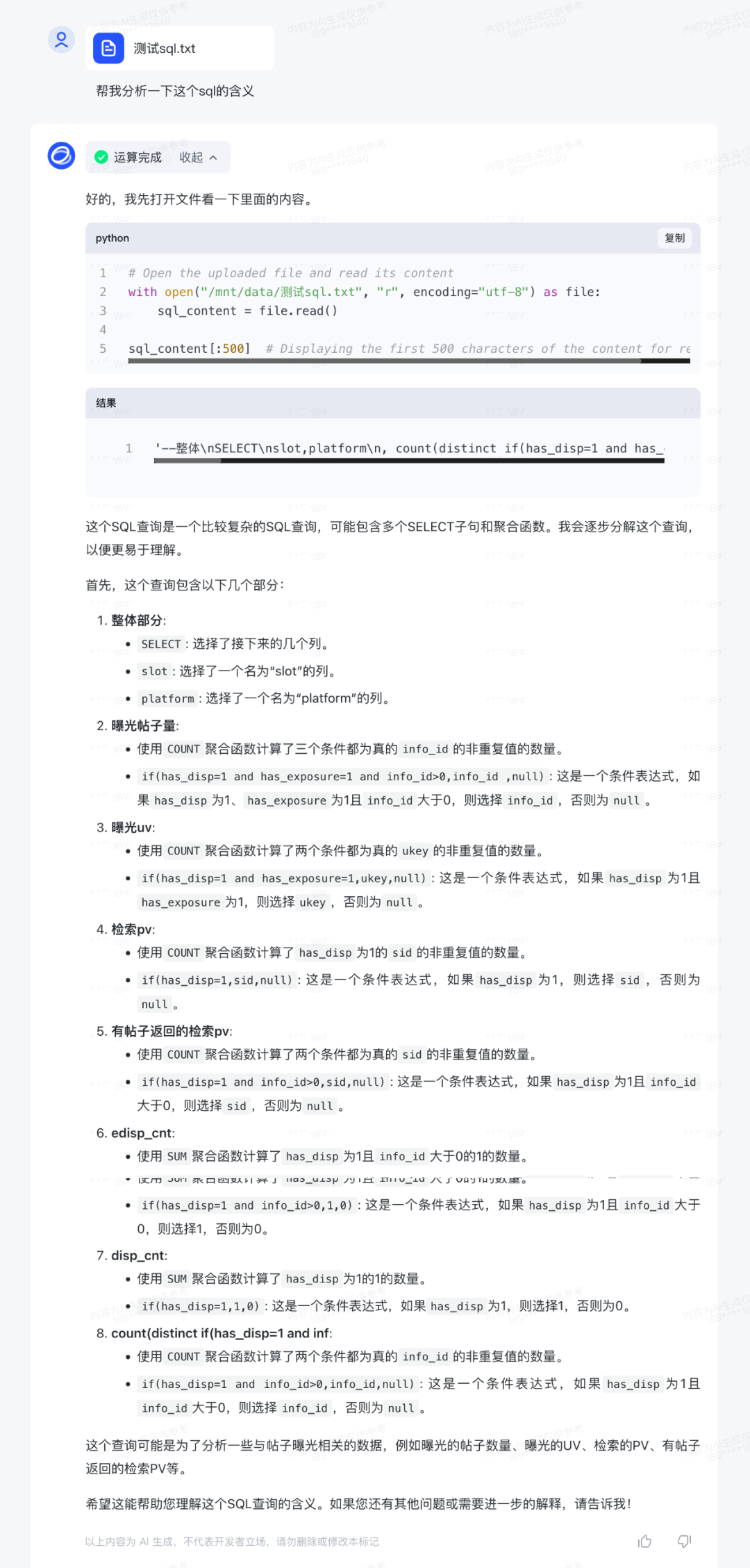

2023年10月27日,智谱AI于 2023 中国计算机大会(CNCC)上,推出了全自研的第三代基座大模型 ChatGLM3 及相关系列产品。

如下。

——The End——

分享

收藏

点赞

在看

评论

来源:GLM大模型

2023年10月27日,智谱AI于 2023 中国计算机大会(CNCC)上,推出了全自研的第三代基座大模型 ChatGLM3 及相关系列产品。

如下。

——The End——

分享

收藏

点赞

在看