Yann LeCun 最新发声:自监督+世界模型,让 AI 像人类与一样学习与推理

来源:AI科技评论 本文约6100字,建议阅读10+分钟

Yann LeCun提倡下一代AI系统将不再依赖于精心标注的数据集。

如何突破当代人工智能(AI)的瓶颈?不同学者存在不同观点。

总体来看可以概括为两类,其一监督学习者,提倡通过改善数据标签质量,从而完善监督学习。代表人物有发起“以数据为中心AI”革命的吴恩达,提倡设计“合成数据自带所有标签”的Rev Lebaredian。

其二,无监督学者,例如Yann LeCun,提倡下一代AI系统将不再依赖于精心标注的数据集。

近日,Yann LeCun在meta AI(原Facebook)官方博客上以及IEEE采访中,深度阐述了他的自监督学习思路,他认为AI想要突破现在的瓶颈,必须让机器学习世界模型,从而能够填补缺失的信息,预测将要发生的事情,并预测行动的影响。

这虽然不是革命性的想法,但却是革命性的行动。正如LeCun在多次演讲中提到:这场革命将是无监督的(THE REVOLUTION WILL NOT BE SUPERVISED)。具体而言这种革命性体现在对两个问题的思考:

第一,我们应该使用什么样的学习范式来训练世界模型?

第二,世界模型应该使用什么样的架构?

同时,他也提到:监督学习的局限性有时会被误以为是深度学习的局限性,这些限制可以通过自监督学习来克服。

以下是LeCun对自监督的思考与世界模型设计,内容来源于meta AI与IEEE,AI科技评论做了不改变原意的编译。

一、AI可以学习世界模型

LeCun提到,人类和动物能够通过观察,简单的交互,以及无监督的方式学习世界知识,因此可以假设,这里面蕴含的潜在能力构成了常识的基础。这种常识能够让人类在陌生的环境下完成任务,例如一位年轻的司机,从来没有在雪地里开过车,但是他却知道如果车开得太猛,轮胎会打滑。

早在几十年前,就有学者研究人类、动物甚至智能系统如何“借力”世界模型,自我学习。因此,当前AI也面临着重新设计学习范式和架构,使机器能够以自我监督的方式学习世界模型,然后使用这些模型进行预测、推理和规划。

世界模型需要融合不同的学科的观点,包括但不限于认知科学、系统神经科学、最优控制、强化学习以及 "传统 "人工智能。必须将它们与机器学习的新概念相结合,如自监督学习和联合嵌入架构(joint-embedding architectures)。

二、AI新架构:自主智能架构

在上述世界模型思想的基础上,LeCun 提出了自主智能机构,由六个独立模块组成,且假设每个都可微:可以容易地计算一些目标函数,以及相对应的梯度估计,并将梯度信息传播到上游模块。

自主智能的系统架构:配置器(configurator)是核心,从其他模块获取输入。

配置器的角色是控制。给定一个要执行的任务,它会通过调整参数预先配置感知模块、世界模型,以及计算成本和添加参与者(actor)。

感知模块能够接收信息,估计现实世界。对于一个特定的任务,只有一小部分感知到的世界状态是相关和有用的。配置器为感知模块提供动力,从感知中提取与任务相关的信息。

世界模型模块是最复杂的部分,具有双重作用。1.估计感知模块无法得到的缺失信息;2.合理预测世界的未来状态,其中包括世界的自然演变以及参与者行动的影响。世界模型是现实世界的模拟器,由于世界充满了不确定性,该模型必须能够处理多种可能的预测。直观的例子是:一个接近十字路口的司机可能会放慢汽车行驶的速度,防止另一辆接近十字路口的车没有按规矩停在停车标志上。

成本模块用来计算预测智能体(agent)的不合适程度。由两部分组成:内在成本( intrinsic cost),特征是不可训练,但能实时计算“不适”:智能体损害、违反硬编码行为等;评价者(critic),它是一个可训练的模块,预测内在成本的未来值。

LeCun表示:成本模块是基本的行为驱动和内在动机的所在。因此,它将考虑到内在成本:不浪费能源,以及任务的具体消耗。成本模块是可分的,成本的梯度可以通过其他模块反向传播,用于规划、推理或学习。

参与者模块提供行动建议。参与者模块可以找到一个使估计的未来成本最小化的最佳行动序列,并在最佳序列中输出第一个行动,其方式类似于经典的最优控制。

短期记忆模块可以记录当前情况,预测世界状态,以及相关成本。

三、世界模型架构和自监督训练

世界模型架构的核心在于预测。

构建世界模型的一个关键挑战是如何使该模型能够表示多个模糊的预测。现实世界并不是完全可以预测的:一个特定的情况可能有多种演变的方式,并且许多与情况相关的细节与手头的任务无关。比如,我可能需要预测我开车时周围的汽车会做什么,但我不需要预测道路附近树木中个别叶子的详细位置。那么,世界模型如何学习现实世界的抽象表示,做到保留重要的细节、忽略不相关的细节,并且可以在抽象表示的空间中进行预测呢?

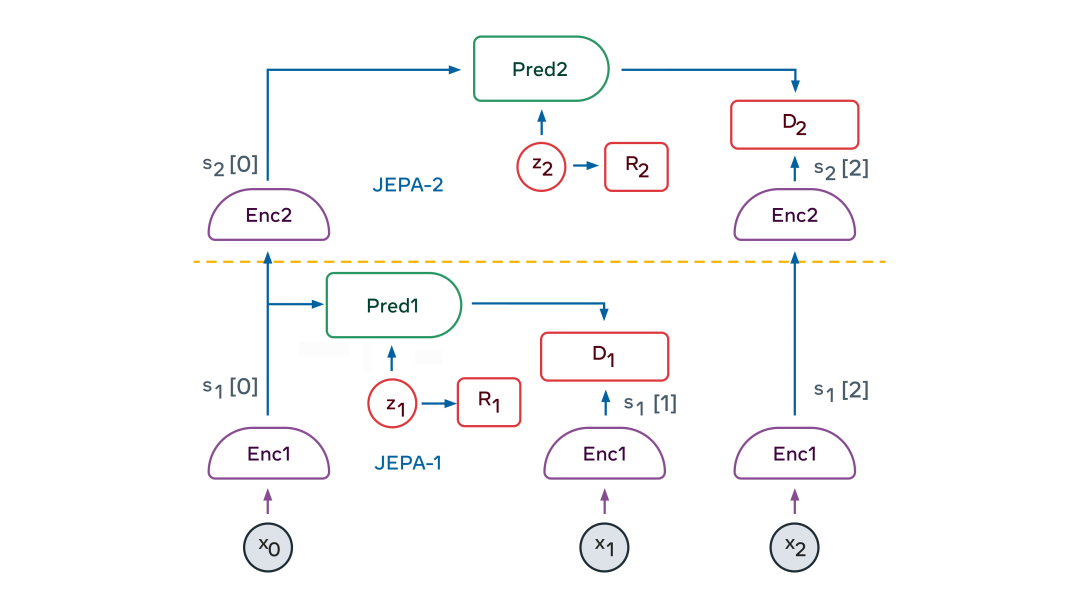

解决方案的一个关键要素是联合嵌入预测架构 (Joint Embedding Predictive Architecture ,JEPA)。JEPA 捕获两个输入(x 和 y)之间的依存关系。例如,x 可以是一段视频,y 可以是视频的下一段。输入 x 和 y 被馈送到可训练的编码器,这些编码器提取它们的抽象表示,即 sx 和 sy。预测器模块被训练为从 sx 预测 sy。预测器可以使用潜在变量 z 来表示 sy 中存在但 sx 中不存在的信息。JEPA 以两种方式处理预测中的不确定性:(1)编码器可能会选择丢弃难以预测的有关 y 的信息;(2)当潜在变量 z 在一个集合上变化时,将导致预测在一个集合上变化一组似是而非的预测。

那么,我们如何训练 JEPA 呢?

截至目前为止,研究者所使用的唯一方法就是“对比”,包括显示兼容 x 和 y 的示例,以及许多 x 和不兼容 y 的示例。但是当表示是高维状态时,这是相当不切实际的。

过去两年还出现了另一种训练策略:正则化方法。当应用于 JEPA 训练时,该方法使用了四个标准:

使 x 的表示最大限度地提供关于 x 的信息;

使 y 的表示最大限度地提供关于 y 的信息;

使 y 的表示可以从 x 的表示中最大程度地预测;

使预测器使用尽可能少的潜在变量信息来表示预测中的不确定性。

这些标准可以以各种方式转化为可微的成本函数。一种方法是 VICReg 方法,即方差/变量(Variance)、不变性(Invariance)、协方差正则化(Covariance Regularization)。在 VICReg 中,x 和 y 表示的信息内容通过将其分量的方差保持在阈值之上并通过使这些分量尽可能地相互独立来最大化。同时,该模型试图使 y 的表示可以从 x 的表示中预测。此外,潜变量的信息内容通过使其离散、低维、稀疏或噪声来最小化。

JEPA 的美妙之处在于它自然地产生了输入的信息抽象表示,消除了不相关的细节,并且可以执行预测。这使得 JEPA 可以相互堆叠,以便学习具有更高抽象级别的表示,可以进行长期预测。

例如,一个场景可以在高层次上描述为“厨师正在制作可丽饼”。它可以预测厨师会去取面粉、牛奶和鸡蛋,将食材混合,把面糊舀进锅里,将面糊油炸,并翻转可丽饼,然后不断重复该过程。在较低层次的表达上,这个场景可能是倒一勺面糊并舀均匀,且将其铺在锅周围。一直持续到每一毫秒的厨师的手的精确轨迹。在低层次的手部轨迹上,我们的世界模型只能进行短期的准确预测。但在更高的抽象层次上,它可以做出长期的预测。

分层 JEPA 可用于在多个抽象级别和多个时间尺度上执行预测。训练方式主要是通过被动观察,很少通过互动。

婴儿在出生后的头几个月主要通过观察来了解世界是如何运作的。她了解到世界是三维的,知道有些物体会摆在其他物体的前面,当一个物体被遮挡时,它仍然存在。最终,在大约 9 个月大的时候,婴儿学会了直观的物理学——例如,不受支撑的物体会因重力而落下。

分层 JEPA 的愿景在于它可以通过观看视频和与环境交互来了解世界是如何运作的。通过训练自己来预测视频中会发生什么,它可以生成对世界的分层表示。通过在世界上采取行动并观察结果,世界模型将学会预测其行动的后果,进而能够推理和计划。

四、“感知-行动”情节

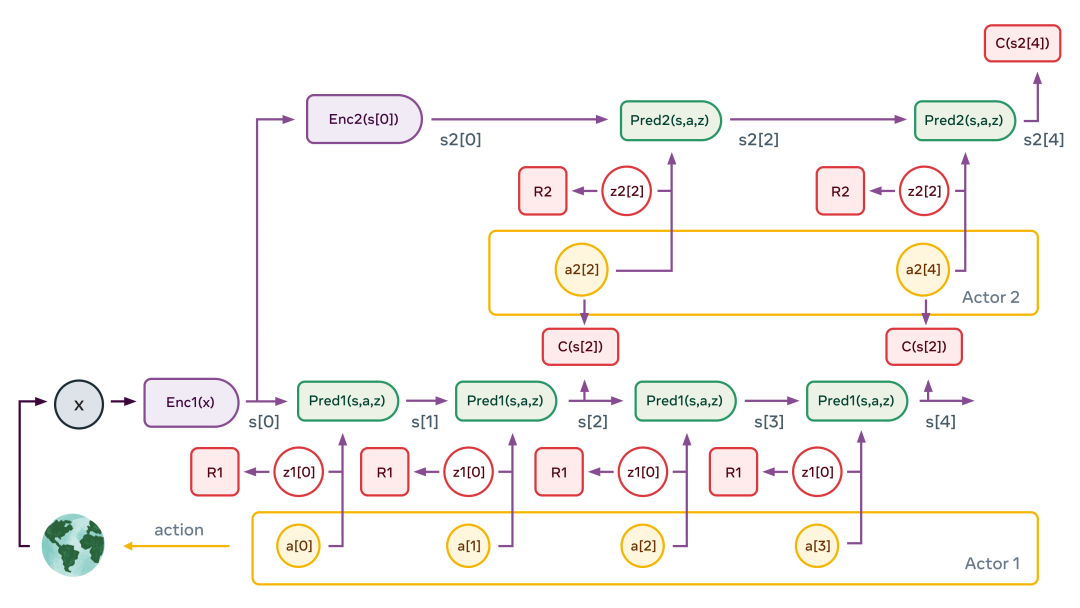

通过将分层 JEPA 训练为世界模型,一个智能体(机器人)就可以执行复杂动作的分层规划,将复杂任务分解为一系列不太复杂和不太抽象的子任务,一直到对效应器(effector)的低级动作。

一个典型的感知-行动情节如上。该图说明了两级层次结构的情况。感知模块提取世界状态的分层表示(图中 s1[0]=Enc1(x) 和 s2[0]=Enc2(s[0]))。然后,在假设二级行动器提出的一系列抽象动作的情况下,多次应用二级预测器来预测未来状态。行动器优化二级动作序列以将总成本最小化(图中的C(s2 [4]))。

这个过程类似于最优控制中的模型预测控制。对第二级潜在变量的多个绘图重复该过程,这可能会产生不同的高级场景。由此产生的高级动作并不构成真正的动作,而只是定义了低级状态序列必须满足的约束(例如,食材是否正确混合?)。它们确实构成了子目标。整个过程在低层重复:运行低层预测器,优化低层动作序列以将上层的中间成本最小化,并对低层潜在变量的多个绘图重复该过程。一旦该过程完成,智能体将第一个低级动作输出到效应器,整个情节可以重复。

如果我们成功构建了一个这样的模型,那么所有的模块都是可微的,因此整个动作优化过程可以使用基于梯度的方法来执行。

五、使 AI 更接近人类水平的智能

LeCun 的愿景需要更深入地探索,而且前方还有许多艰巨的挑战。其中最有趣又最困难的一项挑战是为世界模型将架构和训练细节实例化。我们甚至可以说,训练世界模型是未来几十年人工智能可以真正取得进展的主要挑战。

但是架构的许多其他方面仍有待定义,包括如何精确地训练Critic(Critic网络的作用是衡量一个Actor在某状态下的优劣),如何构建和训练配置器,以及如何使用短期记忆来跟踪世界状态和存储世界状态与行动的历史,用内在成本来调整Critic。

LeCun 和其他 Meta AI 的研究人员期待在未来数月和数年内探索这些内容,并与该领域的其他人交流想法和学习。创造可以像人类一样有效地学习和理解的机器是一项长期的科学努力——而且不能保证成功。但我们相信,基础研究将继续加深对思想和机器的理解,并将带来更多造福人类的人工智能突破成果。

六、Yann LeCun:AI 不需要人类的监督

IEEE Spectrum:您曾说过,监督学习的局限性有时会被误认为是深度学习的内在局限,那哪些限制可以通过自监督学习来克服呢?

Yann LeCun:监督学习在一些结构稳定的领域中表现很出色。在这些领域中,你可以收集大量的标记数据,并且在部署过程中可以看到,这些输入类型与训练过程中使用的输入类型没有太大区别。要收集大量且相对没有偏差的标记数据是很难的。我所说的不一定是社会偏差,而是说系统不应该使用数据中的相关性。一个非常著名的例子是,当你在训练一个能够识别奶牛的系统时,若训练中用的都是草场上的奶牛,那么系统将把草作为奶牛的背景。如果再给它一头在海滩上的奶牛,它可能就很难识别出了。

自监督学习 (SSL) 允许我们训练系统以独立于任务的方式学习良好的输入表示。因为 SSL 训练使用未标记的数据,所以我们可以使用非常大的训练集,并让系统学习更稳健和更完整的输入表示。然后,它只需要少量的标记数据就能在监督任务上获得良好的性能。这大大减少了纯监督学习所特有的标记数据量,并使系统更加稳健,能够更好地处理与标记训练样本不同的输入。它有时还会降低系统对数据偏差的敏感性——关于这一改进,我们将在未来几周内分享更多关于研究的见解。

现在在实际的 AI 系统中正在发生的事情是,我们正在转向使用 SSL 对大量未标记数据进行预训练的更大架构。这些可用于各种任务。例如,Meta AI 现在拥有可以处理几百种语言的语言翻译系统。这是一个单一的神经网络!我们还有多语种语音识别系统。这些系统可以处理几乎没有数据的语言,更不用说带注释的数据了。

IEEE Spectrum:其他行业先驱说,人工智能的前进方向是通过更好的数据标记来改进监督学习。吴恩达最近和我谈到了以数据为中心的AI,英伟达 的 Rev Lebaredian 和我谈到了带有所有标签的合成数据。该领域是否存在关于前进道路的分歧?

LeCun:我不认为存在哲学上的分歧。SSL 预训练是 NLP 中非常标准的做法。它在语音识别方面表现出了出色的性能改进,并且在视觉方面开始变得越来越有用。然而,“经典”监督学习仍有许多未开发的应用,因此人们当然应该尽可能使用合成数据和监督学习。据说英伟达也正在积极开发 SSL。

早在 2000 年代中期,Geoff Hinton、Yoshua Bengio 和我就确信,我们能够训练非常大和非常深的神经网络的唯一方法是通过自监督(或无监督)学习。这也是吴恩达开始对深度学习感兴趣的时候。他当时的工作也集中在我们现在称之为自监督的方法上。

IEEE Spectrum:自监督学习如何促成具有常识的 AI 系统?常识能把 AI 系统带向人类水平的智能多远?

LeCun:我认为,一旦我们弄清楚如何让机器像人类和动物一样学习世界是如何运作的,人工智能就会取得重大进展:这主要是通过观察,并在观察中采取行动。我们了解世界是如何运作的,因为我们已经了解了世界的内部模型,该模型使我们能够填补缺失的信息,预测将要发生的事情,并预测我们行动的影响。我们的世界模型使我们能够感知、解释、推理、提前计划和行动。

但机器如何学习世界模型呢?这归结为两个问题:我们应该使用什么学习范式来训练世界模型?世界模型应该使用什么架构?

对于第一个问题,我的答案是 SSL(自监督学习)。一个例子是让机器观看视频,暂停视频,然后让机器学习视频中接下来会发生什么的表示。在这样做的过程中,机器可以学习大量关于世界如何运作的背景知识,可能类似于婴儿和动物在生命的最初几周和几个月内的学习方式。

对于第二个问题,我的答案是一种新型的深度宏架构,我称之为分层联合嵌入预测架构(H-JEPA)。简单解释,JEPA 不是预测视频剪辑的未来帧,而是学习视频剪辑的抽象表示和剪辑的未来,以便后者能够基于对前者的理解很容易地预测。这可以使用非对比 SSL 方法的一些最新发展来实现,特别是我和我的同事最近提出的一种称为“VICReg”的方法。

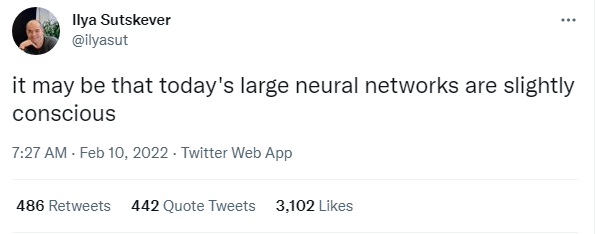

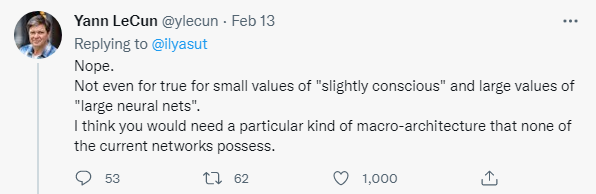

IEEE Spectrum:几周前,你回复了在OpenAI任职的 Ilya Sutskever 的一条推文,他在推文中推测,今天的大型神经网络可能有意识。你的回答是响亮的“不”。在您看来,构建一个有意识的神经网络需要什么?那个系统会是什么样子的?

LeCun:首先,意识是一个非常模糊的概念。一些哲学家、神经科学家和认知科学家认为这只是一种幻觉,我非常接近这种观点。

但我对导致意识错觉的原因有一个猜测。我的假设是,我们的前额叶皮质中有一个单一的世界模型“引擎”。该世界模型可根据当前情况进行配置。我们是帆船的舵手;我们的世界模型模拟了我们船周围的空气和水流。我们建了一张木桌;我们的世界模型想要像切割木头和组装它们的结果,等等。

我们的大脑中需要一个模块,我称之为“配置器”,它为我们设定目标和子目标,配置我们的世界模型来模拟当前的情况,并启动我们的感知系统以提取相关信息并丢弃赘余信息。监督配置器的存在可能是让我们产生意识错觉的原因。但有趣的是:我们需要这个配置器,因为我们只有一个世界模型引擎。如果我们的大脑足够大,可以容纳许多世界模型,我们就不需要意识。所以,从这个意义上说,意识是我们大脑局限的结果!

IEEE Spectrum:自监督学习在元宇宙的构建中可以扮演什么角色?

LeCun:深度学习在虚拟世界中有很多具体的应用,比如 VR 护目镜和 AR 眼镜的运动跟踪,捕捉和重新合成身体运动和面部表情等等。

元宇宙中人工智能驱动的新创意工具有很多机会,可以让每个人在虚拟世界和现实世界中创造新事物。但元宇宙也有一个“纯AI”的应用:虚拟 AI 助手。我们应该有虚拟的 AI 助手,可以在日常生活中帮助我们,回答我们的任何问题,并帮助我们处理每天轰炸我们的海量信息。为此,我们需要我们的 AI 系统对世界如何运作(无论是物理还是虚拟)有一定的了解,有一定的推理和计划能力,以及一定程度的常识。简而言之,我们需要弄清楚如何构建可以像人类一样学习的自主 AI 系统。这需要时间。但是Meta在这条赛道上已经走了很长时间。

参考链接:

1.https://ai.facebook.com/blog/yann-lecun-advances-in-ai-research

2.https://spectrum.ieee.org/yann-lecun-ai