2022年计算芯片(CPU/GPGPU/FPGA/AI/DPU)市场空间及发展趋势

近年来,在云计算蓬勃发展的同时,异构计算市场也乘风得到了长足的发展。对芯片设计企业而言,过去进入服务器计算芯片市场只有通过有竞争力的 X86 CPU,而现在 GPU、FPGA、AI 芯片各类架构 CPU 等多种计算芯片均在服务器中得到广泛应用,为国产 CPU 及 AI 芯片公司,以及基于国产芯片的智能计算产业链提供了良好的发展机会。

云计算应用服务器,主要芯片构成为计算、存储和网络通信。本文选自“中国云计算生态蓝皮书(2022)”,主要关注计算芯片,包括 CPU、GPU/GPGPU(General-purpose Computing on Graphics Processing Units,通用图形处理器)、FPGA、AI 加速芯片等和以 DPU 为代表的网络通信芯片。

下载链接:

技术层面上,传统 CPU 为中心的计算架构,已经不能满足信息应用需求,开始转向 CPU 来负责系统管理和应用程序,维持软硬件生态,各种 XPU(X Process Unit,各种处理器)来提供算力,各个芯片协同合作来实现数据中心降本增效。

CPU 中央处理器作为计算机系统的运算和控制核心,是信息处理、程序运行的最终执行单元。CPU是整个 IT 生态的定义者,无论是服务器端的 X86 还是移动端的 ARM(安谋),都各自构建了稳固的生态系统,不仅形成技术生态圈,还形成闭合价值链。

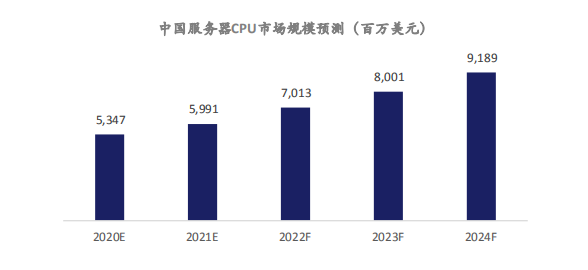

数据中心应用 CPU 价格高,利润最为丰富,根据不同配置,CPU 占据服务器总成本约 1/3 到 1/2。根据中金证券研究数据,2021 年中国服务器 CPU 市场规模 60 亿美元,预计 2024 年达到 92 亿美元,3 年年均复合增长率 15%。

X86、ARM、RISC-V( Reduced Instruction Set Computer-V,第五代精简指令集计算机 )是 CPU 三大技术架构。服务器市场上 X86 处理器市占率超过 90%,占据绝对主导地位。其中英特尔市场占有率接近 90%,服务器市场贡献了英特尔主要的利润和营收。借助台积电先进制程,AMD 服务器CPU 霄龙强势崛起,根据 IDC 数据 2021 年第四季度,AMD 数据中心 CPU 市场占有率自 2016 年之后首超 10%。为应对新的挑战,英特尔 2021 年底历史第一次宣布开放 X86 指令集给第三方公司。

ARM 开放指令集以及在移动端构建的良好生态,数据中心巨大市场以及丰厚利润吸引各家巨头入局开发 ARM 架构服务器 CPU,其市场占有率稳步提升。除美满、富士通、英伟达、海思等传统芯片巨头之外,亚马逊、谷歌、阿里等手握资金、技术以及应用场景的新型互联网公司也加入这一战局,给市场带来变数。ARM 架构服务器 CPU 性能不断提升、生态不断完善,与 X86 架构正面竞争,蚕食之势不容小觑。

RISC-V 作为后起之秀发展迅速,英特尔在 2021 年提出 20 亿美元收购专注于高性能计算的 RISC-V初创公司 SiFIVE。RISC-V 是开源指令集,开放程度比 ARM 更好,支持指令集扩展。RISC-V 在专用领域的计算已经取得成效,比如国内初创公司希姆计算,把 RISC-V 作为 AI 加速卡计算核心,并扩展张量和矢量计算核,应用于互联网云端推理芯片,实现良好编程性,性价比相比传统 GPU 芯片提升 4 倍,产品即将在头部互联网公司内容和广告推荐场景开始大规模部署。

在信创市场驱动下,国产 CPU 各个技术赛道全方面布局,初步满足国产替代需求。CPU 进入门槛最高,Wintel(Windows-intel,微软和英特尔)联盟构建了又深又宽的护城河。信创市场场景相对简单,降低了 CPU 生态建立难度,另外市场规模大,能够支持国产芯片公司持续迭代产品,给国产 CPU 发展带来巨大市场机会。中国 CPU 另外一个特点就是各个技术赛道全方面布局。X86 架构有海光、兆芯,新兴 ARM 架构有飞腾、海思,MIPS( Microprocessor without Interlocked Piped Stages ,无内部互锁流水级处理器)架构有龙芯,RISC-V 架构有阿里等。

传统 CPU 为核心的计算架构中所有数据和指令都由 CPU 来处理。然而 CPU 的架构不适合处理高并行度数据计算业务,更适合进行逻辑运算和整个计算机的管理。随着业务越来越复杂,数据流量呈现指数级增长,全部业务和数据靠 CPU 处理,性价比极低。因此出现了各种协处理器 XPU,专门帮助 CPU 处理各种特定应用场景业务。最早出现的就是计算机 3D 图形渲染专用加速芯片,特点是大量的并行小核,需要在 CPU 调度下工作。1999 年英伟达发布第一款 GPU 产品 NV10,在市场上第一次推出 GPU 概念。随后英伟达把 GPU 应用推广到 GPGPU 和 CUDA( Compute Unified Device Architecture,统一计算设备架构 )编程框架推广,GPU 成为并行计算的主力算力引擎。2012 年的ImageNet 比赛,取得突破的 AlexNet 的发明人亚历克斯使用了英伟达的 GPU,证明了 GPU 非常适合用于多并行计算的神经网络,从此 GPU 成为深度学习标配,引爆市场。

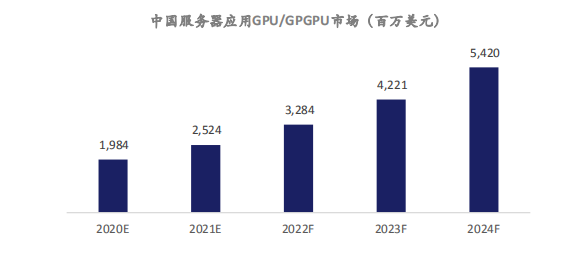

目前中国深度学习加速服务器 90%还是采用 GPU/GPGPU,根据中金证券测算,2021 年中国服务器应用 GPU/GPGPU 市场规模达到 25 亿美元,预计 2024 年市场规模达到 54 亿美元,3 年复合增长率达到 30%。

GPU 采用最先进的逻辑工艺,不考虑巨大的生态建设费用,单芯片研发成本 10 亿人民币起步,过去鲜有资本和创业团队涉足。在 GPU 成为 AI 主要算力芯片,海外英伟达股价屡创新高的示范效应下,叠加中国进口替代以及科创板对芯片产业支持带来的赚钱效应,资本市场对国产 GPU 赛道高度兴奋,GPU 初创公司不断涌现,融资金额屡创新高,估值动辄超百亿。英伟达、AMD 高管为主的创业团队,超一线 VC 机构重金支持,成为国产 GPU 初创公司范式。

FPGA 是基于通用逻辑电路阵列的集成电路芯片,和 ASIC芯片不同,其最大的特点是芯片的具体功能在制造完成以后由用户配置决定。用户可通过配套的 FPGA 专用 EDA 软件实现具体功能,首先由专用 EDA 软件接受用硬件语言描述的用户电路,其次编译生成二进制位流数据,最后将位流下载到芯片中实现用户所需特定功能的集成电路芯片。每颗 FPGA 芯片均可以进行多次不同功能配置,从而实现不同的功能。

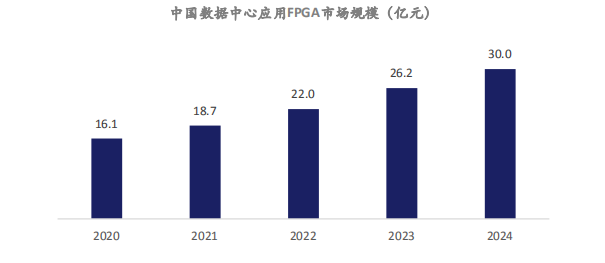

FPGA 芯片具有灵活性高、应用开发成本低、上市时间短等优势。数据中心是 FPGA 芯片的新兴应用市场之一,根据 Frost&sullivan 数据,2020 年应用于该领域的 FPGA 芯片中国销售额将达到 16.1亿元,占中国 FPGA 芯片市场份额的 10.7%,预计 2024 年将达到 30 亿元,2021 年至 2024 年年均复合增长率将达到 16.6%。

FPGA 芯片在数据中心领域主要用于硬件加速,数据中心使用 FPGA 芯片代替传统的 CPU 方案后,处理其自定义算法时可实现显著的加速效果。因此从 2016 年开始,微软 Azure、亚马逊 AWS、阿里云的服务器上都开始部署 FPGA 加速器用于运算加速。在云计算大面积应用的背景下,未来数据中心对芯片性能的要求将进一步提升,更多数据中心将采纳 FPGA 芯片方案,这将进一步提高FPGA 芯片在数据中心芯片中的价值占比。

深度学习涉及少量标量计算、大量的矢量计算和张量计算。GPU 是标量计算核,在处理深度学习数据时,需要消耗大量资源把矢量和张量计算转变为标量计算,因此 GPU 实际算力利用率最高只能达到 40%。固定算法的 ASIC 芯片利用率最高,但是不适合业务复杂、算法在一直更新的云计算应用,而更适合边缘端应用。因此专门针对深度学习应用,结合标量计算、矢量计算和张量计算的 DSA(Domain Specific Architectures,特定领域专用架构)架构应运而生,针对 AI 推理应用,实际算力利用率可超过 90%,并且其芯片提供最基本的深度学习算子,保证芯片在深度学习应用的通用性和扩展性,从而实现数据中心降本增效。2019 年英特尔 20 亿美元收购了以色列初创公司Habana Lab,证明了 DSA 架构在商业和技术上的成功。国内希姆计算、瀚博、燧原等初创公司都采用 DSA 架构技术路线,并开始商业落地。

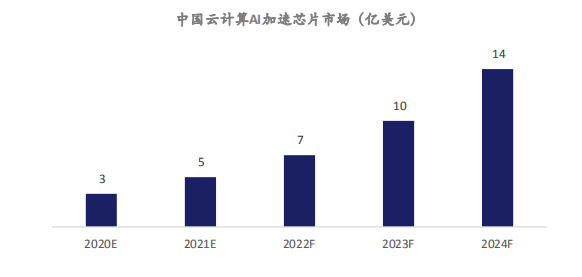

根据中金证券测算,2021 年中国云计算应用 AI 加速芯片市场规模约 5 亿美元,预计 2024 年市场规模将达到 14 亿美元,三年年均复合增长率达到 47%。

互联网公司成为 AI 加速芯片主力。互联网公司直接面向终端提供服务,既拥有丰富的业务场景,又具备技术和资金实力,于是开始绕过英特尔、英伟达等传统芯片供应商下场自研芯片或者投资芯片初创公司,满足自身需求。比如谷歌 TPU,百度昆仑芯片,亚马逊,字节跳动等,都在结合自身应用场景自研 AI 加速芯片。

场景专用的云端 AI 推理加速芯片,依靠性价比取胜,加速取代 GPU 成为主要算力芯片。互联网公司推理应用场景主要是内容推荐和内容审核,内容和用户都已经完成向量化,对芯片实时性要求高,对芯片生态和通用性要求低。并且推理芯片的需求量和增速远高于训练芯片,根据 Facebook给出的预测,今后推理芯片和训练芯片的需求量是 9:1。专门针对 AI 云端推理计算的 DSA 架构 AI推理加速芯片,实际任务负载达到 90%以上,实现相同工艺节点 GPU 的 2 倍以上性价比。DSA 架构 AI 推理加速芯片正在加速取代 GPU 成为 AI 推理的主要算力芯片。

RISC-V 成为 AI 云端推理芯片最佳技术路线。RISC-V 是第五代开源精简指令集,允许用户自定义扩展指令集。MIPS 和 ARM 虽然也是精简指令集,但不允许用户去删减、扩展指令集,因此在特定场景应用下往往造成臃肿。而 RISC-V 扩散性好,对用户友好,且 RISC-V 是 CPU 指令集,构成了图灵完备,相比 DSP(Digital Signal Processor,数字信号处理器)指令集,芯片厂商自定义指令集,用户可以更方便地用 RISC-V 去描述任何新算子。

数据中心规模越来越大,任务越来越复杂,根据亚马逊统计仅处理网络通信就需消耗 CPU 30%的算力,亚马逊称之为“datacenter tax(数据中心税)”。DPU 是以数据为中心构造的专用处理器,支持数据中心底层存储、安全、服务质量管理等基础设施层服务。DPU 要解决的核心问题是基础设施的 “降本增效”,即将“CPU 处理效率低下、GPU 处理不了”的负载卸载到专用 DPU,提升整个计算系统的效率、降低整体系统的总体拥有成本(TCO)。

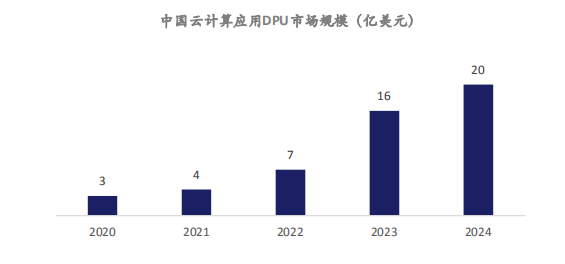

根据头豹研究院测算,2021 年中国云计算应用 DPU 市场规模约 4 亿美元,预计到 2024 年市场规模将达到 20 亿美元,三年年均复合增长率达 70%。

中国有机会出现 DPU 市场巨头。DPU 作为专门负责数据中心底层网络通信的算力芯片,是一个新兴赛道,国内外发展差距小。而且中国在云计算领域,市场规模、增速、特别是用户数量,相较国外都有巨大优势。在英伟达发布的 DPU 产品战略中将 DPU 定位为数据中心继 CPU 和 GPU 之后的 “第三颗主力芯片”,更掀起了一波行业热潮,2021 年 DPU 成为最热的投资赛道。

DPU 作为新兴赛道,最大的挑战是行业标准化。由于数据中心本身的复杂性,各大厂商一方面采用现成商业软件来构建系统,追求低成本,一方面又设法分层服务化(IaaS、PaaS、SaaS),打造面向不用类型客户的标准化产品。除此之外的所有技术实现几乎都是“八仙过海,各显神通”。

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

电子书<服务器基础知识全解(终极版)>更新完毕。

获取方式:点击“阅读原文”即可查看182页 PPT可编辑版本和PDF阅读版本详情。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。