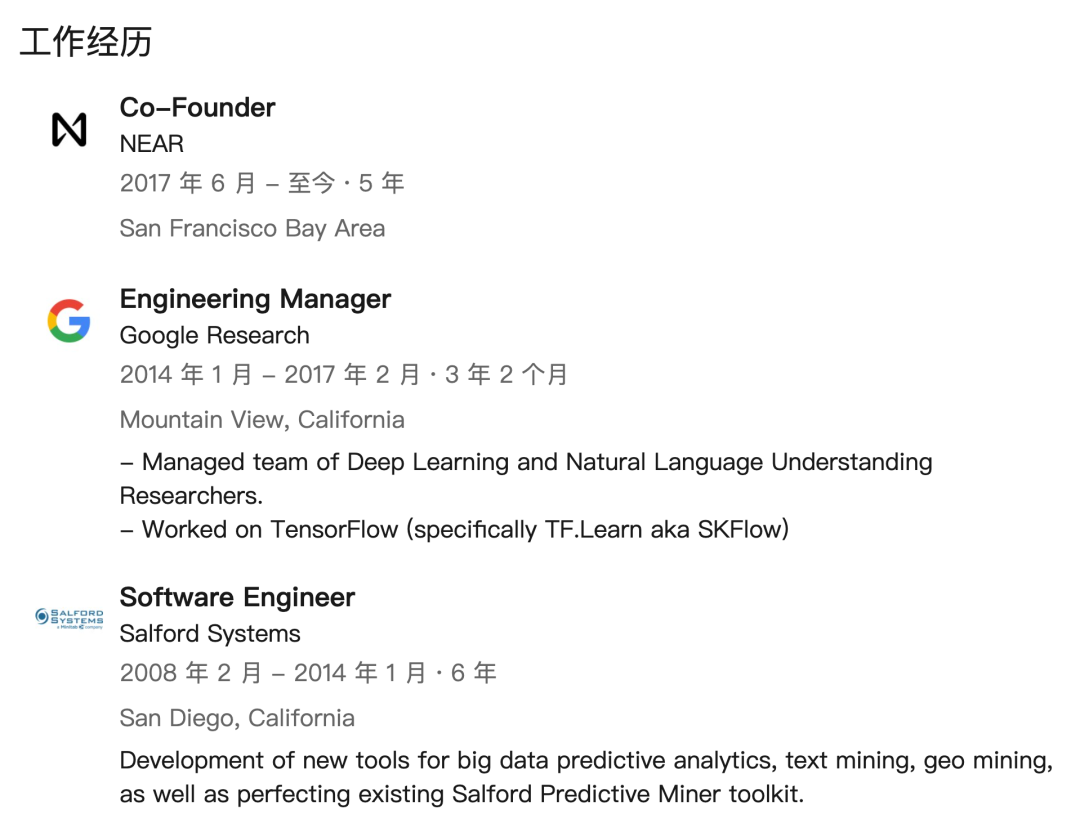

Transformer 五年引用超四万,六位作者创立五家创业公司,仅一位作者还留在谷歌

极市导读

时隔五年,Transformer 的八位作者仅有一位还留在谷歌。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

Jakob 提出用自注意力替代 RNN,并开始努力尝试这一想法;

Ashish 和 Illia 一起设计并实现了第一批 Transformer 模型,并重度参与了 Transformer 架构的各方面工作;

Noam 提出了缩放点积注意力、多头注意力和无参数位置表示,并成为几乎每一个细节的参与者;

Niki 在原始代码库和 tensor2tensor 中设计、实现、调优和评估了无数的模型变量;

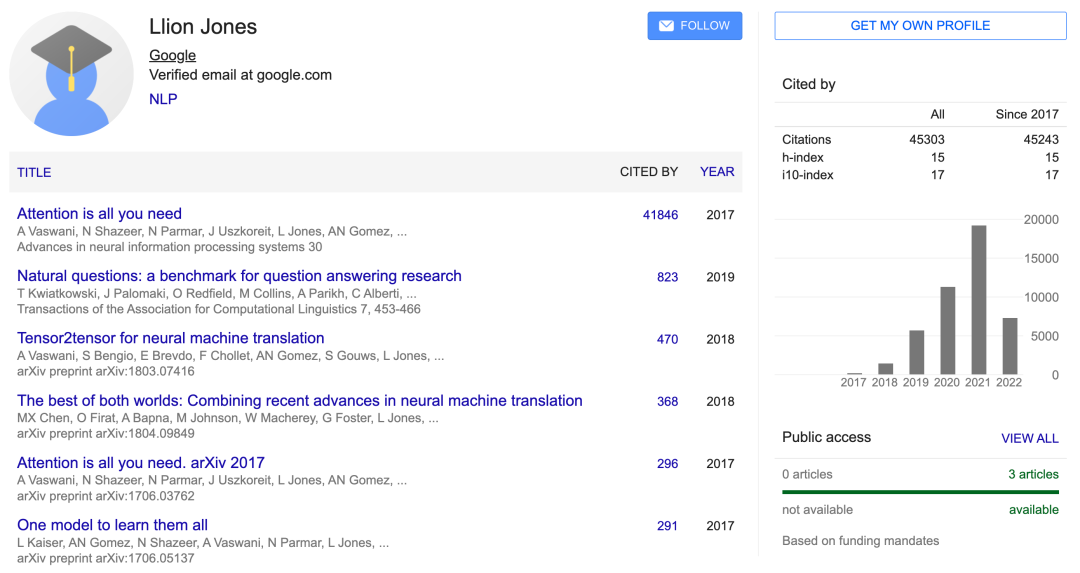

Llion 还尝试了新的模型变体,负责初始代码库以及高效的推理和可视化;

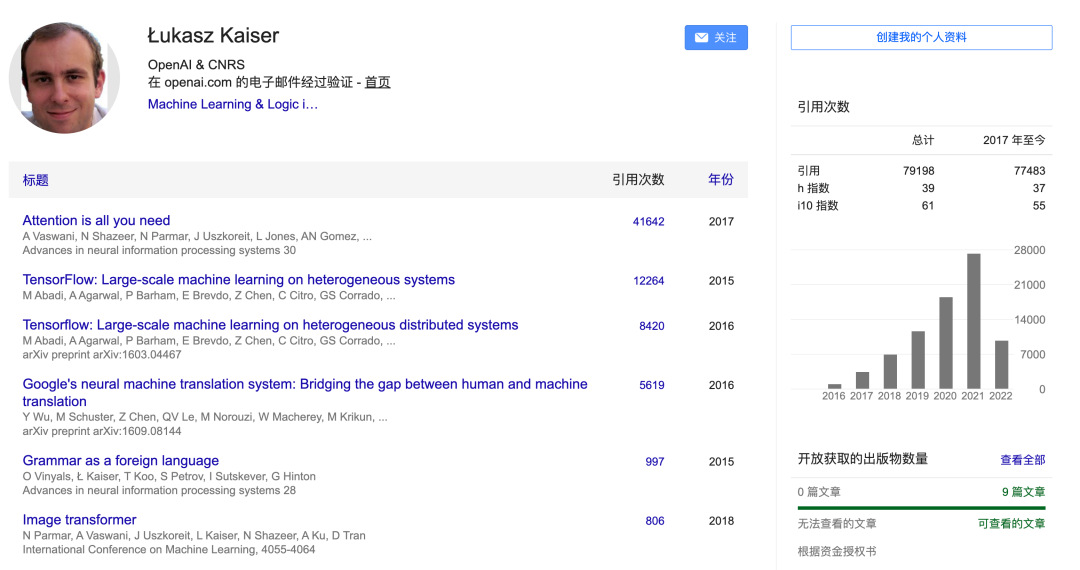

Lukasz 和 Aidan 花了无数天的时间来设计和实现 tensor2tensor 的各个部分,替换了早期的代码库,极大地改善了结果、加速了研究进度。

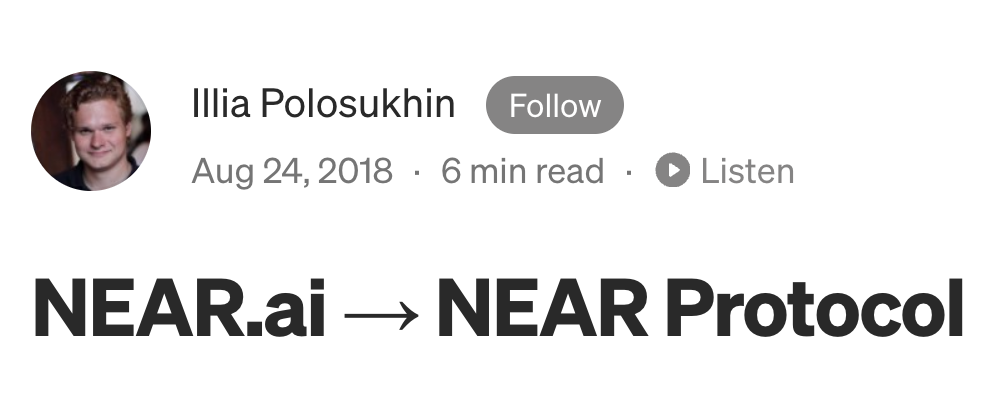

1、考虑到我们在程序合成方面所做的工作,顾问建议我们把研究方向改成为以太坊生成智能合约。目前,普通工程师很难编制可证明的合同,程序合成可以有效解决这个问题;

2、在与想要开发应用程序的人谈过之后,我们逐渐了解到,他们对于「使用区块链构建应用程序,以提供金钱激励和更好的隐私和安全」非常关注。

公众号后台回复“CVPR 2022”获取论文合集打包下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~