Transformer 五年引用超四万!六位作者创立五家创业公司,仅一位作者还留在谷歌

转自:机器之心

时隔五年,Transformer 的八位作者仅有一位还留在谷歌。

Jakob 提出用自注意力替代 RNN,并开始努力尝试这一想法;

Ashish 和 Illia 一起设计并实现了第一批 Transformer 模型,并重度参与了 Transformer 架构的各方面工作;

Noam 提出了缩放点积注意力、多头注意力和无参数位置表示,并成为几乎每一个细节的参与者;

Niki 在原始代码库和 tensor2tensor 中设计、实现、调优和评估了无数的模型变量;

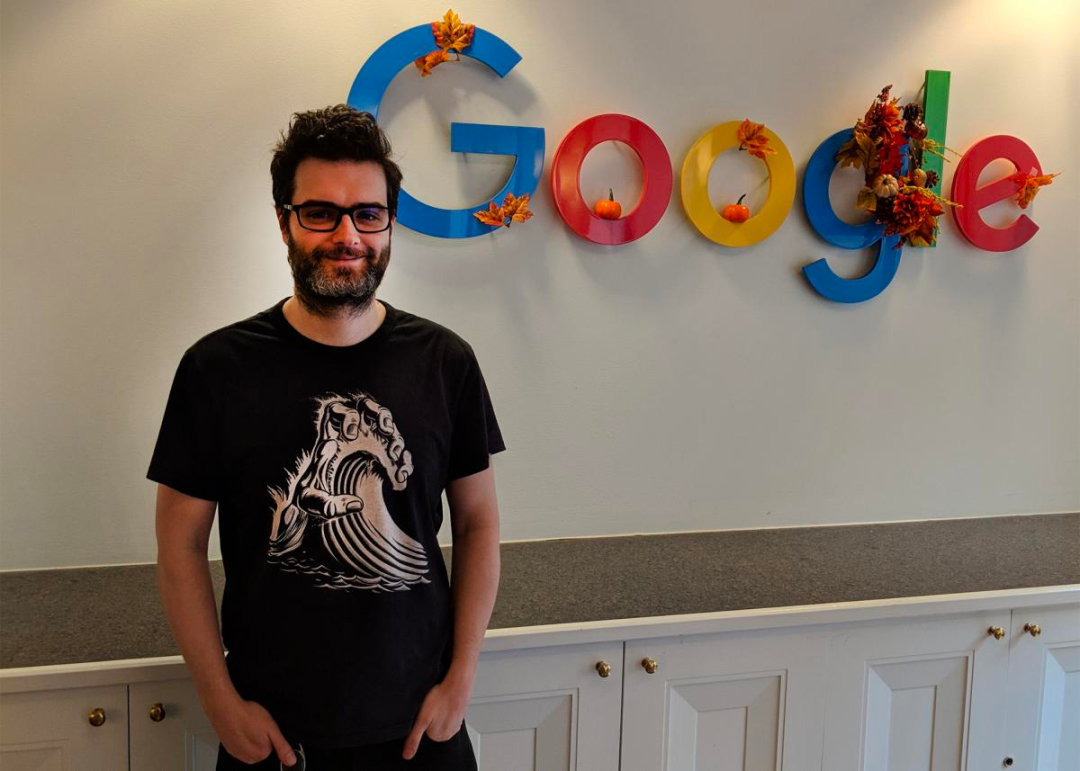

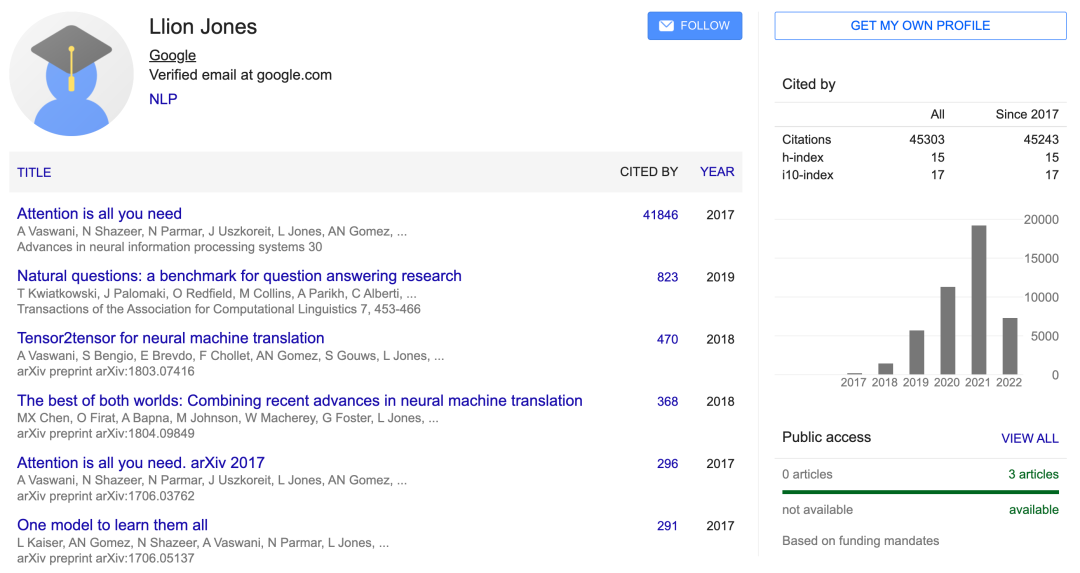

Llion 还尝试了新的模型变体,负责初始代码库以及高效的推理和可视化;

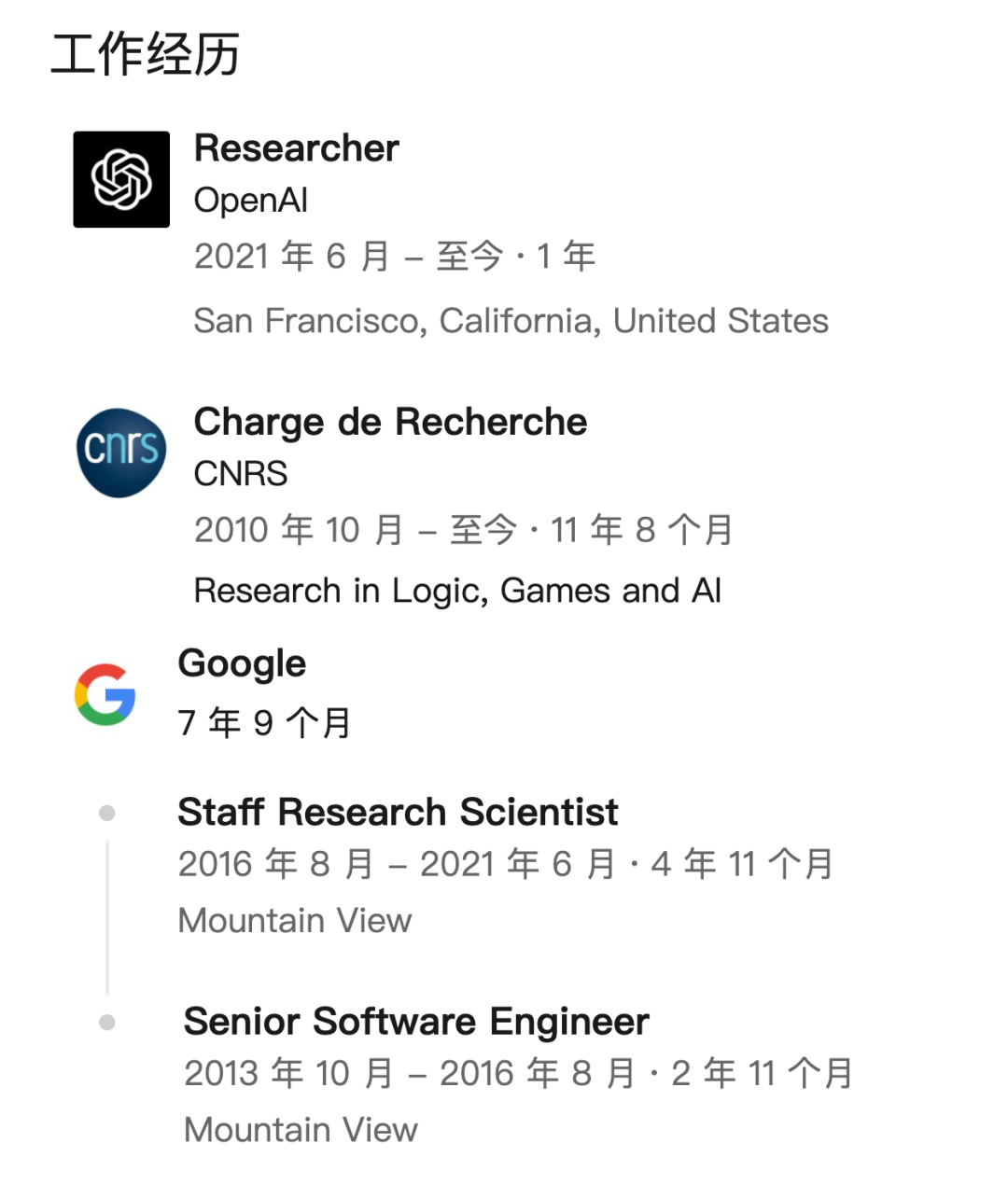

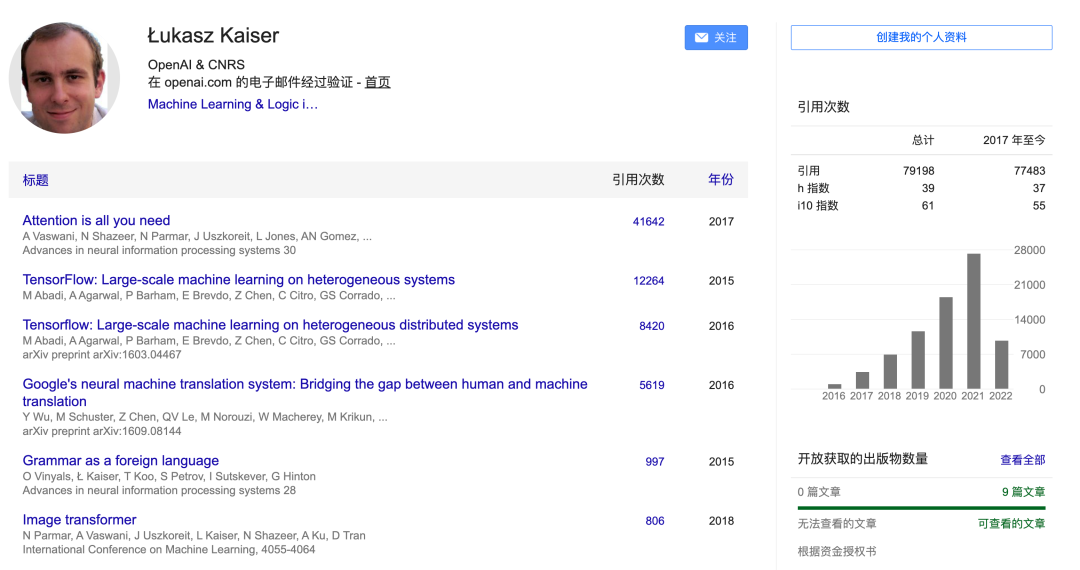

Lukasz 和 Aidan 花了无数天的时间来设计和实现 tensor2tensor 的各个部分,替换了早期的代码库,极大地改善了结果、加速了研究进度。

1、考虑到我们在程序合成方面所做的工作,顾问建议我们把研究方向改成为以太坊生成智能合约。目前,普通工程师很难编制可证明的合同,程序合成可以有效解决这个问题;

2、在与想要开发应用程序的人谈过之后,我们逐渐了解到,他们对于「使用区块链构建应用程序,以提供金钱激励和更好的隐私和安全」非常关注。

往期精彩:

评论