K8S, AI 大模型推理优化的新选择!

▼ 最近直播超级多, 预约 保你有收获

今晚直播: 《 大模型Agent应用落地实战 》

— 1 —

AI 大模型训练和推理

Docker 容器和 Kubernetes 已经成为越来越多 AI 应用首选的运行环境和平台。一方面,Kubernetes 帮助用户标准化异构资源和运行时环境、简化运维流程;另一方面,AI 这种重度依赖 GPU 的场景可以利用 K8S 的弹性优势节省资源成本。在 AIGC/大模型的这波浪潮下,以 Kubernetes 上运行 AI 应用将变成一种事实标准。

大模型训练和推理是企业重要应用,但企业往往面临着 GPU 管理复杂、资源利用率低,以及全生命周期管理中工程效率低下等挑战。通过创建 kubernetes 集群,使用 KServe + vLLM 部署推理服务。适用于以下场景:

- 大模型训练:基于 Kubernetes 集群微调开源大模型,可以屏蔽底层资源和环境的复杂度,快速配置训练数据、提交训练任务,并自动运行和保存训练结果。

- 大模型推理:基于 Kubernetes 集群部署推理服务,可以屏蔽底层资源和环境的复杂度,快速将微调后的大模型部署成推理服务,将大模型应用到实际业务场景中。

- GPU 共享推理: 支持 GPU 共享调度能力和显存隔离能力,可将多个推理服务部署在同一块 GPU 卡上,提高 GPU 的利用率的同时,也能保证推理服务的稳定运行。

— 2 —

vLLM 大模型推理加速器

即使在高端 GPU 上,提供 LLM 模型的速度也可能出奇 的慢,平均推理速度大约5秒,vLLM 是一种快速且易于使用的 LLM 推理引擎。它可以实现比 Huggingface Transformer 网络结构高 10 倍甚至至 20 倍的吞吐量。它支持连续批处理以提高吞吐量和 GPU 利用率, vLLM 支持分页注意力以解决内存瓶颈,在自回归解码过程中,所有注意力键值张量(KV 缓存)都保留在 GPU 内存中以生成下一个令牌。

- vLLM 是一个快速且易于使用的 LLM 推理和服务库。

- vLLM 支持了并行取样,如下所示:

- vLLM 支持了对多个输出进行采样,如下所示:

— 3 —

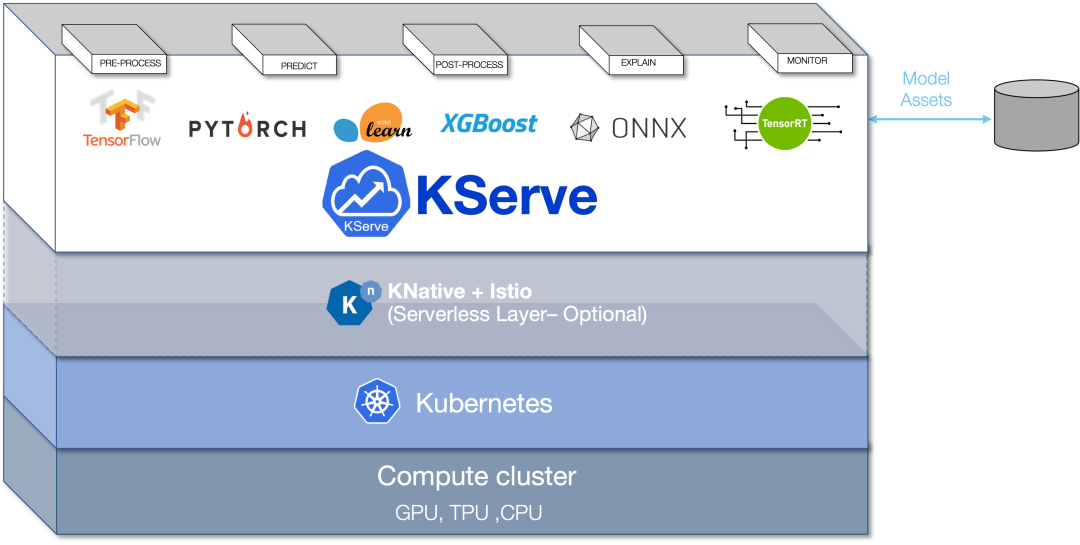

KServe 大模型推理平台

KServe 是一个与云无关的标准大模型推理平台,专为大模型应用高度可扩展而构建,KServe 封装了自动扩展、网络、健康检查和服务器配置的复杂性,为 大模型应用部署带来了 GPU 自动扩展、零扩缩放和金丝雀发布等先进的服务特性。它使得生产大模型应用服务变得简单、可插拔,它提供了以下特性:

- 跨机器学习框架,提供高性能标准化推理协议。

- 支持现代无服务器推理工作负载,具有基于请求在 CPU 和 GPU 的自动缩放(包括缩放至零)。

- 使用ModelMesh 支持 高可扩展性、密度封装和智能路由。

- 简单且可插入的生产服务: 用于推理、预/后处理、监控和可解释性。

- 高级部署: 金丝雀部署、Pipeline、InferenceGraph。

—4 —

领取《AI 大模型技术直播》

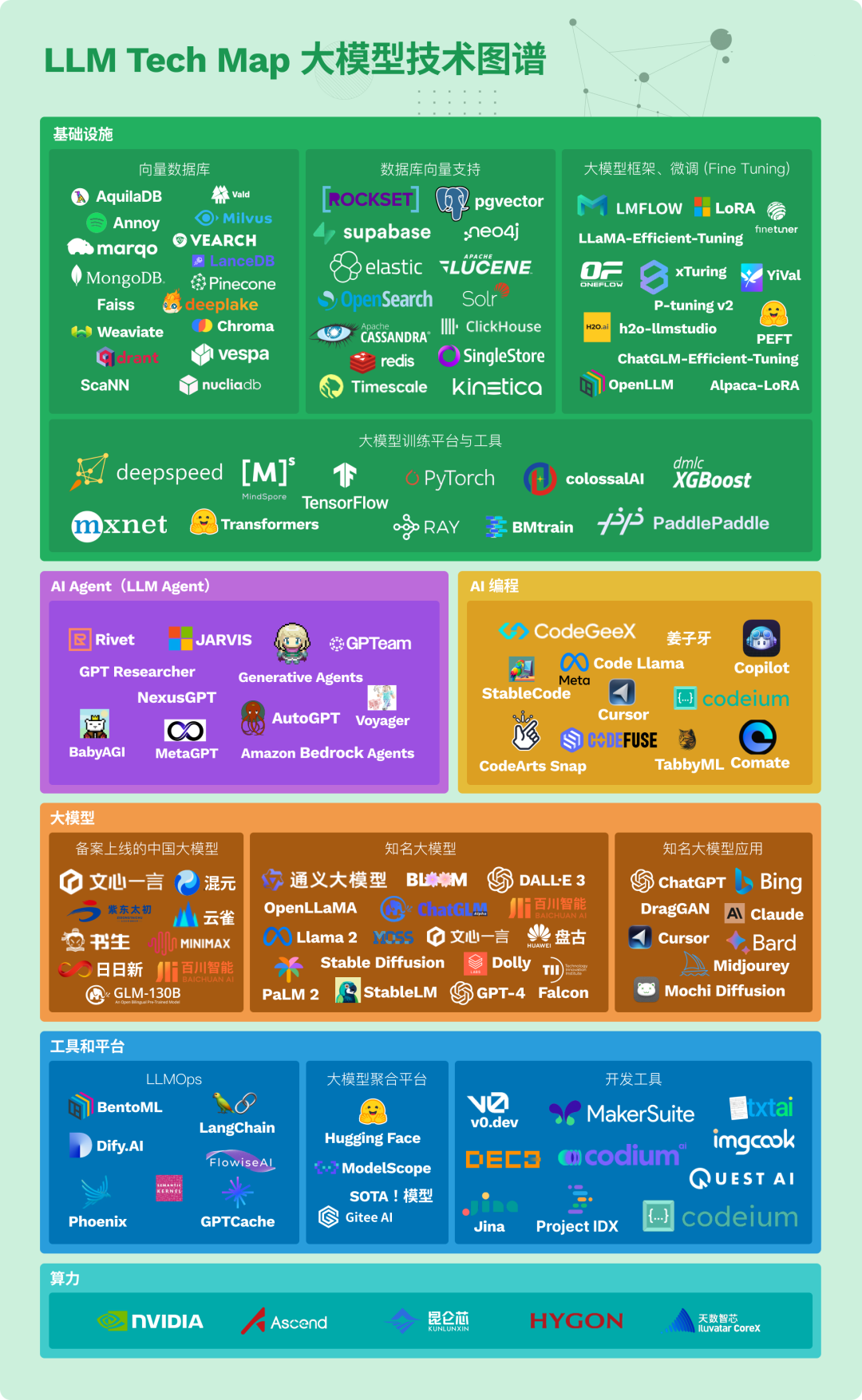

我们梳理了下 AI 大模型应用开发的知识图谱,包括12项核心技能: 大模型内核架构、大模型开发 API、开发框架、向量数据库、AI 编程、AI Agent、缓存、算力、RAG、大模型微调、大模型预训练、LLMOps 等。

END

评论