图灵奖得主Yann LeCun:我的论文也被NeurIPS拒了

共

2626字,需浏览

6分钟

·

2021-10-14 17:59

更多内容、请置顶或星标

机器之心报道

编辑:张倩、小舟

双盲评审之下,图灵奖得主的论文也会被拒。

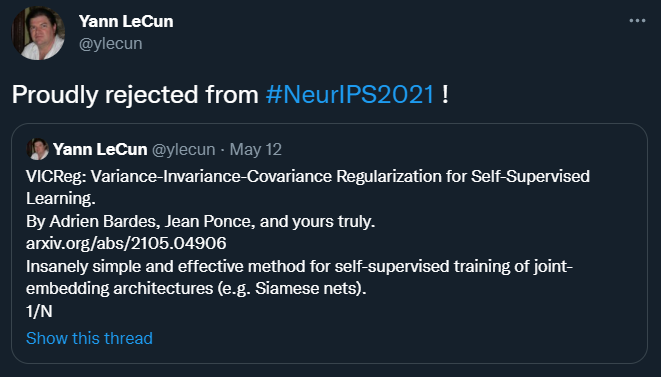

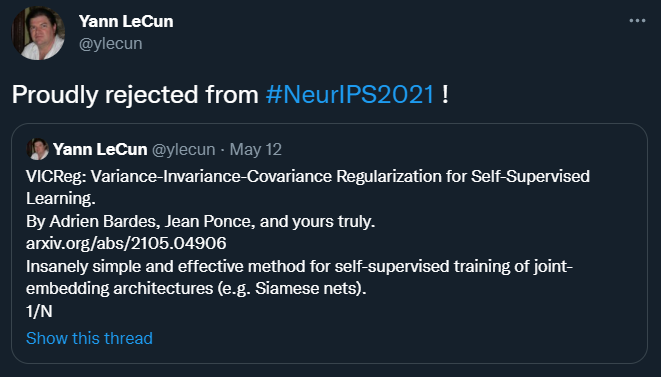

上周,全球人工智能顶会 NeurIPS 2021 放出了今年的论文接收结果。正所谓有人欢喜有人忧,但也有人处于「欢喜」和「忧愁」之外的另一种状态——被拒绝之后的「proud」。这位拥有独特心境的研究者便是大名鼎鼎的 Facebook 首席 AI 科学家、2018 年图灵奖得主 Yann LeCun。

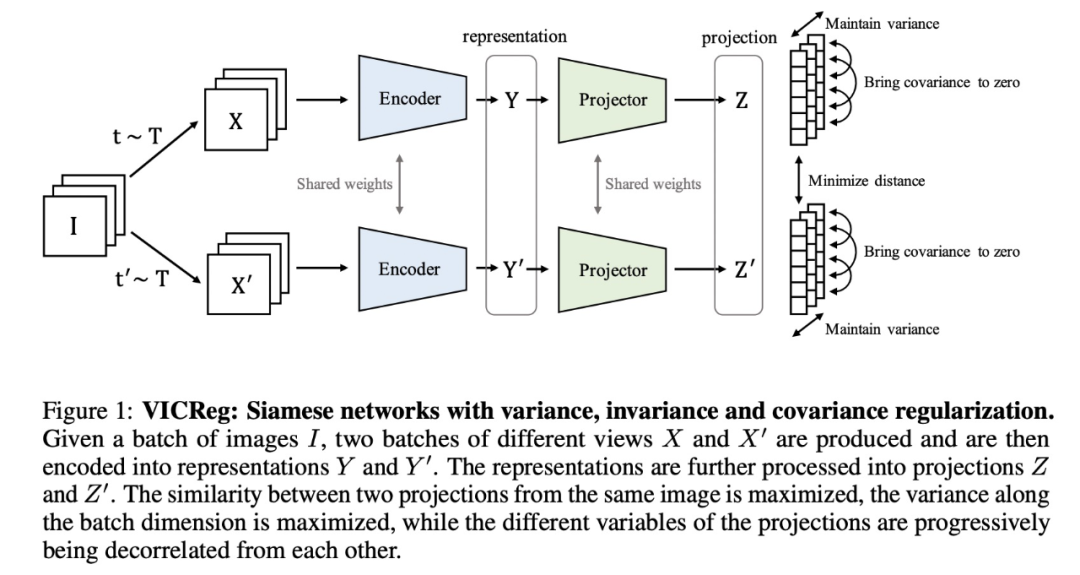

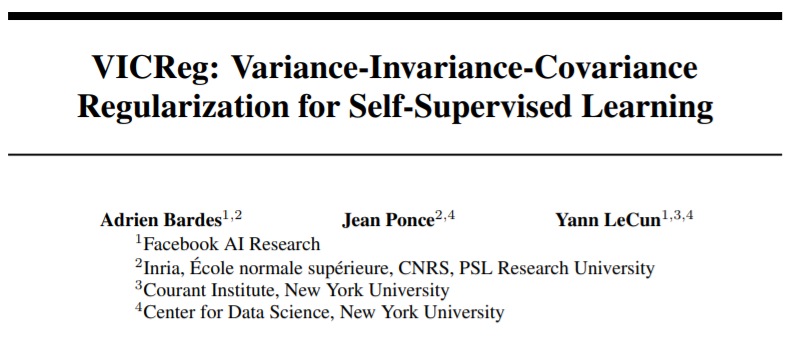

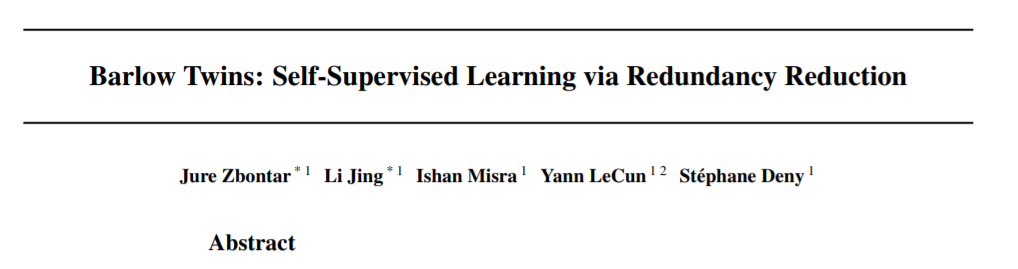

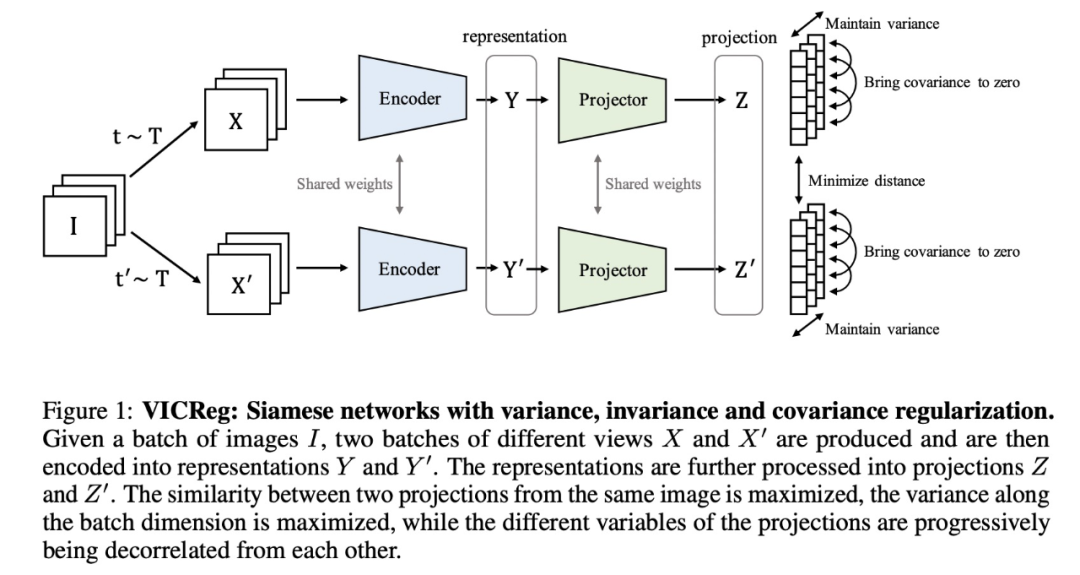

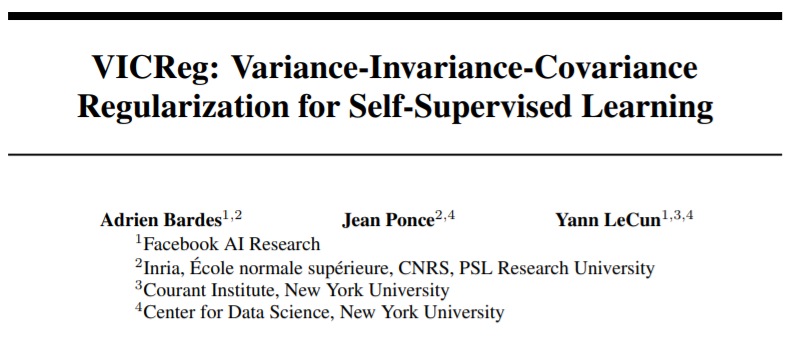

被拒绝的论文标题为《VICReg: Variance-Invariance-Covariance Regularization for Self-Supervised Learning 》。LeCun 表示,在这篇论文中,他们提出了一种极其简单、高效的方法,用于联合嵌入(joint-embedding)架构的自监督训练。

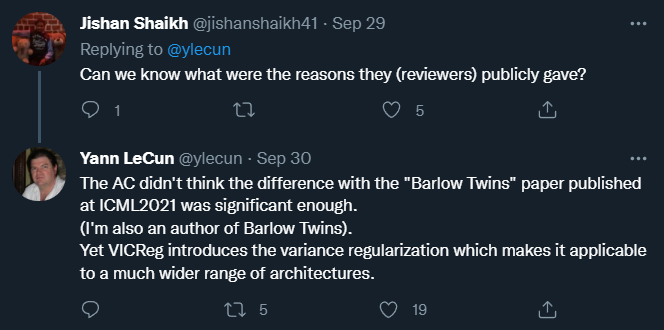

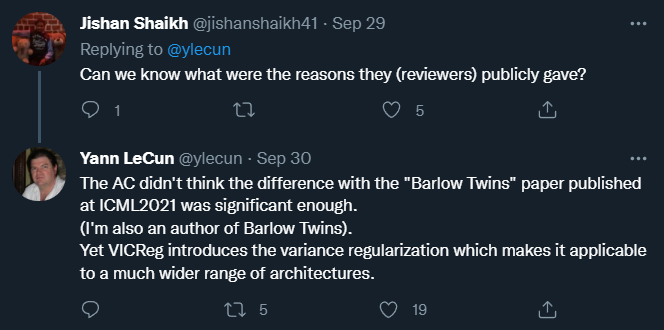

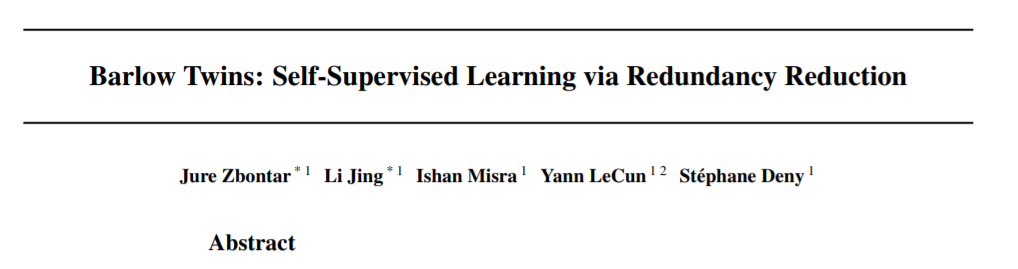

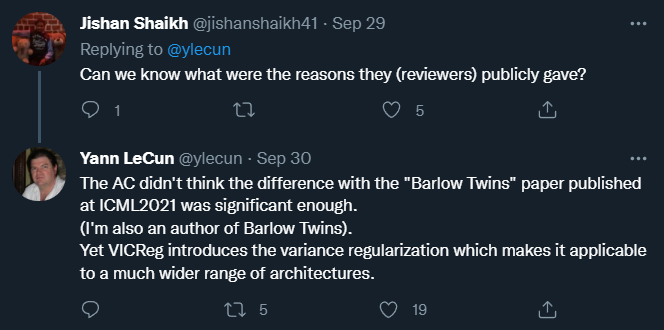

VICReg 论文链接:https://arxiv.org/pdf/2105.04906.pdf而领域主席给出的拒稿理由是:与 LeCun 等人之前发表于 ICML 2021 上的「Barlow Twins」论文相比,这篇「VICReg」提出的改进还不够大。

Barlow Twins 论文链接:https://arxiv.org/pdf/2103.03230.pdf但 LeCun 似乎并不这么认为,他表示,VICReg 引入了方差正则化,这使得它适用于更广泛的架构。

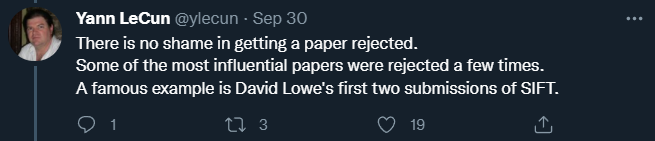

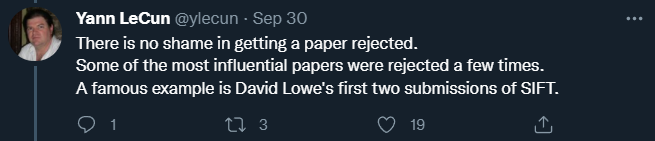

因此,在 LeCun 看来,他们的论文有足够的创新之处,被拒绝并不是什么丢人的事。「一些最具影响力的论文被拒绝过多次,比如 David Lowe 著名的 SIFT,」LeCun 在 twitter 上写道。

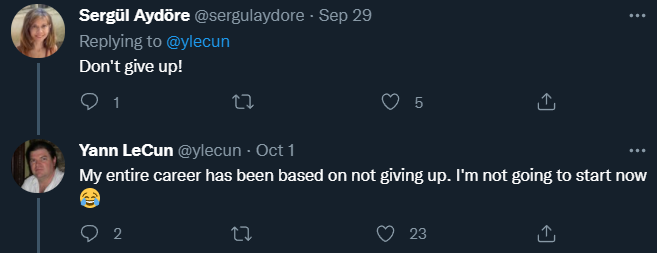

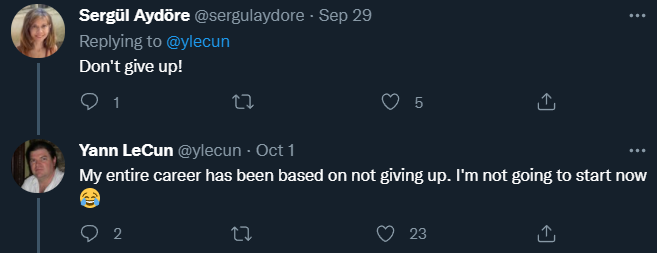

对于「不要放弃」之类的鼓励,LeCun 给出的回应是:「我的整个职业生涯都是基于『不放弃』的,现在也不会改变。」对于 LeCun 这种连「AI 寒冬」都经历过的人,个别研究不被肯定又算得了什么。

不过,对于普通研究者来说,LeCun 论文被拒让人看到了顶会审稿机制透明的一面:看来双盲评审还是有一定公平性的。

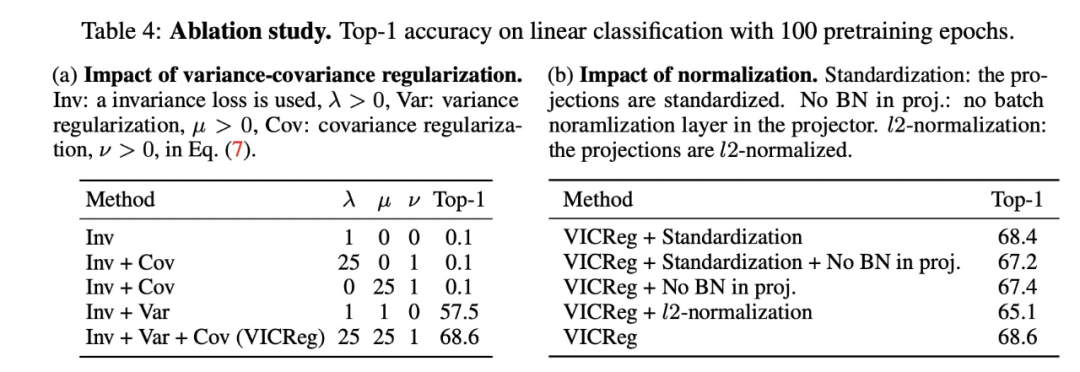

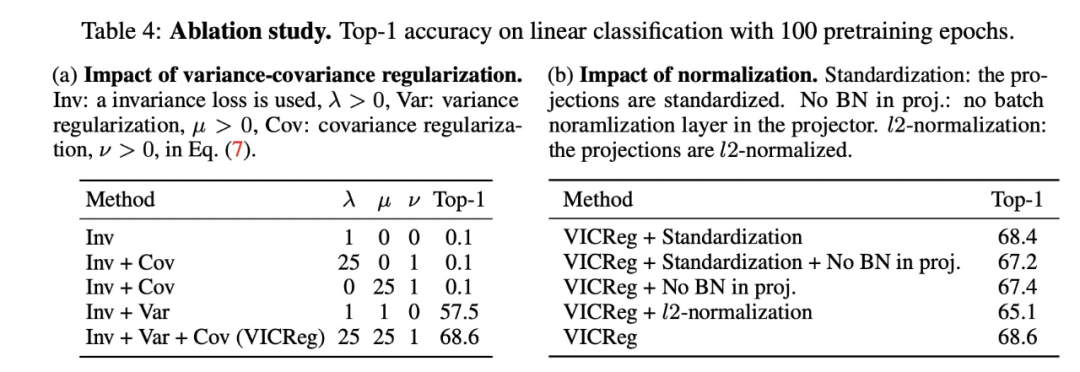

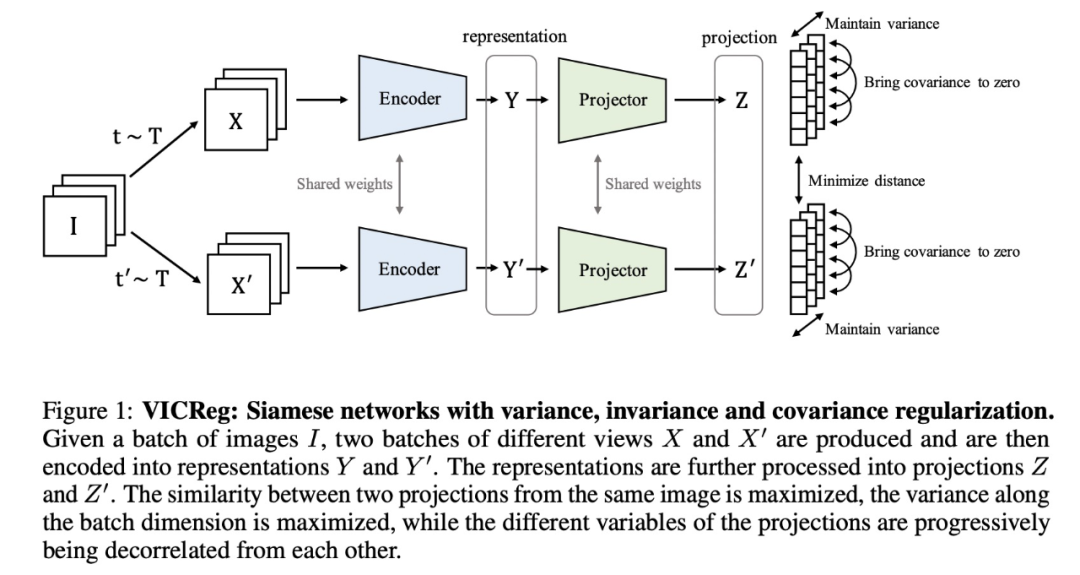

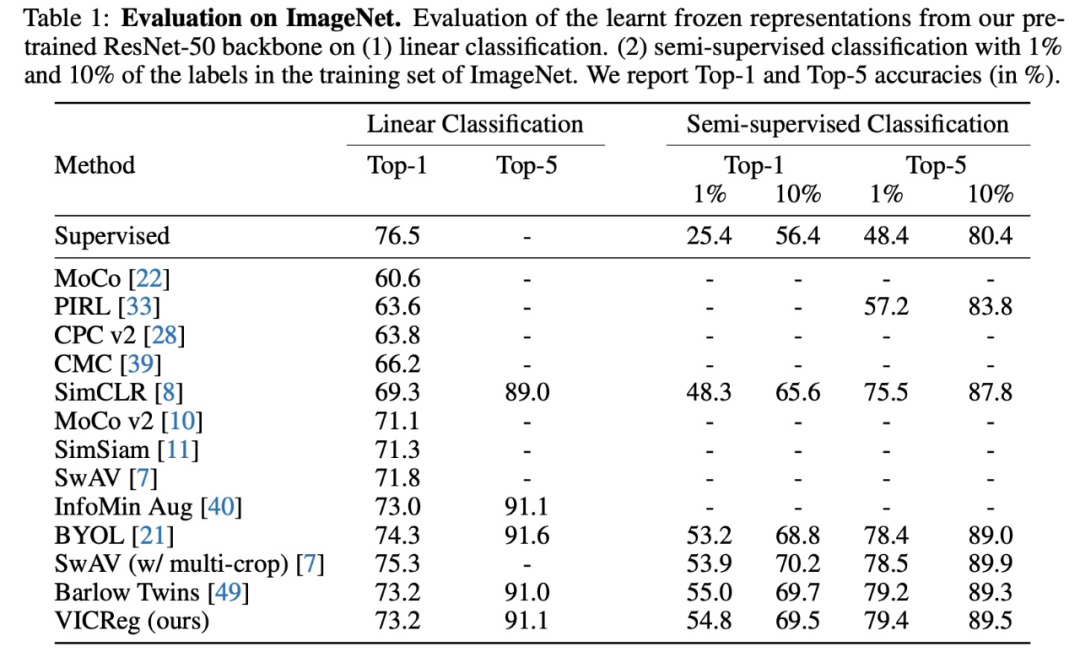

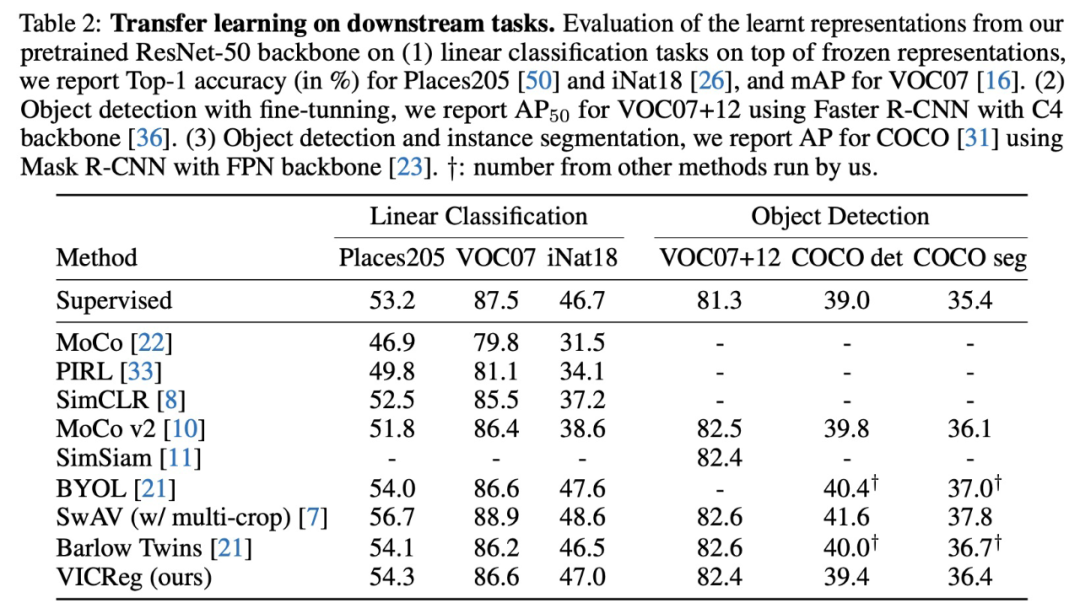

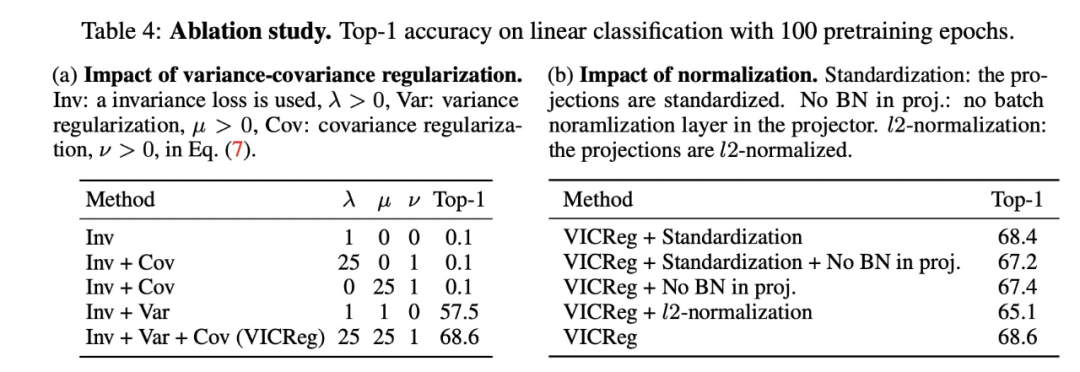

而且,审稿结果似乎并没有被网络上的宣传所左右:该论文今年 5 月份就出现在了 arXiv 上,而且 LeCun 发表推特进行了宣传。在 LeCun 看来,这是一种正常的学术信息交流,有利于技术进步。但不可忽略的一点是:在各种「交流」渠道中,不同地位的研究者所占有的资源是非常悬殊的,这难免造成一些不公平,让本身就很有学术号召力的研究者从中获益。不过,具体到「VICReg」这篇论文是否应该被接收,我们还是要看一下论文的具体内容。自监督表征学习在过去几年取得了重大进展,在许多下游任务上几乎达到了监督学习方法的性能。虽然可以显式地防止崩溃(collapse),但许多方法都存在成本高昂的问题,需要大量内存和较大的批大小。还有一些方法虽然有效,但是依赖于难以解释的架构技巧。已有一些研究提供了关于如何通过非对称方法避免崩溃的理论分析,但还远不完备,并且这些方法可能不适用于其他自监督学习场景。最后,冗余减少(redundancy reduction)的方法通过对表征的维度进行去相关(decorrelate)操作来避免崩溃,从而使表征能够最大限度地提供有关其相应输入的信息。这些方法的性能良好,能够学习有意义的表征,在去相关的同时保留表征的方差,但所有这些都使用一个唯一的目标函数。VICReg 的研究提出将目标分解为三个独立的目标函数,且每个目标函数都有明确的解释。在这篇论文中,研究者提出了一种新的自监督算法——VICReg(Variance-Invariance-Covariance Regularization,方差 - 不变性 - 协方差正则化),用于学习基于三个简单 principle(方差、不变性和协方差)的图像表征,这些 principle 有明确的目标和解释。

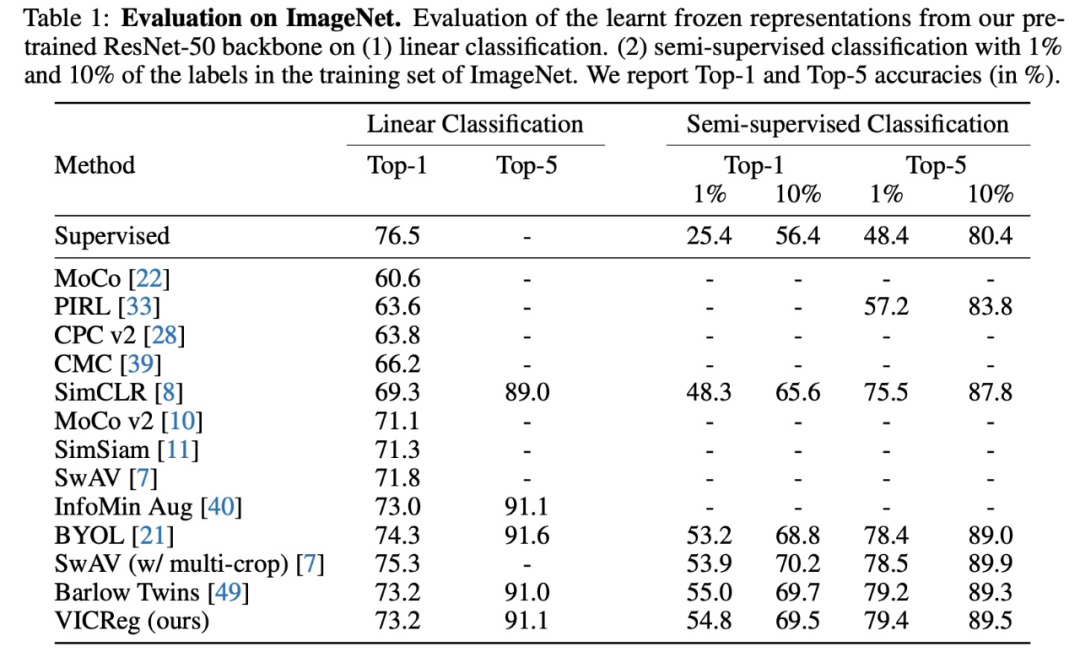

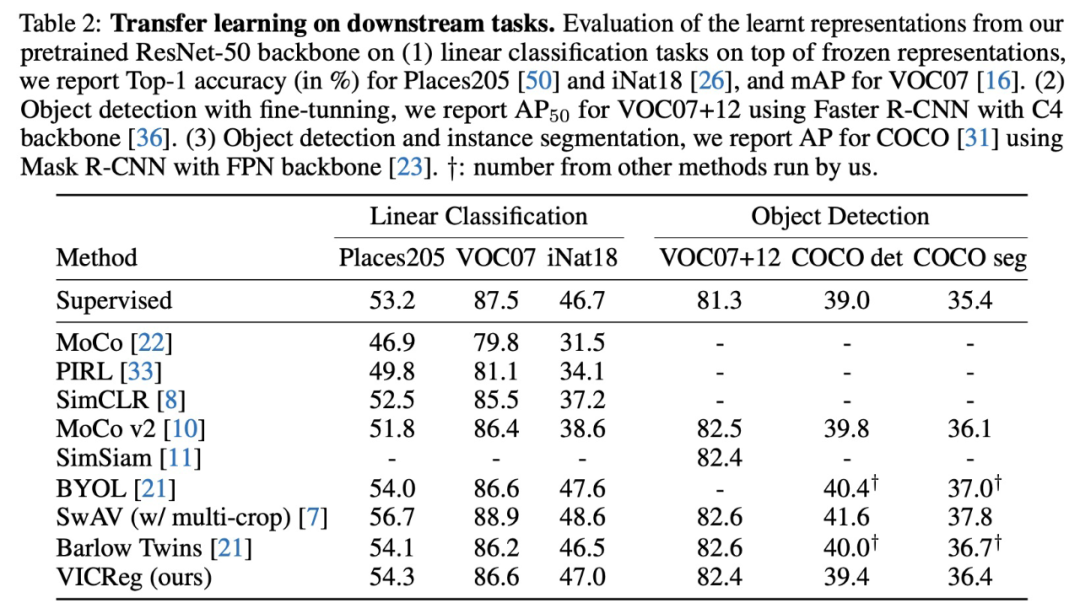

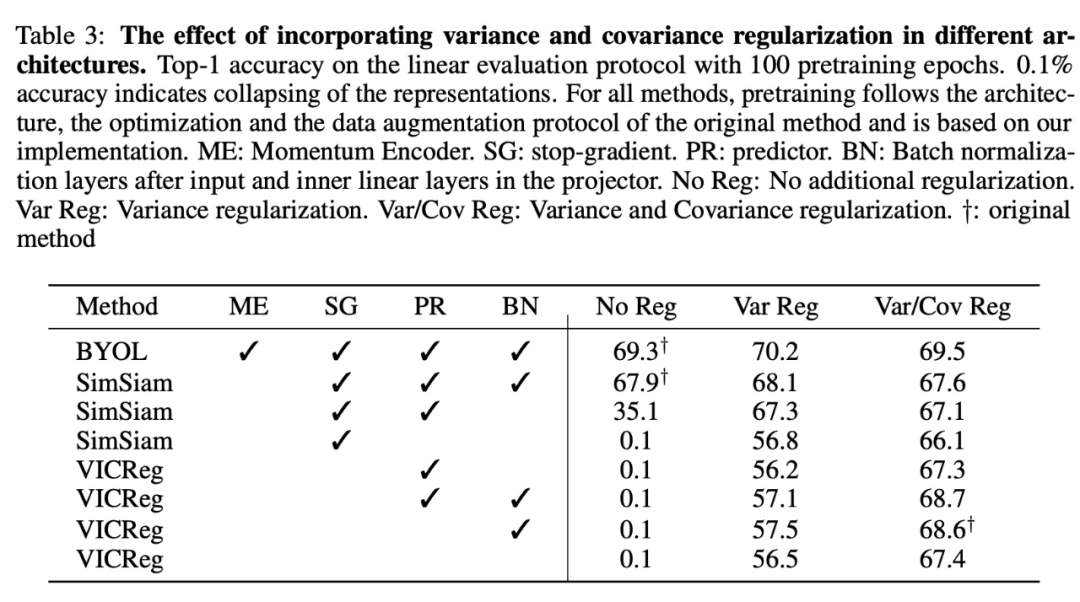

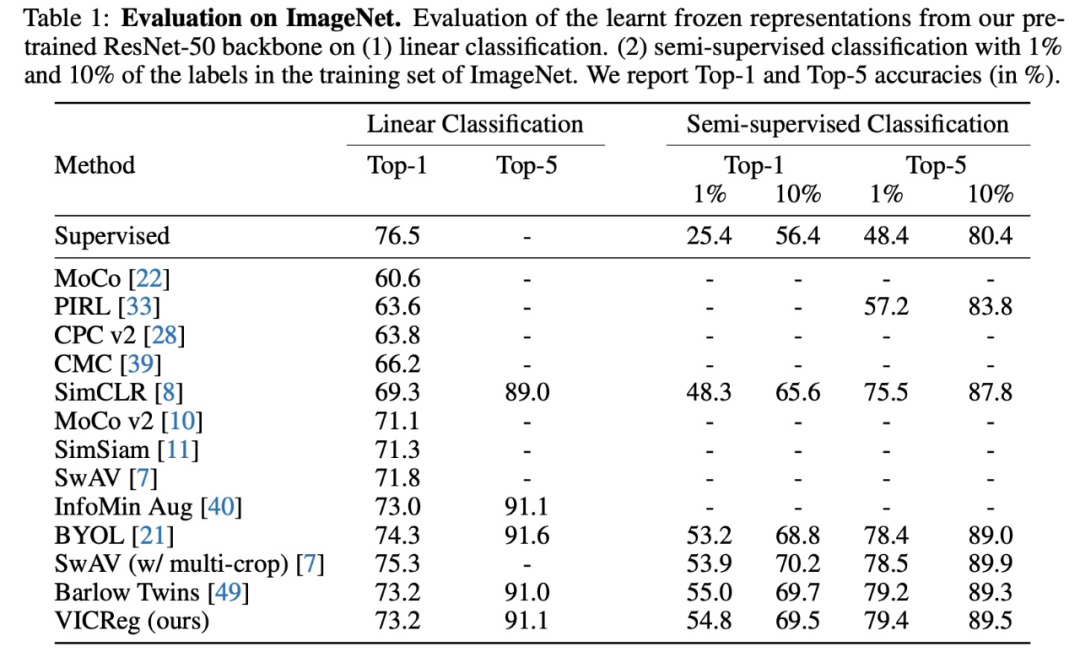

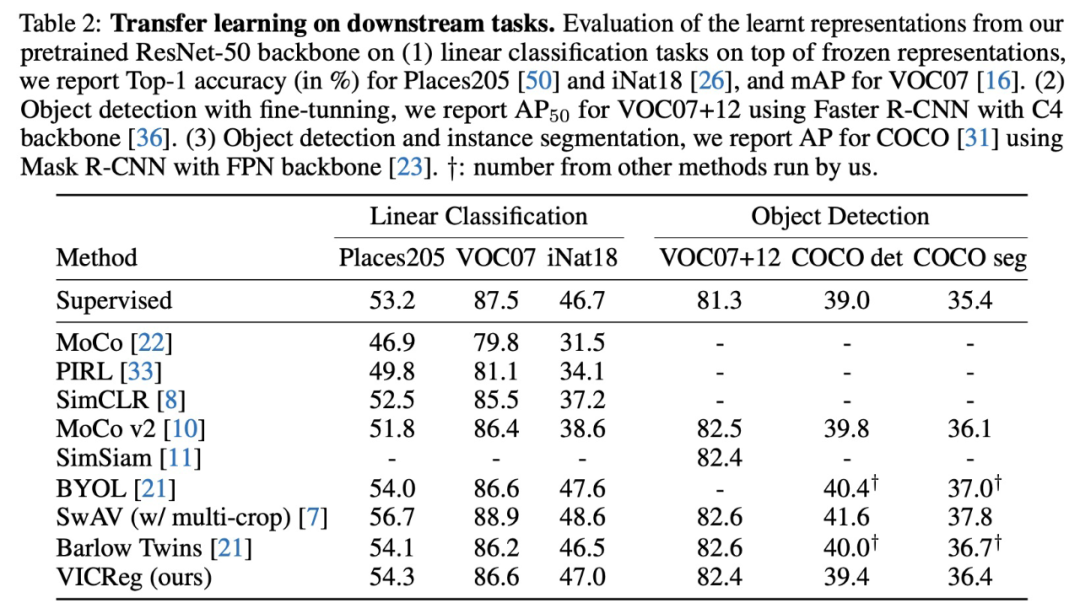

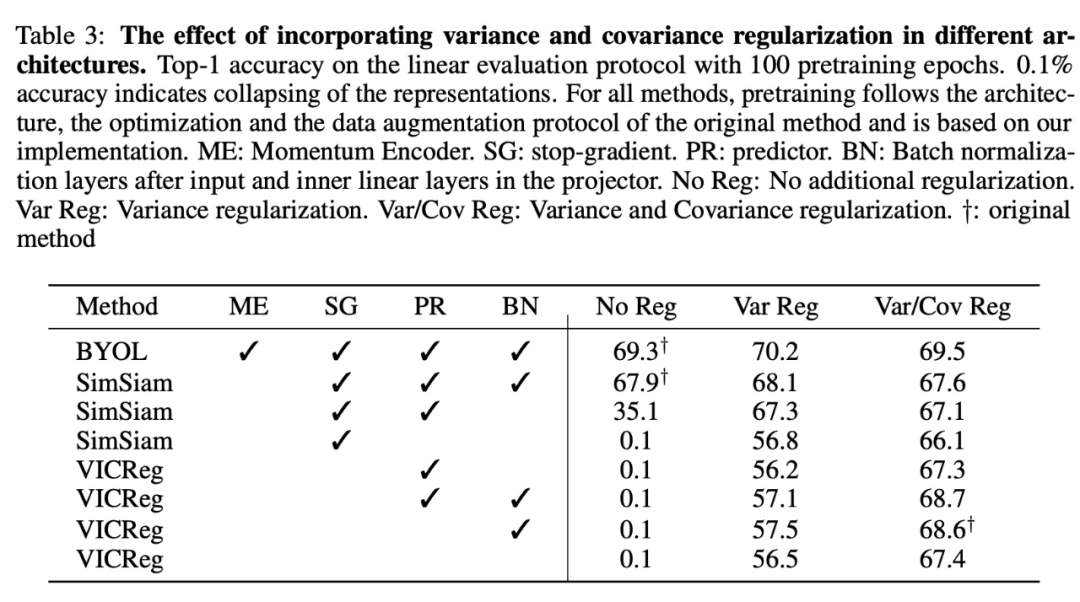

方差 principle 独立地约束每个维度上嵌入的方差,是一种简单而有效的防止崩溃的方法。更准确地说,研究者使用 hinge loss 来约束沿嵌入的批维度计算的标准差,以达到固定目标。与对比方法不同,这里不需要 negative pair,嵌入被隐式地鼓励不同于彼此,而且它们之间没有任何直接的比较。不变性 principle 使用标准的均方欧氏距离来学习对一张图像多个视图的不变性。最后,协方差 principle 借鉴了 Barlow Twins 的协方差 criterion,后者将学习表征的不同维度去相关,目标是在维度之间传播信息,避免维度崩溃。这个 criterion 主要是惩罚嵌入的协方差矩阵的非对角系数。在 SimCLR 中,negative pair 由批给出,这意味着该方法严重依赖于批大小。而 VICReg 则没有这种依赖性。与 Barlow Twin 类似,VICReg 也不需要 siamese 权重差异。此外,VICReg 架构是对称的,并且无需 SimSiam 的停止梯度(stop-gradient)操作、BYOL 的动量编码器(momentum encoder)以及二者均用到的预测器。与之前用于表征学习的任何自监督方法都不同,VICReg 的损失函数中不需要对嵌入进行任何形式的归一化,这使得该方法相对简单。在很多下游任务中,研究者通过评估 VICReg 方法学到的表征来测试其有效性。这些任务包括:ImageNet 线性和半监督评估以及其他一些分类、检测和实例分割任务。他们进一步表明,在更复杂的架构和其他自监督表征学习方法中加入文中提出的方差正则化,可以更好地提高下游任务的训练稳定性和性能。可以说,VICReg 是自监督联合嵌入学习中防止崩塌的一种简单、有效的可解释方法。

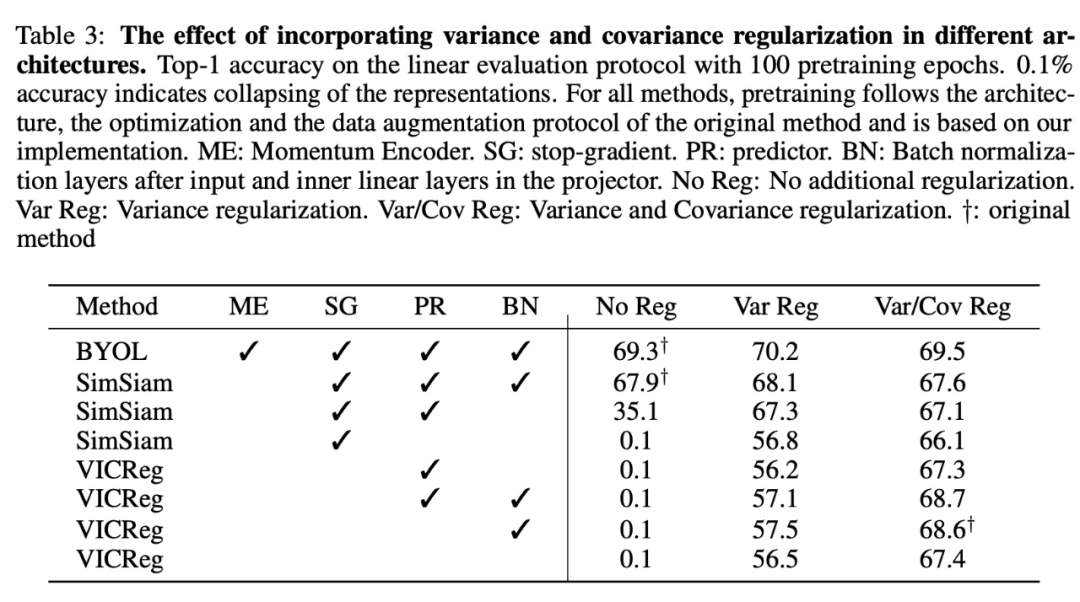

图 3:在不同架构中加入方差和协方差正则化的效果。

— END —

想要了解更多资讯

点这里👇关注我,记得标星呀~

请点击上方卡片,专注计算机人工智能方向的研究

点赞

评论

收藏

分享

手机扫一扫分享

举报

点赞

评论

收藏

分享

手机扫一扫分享

举报