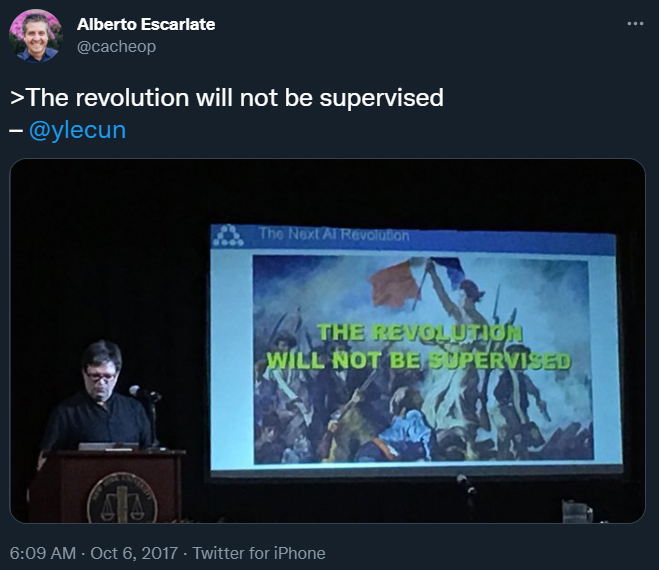

图灵奖得主LeCun:不需要监督的AI才是未来!

AI 的前进方向是通过更好的数据标签来改善监督学习,还是大力发展自监督 / 无监督学习?在 IEEE Spectrum 的最近的一次访谈中,图灵奖得主、Meta 首席 AI 科学家 Yann LeCun 表达了自己的看法。

第一,我们应该使用什么样的学习范式来训练世界模型?

第二,世界模型应该使用什么样的架构?

整理不易,点赞三连↓

评论

AI 的前进方向是通过更好的数据标签来改善监督学习,还是大力发展自监督 / 无监督学习?在 IEEE Spectrum 的最近的一次访谈中,图灵奖得主、Meta 首席 AI 科学家 Yann LeCun 表达了自己的看法。

第一,我们应该使用什么样的学习范式来训练世界模型?

第二,世界模型应该使用什么样的架构?

整理不易,点赞三连↓