入门nlp必读的10篇baseline论文

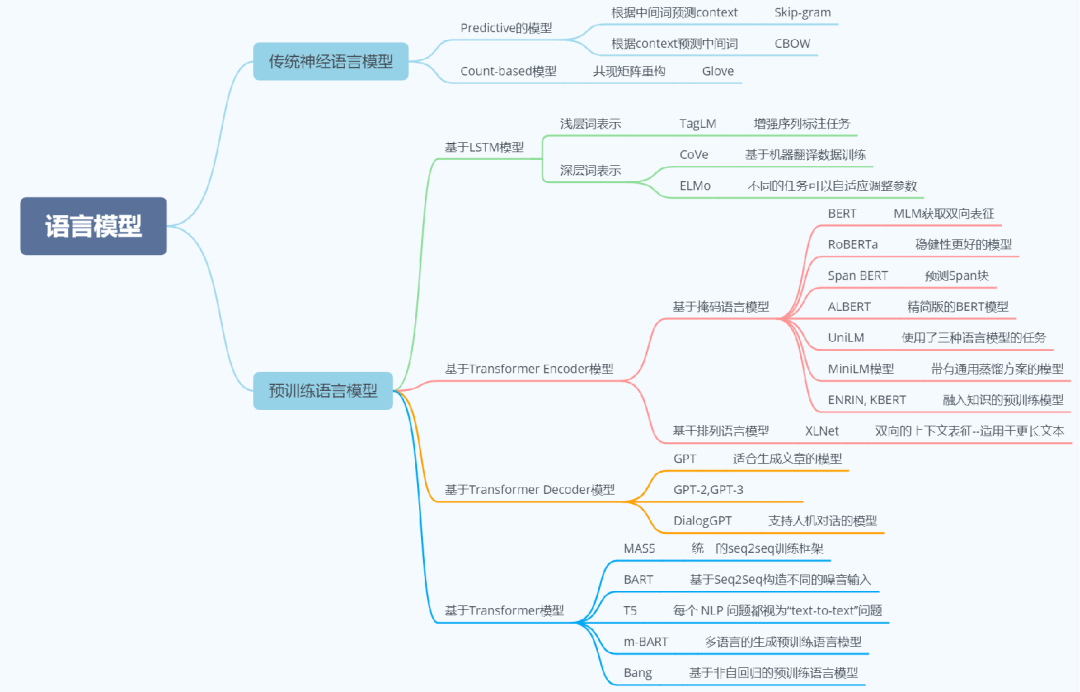

我把NLP文本分类任务的10篇经典论文称为“baseline 论文”——基石论文。吃透baseline论文,是学习NLP其他细分任务论文的基础。这10篇论文的篇目如下:

ICLR2013,Word2Vec 词向量扛鼎之作

《Efficient Estimation of Word Representation in Vector Space》

EMNLP2014,Glove:最出名的词向量训练方法之一

《GloVe: Global Vectors for Word Representation》

EMNLP2015,Char Embedding 第一篇介绍字符嵌入的论文

《Compositional character models for open vocabulary word representation》

EMNLP2014,TextCNN 第一篇CNN用于文本分类的文章

《Convolutional Neural Network for Sentence Classification》

NIPS2015,CharTextCNN 第一篇字符级别文本分类模型

《Character-level Convolutional Networks for Text Classification》

EACL2017,FastText 细粒度的文本分类

《Bag of Tricks for Efficient Text Classification》

LSTM_NMT 使用LSTM解决机器翻译问题

《Sequence to Sequence Learning with Neural Networks》

ICLR2015,Bahdanau_NMT 第一篇介绍attention的论文

《Neural Machine Translation by Jointly Learning to Align and Translate》

NAACL2016,Han_Attention attention用于文本分类

《Hierarchical Attention Networks for Document》

Coling2018,SGM 第一篇使用序列生成做多标签文本分类

《SGM: Sequence Generation Model for Multi-label Classification》

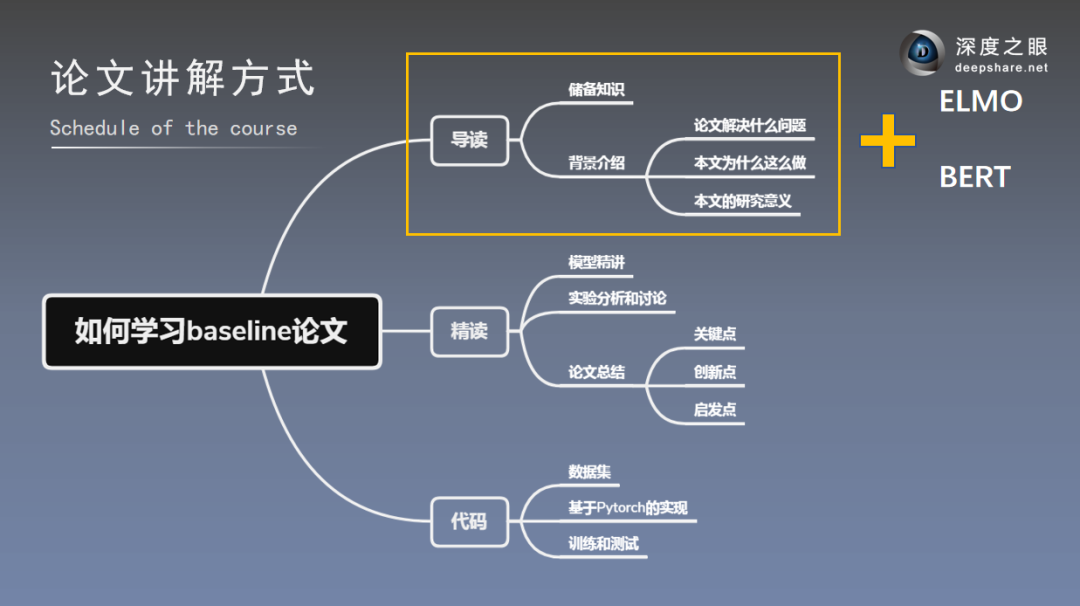

再有,这些论文要怎么学习才能又好又快地吃透呢?

无非三个步骤:泛读、精读、代码复现。

我请到了中科院博士Albert,推出NLP Baseline Paper 精讲直播,为期2天,主讲Word2Vec以及ELMO,BERT。

—— 主讲老师 ——

—— 直播内容与安排 ——

1、3月17日20:00直播

1.自然语言处理发展历程与前进方向

2.技术演化路径

3.Word2vec论文背景意义

4.ELMO背景意义

5.BERT背景意义

6.学习路径推荐

2、3月18日20:00直播

1.预训练语言模型概述

2.ELMO语言模型

3.BERT语言模型

4.学习路径推荐

原价298元,现在预约仅0.1元

3月17日20:00前预约

可享直播内容30天无限次回看

预约后记得添加客服进群→有老师答疑哦