【LLM系列】中文版FLAN Collection,最大开源中文指令数据集COIG-PC

共 2841字,需浏览 6分钟

·

2023-08-23 15:35

作者:黄文灏

项目地址:https://zhuanlan.zhihu.com/p/649230791

在之前的文章中表达过一个观点,开源社区很难参加大模型训练的过程中,因为训练资源是少数机构垄断的,那开源社区最值得做的事情就是参与到数据集建设中。不管是预训练数据还是指令数据,中文开源社区都没有特别好的数据资源,大多数预训练数据大家都还在用Wudao-Corpora,但Wudao的数据需要大幅更新并进行质量控制。指令领域更没有大规模数据集给大家使用。从今年五月开始,智源研究院、清北、HKUST、CMU、MIT、ETH、Cornell、开源组织MAP、stardust.ai、linksoul.ai等机构一起组织了COIG(Chinese Open Instruction Generalist)项目,目标就是构建大规模的开源指令数据集,为LLM(Large Language Model)提供高质量指令微调数据。最近,COIG二期指令数据集COIG-PC v1发布,PC(Prompt Collection) v1 数据集整合3.6亿条中文指令数据集,3000+个中文自然语言任务,45B+ tokens,是目前最大规模、可商用的开源中文多任务指令集!团队集合上百位工程师,来自全球各地40+个机构。

COIG-PC

COIG-PC采用类似FLAN Collection的Instruction数据收集流程:通过对来源于互联网的传统中文自然语言处理(NLP)数据集进行清洗、标注和改写,高质量地建模中文自然语言指令。其中,工程师人工筛选3000+个开源域NLP数据集,改写近千个源数据集的3367个中文NLP任务,3.6亿条examples,总token数45B+!Task数量和example数量超过原版FLAN Collection(原版为1836 tasks & 15M examples)。

COIG-PC v1不仅是指令微调,也是多任务学习进一步规模化的珍贵资料。可以帮助中文LLM进行微调和优化;并为研究人员和开发人员提供丰富资源,以提高语言模型处理多领域中文文本的能力,包括但不限于文本生成、信息提取、情感分析、机器翻译等领域。根据之前的LinkSoul.ai进行Chinese LLaMA 2工作的经验,通过大规模的指令微调是可以给基座模型补充知识的。如果对LLaMA2扩充中文词表,就一可能仅用COIG-PC的数据对LLaMA 2进行指令微调就有可能同时完成继续训练和指令微调。

Chinese-Llama-2-7b https://github.com/LinkSoul-AI/Chinese-Llama-2-7b

目前,数据集已更新至huggingface,论文和相关的core subset即将放出,敬请期待!

COIG-PC 链接:

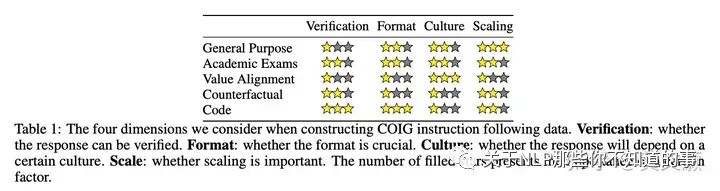

COIG 一期

第一期总共发布了 5 个子数据集,包括翻译指令、考试指令、人类价值观对齐指令、反事实修正多轮聊天、Leetcode指令,总计 191k 数据,聚焦中文语料、数据类型多样、经过了人工质检与修正、数据质量可靠,而且可以商用。

共包括五部分数据:

经过人工验证的翻译通用指令(67,798)

作者对三个数据集进行了翻译工作,包括具有1,616个任务描述和示例的Super-Natural Instructions数据集,175个种子任务的Self-Instruct数据集,以及66,007个指令的Unnatural Instructions数据集。整个翻译过程分为自动翻译、人工验证和人工修正三个阶段,以确保翻译结果的准确性和可靠性。

在自动翻译阶段,作者将指令和实例的输入输出组合在一起,然后使用 DeepL 进行翻译。

在人工验证阶段,作者为注释者定义了四个标签,根据指令是否可用和需要的修正程度进行分类。作者使用两阶段质量验证方法进行人工验证,第一阶段由经验丰富的质量检查员进行验证,只有正确率超过95%的案例才能进入第二阶段。在第二阶段,专家质量检查员从总语料库中随机抽取200个案例进行验证。

在人工修正阶段,注释者需要将翻译后的指令和实例纠正为正确的中文三元组{指令,输入,输出},而不仅仅是保持翻译的准确性。这是因为在 unnatural instructions 中存在事实错误,这可能会导致LLMs出现 hallucination. 作者同样使用两阶段质量验证方法进行人工修正,第一阶段的正确率为97.24%。

人工注释的考试指令(63,532)

中国的高考、中考和公务员考试题目中包含各种问题类型和详细的分析,这些考试可以用来构建思维链(CoT)语料库用于增强模型推理能力。作者从这些考试中提取了六个信息元素,包括指令、问题背景、问题、答案、答案分析和粗粒度学科。这些语料库中的六个主要学科是语文、英语、政治、生物、历史和地质。数学、物理和化学问题很少在语料库中出现,因为这些问题通常包含难以注释的复杂数学符号。

人类价值观对齐指令(34,471)

为了尊重和反映不同文化背景所带来的主要差异,COIG数据集中的价值观对齐数据被分为两个独立的系列:

一组展示中文世界共享人类价值观的样本。作者选择了50个指令作为扩充种子,并使用中文世界通用的价值观对齐样本,生成了3,000个结果指令。另外一些展示特定区域文化或国家特定人类价值观的样本集。

反事实修正多轮聊天(13,653)

反事实修正多轮聊天数据集(CCMC)是基于CN-DBpedia知识图谱数据集构建的,旨在解决当前LLM中出现的幻觉和事实不一致的问题。数据集包含约13,000个对话,每个对话平均有5轮,共约65,000轮聊天。这些对话是在学生和教师之间进行的角色扮演聊天,他们在对话中参考相关的知识。

Leetcode 指令(11,737)

考虑到与代码相关的任务可能有助于LLM能力的涌现,作者从CC-BY-SA-4.0许可下的2,589个编程问题中构建Leetcode指令。这些问题包含问题描述、多种编程语言和解释(其中 834个问题尚没有解释)。

希望感兴趣的同学一起加入COIG数据集共建工作,为中文LLM贡献自己的力量。