ICDE 2021 | 可微图神经网络架构搜索

点击上方“视学算法”,选择加"星标"或“置顶”

重磅干货,第一时间送达

该论文已经被国际顶级数据挖掘会议ICDE 2021接收,大会于2021.4.19-2021.4.22召开,论文作者团队将在北京时间2021.4.21 23:00在线上做口头报告,欢迎大家届时关注。如有任何问题,欢迎联系zhaohuan@4paradigm.com。

论文地址:https://arxiv.org/abs/2104.06608

代码地址:https://github.com/AutoML-4Paradigm/SANE

背景介绍

。

。

本次工作的方法

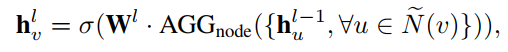

,可以计算交叉熵并更新这个模型。

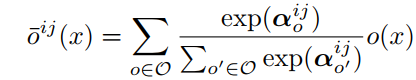

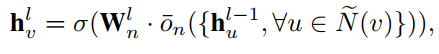

,可以计算交叉熵并更新这个模型。 和网络权重(network weights)

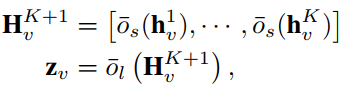

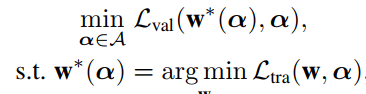

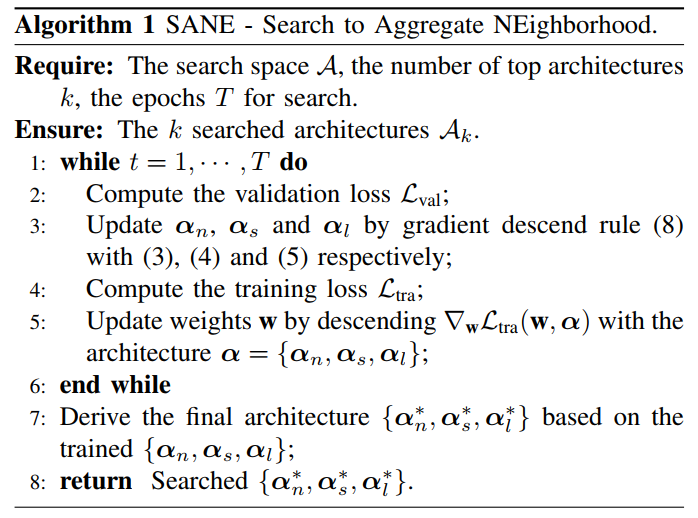

和网络权重(network weights) 。具体更新过程见算法1

。具体更新过程见算法1

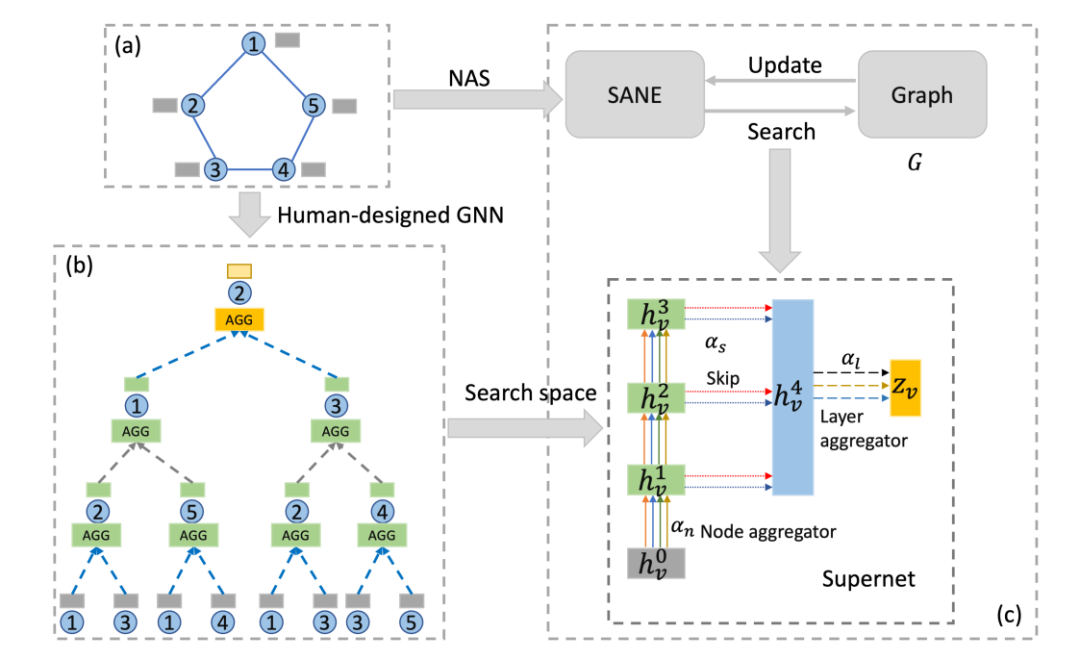

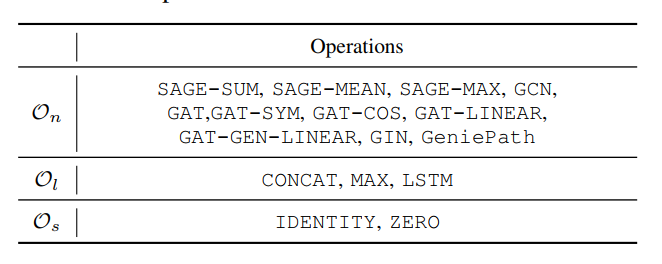

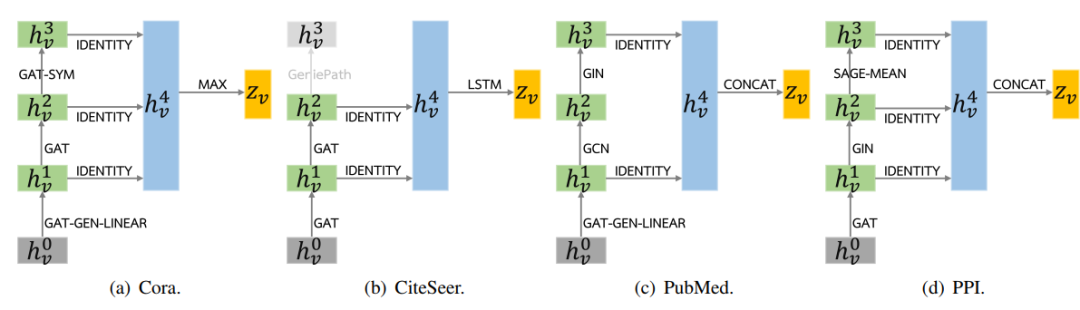

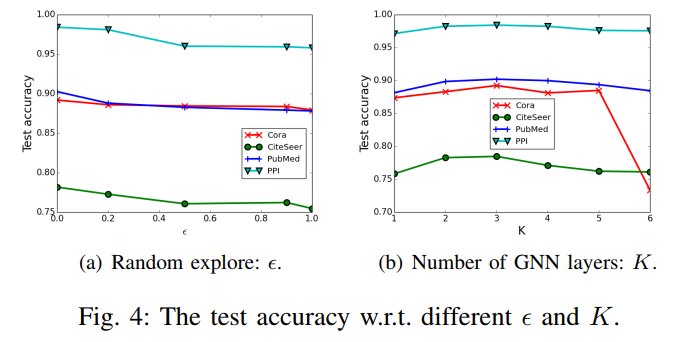

我们设计了基于NAS的SANE方法来设计GNN的结构,SANE提供的小而精的搜索空间可以覆盖现有的GNN的方案。 为了解决现有的搜索GNN结构中遇到的效率问题,我们使用了可微的搜索算法,搜索效率相比现有的基于强化学习的方法提高两个数量级。 我们在5个数据集上来验证了SANE的有效性和高效率,具体实验在下。

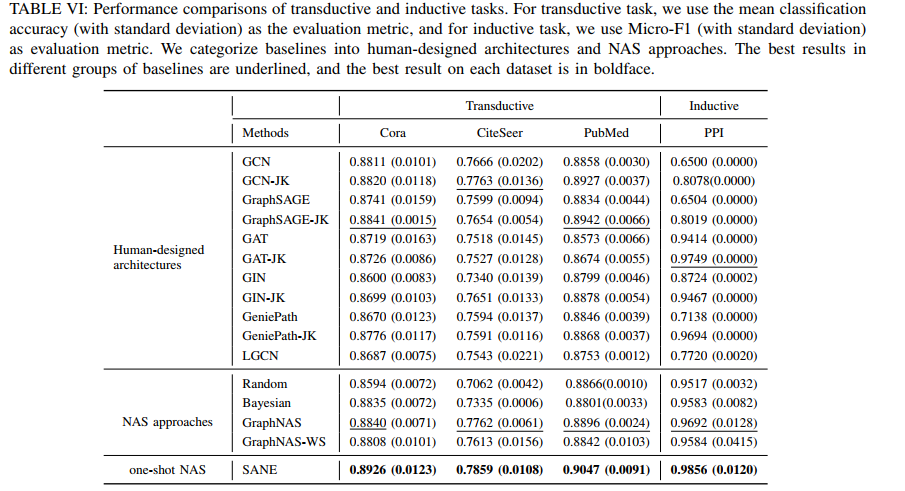

实验

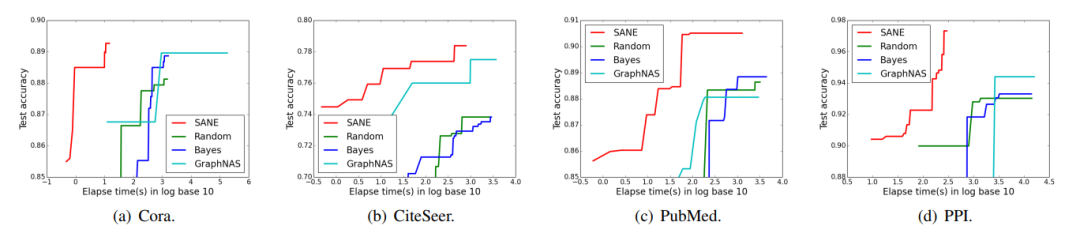

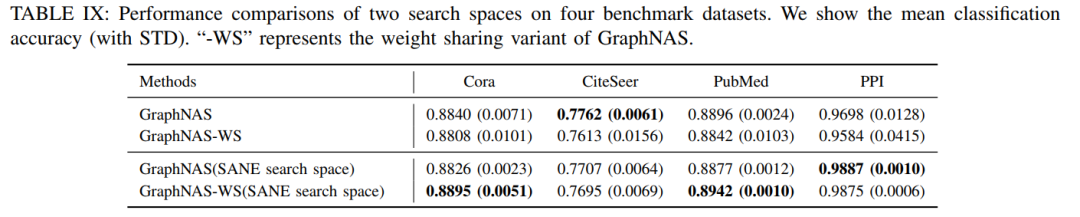

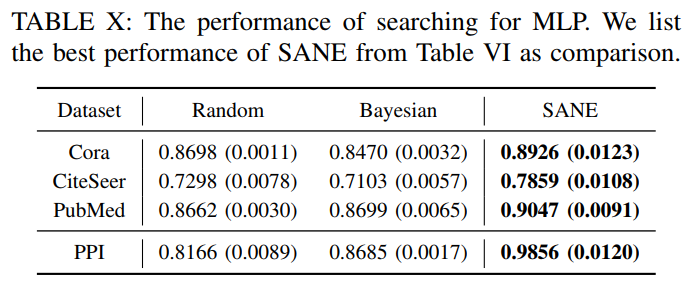

如图3所示,相比较于现有的基于强化学习的方案和传统的基于随机搜索和贝叶斯搜索的方案,SANE用到的可微的搜索算法可以更快的搜索到高表现力的GNN模型。

结语

未来工作

致谢

感谢公司的支持,同时也感谢实习生卫岚宁参与baseline的实现。

引用文献

[1] Semi-supervised classification with graph convolutional networks. ICLR 2016.

[2] Graph convolutional neural networks for web-scale recommender systems. KDD 2018.

[3] Fakedetector: Effective fake news detection with deep diffusive neural network. ICDE 2020.

[4] Design Space for Graph Neural Networks. NeurIPS 2020.

[5] Neural message passing for quantum chemistry. ICML 2017.

[6] Graph attention networks. ICLR 2018.

[7] How powerful are graph neural networks?. ICLR 2019.

[8] Representation learning on graphs with jumping knowledge networks. ICML 2018.

[9] Graph neural architecture search. IJCAI 2020.

[10] Auto-GNN: Neural architecture search of graph neural networks. arXiv 2019.

[11] Simplifying Architecture Search for Graph Neural Network. CIKM-CSSA 2020

本组其他相关工作

本文探索了NAS在GNN聚合函数中的应用,除此之外,本组还有以下新工作:

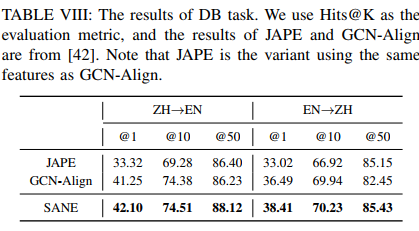

AutoSF: Searching scoring functions for knowledge graph embedding. ICDE 2020. (AutoSF)

Simplifying Architecture Search for Graph Neural Network. CIKM-CSSA 2020

Interstellar: Searching Recurrent Architecture for Knowledge Graph Embedding. NeurIPS 2020. (Interstellar)

Efficient Relation-aware Scoring Function Search for Knowledge Graph Embedding. ICDE 2021. (ERAS)

Role-Aware Modeling for N-ary Relational Knowledge Bases. WWW 2021. (RAM)

Searching to Sparsify Tensor Decomposition for N-ary relational data. WWW 2021. (S2S)

点个在看 paper不断!