FaceBook推出强大的多语言模型,试图理解所有人类语言

共 1868字,需浏览 4分钟

·

2021-12-14 02:12

大数据文摘授权转载自数据实战派

作者:MetaAI

译者:张雨嘉

语言交流是人们日常生活中最常用的交互方式,而随着语音技术的发展,未来人们还可以与电子设备以及虚拟世界进行交互,将虚拟体验与现实世界合二为一。

但是,现有的语音技术仅适用于数千种世界语言中的一小部分。

有效的方法是基于有限标记数据的少样本学习,或者无监督的语音识别方法,而这些方法的成功取决于自监督模型的性能。

目前,Meta AI 团队( 原Facebook AI)发布了一个用于多种语音任务的自监督模型——XLS-R。

通过在之前 2 倍以上的语言数量和近 10 倍的公共数据集上进行训练,XLS-R 模型的性能远超以前的多语言模型。

为了让单一模型实现理解多种不同语言语音的能力,Meta AI 团队对 XLS-R 进行微调,以执行语音识别、语音翻译和语言识别任务。并分别在以下基准上获得不错的结果:用于语音识别的 BABEL、CommonVoice 和 VoxPopuli;用于外文到英文翻译的 CoVoST-2;以及用于语言识别的 VoxLingua107。

为了让更多人可以使用这种方法,FB已经和 Hugging Face 联手发布该模型,并可以在 GitHub 的 fairseq 项目中使用 (https://github.com/pytorch/fairseq/tree/master/examples/wav2vec)。

XLS-R 在 436,000 多小时的公开语音录音数据上进行训练,并且基于 wav2vec 2.0 模型对语音表征进行自监督学习。该方法的训练数据量比去年发布的最好模型 XLSR-53 还多 10 倍。

通过收集会议记录、有声读物等不同来源的语音数据,XLS-R 模型已经可以支持 128 种不同语言,是之前语言数量的约 2.5 倍。

最大 XLS-R 模型有超过 20 亿个参数,其性能远远优于其他较小的模型,因为更多的参数可以更充分地学习数据集中的多种语言。并且团队发现,与在单一语言上预训练相比,更大的模型可以得到更好的性能。

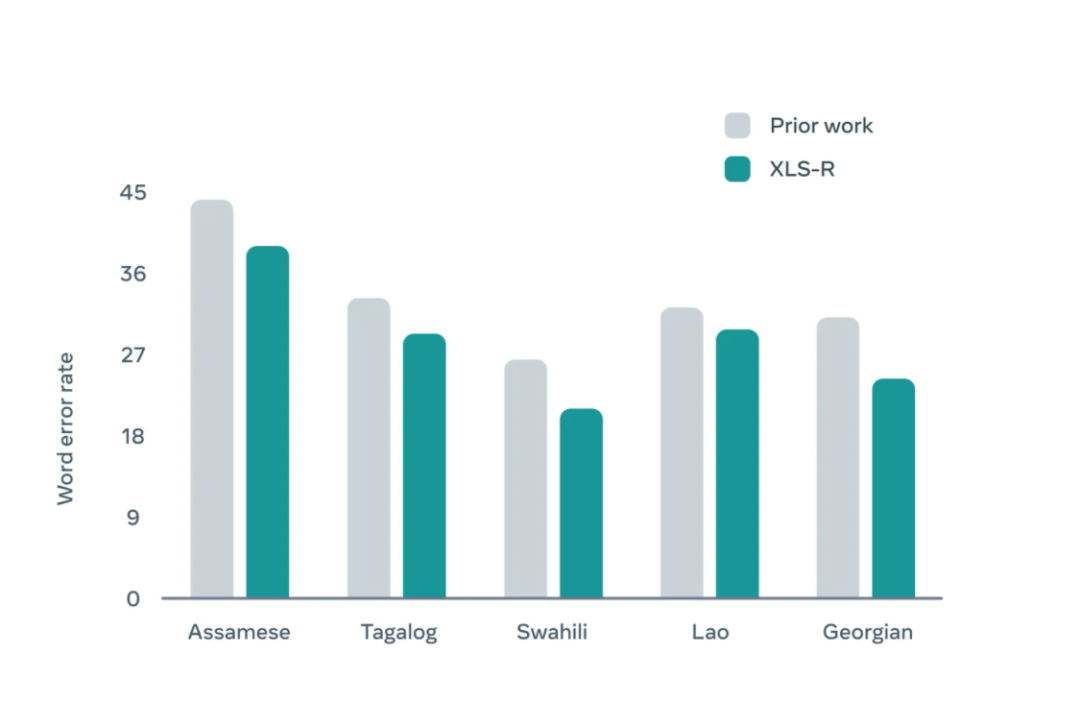

将 XLS-R 在四个多语言的语音识别任务上进行评估,结果表明它在 37 种测试语言上的表现都优于之前的工作。具体包括 BABEL 的5种语言、CommonVoice 的 10 种语言、MLS 的 8 种语言和 VoxPopuli 的 14 种语言。

图 | 在 BABEL 上的单词错误率结果。与以前的工作相比,XLS-R 有明显改进

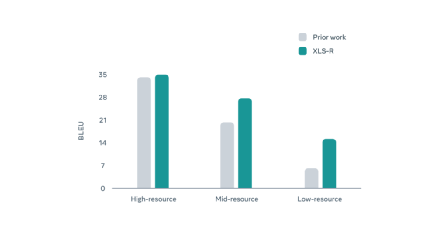

团队还在语音翻译任务上对模型进行评估,语音翻译就是将录音翻译成另一种语言。而且为了实现一个能够执行多任务的模型,他们将 XLS-R 在 CoVoST-2 基准的不同翻译方向上进行微调。结果显示,这种单一模型可以在英语和其他 21 种语言之间完成翻译。

对英语以外的语言进行编码时,XLS-R 有比较明显的改进,这也是多语言语音表征方面的一大突破。模型在将印度尼西亚等低资源语种(low-resource language)翻译为英语方面有显著改进,BLEU 指标的平均准确率翻了一番,也是口语翻译方面的一大进步。BLEU 指标的提升,意味着模型生成的自动翻译结果与人工翻译间有更高的相似性。

图 | 自动语音翻译在 BLEU 上的准确性,模型对高资源语言(例如法语、德语)、中等资源语言(例如俄语、葡萄牙语)和低资源语言(例如泰米尔语、土耳其语)的语音翻译成英语时,准确性逐渐降低。

XLS-R 证明了通过跨语言预训练可以提高模型在低资源语言上的性能。

在语音识别和将外语翻译到英语的语言翻译任务上的准确率提高了一倍以上。

FB表示,XLS-R 是用单一模型理解多种不同语言语音的关键一步,是在已知公共数据上进行多语言预训练方面的最大努力。相信该研究将使机器学习应用更好地理解所有人类语言,使语音技术在全球范围尤其是在服务欠缺地区中被使用。

未来,他们将继续从少监督学习中开发新方法来改进算法,并将其扩展到全球 7,000多 种语言上。

如果你想使用该模型,可以查看 Hugging Face 上有关微调模型的教程(

https://huggingface.co/blog/fine-tune-xlsr-wav2vec2)。